728x90

728x90

| context_length | 128 | 128 | 128 |

| expansion_factor | 16 | 32 | 64 |

| latent_size | 49,152 | 98,304 | 196,608 |

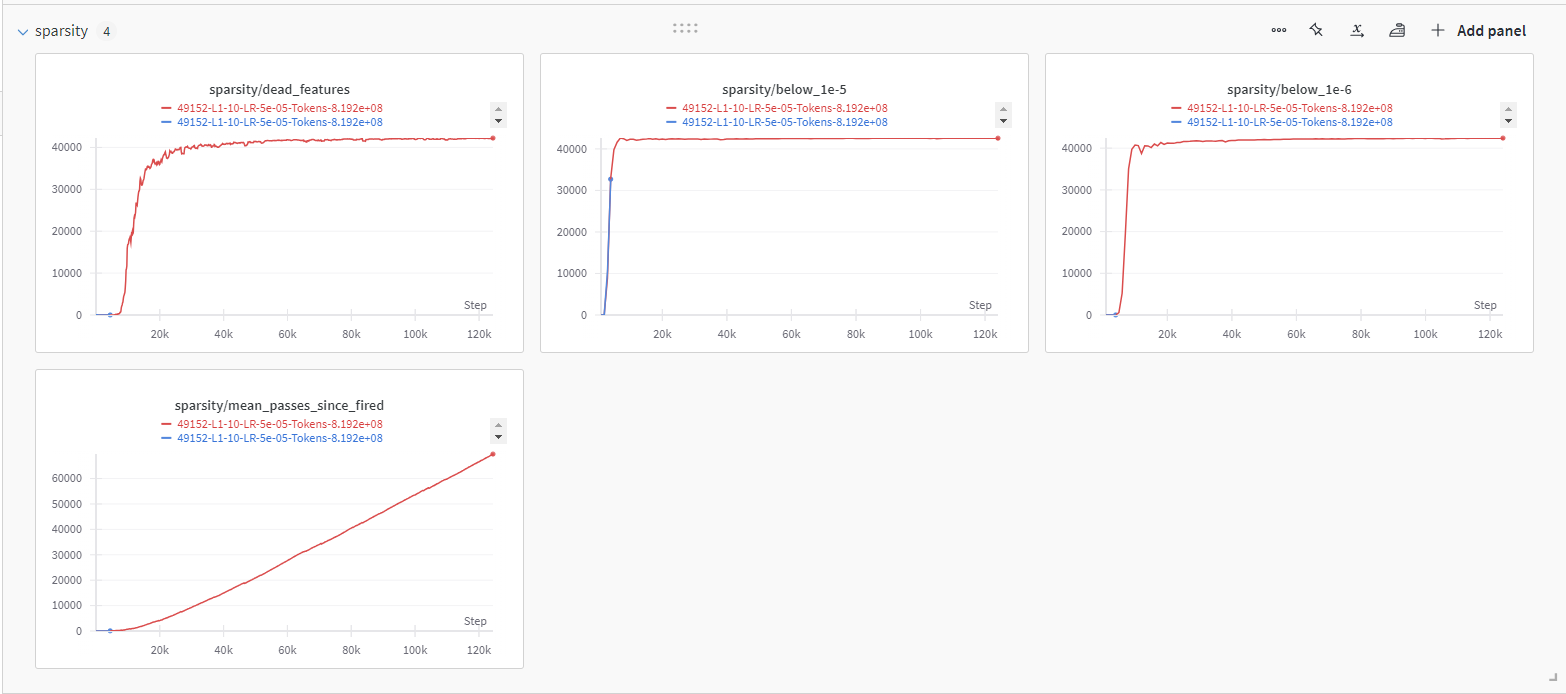

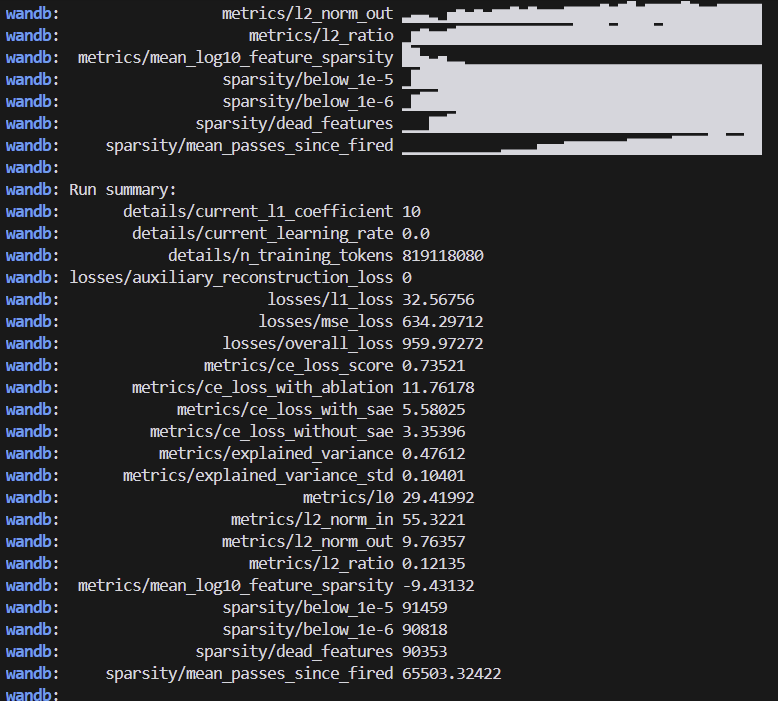

| below_1e-5(sparsity) | 42,602 | 91,309 | 171,941 |

| head_features | 42,257 | 88,793 | 169,247 |

| 죽은 feature 비율 | 85.97% | 90.32% | 86.08% |

| sparsity한 것 중 죽은 feature 비율 | 99.19% | 97.24% | 98.43% |

| 학습 진행 | 62% | 43% | 19% |

62% 정도 학습했는데... 너무 죽네요....?

여긴 43% 학습했습니다.

음 상당하게 죽네요....

여긴 19% 학습했습니다.

더 확인해 봐야겠지만 이 정도는 너무 심한데...

Open Source Sparse Autoencoders for all Residual Stream Layers of GPT2-Small — LessWrong

Browse these SAE Features on Neuronpedia! …

www.lesswrong.com

GPT2 Small Residual Stream Sparse AutoEncoders

Training Metrics and Results. Made by Joseph Bloom using Weights & Biases

wandb.ai

조금 더 연구해보겠습니다...

학습 시간이 이건 뭐.....

일단 모든 모델은 내일부터 하나씩 여기에 올라갈 예정입니다.

yoonLM (Yoon JeongHo)

yoonLM/sae_llama3.2_512_16 Updated about 8 hours ago

huggingface.co

써보실 분들은 튜토리얼 따라서 하나씩 써보세요 ㅎㅎ...

728x90

'인공지능 > XAI' 카테고리의 다른 글

| Sparse Autoencoder 학습 - l1 regularization coefficient에 따른 학습 변화 (0) | 2024.10.13 |

|---|---|

| Sparse Autoencoder 학습과 문제점 (0) | 2024.10.08 |

| LLama3 학습 데이터 변환하여 LLama3.2 Sparse Autoencoder 학습하기 (3) | 2024.09.27 |

| SAE 통해 특정 feature를 강화시켜 LLM 출력 변형하기 - 미스트랄 mistral 7b (2) | 2024.09.26 |

| SAE Tutorial summarize (4) | 2024.09.24 |