728x90

728x90

그러나 이 것도 데이터에 의한 학습이 아닌가...?

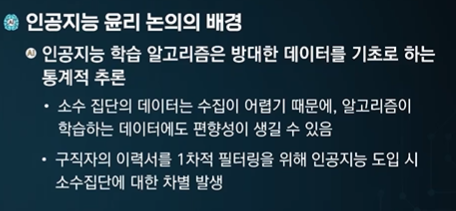

소수의 데이터는 수집도 어렵다 -> 학습에 문제가 생긴다.

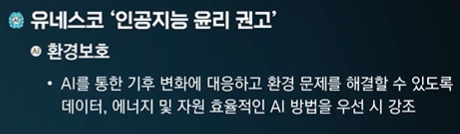

편의성과 안락함을 줄 순 있지만 인간에게 해를 끼칠 수 있다!

이슈가 있다 == 보안한다.

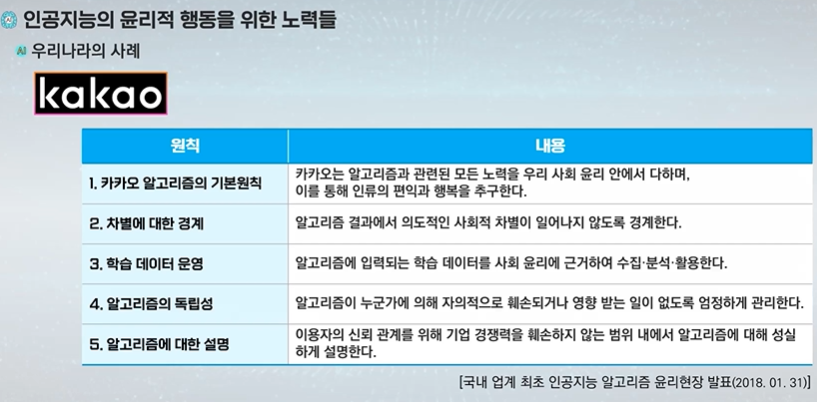

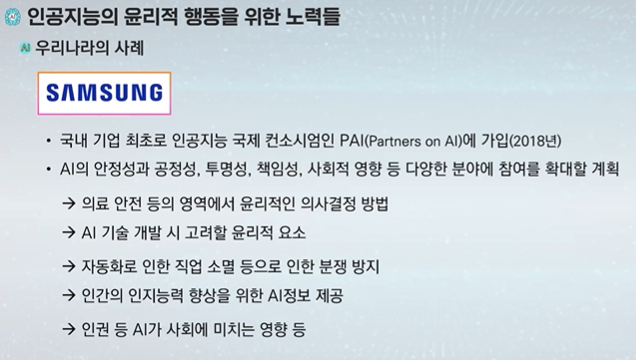

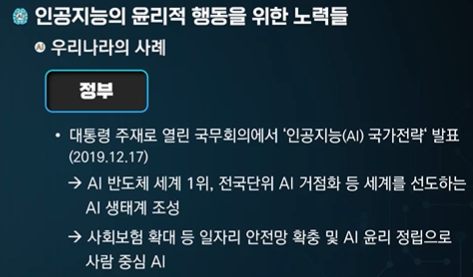

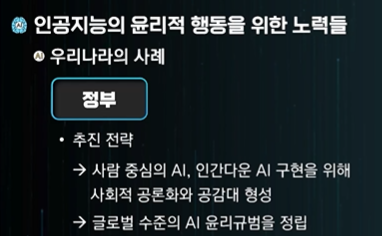

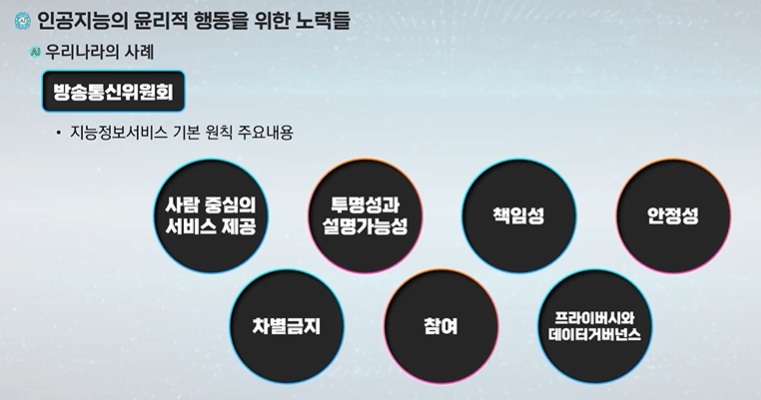

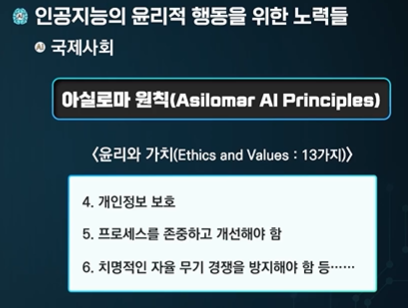

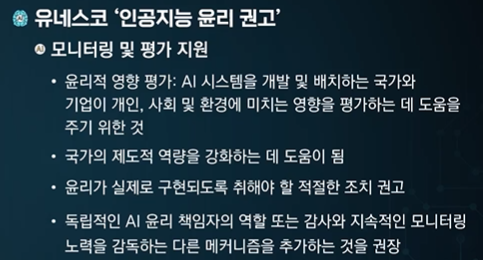

기술 수준의 개발만 하는 것이 아닌 도덕성 가치와 윤리를 같이 고려한다.

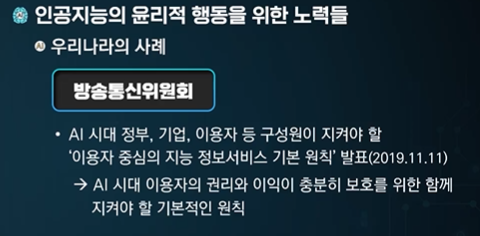

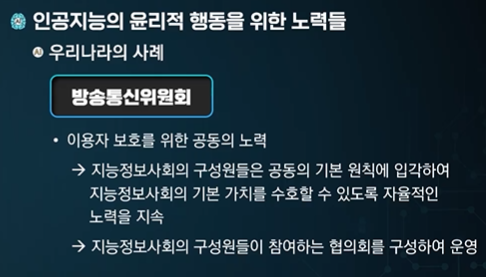

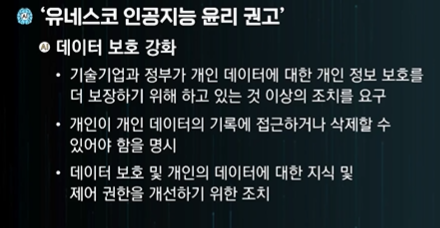

개인정보 이출 이슈를 보호하겠다는 것이다.

윤리 이슈를 개인정보 보호에 맞추고 있다.

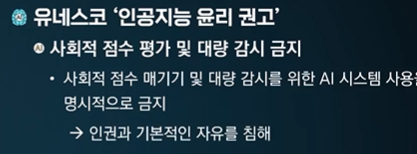

위배할 가능성이 매우 높은 것이다.

결론!

판사 AI를 만들었는데 지금까지의 모든 판결 데이터를 가지고 만들었어

그런데 흑인의 범죄 비율이 압도적으로 높았고 범죄도 많이 일으킨다고 가정하면 그 AI판사가 흑인에 대해 실형 판결을 많이내는 것이 윤리적 문제는 아니지 않아?

학습데이터도 잘 학습하고, 판결도 잘 한거잖아

이 문제는 인공지능이 사회적, 윤리적 맥락에서 어떻게 영향을 미칠 수 있는지 보여주는 중요한 사례입니다. 인공지능 판사 시스템이 모든 판결 데이터를 학습했다고 하더라도, 데이터 자체에 편향이 포함되어 있을 수 있다는 점을 고려해야 합니다. 이는 다양한 윤리적 문제를 야기할 수 있습니다.

윤리적 문제:

- 데이터 편향: 기존의 판결 데이터가 사회적, 역사적 편견을 반영할 수 있습니다. 즉, 학습 데이터 자체가 특정 인종, 성별, 계층에 대한 편향을 포함하고 있다면 인공지능도 그 편향을 학습하게 됩니다. 결과적으로, 인공지능 판사는 이러한 편향을 그대로 반영하여 판결할 수 있습니다.

- 차별 문제: 판결에서 특정 집단을 대상으로 차별적인 결과를 초래하는 경우, 인공지능이 사회적 불평등을 악화시킬 수 있습니다. 실형 판결이 특정 집단에 집중된다면 이는 시스템의 신뢰도와 공정성을 해칠 수 있습니다.

- 공정성과 정의: 모든 사람은 법 앞에 평등한 대우를 받을 권리가 있습니다. 공정한 판결은 단순히 통계적 패턴만을 따르는 것이 아니라, 개인의 특수한 상황을 고려한 판단을 포함해야 합니다. 만약 인공지능 판사가 인종적 배경만으로 판단을 내린다면, 이는 법적 정의에 반할 수 있습니다.

대응책:

- 다양한 데이터 소스 사용: 데이터의 편향을 최소화하기 위해, 다양한 배경을 가진 데이터를 학습시킬 필요가 있습니다.

- 검토 및 감시: 인공지능 판사의 판결에 대한 인적 검토가 필요합니다. 전문적인 판사와 같은 전문가들이 시스템을 모니터링하고 수정할 수 있어야 합니다.

- 설계 기준 수립: 인공지능 시스템이 공정성과 책임성을 갖도록 설계해야 하며, 이러한 설계 기준은 다양한 사회적 요소를 고려해야 합니다.

결론적으로, 인공지능 판사는 데이터 편향 및 차별 문제에 매우 민감하기 때문에 공정한 시스템을 구축하려면 다양한 윤리적 고려가 필수적입니다.

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 모두를 위한 머신러닝 10주차 1차시 - 머신러닝 시스템 설계 시 고려사항 (0) | 2024.05.09 |

|---|---|

| 이전부터 살짝 아리까리 했던 RNN 정리하기 (0) | 2024.05.09 |

| 인공지능과 빅데이터 10주차 2차시 - 인공지능 윤리이슈 (1) | 2024.05.07 |

| 인공지능과 빅데이터 10주차 1차시 - 인공지능 기술의 미래와 윤리 (0) | 2024.05.07 |

| 생성형 인공지능 입문 9주차 퀴즈 (0) | 2024.05.02 |