모델 평가

모델 학습에 대한 평가를 한다.

metric 데이터 셋에 대해 모델의 성능을 평가하는 지표

cost error

accuracy

precision

recall

cost error

Cost function의 출력밧

모델과 데이터셋 사이의 cost function으로 계산된 차이

accuracy

데이터셋 전체 샘플 갯수 중 모델이 정답을 맞춘 비율

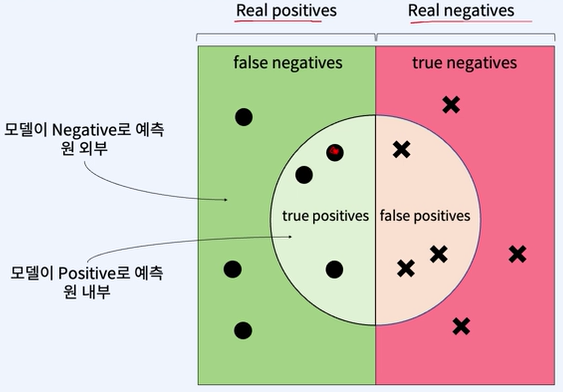

true를 true라 하는지, negative라고 하는지를 보여주는 원이다.

precision

모델이 positive라고 예측한 샘플들 중 실제 positive인 비율

recall

데이터셋 전체 positive 샘플 중 모델이 positive라고 예측한 비율

암을 비교할 때 사용 = 잘못된 예측을 해서 정상인을 암이 있다고 하더라도, 모든 암이 있는 사람을 찾아내는 것

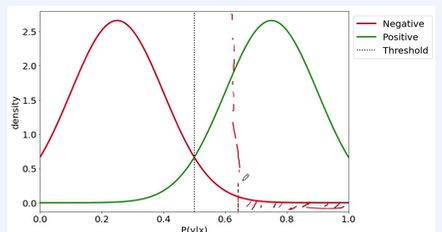

precision recall trade-off

임계값을 조정하여 모델의 결정 경계를 이동 시킬 수 있다.

threshold 변경함으로써 precision, recall의 trade-off가 생긴다.

threshold를 높게 설정하면 precision이 올라가고 recall이 내려간다.= 정확할 때만 참이라고 한다.

threshold를 높게 설정하면 precision이 내려가고 recall이 올라간다.

상황에 따라 잘 해야 한다.

precision, recall의 점수를 동시에 고려해서 모델의 성능 평가를 하고 싶을 경우 F1 score를 사용한다.

threshold에 따라 precision, recall trade off가 되지만 f1 score는 그대로이다.

train set

모델 파라미터 학습에 직접적으로 사용되는 데이터 셋

validation set

모델의 학습 과정에서 만들어낸 많은 가설 집합에서 성능이 높은 가설을 찾기 위해 사용하는 데이터 셋

test set

모델 최종 성능 측정을 위해 사용되는 데이터 셋

일반적으론 60~80, 10 ~ 20, 10 ~ 20으로 나눈다.

데이터셋 나눌 시 주의 해야 할 점

원하는 바 목적에 맞게 나눠야 한다.

데이터 분포를 유사하도록 하는 것이 중요하다.

모델 선택은 가설 집합 H로 부터 최고의 모델 하나를 선택하는 과정이다.

최종 성능 평가

cross validation

- holdout cross validation

validation set만을 이용해 최종 모델을 결정하고 test set 성능을 기록

- K-fold cross validation

train set을 K개의 fold로 나누고 각 fold를 한번씩 test set으로 활용하여 test set 성능을 계산하고, 그 tes set 성능을 평균내어 점수를 계산

데이터셋 크기가 작을경우 이렇게 하게 된다

이건 그냥 배치 사이즈 나누는거 아님?

high bias

모델이 너무 단순 = 언더피팅

모델의 복잡도를 늘려야 한다.

high variance

모델이 너무 복잡 = 오버피팅

test, validation set에 대해 성능 평가가 낮다.

모델의 복잡도를 높여야 한다.

2023.12.16 - [인공지능/공부] - 인공지능 Overfitting, Convolution, CNN

인공지능 Overfitting, Convolution, CNN

Overfitting overfitting은 traning data에 과도하게 optimized 되어 training data만 예측을 잘 하고, test data에는 오히려 낮은 점수를 보이는 것이다. 그래서 우린 데이터를 나누기로 결정한다. 데이터 불균형이

yoonschallenge.tistory.com

아마 저기에 기본 개념은 자세하게 적어놨어요

Learning Curve (학습 곡선)을 통해 모델이 오버피티인지 언더피팅인지 진단 가능하다.

high bias = 언더피팅

적은 train set에 대해서 빠르게 성능이 수렴

높은 error

데이터를 더 추가하더라도 소용 없다.

high variance = 오버피팅

validation cost와 training cost의 차이가 크다.

데이터를 추가하여 성능 개선 가능성이 있다.

모델 복잡도를 줄이는 방법도 있다.

선형회귀

regression

여러개의 독립변수와 하나의 종속 변수 간의 상관 관계를 모델링하는 기법

Linear regression

하나 이상의 독립 변수와 하나의 종속 변수 간의 선형 관꼐를 모델링 하는 기법

Polynomial regression

하나 이상의 독립변수 x와 하나의 종속 변수 y간의 선형 관계를 x의 n차 다항식으로 모델링 하는 기법

MSE = Mean Square Error

평균 제곱 오차

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 - Linear Regression 선형 회귀, Cost function 비용함수 실습 (1) | 2024.01.09 |

|---|---|

| 자연어 처리 - Logistic (0) | 2024.01.07 |

| 자연어 처리 - 머신러닝 기초, 나이브, k알고리즘, 앙상블, (1) | 2024.01.04 |

| 딥러닝 기초 , rogistic regression, 파라미터, 비용 함수, 학 (1) | 2024.01.03 |

| 자연어 처리 시작, 인공지능에 필요한 수학 개념 (2) | 2024.01.03 |