진료 차트 작성해야 할 일이 생겨서....

Reference, Prediction 중첩도 Rouge-1 점수를 올려야 해서 일단......

논문 확인부터 했습니다.

https://aclanthology.org/2023.eacl-main.168/

An Empirical Study of Clinical Note Generation from Doctor-Patient Encounters

Asma Ben Abacha, Wen-wai Yim, Yadan Fan, Thomas Lin. Proceedings of the 17th Conference of the European Chapter of the Association for Computational Linguistics. 2023.

aclanthology.org

Abstract

의사들은 환자 진료 후 임상 노트를 작성하는 데 하루 평균 52~102분을 사용한다. 이 업무 부담을 줄이기 위해서는 적절하고 효율적인 요약 기법이 필요하다. 본 논문에서는 임상 환경에서의 의사-환자 대화 자동 요약을 위해 새로운 자원과 실증적 연구를 제시한다. 구체적으로, 1,700개의 의사-환자 대화와 그에 대응하는 임상 노트로 구성된 새로운 데이터셋 MTS-DIALOG를 소개한다. 우리는 이 데이터셋을 활용하여 해당 과제의 실현 가능성과 기존 언어 모델, 데이터 증강, 가이드 요약 기법의 적합성을 조사한다. 또한 생성된 요약의 정확도와 사실적 일관성을 평가하기 위해 n-그램 매칭, 문맥 임베딩, 사실 추출에 기반한 표준 평가 지표들을 비교한다. 이러한 결과를 뒷받침하기 위해, 관련 자연어 생성 평가 기준과 ‘중요 정보 누락(critical omissions)’과 같은 과제 특화 기준을 적용한 전문가 기반 평가를 수행하고, 자동 지표와 전문가 판단 간의 상관관계를 분석한다. 우리가 아는 한, 본 연구는 임상 노트 생성을 상세히 자동·수동 평가와 함께 다루면서, 의사-환자 대화와 임상 노트를 포함한 공개 데이터셋을 소개한 최초의 시도이다.

INTRO

자동 요약의 최근 성과는 대규모 트랜스포머 기반 언어 모델과 대규모 데이터셋의 가용성에 큰 영향을 받아 이루어졌다. 의료 대화 요약 역시 이러한 접근법의 혜택을 받을 수 있는 위치에 있으나, 데이터 부족과 적절한 평가 프로토콜의 부재 같은 도메인·과제 특유의 장애물에 직면해 있다.

의사들은 환자와의 대화로부터 임상 노트를 작성하는 데 하루 평균 52~102분을 사용한다(Hripcsak et al., 2011). 전자의무기록(EHR) 시스템에 들이는 시간은 일·생활 불균형, 직무 불만족, 높은 이직률, 그리고 50%를 넘는 번아웃률에 기여한다(Arndt et al., 2017). 요약 모델은 의사-환자 만남으로부터 임상 노트를 자동 생성함으로써 이러한 업무 부담을 줄이는 데 핵심적인 역할을 할 수 있다(Knoll et al., 2022).

임상 현장에서 사용할 의사-환자 대화 요약은 일반적인 자연어 이해·생성 요소 외에도 고유한 도전과 미묘함을 수반한다. 예를 들어, 중요한 의학적 사실의 누락(critical medical facts omission)은 환자 결과를 바꿀 가능성이 크며, 어느 요약 시스템을 채택할지 결정하는 데 핵심 요인이 되어야 한다. 또한 환각(hallucination)이 방지되지 않거나(혹은 높은 정확도로 탐지되지 않으면) 임상 결과에 악영향을 미칠 가능성도 있다.

이러한 과제를 해결하는 요약 모델의 설계와 개선은 더 폭넓은 연구 노력으로부터 이익을 얻을 수 있다. 그러나 공개적으로 이용 가능한 의사-환자 대화 데이터셋의 부족은 이 요약 과제에 대한 NLP 커뮤니티의 폭넓은 연구를 제한한다. 본 논문에서는 공개 임상 노트로부터 시뮬레이션된 대화를 생성함으로써 개인정보 침해 위험을 피하고, 의사-환자 대화와 연관 임상 노트의 새로운 데이터셋을 구축해 이 과제의 데이터 부족 문제를 다룬다.

우리의 주요 기여는 다음과 같다. (i) **1,700건의 의사-환자 대화(총 1.6만 턴, 1.8만 문장)**와 그 요약 임상 노트(6천 문장)로 이루어진 새로운 데이터셋을 제시한다. 우리의 지식으로는, 이 규모에서 의학적 대화와 연관 노트를 함께 제공하는 최초의 공개 데이터셋이다. (ii) 기존의 관련 데이터셋 활용, 증강 학습 데이터, 가이드 요약을 포함한 여러 최첨단(SOTA) 요약 모델 변형들을 의료 대화 요약에 대해 평가한다. (iii) 생성된 임상 노트의 평가를 위해 표준 자동 평가 지표, 도메인 특화 지표, 전문가 판단을 함께 연구하고, 자동 점수와 수동 점수 간 상관관계를 계산·분석한다.

3 MTS-DIALOG

3.1 데이터 생성

우리의 데이터 생성 방식은 공개된 임상 노트로부터 의사-환자 대화를 시뮬레이션하여 생성하는 것이다. 이러한 임상 노트/요약을 수집하기 위해, 비식별화(de-identified)된 임상 노트를 제공하는 공개 MTSamples 컬렉션에서 노트를 모았다[2] (South et al., 2014; Moramarco et al., 2022a). 선정된 임상 노트는 해당 컬렉션에서 가장 빈도가 높은 여섯 가지 노트 유형과 전문과를 포함하며, **일반의학(General Medicine), SOAP(Subjective, Objective, Assessment, Plan), 신경과(Neurology), 정형외과(Orthopedic), 피부과(Dermatology), 알레르기/면역(Allergy/Immunology)**를 다룬다.

의료 배경을 지닌 훈련된 주석자 8명에게 임상 노트의 모든 섹션을 제공하고, 상세 지침에 따라 한 번에 한 섹션씩 임상 대화를 작성하도록 했다. 이러한 지침은 수백 건의 실제 의사-환자 대화와 관련 노트로 이루어진 대규모 비공개 컬렉션을 분석하여 마련되었다. 주석 지침에는 다음이 포함된다.

- 대화 생성 규칙: 대화는 (i) 환자 방문 당일과 관련된 내용으로 작성하고, (ii) 외래 방문 또는 응급실 방문의 맥락으로 구성할 것.

- 의학 용어 규칙: 임상 노트에는 동일한 문제·치료·검사를 대화보다 더 자세한 표현으로 기술하는 경우가 있다. 예를 들어, 임상 노트의 “Open reduction internal fixation (ORIF)”은 대화에서는 “수술을 해야 할 것 같습니다(We will have to do surgery on it)”처럼 표현될 수 있다.

- 상상 가능하되 그럴듯함(Imaginary but plausible) 규칙: 임상 노트의 정보가 부족한 경우라도 그럴듯한 범위 내에서 대화를 생성할 수 있다. 다만, (위에서 언급한 문제·치료·검사 항목을 예외로 하고) 대화 전사는 연관된 임상 노트보다 더 상세해야 한다.

- 형식 규칙: 표준 전사 가이드라인을 따른다(발음되는 대로의 표기, 대문자 사용, 문장부호 규칙 등).

- 대화 특성: 실제 진료 현장을 모사하기 위해 가능한 한 다양성을 확보한다. 이에 비유창성(disfluency)—예: 말 머뭇거림과 false start, 메우기(filler), 감탄사, 상대방 말 끊기, 화자의 이전 정보 정정, 속어·방언, 구어체—의 사용을 포함한다.

또한 원본 노트의 279개 섹션 헤더를 20개 1단계 헤더(예: assessment, allergy, diagnosis, exam, medications, past medical history, past surgical 등)로 정규화했다.

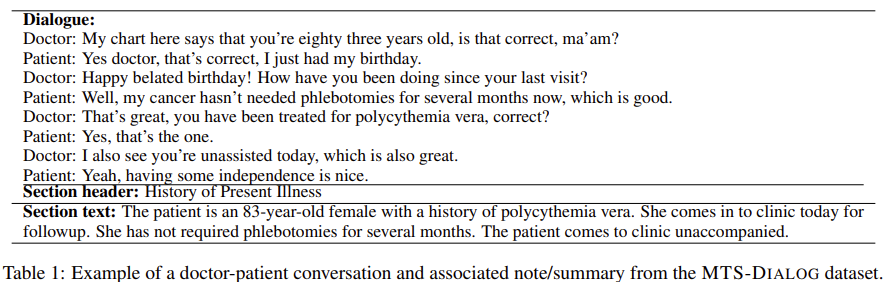

최종 MTS-DIALOG 데이터셋은 1,701개의 대화와 해당 임상 노트 섹션의 쌍을 포함한다. 표 1에는 데이터셋의 예시가 제시되어 있다. 전문과/노트 유형별 쌍의 개수는 일반의학 1,035, SOAP 79, 신경과 296, 정형외과 208, 피부과 56, 알레르기/면역 27이다. 데이터셋 구축에는 총합 약 1,800시간이 소요되었으며, 추가 통계는 표 2에 제시되어 있다.

3.2 데이터 품질(Data Quality)

MTS-DIALOG 데이터셋의 품질은 다음의 세 단계를 통해 보장되었다. (1) 주석자는 의료 관련 교육/경력을 갖춘 지원자(예: 전직 메디컬 스크라이브)만 채용했고, (2) 과제 초기 단계에서 경험 많은 트레이너가 1:1 정기 피드백을 제공하는 방식으로 교육을 진행했으며, (3) 데이터셋 전체 구축이 완료된 뒤에는 별도의 독립적 검증 단계를 수행하여 루브릭 등급 체계에 따라 코퍼스를 공식적으로 평가하였다. 이 독립 평가에서는 각 대화가 주석 지침 준수 여부, 그리고 초기 임상 노트 대비 내용 적합성·포괄성을 기준으로 채점되었다. 수동 검증 결과는 표 3에 제시되어 있다. 추가로, 검증자는 맞춤법 수정이나 누락 정보 보완과 같은 경미한 교정도 수행하여, 최종 데이터 품질이 보고된 수치보다 더 높아지도록 했다.

3.3 실제 데이터와의 비교(Comparison with Real Data)

MTS-DIALOG는 실제 임상 노트와, 개인정보 보호를 위해 공개하지 못하는 실제 의사-환자 대화를 대신하는 합성 대화로 구성되어 있다. 합성 데이터에 의존하는 것의 영향을 조사하기 위해, MTS-DIALOG 데이터가 실제 대화와 얼마나 유사한지를 블라인드 평가로 살펴보았다. 구체적으로, (i) MTS-DIALOG에서 무작위로 추출한 52개 대화와, (ii) 실제로 녹음·전사된 의사-환자 대화를 모은 비공개 컬렉션에서 무작위로 추출한 52개 대화, 두 하위 집합을 대상으로 평가했다. 비공개(실제) 하위 집합의 **턴(발화)**들은 MTS-DIALOG의 턴 길이와 유사하도록 선택되었다. 병원에서 메디컬 스크라이브로 일한 경험이 있는 의료 전문가가 각 대화를 실제(real), 합성(synthetic), 또는 **미상(unknown)**으로 판정하고, 그 근거를 서술식 설명으로 남기는 방식으로 독립 블라인드 주석을 수행했다. 또한 대화의 **비유창성(disfluency)**과 중단(interruption) 특성에 대한 표기도 포함되었다.

이 주석의 결과(표 4 참조)에 따르면, **실제 대화의 55.77%(29/52)**가 실제로, **실제 대화의 42.31%(22/52)**가 합성으로, **합성 데이터의 9.61%(5/52)**가 실제로 라벨링되었다. 의료 전문가의 블라인드 라벨은 전체의 **26.92%(28/104)**에서 오류였다. 만약 합성과 실제가 구별 불가능하다면 오류율은 **50%**가 되었을 것이다.

합성 데이터를 실제로 잘못 라벨링한 경우에 대해 의료 전문가는, 표 5의 통계 비교가 보여주듯 MTS-DIALOG 대화가 평균적으로 비유창성과 중단이 더 적음에도 불구하고, 내용이 매우 현실적으로 느껴졌다는 설명을 공통적으로 제시했다. 반대로 실제 데이터를 합성으로 라벨링한 흔한 이유로는, 대화가 **핵심 위주(to-the-point)**이고 비유창성이 낮아 명료하며, 따라가기 쉽고, 갑작스러운 주제 전환이나 구어체/속어가 포함되어 있다는 점 등이 있었다.

이처럼 합성과 실제를 구분하기 어려웠다는 사실은, MTS-DIALOG가 현실 세계 응용을 위한 모델 학습·벤치마크에 활용될 수 있는 가치 있는 초기 데이터셋임을 시사한다. 예컨대 MTS-DIALOG는 데이터 증강 자원으로 쓰이거나, 이후 (비공개) 실제 대화로 파인튜닝하기 전에 사전학습(pre-training) 데이터로 활용될 수 있다.

4 Methods (방법)

4.1 Summarization Models (요약 모델)

의사–환자 대화 요약의 특수성과 평가 방법의 적합성을 살피기 위해, 우리는 여러 SOTA 트랜스포머 기반 모델(예: BART(Lewis et al., 2020), Pegasus(Zhang et al., 2020))로 요약을 생성했다. 여기에는 관련 데이터셋(예: XSum(Narayan et al., 2018), Samsum(Gliwa et al., 2019))으로 **사전 미세조정(pre-finetuning, PFT)**한 변형과, 아래 절에서 설명하는 데이터 증강 및 가이드 요약을 적용한 변형들이 포함된다.

4.2 Data Augmentation via Back-translation (역번역을 통한 데이터 증강)

적절한 데이터 증강은 과적합을 피하고 신경망 방법의 성능을 높이는 효과적인 기법이다. 특히 역번역 증강은 텍스트를 다른 언어로 번역한 뒤 다시 원언어로 번역해 되돌리는 방식이다. 우리는 역번역 문장에 더 많은 다양성을 부여하기 위해 두 개의 보조 언어를 사용했다[3]. 번역 오류를 줄이기 위해, 영어와 어휘적으로 가까운 프랑스어와 스페인어를 선택하고, 성능이 높은 번역 모델(Tiedemann and Thottingal, 2020)을 사용했다.

4.3 Guided Summarization (가이드 요약)

요약 모델의 출력을 제어하기 위해서는 여러 가지 가이드 신호를 사용할 수 있다. 임상 노트는 Family History, Assessment 등 여러 섹션으로 구성되고, MTS-DIALOG 데이터셋의 시뮬레이션 대화 역시 섹션 단위로 독립적으로 생성되었다. 가이드 요약 실험에서 우리는 **섹션 헤더를 학습 데이터의 프리픽스(접두)**로 사용하여 의사–환자 대화의 요약을 유도했다. 이를 통해 모델이 **신호(섹션 헤더)**와 그 신호에 의해 유도된 요약을 함께 생성하도록 학습할 수 있다.

4.4 Evaluation Methods (평가 방법)

요약 평가에 대한 지속적인 연구에도 불구하고, 자동 평가에는 여전히 여러 한계와 편향이 존재한다(Hardy et al., 2019; Fabbri et al., 2021; Ben Abacha et al., 2021). 이러한 한계는 현재와 미래의 연구를 오도하고, 신경망을 생성 요약의 실제 적합성과 품질을 제대로 반영하지 못하는 최적점으로 이끌 수 있다. 예를 들어, 흔히 쓰이는 ROUGE 같은 지표는 요약이 원문과 사실적으로 일치하는지, 중대한 오류가 있는지, 중요 정보가 빠졌는지를 평가하지 못한다(Goodrich et al., 2019). 수동 평가는 품질을 평가하는 또 다른 방법이지만, 시간이 많이 들고 도메인 전문가의 가용성에 의존한다. Howcroft et al.(2020)은 인간 평가를 포함한 NLG 논문 165편을 검토하고, 이 분야에는 표준 평가 방법과 용어가 시급히 필요하다고 결론내렸다.

이러한 요소들을 고려하여, 우리는 생성 요약을 n-그램 매칭, 사전학습된 문맥 임베딩 기반(BERTScore), 학습 기반 지표(BLEURT), 자동 사실 기반 지표(Fact Scores), 그리고 의료 전문가의 수동 평가로 다양하게 평가한다. BERTScore(Zhang* et al., 2020)는 사전학습된 BERT의 문맥 임베딩을 사용하여 후보와 참조 텍스트의 단어를 코사인 유사도로 매칭한다. 우리는 두 가지 변형을 사용한다: 기본 roberta-large를 쓰는 BERTScore-M1, 그리고 인간 평가와의 상관이 가장 높다고 보고된 deberta-xlarge-mnli를 쓰는 BERTScore-M2.

BLEURT(Sellam et al., 2020)는 BERT 기반의 학습형 지표로, 수백만 개의 합성 예시를 활용한 사전학습 절차를 사용한다. 우리는 인간 판단과 더 잘 상관되는 최신 체크포인트 BLEURT-20을 사용하며, 모든 자동 지표에 대해 F1 변형을 사용한다.

사실 기반 평가를 위해서는, 의료 사실 추출 시스템을 이용해 의학적으로 관련된 사실을 추출한다. 의료 사실은 하나의 **핵심 속성(core attribute)**과 선택적으로 하나 이상의 속성(예: laterality(좌우성), bodysite(신체 부위))으로 구성된다. 예를 들어, 입력 문장 *“the patient has rash on the upper arms”*에 대해 사실 추출 시스템이 식별한 항목은

<FINDING_CORE> rash <LATERALITY> upper <BODYSITE> arms

가 된다. Fact Score 지표는 의학적 관련 사실 추출의 F1 점수를 제공한다. 첫 번째 변형인 Fact-Core는 7개의 핵심 속성(’Procedure_Core’, ’Disorder_Core’, ’Finding_Core’, ’Medication_Core’, ’Substance_Use_Core’, ’Vital_Sign_Core’, ’Allergy_Core’)의 추출에 기반한다. Fact-Full 변형은 이러한 핵심 사실에 추가 5개 속성(’Negation’, ’Hedge’, ’Status’, ’Laterality’, ’Bodysite’)을 결합한다.

또한 우리는 자동 지표와 전문가 판단 간의 상관관계도 함께 조사한다.

5 Experiments (실험)

우리는 요약 모델을 Nvidia Tesla K80 GPU 4개, 4 epoch로 학습했다. 학습률은 3e-5, 가중치 감쇠(L2)는 0.1로 설정했다. 테스트 세트 100쌍(대화–노트)을 MTS-DIALOG에서 무작위로 선택했고, 나머지는 학습 1,201쌍 / 검증 400쌍으로 사용했다.

5.1 Automatic Evaluation (자동 평가)

표 6은 MTS-DIALOG에서 미세조정·평가한 다양한 요약 모델의 결과를 보여준다. 이후의 추가 분석을 위해 각 범주에서 성능이 가장 좋은 모델 1개씩, 총 4개를 선정했다. 표 7은 이 네 모델을 ROUGE-N, Fact Scores, BERTScore, BLEURT로 비교한다(생성 예시는 표 9).

초기 결과는 적절한 사전 미세조정(PFT) 타깃의 중요성을 강조한다. XSum을 첫 PFT 단계로 쓰면 CNN/DailyMail보다 현저히 좋다(ROUGE-1 40.15 vs 32.01). 이는 MTS-DIALOG 요약이 평균 3문장·48단어로 극단 요약(extreme summarization) 길이에 더 가깝기 때문으로 일부 설명된다.

**데이터 증강(DA)**은 표 7에서 보듯 ROUGE-2와 BERTScore-M1을 제외한 전 지표에서 소폭 향상을 보였다. **가이드 요약(GS)**은 ROUGE-2와 Fact 기반 지표를 제외하고 자동 지표 전반에서 일관된 개선을 보였다.

5.2 Expert-based Manual Evaluation (전문가 기반 수동 평가)

생성 요약의 수동 평가는 **NLG 기준(유창성·비중복성)**과 **의학 기준(사실 추출 기반의 중대한 누락 등)**으로 수행했다. 여기서 **fact(사실)**은 하나의 문장 단위로 독립적으로 기술될 수 있는 최소 정보 단위로 정의했다. 예를 들어

“The father died of stroke at age 89.”는

“The father died.”, “He was 89 yo.”, “Stroke was the cause of death.”의 3개 사실로 분해된다.

수동 평가 기준:

- Fluency(유창성): 읽기 유창한가? (0=전혀, 1=낮음, 2=보통, 3=높음)

- Non-redundancy(비중복성): 중복이 얼마나 적은가? (0–3)

- Critical Omissions(중대한 누락): 누락된 의학적 사실 수

- Hallucinations(환각): 환각된 사실 수

- Correct Facts(정확한 사실): 입력 대화 기준으로 정확한 사실 수

- Incorrect Facts(부정확한 사실): 환각이 아닌 오류(예: 나이 오기) 수

수동 계수로부터 다음 점수를 계산:

Factual Precision = (#CorrectFacts) / (#SystemOutputFacts)

Factual Recall = (#CorrectFacts) / (#ReferenceFacts)

HallucinationRate = (#HallucinatedFacts) / (#SystemOutputFacts)

OmissionRate = (#OmittedFacts) / (#ReferenceFacts)

#SystemOutputFacts = Correct + Incorrect + Hallucinated

최종 사용자(의사가 시스템 요약을 편집하는 데 드는 노력)를 가늠하기 위해, Levenshtein 편집거리(문자 단위 삽입·삭제·치환·전치 최소 횟수)를 계산했다:

(i) 시스템 요약 vs 참조 요약, (ii) 시스템 초기 요약 vs 사람이 모든 문제를 수정한 요약. 그런 다음 더 긴 요약의 길이로 나눠 정규화했다.

전문가 평가의 일관성을 측정하기 위해, 의료 배경의 주석자 2명이 공통 100건을 독립적으로 라벨링했고, 나머지 300건은 단일 주석으로 진행했다.

- 등급형 점수의 피어슨 상관: 유창성 0.631, 비중복성 0.894

- 참조 사실 수 및 시스템의 정확/누락/환각/오류 사실 수에 대해 Cohen’s κ=0.467, F1=0.675(엄격 기준)

- 사실 수에서 ±1 또는 ±2의 오차를 허용한 완화 F1: 0.875 / 0.957

- 두 주석자의 사실 수 피어슨 상관(매크로 평균): 0.862

수동 평가 결과(표 10)는 대체로 표 7의 자동 평가를 확증한다. Factual Recall/F1에서 모델 #2–#4가 베이스라인(#1)보다 우수했다. **모델 #3 대비 모델 #4(DA 추가)**는 유창성·비중복성·Factual Recall/F1 향상, 중대한 누락 감소를 보였지만, **환각률이 1% → 3%**로 증가했다.

가이드 요약·증강이 없는 모델 #2는 두 방법을 모두 쓴 모델 #4와 유사한 결과를 냈고, **자동 사실 추출 지표(표 7)**로는 #2가 더 높게 랭크되었다. 이는 GS가 사실의 정밀도(+5.5%)를 높이는 대신 재현율(−5%)을 낮추고, DA가 그 추세를 되돌리는 효과가 있음을 시사한다. 또한 GS 실험에서 학습 데이터에 20개 섹션 헤더를 프리픽스로 넣었기 때문에, 사실 기반 성능이 프리픽스에 더 민감해져 섹션 간 사실 패턴의 일반화가 방해되었을 가능성이 있다. 반면 토큰 기반 지표(ROUGE-1, BERTScore)에서는 프리픽스가 성능 향상에 도움이 되었다. 또 GS는 비중복성 개선, **환각률을 4%→1%**로 낮추는 데 기여했다.

네 모델의 평균 요약 길이는 각각 9.76 / 24.60 / 19.77 / 21.45 토큰이었다. 길이 편향을 보기 위해, 요약 길이와 BLEURT(자동 지표), 요약 길이와 **Factual F1(수동 지표)**의 상관을 계산했다.

- BLEURT ↔ 길이의 상관: 모델 #1~#4가 각각 −0.200, −0.027, −0.147, −0.173(낮고 음의 상관)

- Factual F1 ↔ 길이의 상관: −0.511, −0.230, −0.268, −0.409(더 큰 음의 상관)

→ 요약이 길수록 오류가 늘어날 위험이 있음을 시사한다.

5.3 Correlation between Evaluation Metrics (평가 지표 간 상관)

표 11은 자동 지표들 간의 피어슨 상관이다. DeBERTa 기반 BERTScore-M2가 n-그램 지표(ROUGE-1/2/L)와 임베딩 기반 지표(BERTScore-M1, BLEURT) 모두와 가장 높은 상관을 보였다. 반면 ROUGE-1/2는 Fact-Core/Fact-Full과 더 높은 상관을 보였다.

표 12는 자동 지표와 수동 점수 간 상관을 제시한다. 수동 점수와의 상관에서는 BLEURT가 사실 수(정확성)와 전문가 기반 정답성 평가에 가장 높은 상관을 보였다. 또한 생성 요약을 수정하는 노력의 지표로 사용한 Levenshtein 거리와도 가장 높은 상관을 보였다.

더 나아가, 수동 사실 지표는 ROUGE-1/2/L보다 임베딩 기반 지표들과 더 잘 상관되었다(자동 사실 추출 지표와는 대조적). 이는 부분적으로 자동 사실 추출의 커버리지 한계가 수동 사실 식별보다 낮기 때문으로 설명될 수 있다. 이 관찰은 중요한 실증적 통찰을 제공한다. 즉, 자동/기호적 사실 추출의 제한된 커버리지라는 상한이 상관 분석을 신경 임베딩 방법에 불리하게 편향시킬 수 있다는 점이다. 신경 임베딩은 대규모 사전학습을 통해 보다 넓은(암묵적) 커버리지를 갖기 때문이다.

공개된 임상 노트에서 의료 지식을 가진 사람들에게 대화를 만들도록 했다. (이게 맞음? 쉽지 않네 사람이 만든 데이터)

데이터 통계

합성 데이터를 합성 데이터하고 하는 경우가 너무 많아서 이걸 제대로 된 데이터라고 하는 게 맞나 싶기도 하고,,,,

그래도 비슷한 결과라도 나왔으면 모르겠는데....

https://github.com/abachaa/MTS-Dialog

GitHub - abachaa/MTS-Dialog: A new collection of 1.7k doctor-patient conversations and corresponding clinical notes/summaries.

A new collection of 1.7k doctor-patient conversations and corresponding clinical notes/summaries. - abachaa/MTS-Dialog

github.com

데이터 셋은 여기있다.

https://huggingface.co/datasets/EdinburghNLP/xsum

EdinburghNLP/xsum · Datasets at Hugging Face

Simone Favaro got the crucial try with the last move of the game, following earlier touchdowns by Chris Fusaro, Zander Fagerson and Junior Bulumakau. Rynard Landman and Ashton Hewitt got a try in either half for the Dragons. Glasgow showed far superior str

huggingface.co

학습 데이터 셋

https://github.com/EdinburghNLP/XSum

GitHub - EdinburghNLP/XSum: Topic-Aware Convolutional Neural Networks for Extreme Summarization

Topic-Aware Convolutional Neural Networks for Extreme Summarization - EdinburghNLP/XSum

github.com

그 깃허브

https://huggingface.co/datasets/knkarthick/samsum/viewer/default/train?views%5B%5D=train&row=2

knkarthick/samsum · Datasets at Hugging Face

Ellen: Hi, honey, sorry I've been so unreachable lately, the redecoration is a nightmare. Kate: Don't worry, sweetie, what's wring with the redecoration? Ellen: Well, nothing's wrong per se, it's just it's taking so much time, I barely sleep nowadays... Ka

huggingface.co

또 학습 데이터

여기선 Xum으로 1차 fine-tuning, samsum으로 2차 fine-tuning, 그리고 앞에 프리픽스 넣는 GS, 마지막으로 데이터 증강을 진행해서 마지막 학습까지 한 것이 있는데 성능은 다 하는 것이 좋지만 단순 fine-tuning만 해도 성능은 그렇게 나쁘지 않다.

| 문제 상황 | 의사들은 환자 진료 후 임상 노트 작성에 하루 52–102분을 소비 → 번아웃·만족도 저하. 의사–환자 대화로부터 정확한 임상 노트 자동 생성이 필요. |

| 데이터 (MTS-DIALOG) | 구성: 공개 임상노트(MTSamples)에서 섹션을 추출하고, 의료 배경 주석자 8명이 각 섹션을 기반으로 합성 대화를 작성(외래/응급 맥락·의학용어 대화화 규칙 포함). 섹션 정규화: 원문 279개 헤더 → 20개 1단계 헤더로 통일(Assessment, PMH 등). 규모/전문분야 분포: 1,701 대화–노트 쌍, 총 제작 약 1,800시간, 분포= 일반의학 1,035 / SOAP 79 / 신경과 296 / 정형 208 / 피부 56 / 알레르기·면역 27. 통계(길이/턴): 대화 총 15,969턴/18,406문장/241,685단어, 요약 총 5,870문장/81,299단어; 샘플 평균= 대화 9턴·11문장·142단어, 요약 3문장·48단어. 품질보증: (1) 의료 경력자 채용 (2) 1:1 피드백 교육 (3) 독립 검증 루브릭(0.1–1.0) 및 경미 수정(최종품질은 보고치 이상). 루브릭 빈도: 1.0=51%, 0.7=32%, 0.5=4%, 0.3=11%, 0.1=1%. 현실성(블라인드 테스트): 실대화 52 vs 합성 52 구분 과제에서 오분류 26.92%; 실대화는 비유창성/중단이 더 잦음(합성은 상대적으로 깔끔). → 합성 데이터의 실전 유사성과 차이를 동시 보고. 증강 공개: 역번역(영↔불/서)으로 3,603쌍 추가 공개. |

| 방법론 | 모델: BART/PEGASUS 계열. 4구성 비교 1 BART 기본, 2 사전 미세조정(PFT: XSum→Samsum), 3 PFT+가이드 요약(GS: 섹션 헤더 프리픽스), 4 PFT+GS+데이터 증강(DA: 역번역). |

| 실험 세팅 | 학습/평가 분할: Train 1,201 / Dev 400 / Test 100. 학습: Tesla K80×4, 4 epochs, lr=3e-5, L2 wd=0.1. |

| 결과 (자동평가) | ROUGE·BERTScore·BLEURT·FactScore로 비교. XSum PFT가 큰 이득(ROUGE-1 40.15 vs CNN/DM 32.01), GS/DA는 대부분 지표 상승(일부 예외). |

| 결과 (전문가평가) | 비교 4모델의 수동평가(100샘플): Factual F1: 1 0.6822 → 2 0.7632 → 3 0.7576 → 4 0.7675(최고); Hallucination: 3 1%(최저), 4 3%, 2 4%; Omission: 2/4 33%; 편집거리(wrt Correction): 2 0.4944(최저). |

| 기여 | (1) 공개 벤치마크: 대화↔노트 1,700+쌍(섹션 20종 정규화) 최초 공개 (2) 방법 비교 체계화: PFT·GS·DA를 동일 프로토콜로 정량 비교 (3) 복합 평가 프레임: ROUGE/BERTScore/BLEURT/FactScore + 전문가평가 동시 운영 (4) 합성 데이터 현실성을 블라인드로 검증. |

| 한계 | (i) 합성 대화 의존: 실제 대화의 비유창성·STT 오류 반영 한계 (ii) 데이터 규모/질병 스펙트럼 제한: 대규모 오픈도메인 요약 코퍼스 대비 작음 (iii) 모델 범위 제한: 더 큰/다른 모델에서는 결과가 달라질 수 있음 (iv) 원 자료 내 잠재 편향. |

| 즉시 적용 팁 | 데이터 스타일 정합이 중요: 요약 길이(평균 3문장/48단어)가 짧아 XSum PFT가 유리. 목적별 스위치: 정밀도/환각↓가 중요→ GS(섹션 프리픽스), 누락↓·재현율↑가 중요→ DA(역번역) 병행. 선택 지표로는 BLEURT-20을 권장(전문가평가와 상관↑). |

임상 대화에서 임상 노트 자동 생성: MTS-DIALOG 기반 실증 연구 정리

원문: An Empirical Study of Clinical Note Generation from Doctor-Patient Encounters (EACL 2023)

한눈에 보는 핵심 요약 (TL;DR)

의료 도메인 대화 요약을 위해 의사-환자 대화 ↔ 임상 노트 쌍 1,701개로 구성된 공개 데이터셋 MTS-DIALOG를 만들고, BART/PEGASUS 계열 모델에 대해 사전 미세조정(특히 XSum), 가이드 요약(섹션 헤더 프롬프트), 역번역 증강을 결합해 성능을 비교했다. 자동/수동 평가를 종합하면, 사전 미세조정이 가장 큰 이득을 주며, 가이드 요약은 사실 정밀도(Precision)↑, 사실 재현율(Recall)↓ 경향이 있고, BLEURT가 수동 평가(사실 F1, 편집 비용)와 가장 잘 상관했다. 최선 모델도 사실 누락율이 ~33%, 환각률 1–4% 수준이라, 사실성·누락 완화가 향후 과제다.

1) 문제 설정

- 임상 노트 작성 부담: 의사들은 일 평균 52–102분을 문서화에 사용 → 번아웃, 만족도 저하. 목표는 의사-환자 대화로부터 사실적으로 정확한 임상 노트 자동 생성.

2) 데이터셋 (MTS-DIALOG)

- 출처/제작: 공개 MTSamples의 비식별 임상 노트를 기반으로, 의료 배경을 가진 8명의 주석자가 **대화(Doctor–Patient)**를 섹션별로 시뮬레이션 생성. 279개 섹션 헤더 → 20개 1단계 헤더로 정규화.

- 규모/통계: 1,701 대화-노트 쌍, 대화 ~1.6만 턴/1.8만 문장, 노트 ~5,870문장, 노트 평균 길이 3문장(48단어).

- 품질 보증: 독립 검증 루브릭(0.1–1.0). 1.0(완전 적합) 51%, 0.7 32% 등으로 보고(검증 후 경미 수정 반영).

- 실데이터 유사성(블라인드 테스트, n=104): 실대화의 56%만 ‘실제’로 식별, 합성의 10%는 ‘실제’로 착각, 전반 오분류 27%. 실대화가 비유창성/중단이 더 많았음. → 합성 대화가 유의미한 초기 학습 자원이라는 근거.

3) 방법론(모델·학습·평가) — Step by Step

A. 요약 모델 구성

- 기저 모델: BART-large, PEGASUS-large.

- 사전 미세조정(PFT):

- XSum, Samsum(대화 요약), 일부는 CNN/DailyMail 대비 비교.

- XSum 사전 미세조정이 가장 큰 이득(요약 길이/스타일 유사성 영향).

- 가이드 요약(GS): **섹션 헤더(예: Assessment, Family History 등 20종)**를 프리픽스로 입력해 섹션별 요약을 유도.

- 데이터 증강(DA): **역번역(영↔불/서)**로 문장 다양성 확대(모델은 OPUS-MT 계열). 증강 결과 3,603쌍도 공개.

B. 학습 설정

- 장비/스케줄: Tesla K80 ×4, 4 epochs, lr=3e-5, weight decay=0.1. 데이터 분할: Train 1,201 / Dev 400 / Test 100.

C. 평가 지표

- 자동 평가: ROUGE-N/L, BERTScore(M1/M2), BLEURT-20, Fact Score(코어/풀: 자동 의학 사실 추출 기반).

- 전문가 수동 평가:

- 유창성(0–3), 비중복성(0–3)

- 사실 정밀도/재현율/F1, 환각률, 누락률(참조 사실 대비)

- 편집비용: Levenshtein 거리(시스템→정정/참조). 이중 주석 100건 합의 통계(카파·F1·상관) 보고.

4) 실험 결과 (대표 수치)

A. 자동 평가(테스트 100개)

- 사전 미세조정 + 가이드 + 증강(BART-xsum-samsum, GS+DA; Model #4):

ROUGE-1 42.52 / ROUGE-L 34.90 / BLEURT 0.5123 (최고 혹은 동률 최고).

다만 Fact-Core/Full은 PFT만 한 Model #2가 약간 더 높음(0.3753/0.2264). - 요약: GS는 ROUGE, BERTScore ↑이나 Fact 기반은 소폭 ↓ 경향; DA는 전반 소폭↑(예: BLEURT)이나 지표별 상이.

B. 수동 평가(전문가)

- Model #2 (PFT만) vs Model #4 (PFT+GS+DA)

- Factual F1: 0.7632 vs 0.7675(최고)

- Hallucination: 4% vs 3% (Model #3는 **1%**로 최저)

- Omission: 33%(두 모델 동일)

- 편집비용(정정 기준 Levenshtein): 0.4944(최저: Model #2) vs 0.5521

⇒ GS는 Precision↑, Recall↓, DA는 Recall↑(누락↓)이나 환각 약간↑ 경향.

C. 상관 분석(무엇을 믿을 것인가?)

- 자동↔자동: BERTScore-M2가 ROUGE·BLEURT와 높게 상관. ROUGE는 Fact-Core/Full과 상대적으로 더 높은 상관.

- 자동↔수동: BLEURT-20이 Factual Recall/F1 및 편집비용과 최고 상관(예: Omission와 −0.591) → 사실성 품질 추정에 BLEURT가 가장 신뢰도 높음.

- 길이 편향: 요약이 길수록 수동 사실 F1과 음의 상관(예: −0.51 등) → 장문 생성 시 오류↑ 경향.

5) 기여(Contribution)

- 공개 데이터셋: MTS-DIALOG(1,701쌍) — 의사-환자 대화↔임상 노트 대규모 공개 세트 최초 수준. **증강본(3,603쌍)**도 제공.

- 방법 비교의 체계화: 사전 미세조정, 가이드 요약, 역번역 증강의 효과를 자동+수동 복합 평가로 분해.

- 평가 통찰: 의료 요약에서 BLEURT가 수동 평가와 가장 일관; **GS는 사실 정밀도↑·재현율↓**라는 정확도-포괄성 트레이드오프를 확인.

6) 한계(Limitations)

- 대화는 합성(실노트 기반 시뮬레이션) → 실제 음성 전사 특유의 비유창성·오류·중단은 상대적으로 적다. 실대화 벤치마크가 생기면 외적 타당성 재검증 필요.

- 데이터 규모/질병 범위 제한: 개방형 요약 코퍼스 대비 작다 → 대형 모델 파인튜닝에는 제약. 섹션 프리픽스(20종) 의존으로 섹션 간 사실 일반화 방해 가능성.

- 최선 모델도 누락 큼(≈33%)·환각 존재(1–4%). 사실 추출 기반 자동 평가의 커버리지 한계도 관찰됨.

7) 재현/적용 체크리스트 (실험 순서)

- 데이터 준비: MTS-DIALOG 로드(섹션 헤더 20종 유지). 필요 시 **역번역(영↔불/서)**로 증강.

- 사전 미세조정: BART에 XSum→Samsum 순으로 두 단계 PFT 권장(대화 요약 적합도 향상).

- 가이드 요약 옵션: 입력에 [SECTION] 헤더 프리픽스 추가하여 학습/추론 일치. Precision↑·Recall↓ 트레이드오프 감안.

- 학습 설정: lr=3e-5, wd=0.1, 4 epochs(K80×4 기준). Train/Dev/Test = 1201/400/100.

- 평가: ROUGE, BLEURT-20(권장), BERTScore, Fact-Score(Core/Full) + 전문가 수동 평가(사실 F1, 환각/누락, 편집비용). 길이-오류 상관 주시.

8) 연구자 관점의 해석(타당성·한계·확장)

- 왜 XSum PFT가 이득인가? 이 과제의 **짧은 요약 스타일(평균 3문장/48단어)**이 XSum의 극단 요약 특성과 맞아 내용 선택/압축에 유리.

- GS의 역설: 프리픽스는 **섹션별 토큰 정합성(ROUGE/BERTScore)**을 끌어올리지만, 사실 범주 일반화를 저해해 Fact-Recall 저하로 귀결(논문의 관찰).

- 평가 지표 선택: 의료 도메인에서는 BLEURT가 수동 사실성/편집비용과 더 일치 → 모델 선택/얼리스톱 신호로 BLEURT를 우선 고려. Fact-Score는 커버리지 한계로 자동↔수동 상관이 약화될 수 있음.

9) 표로 보는 전체 정리

구분 내용| 문제 상황 | 의사 문서화 시간·피로도↑ → 대화→임상노트 자동 생성 필요. |

| 데이터 | MTS-DIALOG 1,701쌍, 대화/노트 섹션 정규화(20헤더), 합성 대화지만 실대화와 혼동될 정도로 유사(블라인드 오분류 27%). |

| 모델 | BART/PEGASUS, 사전 미세조정(XSum, Samsum 등), 가이드 요약(섹션 프리픽스), 역번역 증강(불/서). |

| 학습 설정 | K80×4, 4 epochs, lr=3e-5, wd=0.1; 1201/400/100 분할. |

| 자동 평가 | Model #4(BART-xsum-samsum, GS+DA): ROUGE-1 42.52, BLEURT 0.5123. Fact-Core는 Model #2가 근소 우위. |

| 수동 평가 | Factual F1: #4 0.7675(최고) / #2 0.7632. Hallucination: #3 1%(최저), #4 3%, #2 4%. Omission: 둘 다 33%. 편집비용: #2 최저(0.4944). |

| 상관 분석 | BLEURT ↔ 수동 사실성/편집비용 최고 상관; ROUGE ↔ 자동 FactScore 상관 상대적 우위. 길이↑ → 사실 F1↓ 경향. |

| 기여 | 공개 데이터셋 제시, PFT/GS/DA 영향 체계화, 평가지표 상관 통찰 제공. |

| 한계 | 합성 대화(실전사 오류·비유창성 부족), 데이터 규모/질병 커버리지 제한, 여전히 누락/환각 존재. |

10) 실험 적용 팁(당신의 프로젝트에 바로 쓰기)

- Baseline: BART-large에 XSum→Samsum PFT 후, MTS-DIALOG 파인튜닝.

- Precision vs Recall 조절:

- **정확도(환각 최소)**가 중요하면 GS 사용(섹션 프리픽스) + 길이 제약.

- **포괄성(누락 최소)**이 중요하면 **DA(역번역)**를 섞되, 환각 모니터링.

- 모델 선택 신호: BLEURT-20 + **샘플 수동 점검(사실 F1, 편집비용)**을 함께 보정. Fact-Score는 보조 신호로 사용.

관련 연구 맵 & 본 논문의 차별점(기여) 정리

아래는 원문(An Empirical Study of Clinical Note Generation from Doctor-Patient Encounters, EACL 2023)을 근거로, 임상 대화 요약/임상 노트 생성 분야의 선행연구를 범주별로 정리하고, 본 논문이 어디서 어떻게 새 기여를 했는지 한눈에 대비한 표입니다.

1) 분야별 선행연구 핵심 정리

축 대표 연구/데이터 핵심 아이디어/세팅 한계(원문 기술) 본 논문과의 차이| 오픈 도메인 대화/미팅 요약 | 대화/미팅 요약 모델·코퍼스(Goo & Chen 2018; Li 2019; Shin 2022; ICSI/AMI 등) | 대화·미팅 요약을 위한 모델/코퍼스 축적 | 오픈 도메인은 연구가 있으나, 의료 대화 요약은 상대적으로 미개척(under-studied)이라고 명시. | 의료 대화에 특화된 대규모 공개 데이터셋과 평가 체계를 제시(의료 맥락에서의 결핍 보완). |

| 의료 대화→요약/노트 생성 (영문) | Joshi 2020(telemedicine, pointer-generator, 대화 일부 스니펫으로 학습)·Zhang 2021(BART 파인튜닝, 두 개 전문 분야+HPI 섹션 한정)·Krishna 2021(Cluster2Sent, SOAP 노트, 추출+생성 혼합)·Enarvi 2020(RNN/Transformer S2S, 정형 리포트, 정형외과 도메인) | 다양한 모델로 의사-환자 대화→요약/노트 시도 | 데이터 비공개, 전문/섹션/도메인 한정 등 범용성·재현성 한계. | 1,700쌍 규모 공개 데이터셋으로 재현가능 벤치마크 제시 + SOTA 사전미세조정/가이드/증강을 체계 비교. |

| 의료 대화 요약 (중국어 생태) | Song 2020(계층 인코더-태거, 추출 요약; 문제/치료 요약 분리) + 중국 온라인 헬스 플랫폼 대화 코퍼스(요약 부재) | 비영어권 의료 대화 자원 | 일부 코퍼스는 요약이 없음, 직접 비교 어려움. | 영어권 대화↔노트 쌍을 공개해 직접적 학습·평가 가능. |

| 소규모 노트 생성·평가 상관 연구 | Moramarco 2022(대화-노트 57쌍) | 자동지표–인간평가 상관 탐색 | 작은 규모, SOTA 벤치마크 목적 아님 | 본 논문은 대규모 데이터로 자동지표(ROUGE/BERTScore/BLEURT/FactScore)–전문가평가 상관을 정량 검증. |

| 평가 방법론 일반론 | ROUGE 등 자동평가의 사실성·중요정보 누락 한계 지적, BLEURT/BERTScore, 도메인 특화 FactScore 도입과 전문가 평가 병행 | 의료 NLG에서 표준화 필요, 자동지표 편향 경계 | 의료 맥락에 맞춘 복합 평가 설계 필요. | 본 논문: BLEURT/BERTScore/FactScore+전문가 복합평가로 상관·신뢰도를 분석하는 일관된 프로토콜 제시. |

2) 본 논문이 선행연구 대비 “새로 한 것(What’s new)” — 근거 포함

- 처음으로 “규모 있게 공개된” 의사-환자 대화↔임상 노트 데이터셋(MTS-DIALOG, 1,700쌍)

- 저자들은 *“의료 대화와 연계 노트를 이 규모로 공개한 것은 처음”*이라고 명시. 연구 커뮤니티의 접근·재현을 가로막던 비공개 데이터 한계를 해소.

- 합성 대화의 “현실성”을 블라인드로 검증해 데이터 타당성을 제시

- 실대화 vs 합성대화 104개 블라인드 판별에서 오분류 26.9%, 합성의 현실성이 확인됨(단, 실대화가 더 비유창성/중단 多). 데이터의 실전 유사성과 한계를 동시에 정리.

- 가이드 요약(섹션 헤더 프리픽스) + 역번역 증강을 의료 노트 생성 맥락에서 체계적으로 비교

- 섹션 헤더를 프리픽스로 넣어 섹션별 요약을 유도(가이드 요약), 프랑스어/스페인어 역번역 증강으로 데이터 다양성 확대 및 증강본(3,603쌍) 공개.

- 사전 미세조정 타깃의 중요성을 임상 노트 길이/스타일과 연결해 실증

- XSum 사전미세조정이 CNN/DailyMail 대비 크게 우수, 이는 **요약 길이(3문장/48단어)**가 XSum의 익스트림 요약 특성과 맞닿아 있기 때문이라는 분석을 제시.

- 자동지표(ROUGE/BERTScore/BLEURT/FactScore)와 의료 전문가 평가 간 상관을 동일 코퍼스에서 정량 분석

- ROUGE의 한계를 짚고 BLEURT-20, BERTScore, 도메인 FactScore를 함께 사용, 전문가 평가와의 상관 연구를 단일 벤치마크에서 수행(메트릭 선택의 근거 마련).

3) “이 논문의 위치”를 더 명확히: 선행 대비 차별 포인트 요약

- 데이터 공개성·스케일: 기존 연구 다수가 비공개/소규모/특정 섹션 한정인데 반해, 본 논문은 대화↔노트 쌍을 대규모로 공개하여 재현·확장 연구의 기점을 제공.

- 현실성 검증(Blind test): 합성 데이터의 실전 유사성을 정량 검증하여 공개 데이터셋의 사용 타당성 근거를 제시(동시에 비유창성/중단 분포 차이 등 한계도 투명 공개).

- 방법 비교의 체계화: 사전 미세조정(XSum 등) → 가이드 요약(섹션 헤더) → 역번역 증강을 동일 프로토콜로 비교, 무엇이 언제 이득인지를 임상 노트 생성 맥락에서 명확히 함.

- 평가 표준 제안: BLEURT/BERTScore/FactScore + 전문가 평가를 한자리에 모은 평가 프레임을 제공하고, 지표–인간 상관을 보고해 실무적 모델 선택 신호를 제시.

4) 한 문장 정리(Statement of Contribution)

본 논문은 (i) **대화↔임상 노트 공개 데이터셋(MTS-DIALOG)**을 처음으로 현실성 검증까지 포함해 제시하고, (ii) 사전 미세조정/가이드 요약/역번역 증강의 효과를 임상 맥락에서 체계 비교, (iii) BLEURT·BERTScore·FactScore-전문가평가의 상관 분석으로 의료 노트 생성의 신뢰 가능한 평가·벤치마크 프로토콜을 정립했다는 점에서, 비공개·분절적이던 기존 연구들을 재현 가능한 공개 생태계로 끌어올렸다는 실질적 기여가 있습니다.

필요하시면 위 표를 LaTeX 표/연구계획서 섹션으로 바로 붙일 수 있게 포맷팅해 드릴게요.

결과·결론·한계·기여·타당성 — 면밀 검토 정리

대상: An Empirical Study of Clinical Note Generation from Doctor-Patient Encounters (EACL 2023)

결과(Results) — 핵심 수치와 관찰

- 전문가 수동평가(100개 테스트)

- Factual F1: Baseline(#1) 0.6822 → #4(PFT+GS+DA) 0.7675(최고); #2(PFT) 0.7632, #3(PFT+GS) 0.7576.

- Hallucination(환각): #3 1%(최저), #4 3%, #2 4%. Omission(누락): #2/#4 33%, #3 37%, #1 47%.

- 편집비용(정정 대비 Levenshtein): #2 0.4944(최저).

- 설계별 효과

- **사전 미세조정(PFT)**이 사실성·유창성 개선, 누락 감소에 핵심적 역할.

- **가이드 요약(GS)**은 정밀도↑·환각↓(예: 4%→1%), 대신 Recall↓(섹션 프리픽스에 민감해 섹션 간 사실 일반화를 저해).

- **역번역 증강(DA)**은 Recall·F1 회복과 유창성/비중복성 소폭 개선, 단 환각 소폭↑(1→3%).

- 자동–수동 지표 상관

- 자동지표 간: BERTScore-M2가 ROUGE·BLEURT와 가장 높은 상관, ROUGE는 FactScore와 더 상관.

- 자동↔수동: BLEURT-20이 수동 사실 F1/Recall 및 편집거리와 최고 상관(누락과 −0.591 등).

- 길이 편향: 요약이 길수록 수동 F1과 음의 상관(예: −0.511, −0.409 등) → 장문일수록 오류↑ 경향.

- 합성 대화의 현실성(Blind test)

- 실대화 52 vs 합성 52 블라인드 판별: 오분류 26.92%. 합성이 비교적 현실적이나, 실대화는 비유창성·중단이 더 잦음.

결론(Conclusions)

- 핵심 결론: (i) 사전 미세조정이 사실성·유창성↑ 및 **중요 사실 누락↓**에 핵심, (ii) 가이드 요약은 정밀도↑·환각↓ 대가로 Recall↓, (iii) 공개 데이터셋과 복합 평가로 임상 노트 생성의 벤치마크 기반 마련.

- 최선 모델의 한계치: 유창성 2.44/3, Factual F1≈0.76에 도달했으나 환각 3%, **누락 33%**는 여전히 큼(추가 개선 필요).

한계(Limitations)

- 합성 대화 의존: 실제 의사-환자 대화의 비유창성·중단·STT 오류가 덜 반영될 수 있음 → 실대화 벤치마크에서 외적 타당성 재검증 필요.

- 데이터 규모·질병 커버리지: 오픈 도메인 요약 코퍼스 대비 작음, 질병 스펙트럼 제한 → 대형 모델 파인튜닝 성능/일반화에 제약.

- 평가 도구의 한계: 자동 Fact 추출은 커버리지 한계로 수동 사실계수와의 상관이 약함(상관 해석 시 편향 유의).

- 모델 범위: 시험한 모델/세팅 일부에 한정, 다른(혹은 더 큰) 모델은 다른 결론을 낳을 가능성.

기여(Contributions)

- 공개 데이터셋 MTS-DIALOG(1,700쌍): 의사-환자 대화↔임상 노트 대규모 공개 세트(섹션 정규화 20종).

- 증강본 3,603쌍 추가 공개(역번역) → 다양성·재현성 향상.

- 방법 비교의 체계화: **PFT(XSum/Samsum)–GS(섹션 프리픽스)–DA(역번역)**를 동일 프로토콜로 정량 비교.

- 평가 프레임 확립: ROUGE/BERTScore/BLEURT/FactScore + 전문가 평가를 한 코퍼스에서 동시 운영, 자동↔수동 상관을 정리(BLEURT가 수동 품질과 최고 상관).

- 현실성 검증(블라인드): 합성 vs 실대화 **오분류 26.92%**로 데이터 실전 유사성에 근거 제시.

타당성(Validity) — 설계·데이터·평가의 신뢰도 점검

- 주석 품질관리: 의료 배경 주석자 채용→1:1 피드백→독립 검증 루브릭(0.1–1.0) 수행·경미 수정 반영(최종 품질은 보고치 이상).

- 현실성 외부 타당성(Blind test): 실·합성 구분 정확히 어렵다는 근거(오분류 26.92%)와 비유창성/중단 분포 차이까지 제시.

- 전문가 평가 신뢰도: 완화 F1 기준 상호합의 0.875/0.957, 사실수 카파·피어슨(0.862) 등 합치도 보고.

- 지표 상관 검증: 자동지표 간/자동↔수동 상관을 포괄 산출(BLEURT-20 최상관, Fact 추출 커버리지 한계 설명).

- 삼각검증(트라이앵귤레이션): 자동 평가+전문가 평가를 동시 사용해 결과를 상호 보강.

요약 표(숫자만 빠르게 보고 싶을 때)

항목 핵심 내용| 최고 성능(수동 F1) | #4: 0.7675, 환각 3%, 누락 33% (편집거리 wrt correction 0.5521) |

| 설계별 효과 | PFT 효과 큼 → 사실성·유창성↑·누락↓ / GS: 정밀도↑·환각↓·Recall↓ / DA: Recall·F1↑(환각 약간↑) |

| 지표 상관 | 자동↔수동에서 BLEURT-20 최상관, 길이↑→수동F1↓(오류↑) |

| 데이터 현실성 | 블라인드 오분류 26.92%, 실대화는 비유창성/중단 더 많음 |

| 공개 자원 | MTS-DIALOG 1,700쌍, 증강 3,603쌍 공개 |

한 줄 결론

사전 미세조정 + (목표에 따른) GS/DA 선택이 임상 노트 생성의 사실성–환각–누락 간 트레이드오프를 가장 잘 다루며, BLEURT-20이 실사용자 관점(수정 부담·사실성)과 가장 맞물리는 선별 지표입니다.

PFT vs. GS vs. DA — 무엇을 왜 썼고, 어떻게 다른가?

아래는 논문이 사용한 세 가지 축(사전 미세조정 PFT, 가이드 요약 GS, 데이터 증강 DA)의 목적·입력 변경점·학습 차이·효과·주의점을 한눈에 비교한 표입니다.

축 무엇(정의) 왜(의도) 어떻게(입·출력/학습) 관찰된 효과 주의점| PFT(Pre-Fine-Tuning) | 본 과제 학습 전, 관련 코퍼스로 요약 모델을 사전 적응 | 임상 노트는 짧고 압축적인 스타일 → XSum/Samsum로 스타일·도메인 갭 축소 | BART/PEGASUS를 XSum→Samsum 등으로 먼저 미세조정 후 MTS-DIALOG에 파인튜닝 | XSum 사전 단계가 큰 이득: ROUGE-1 40.15(BART-xsum-samsum) vs 30.42(BART 기본) 등, 데이터의 **평균 길이(3문장·48단어)**와 맞아떨어짐. | PFT 타깃 선택이 중요(CNN/DM는 32.01로 덜 적합). 과도한 PFT는 스타일 과적합 유의. |

| GS(Guided Summarization) | 입력에 섹션 헤더를 프리픽스로 넣어 섹션별 요약을 유도 | 임상 노트는 섹션 구조(HPI, Assessment 등) → 모델에 구조 신호 제공 | 학습·추론 시 입력 앞에 섹션명 프리픽스(예: “History of Present Illness: …”)를 붙여 헤더+요약을 함께 생성하도록 학습 | 다수 자동지표 ↑(ROUGE-2/Fact는 예외), 환각 감소 경향(정밀도↑) 보고. | 재현율(Recall) 하락 가능: 헤더 신호에 과민 → 섹션 간 일반화 저해 위험. |

| DA(Data Augmentation) | 역번역(영↔불/서)을 이용해 텍스트 다양화 | 작은 의료 코퍼스의 과적합 완화·표현 다양성 확보 | OPUS-MT 등 고성능 번역기로 불어/스페인어를 경유해 역번역(증강 3,603쌍 공개) | 전반 소폭 개선(ROUGE-2, BERTScore-M1 제외) — 특히 **GS와 결합(#4)**에서 최고 BLEURT. | 번역 오류·표현 변형으로 환각 소폭↑ 가능(정밀도 관리 필요). 논문은 프랑스어/스페인어를 오류 적고 어휘 근접해 선택. |

네 축을 조합한 4모델 비교에서, **#2(PFT)**가 큰 도약을 만들고, **#3(PFT+GS)**는 정밀도를, **#4(PFT+GS+DA)**는 BLEURT/전반 성능을 최상으로 이끕니다(ROUGE-1: 30.42→40.15→42.04→42.52).

입력/출력 포맷 — 실전 적용용 미니 가이드

1) PFT 단계(사전 미세조정)

- 입력: (XSum) 기사 본문 → 극단 요약 / (Samsum) 일반 대화 → 대화 요약

- 출력: 해당 코퍼스의 참조 요약

- Tip: 임상 요약의 짧은 길이와 맞아 XSum→Samsum 순서가 유리.

2) GS 단계(섹션 가이드)

- 입력 예(형식):

History of Present Illness: <doctor-patient conversation text>

모델은 헤더 신호 + 헤더별 요약 생성을 함께 학습합니다.

3) DA 단계(역번역 증강)

- 절차: 영어 문장을 FR/ES로 번역→영어로 재번역하여 동일 의미, 다른 표면형 샘플 추가(논문은 불어·스페인어 사용, OPUS-MT 기반).

데이터 예시(논문 표본을 바탕으로 재구성)

(A) MTS-DIALOG 한 샘플의 구조

- 섹션 헤더: History of Present Illness (HPI)

- 대화(요지):

의사–환자가 나이(83세), 기저질환(polycythemia vera), 최근 경과(수개월간 채혈요법 불요), 혼자 내원 등을 주고받음. - 노트(섹션 요약, 요지):

“83세 여성, polycythemia vera 과거력. 팔로업 내원. 수개월간 phlebotomy 불필요. 보호자 동반 없음.”(의학 사실 단위로 압축)

논문은 원본 279개 섹션 헤더를 20개 1단계 헤더로 정규화(예: assessment, allergy, diagnosis, exam, medications, past medical/surgical 등)했습니다. GS는 이 헤더 신호를 입력 프리픽스로 활용합니다.

(B) “대화→노트(가이드)” 입력/출력 예(형식)

- 입력

History of Present Illness: [대화 전문 텍스트] - 출력(요약)

History of Present Illness: [핵심 사실 요약]

(섹션명까지 생성하도록 학습 — 프롬프트와 출력이 구조적으로 정합)

실험적 차이, 숫자로 재확인

- PFT 효과: BART-large(ROUGE-1 30.42) → BART-xsum-samsum 40.15. (XSum이 CNN/DM보다 유리)

- GS 효과: 자동지표 전반 개선(단, ROUGE-2·Fact는 예외) → 구조 신호가 **정밀도↑/환각↓**에 기여.

- DA 효과: 소폭↑(ROUGE-2·BERTScore-M1 제외) — 최종 #4가 BLEURT-20 0.5123로 최고.

한 줄 요약

- PFT로 스타일·장르 갭을 먼저 줄이고, GS로 섹션 구조 신호를 준 뒤, DA로 표현 다양성을 보강하면, 임상 노트 생성에서 정밀도–재현율–환각/누락의 트레이드오프를 유연하게 조절할 수 있습니다. (수치·절차는 위 인용 참조)

필요하시면, 당신의 한국어 의료 데이터에 맞춘 프롬프트 포맷(섹션 프리픽스), 역번역 스크립트, PFT 체크리스트를 바로 뽑아드릴게요.

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| Repurposing Language Models into Embedding Models: Finding the Compute-Optimal Recipe (0) | 2025.09.13 |

|---|---|

| Think you have Solved Question Answering? Try ARC, the AI2 Reasoning Challenge (0) | 2025.09.12 |

| LLM의 중간 계층 표현 능력 논문 리뷰 - LLM middle layer representation ability (0) | 2025.09.05 |

| Language Model 파라미터 감소(Pruning) 논문 5 (1) | 2025.09.03 |

| Language Model 파라미터 감소(Pruning) 논문 4 (0) | 2025.09.02 |