https://arxiv.org/abs/2411.18203

Critic-V: VLM Critics Help Catch VLM Errors in Multimodal Reasoning

Vision-language models (VLMs) have shown remarkable advancements in multimodal reasoning tasks. However, they still often generate inaccurate or irrelevant responses due to issues like hallucinated image understandings or unrefined reasoning paths. To addr

arxiv.org

VLM은 추론 과제에서 발전을 보였으나 Hallucination, 추론 경로 오류 등 이상한 응답 생성하는 경우가 많다!

=> Actor- Critic 구조를 통해 VLM 추론 능력을 향상시키는 Critic-V를 소개함

멀티모달 추론 중 자주 발생하는 VLM의 오류를 줄이기 위해 Reasoner, Critic으로 구성된 프레임워크 Critic-V를 제안하여 추론 오류를 효과적으로 수정하며 Reasoner의 응답을 반복적으로 개선하였음. 이를 통해 복잡한 Reasoning 벤치마크에서 기존 VLM을 이기는 모습을 보였음

1. VLM 오류를 해결하기 위해 Actor-Critic 구조로 확장한 것은 기존 방향과 다르고, Critic을 학습시키는 것이 Self-Refine과는 뚜렷하게 구분

2. 다양한 VLM에 Critic-V 적용 전 후 성능을 비교하여 Reasoning 중심 벤치마크에서 일관된 성능 향상을 입증함

3. 데이터 셋 공개하여 재현 및 활용 가능성이 커졌다.

1. Critic 학습을 위한 데이터 생성은 OpenAI API와 여러 VLM을 활용해야 하여 자원 소모가 크다.

2. 실시간 응답이 요구되는 자율주행이나, 로봇 상황에서는 Feedback 구조가 지연 시간 때문에 문제가 된다.

3. 피드백이 실제로 Reasoner Reasoning에 효과적이라는 보장이 충분히 검증되지 않아 어느 경우에 가장 효과적인지에 대해 분석이 부재

1. 학습시에 LoRA를 활용하여 리소스 사용을 줄이거나, Distill을 통해 작은 모델에 전이하여 실시간 성능 증가

2. 피드백이 Reasoning 개선에 어떤 영향을 주는기 분석하여 유형별로 다양하게 피드백을 주어 성능 향상

3. 질문에 따라 라우터를 둬서 경량 Critic과 정밀 Critic을 선택하는 하이브리드 구조를 통해 효율성과 성능의 균형을 조정

| 연구 목적 | 기존 VLM의 추론 오류(환각, 논리 비약 등)를 줄이기 위해, 외부 평가자(Critic)를 도입하여 Reasoner의 멀티모달 응답 품질을 개선 |

| 문제의식 | 🔸 VLM은 시각정보와 문장을 조합하지만 🔸 자가추론(Self-Refine)은 자기 오류를 제대로 잡지 못함 🔸 외부적이고 자연어 기반의 정교한 피드백 시스템 부재 |

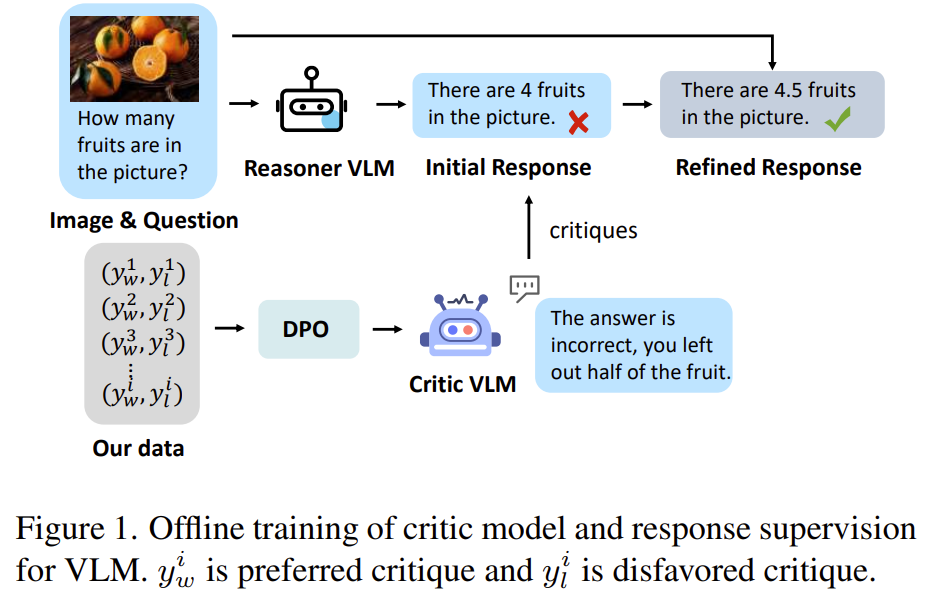

| 핵심 아이디어 | 🎯 강화학습의 Actor-Critic 패러다임 차용 🎯 Reasoner(기존 VLM)가 응답 생성 → Critic이 자연어 피드백 제공 → Reasoner가 Prompt를 수정하며 응답 개선 |

| Critic 작동 방식 | 🔸 응답의 오류를 감지하고 자연어로 비평 (critique) 생성 🔸 평가 점수 대신 수정 유도 문장 생성 🔸 피드백이 충분히 정확할 때까지 루프 반복 |

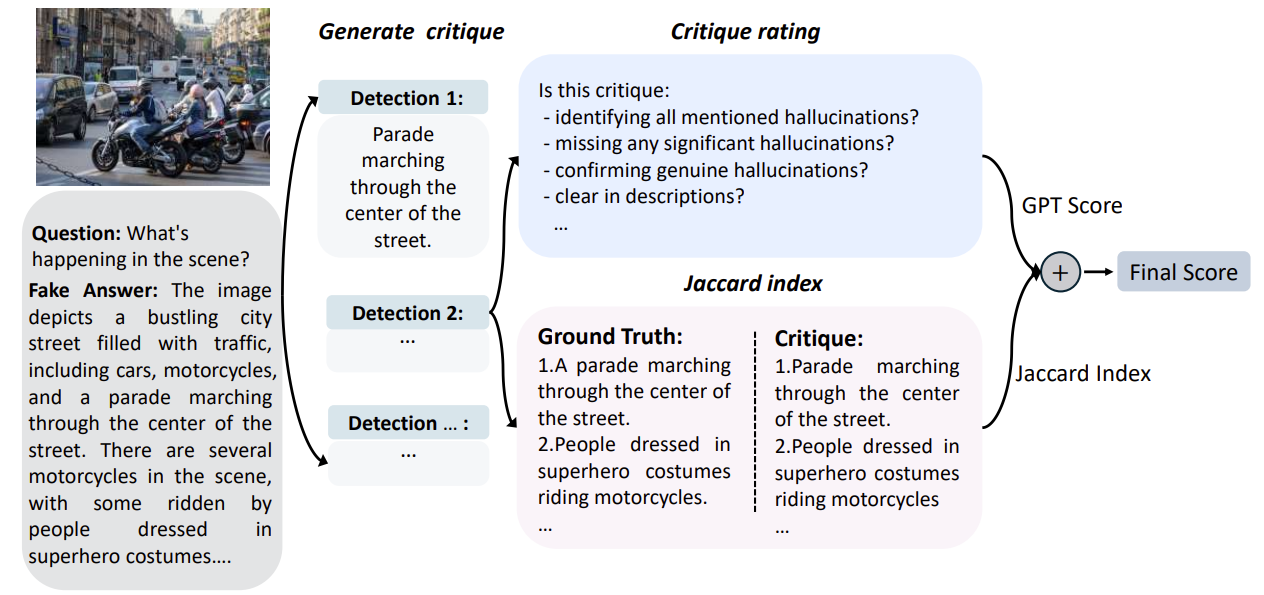

| Critic 학습 방법 | ✅ 학습함 (DPO 적용) 🛠️ VEST: GPT-4o가 오류 삽입된 가짜 정답 생성 🧪 여러 VLM이 critique 생성 📊 Jaccard + GPT 평가로 좋은 vs 나쁜 critique 쌍 수집 ⚙️ DPO (Direct Preference Optimization)으로 선호 critique를 잘 생성하는 모델로 학습 |

| Reasoner 업데이트 방식 | 기존 강화학습의 policy gradient 대신 TextGrad 사용하여 자연어 프롬프트의 gradient 추정 → Critic의 피드백을 받아 프롬프트를 수정하며 반복 개선 |

| 데이터셋 | 📚 Critique-VQA: 29,012개 멀티모달 QA 쌍 + critique 쌍 (선호/비선호) 📊 Jaccard Index와 GPT 평가 기반 평가 지표 사용 |

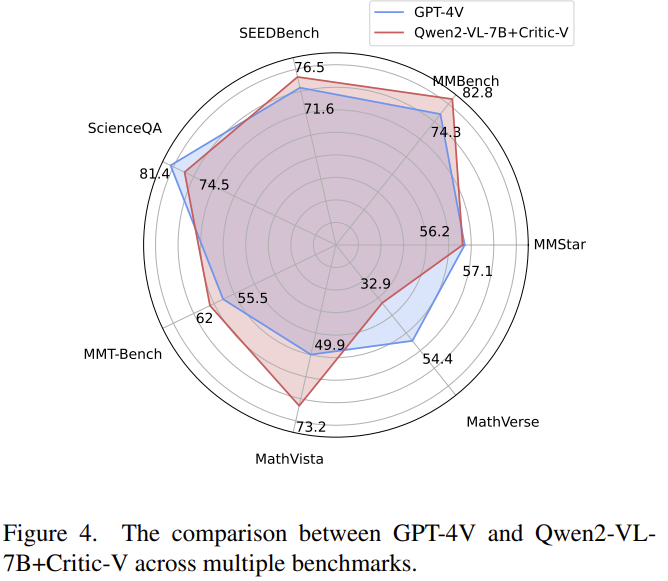

| 성능 향상 | Qwen2-VL-7B 기준: 🔹 MathVista +11.8%, MathVerse +7.1%, 🔹 RealWorldQA +4.8%, ScienceQA +1.1% 🔹 GPT-4V보다 더 나은 성능 달성한 벤치마크 다수 |

| 기존 방법과 비교 | Self-Refine, POVID, SIMA, SCL 등과 비교하여 6개 벤치마크 중 5개에서 우위 |

| 장점 | ✅ Reasoner가 오류를 동적으로 수정 가능 ✅ 외부 비평자가 더 정교하고 직관적인 피드백 제공 ✅ 수학·추론·리얼월드 문제에 강한 개선 효과 |

| 한계점 | ⚠️ 추가적인 추론 비용 (token 수 증가) ⚠️ Critic 학습과정의 비용 ⚠️ 반복 루프가 많아질 경우 오히려 혼란 가능성 |

| 주요 기여 | 🌟 Reasoner-Critic 구조 최초 제안 🌟 자연어 기반 feedback 활용한 VLM 보정 🌟 Critique-VQA dataset 및 DPO 기반 Critic 학습 설계 🌟 수학·논리 reasoning 분야에서 SOTA 수준의 성능 확보 |

논문 “Critic-V: VLM Critics Help Catch VLM Errors in Multimodal Reasoning”는 Vision-Language Model(VLM)이 멀티모달 추론 중 발생하는 오류를 더 효과적으로 검출하고 수정할 수 있도록 하기 위해 외부 Critic 모델을 도입하는 새로운 프레임워크를 제안합니다.

🔍 1. 문제 정의: VLM의 멀티모달 추론 오류

| Hallucination 오류 | 이미지에 존재하지 않는 정보를 생성함 |

| 비논리적 추론 | reasoning 단계가 누적 오류를 유발 (cascading error) |

| 내부 의존 | 외부 피드백 없이 자기 오류를 자가 수정하려 함 (Self-Refine 한계) |

✅ 기존 방법: Self-correction, DPO 등은 내부 self-feedback에 의존해 외부 평가 능력이 부족

🧠 2. 제안 방법: Critic-V 프레임워크

| 🧾 Reasoner | 이미지와 질문에 기반하여 초기 추론 응답 생성 |

| 🧐 Critic | 생성된 응답을 평가하고 자연어로 피드백 (scoring 대신 critique) 제공 |

| 🔄 Feedback Loop | Critic의 피드백으로 Reasoner의 프롬프트를 점진적으로 수정하며 응답 품질 향상 |

📌 주요 특징

- Actor-Critic 구조 차용: 강화학습의 actor(Reasoner)–critic 구조를 자연어 피드백 기반으로 확장

- Prompt 업데이트 방식: policy gradient가 아닌 prompt 자체를 업데이트하여 Reasoner의 추론을 유도

- TextGrad 활용: 자연어 프롬프트의 gradient 계산을 안정화

- DPO로 Critic 학습: 고품질 vs 저품질 critique 간의 preference 학습을 통해 Critic을 고도화

🧪 3. 실험 및 결과 분석

✅ 성능 향상 결과 (Qwen2-VL-7B, DeepSeek-VL-7B에 적용)

| Benchmark | Qwen2-VL-7B | +Critic-V | 향상폭 |

| MathVista | 61.4 | 73.2 | +11.8% |

| MathVerse | 25.8 | 32.9 | +7.1% |

| MMT-Bench | 60.4 | 62.0 | +1.6% |

| ScienceQA | 73.4 | 74.5 | +1.1% |

GPT-4V보다 높은 성능을 달성한 벤치마크도 다수

🔍 비교 실험

| 모델 | RealWorldQA | MMT-Bench | MMBench |

| LLaVA-7B | 50.7 | 36.0 | 68.4 |

| +SCL | 53.2 | 39.6 | 70.8 |

| +Critic-V | 63.5 | 49.7 | 73.8 |

🧪 Ablation 분석

- Critic 없이 prompt만 바꿔도 성능은 소폭 상승

- 하지만 Critic-V 도입 시 가장 큰 성능 향상, 특히 DPO로 학습된 Critic 효과가 큼

🏗️ 4. Critic 학습 구조 및 데이터셋

| 📚 Critique-VQA Dataset | 29,012 쌍의 질문-이미지와 critique 쌍 포함 |

| 🐛 Vision Error Insertion (VEST) | GPT-4o를 활용해 의도적으로 오류가 포함된 답변 생성 |

| 🎯 Rule-based Reward | Jaccard Index + GPT 평가 조합으로 critique의 품질 점수 산정 |

| 🎯 Critic 학습 방식 | DPO (Direct Preference Optimization) 방식으로 좋은 vs 나쁜 critique 구분 학습 |

🎓 5. 주요 기여 및 의의

| 🔄 Critic-V 프레임워크 | 멀티모달 추론 과정에서의 동적 피드백 루프 구현 |

| 📊 대규모 데이터셋 공개 | VQA 질문-이미지-피드백 쌍을 포함한 학습용 데이터셋 |

| 🧱 Plug-and-Play Critic | 기존 Reasoner 모델에 간단히 추가 가능하며 성능 개선 가능 |

| 🔍 수치 기반 보상 아닌 자연어 피드백 | 정성적이고 세밀한 reasoning 오류 식별 및 수정 가능 |

🧭 결론 요약

Critic-V는 기존 Self-Refine 계열의 한계를 넘어서 외부 평가자(Critic)를 도입함으로써 VLM의 멀티모달 reasoning 정확도와 신뢰성을 비약적으로 향상시킨다. 특히 수학, 과학, 리얼월드 QA 등 추론 집중 분야에서 큰 효과를 보였으며, plug-and-play 방식으로 다양한 Reasoner에 적용 가능하다.

정확히 이해하셨습니다! 논문의 Critic-V 프레임워크 방법론은 다음과 같은 "Reasoner → Critic → Feedback Loop" 구조로 동작하며, 말씀하신 구조가 바로 핵심입니다. 아래에 step-by-step으로 체계적으로 정리해드릴게요.

🔁 Critic-V 프레임워크 작동 흐름 (Step-by-Step)

1. Initial Step: Reasoner 생성

- 입력: 이미지 + 질문 (VQA 형태)

- 출력: Reasoner가 생성한 초기 응답 (자신의 내부 추론 능력만 사용)

예: “이미지 속에는 몇 개의 과일이 있나요?”

→ Reasoner: “4개”

2. Critic의 피드백 평가

- Critic은 Reasoner의 응답을 비판적으로 평가함:

- 이미지 및 질문 문맥을 기반으로 오류 탐지

- 정답이 부정확하거나, 논리적으로 불완전한 경우 이를 자연어로 피드백함

- 정확한 경우에는 "더 이상 수정할 필요 없음"으로 판단

Critic: “정답이 틀렸습니다. 사과 반쪽이 빠졌습니다. 실제 과일 수는 4.5개입니다.”

3. Reasoner의 응답 수정

- Critic의 피드백을 기반으로 Reasoner는 자신의 프롬프트를 업데이트

- 이후 새로운 응답 생성

- 이 과정을*최대 반복 횟수(max iterations)까지 반복하거나, Critic이 "충분히 만족스러운 응답"이라고 판단하면 종료

Reasoner 수정 응답: “이미지에는 총 4.5개의 과일이 있습니다.”

→ Critic이 만족하면 최종 제출

🔁 구조 요약 도식 (논문 Figure 기반)

graph TD

A[Question + Image] --> B[Reasoner (초기 응답)]

B --> C[Critic 평가]

C -->|오류 발견| D[피드백 (자연어)]

D --> E[Prompt 수정 후 Reasoner 재생성]

E --> C

C -->|만족| F[최종 응답 제출]

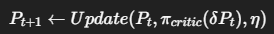

✍️ 수학적 공식 (논문 기준 요약)

- Critic은 텍스트 프롬프트 P_t를 기반으로 feedback δP_t를 생성

- Reasoner는 다음 프롬프트를 다음과 같이 업데이트:

- Critic은 DPO(Direct Preference Optimization)으로 학습되어 좋은 vs 나쁜 피드백을 구별할 수 있음

✅ 정리: 핵심 흐름은 다음과 같습니다

| 1차 응답 생성 | Reasoner가 이미지 + 질문으로 답 생성 |

| 피드백 제공 | Critic이 응답에 오류가 있는지 비판 |

| 정답 수정 | 피드백이 있으면 Reasoner가 프롬프트 수정 |

| 종료 조건 | Critic이 만족하거나 반복 종료 시 응답 제출 |

좋습니다. 논문의 방법론(Method) 부분을 논문 기반으로 정확하고 체계적으로 정리해 드릴게요. 특히 Reasoner-Critic 구조의 동작 방식, Critic의 학습 여부와 학습 방식, 기술적 세부 사항까지 모두 포함해 자세하게 설명하겠습니다.

📌 방법론 개요: Critic-V 구조

목표: VLM이 멀티모달 reasoning 시 오류를 줄이고 정답을 개선하도록, 외부 피드백(Critic)을 반복적으로 받아 Reasoner의 응답을 점진적으로 개선하는 구조 도입.

🧠 1. Reasoner-Critic Framework 구조

🧾 Reasoner (행동자, Actor)

- 입력: 이미지 + 질문 + 프롬프트

- 출력: 자신의 추론에 따른 초기 응답 생성

- 방식: 기존 VLM (예: Qwen2-VL, DeepSeek-VL 등)을 사용

- 특이점: 프롬프트를 동적으로 수정해가며 개선된 응답을 생성함 (policy update ≈ prompt update)

🧐 Critic (비평자, Critic)

- 역할: Reasoner가 생성한 응답을 보고 자연어로 피드백을 줌

- 출력: 응답의 문제점을 설명하는 문장 기반의 critique

- 특이점: scalar reward(점수) 대신 자연어 피드백을 제공하여 더 풍부하고 미세한 조정 가능

🔄 2. 동작 순서 (Interaction Process)

| Step 1 | Reasoner가 이미지 + 질문에 대한 초기 응답 생성 |

| Step 2 | Critic이 해당 응답을 분석 후 비판적 피드백(critique) 생성 |

| Step 3 | Reasoner는 Critic의 피드백을 프롬프트에 반영하여 응답 수정 |

| Step 4 | 위 과정을 반복 (최대 반복 수 or Critic 만족 시 종료) |

🧪 3. Critic은 학습하는가?

✅ 네, Critic은 학습합니다.

Critic은 단순 규칙 기반이 아닌, 자연어로 오류를 지적하고 Reasoner를 유도하는 능력을 학습한 모델입니다. 그 학습 방식은 다음과 같습니다:

🔧 4. Critic의 학습 방법: DPO + VEST

(1) 학습 데이터 구성: VEST (Vision Error inSertion Technique)

- 실제 이미지-질문-정답에 대해 GPT-4o가 오류를 의도적으로 삽입한 가짜 정답(fake answer)을 생성

- 여러 VLM이 그 오류를 찾아내도록 지시하여 다양한 비평(critique)을 생성함

(2) 비평 품질 평가: Rule-Based Reward + Jaccard Index

- critique가 오류를 얼마나 잘 지적했는지 Jaccard(G ∩ C / G ∪ C)로 평가

- GPT 평가도 결합하여 정답과 가장 가까운 critique 선택

(3) Critic 학습: DPO (Direct Preference Optimization) 사용

- Critic에게 좋은 critique와 나쁜 critique를 쌍으로 학습시킴

- 좋은 critique를 선택하도록 확률 분포를 조정

- 여기서 C_w: 선호되는 critique

- C_l: 선호되지 않는 critique

- 전체 학습 데이터: 29,012개 질문-이미지에 대한 critique 쌍

🧠 5. 강화학습 방식의 Prompt 업데이트

Reasoner는 다음 수식처럼 Critic이 제시한 δP_t를 받아 프롬프트를 수정하여 응답을 향상시킴:

- P_t: 기존 프롬프트

- π_critic(δPt): Critic이 제시한 수정 사항

- η: 학습률 (얼마나 반영할지)

이 업데이트는 기존 policy gradient 대신, prompt 자체를 직접 수정하는 방식이라서 TextGrad 기법을 사용해 gradient를 안정적으로 계산함.

📊 6. 실험에서의 구조 정리

| Reasoner | Qwen2-VL-7B, DeepSeek-VL-7B 등 기존 VLM |

| Critic | Qwen2-VL-7B 기반, DPO로 학습된 자연어 평가 모델 |

| 학습 방법 | VEST로 critique 데이터 생성 + DPO로 학습 |

| 개선 방식 | Reasoner가 Critic 피드백을 받아 프롬프트를 수정하며 정답을 갱신 |

✅ 요약

| 핵심 구조 | Reasoner가 응답 생성 → Critic이 자연어 피드백 제공 → Reasoner가 수정 |

| Critic 역할 | 외부 피드백 제공자 (점수가 아니라 설명 기반의 피드백) |

| Critic 학습 | ✅ 학습함. DPO를 통해 좋은 vs 나쁜 피드백을 구별할 수 있도록 학습 |

| 데이터 생성 | GPT-4o 기반 오류 삽입 + Jaccard 기반 품질 평가 |

| 학습 목적 | 더 정밀하고 실제 문제에 강한 multimodal reasoning 수행 가능하게 함 |

✅ 1. 실험 결과 (Results)

📊 주요 벤치마크 성능 비교 (표 요약)

| 모델 | MathVista | MathVerse | MMT-Bench | RealWorldQA | ScienceQA |

| Qwen2-VL-7B | 61.4 | 25.8 | 60.4 | 70.1 | 73.4 |

| + Critic-V | 73.2 (+11.8) | 32.9 (+7.1) | 62.0 (+1.6) | 74.9 (+4.8) | 74.5 (+1.1) |

- 특히 수학(M) 벤치마크에서 큰 향상:

- Qwen2-VL-7B + Critic-V는 MathVista +11.8%, MathVerse +7.1%

- GPT-4V 대비 성능 우위도 다수 달성

- LLaVA-7B 기준 다른 방법과의 비교에서도 가장 높은 성능:

| 방법 | MMT-Bench | RealWorldQA |

| SCL | 39.6 | 53.2 |

| Critic-V | 49.7 | 63.5 |

→ Critic-V는 reasoning-heavy multimodal task에서 Self-Refine, POVID, SIMA, SCL 등 기존 방법들을 전반적으로 능가함

🧠 2. 결론 (Conclusion)

논문은 기존 VLM의 내부 한계(Self-Refine 등)를 극복하고자 외부 critic 모델을 도입한 Reasoner-Critic 프레임워크를 제안하며 다음과 같은 결론을 도출합니다:

- 자연어 기반 피드백이 scalar reward보다 효과적

→ 복잡한 추론 오류를 더 정확히 지적하고 수정 가능 - 외부 학습된 Critic은 실시간 판단 능력을 갖춤

→ Reasoner가 reasoning path를 반복적으로 개선 가능 - 수학·과학 등 논리 기반 멀티모달 추론에 특히 효과적

→ MathVista, ScienceQA 등에서 두드러진 성능 향상 - Prompt 개선 기반 강화학습 정책이 매우 실용적

→ 텍스트 기반 policy를 업데이트하며 직접적인 행동 수정 가능

⚠️ 3. 한계점 (Limitations)

| 📈 계산 비용 증가 | Critic이 각 응답마다 평가하므로 추론 시간과 token 사용량 증가 |

| 🎯 초기 학습 비용 | Critic 학습을 위한 VEST + DPO 데이터 생성 및 학습 비용 큼 |

| 🧪 Iteration 제한 | 너무 많은 피드백 루프는 오히려 성능 저하나 불안정성 가능성 있음 (논문은 max-iteration 제한) |

| 🧠 Reasoner 의존성 | Critic이 잘 학습되어도, Reasoner가 prompt update를 제대로 반영하지 못하면 성능 향상 제한적 |

🌟 4. 주요 기여 (Contributions)

| 🧾 Reasoner-Critic 프레임워크 제안 | 강화학습의 Actor-Critic 구조를 multimodal VLM에 적용한 최초의 시도 |

| 🔍 자연어 Critique 기반 평가 구조 | 점수가 아닌 문장 기반의 피드백을 통해 정교한 오류 수정 가능 |

| 🧪 Critique-VQA 데이터셋 구축 | 29,012개 QA쌍에 대해 다양한 수준의 critique와 preference 쌍 포함 |

| 🧠 DPO 기반 Critic 학습 구조 설계 | 비선호 critique 대비 선호 critique를 학습하는 구조로 외부 평가자 고도화 |

| 📈 벤치마크 전반 성능 향상 실증 | 기존 모델 대비 다수 벤치마크에서 명확한 성능 개선 확인 (특히 reasoning-heavy domain) |

🧾 요약 정리

| ✅ 결과 | 다양한 VQA, 과학, 수학 벤치마크에서 기존 대비 최대 +17.8% 향상 |

| ✅ 결론 | Critic의 자연어 피드백이 VLM reasoning 향상에 매우 효과적 |

| ⚠️ 한계 | 계산 비용, 학습 비용 증가, 반복 한계 존재 |

| 🌟 기여 | Reasoner-Critic 구조 제안 + Critique 데이터셋 공개 + DPO 학습 방식 적용 |