https://arxiv.org/abs/2403.03101

KnowAgent: Knowledge-Augmented Planning for LLM-Based Agents

Large Language Models (LLMs) have demonstrated great potential in complex reasoning tasks, yet they fall short when tackling more sophisticated challenges, especially when interacting with environments through generating executable actions. This inadequacy

arxiv.org

https://zjunlp.github.io/project/KnowAgent/

KnowAgent: Knowledge-Augmented Planning for LLM-Based Agents

Large Language Models (LLMs) have demonstrated great potential in complex reasoning tasks, yet they fall short when tackling more sophisticated challenges, especially when interacting with environments through generating executable actions. This inadequacy

zjunlp.github.io

planning hallucination은 특정 Task에 대한 지식이 부족하여 Planning Trajectories를 제대로 생성하지 못한다.

그리하여 KnowAgent를 통해 자가학습 전략으로 합리적인 Trajectories를 생성하고, 계획 성능을 향상시킨다.

Action Rules (R)은 가능한 액션 순서가 담겨있고, Action Knowledge에는 Action종류(Ea)와, R이 같이 들어있습니다.

이거한 R과 Ea를 통해 Action Knowledge base(Action KB)가 구성됩니다.

그리하여 프롬프트로 구성되어 LLM에 전달되고, 계획 경로를 만듭니다.

그리하여 성공된 데이터는 저장소에 쌓이고, 이 데이터를 활용해 다시 SFT를 진행합니다.

이렇게 하면 여러 모델이 쌓이게 되고, 수렴 혹은 원하는 성능에 도달할 때 까지 반복하게 됩니다.

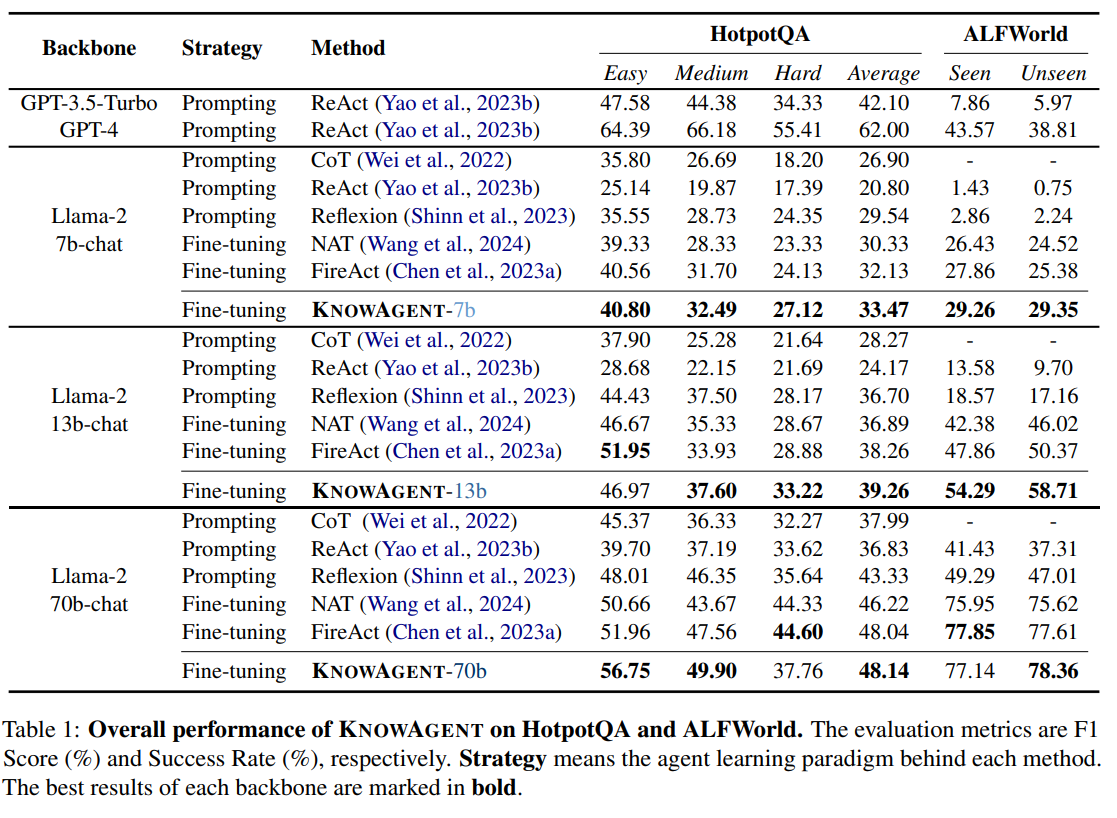

그리하여 GPT 모델을 이기진 못하지만 70b 모델 만으로도 준수한 성능을 보여주게 됩니다.

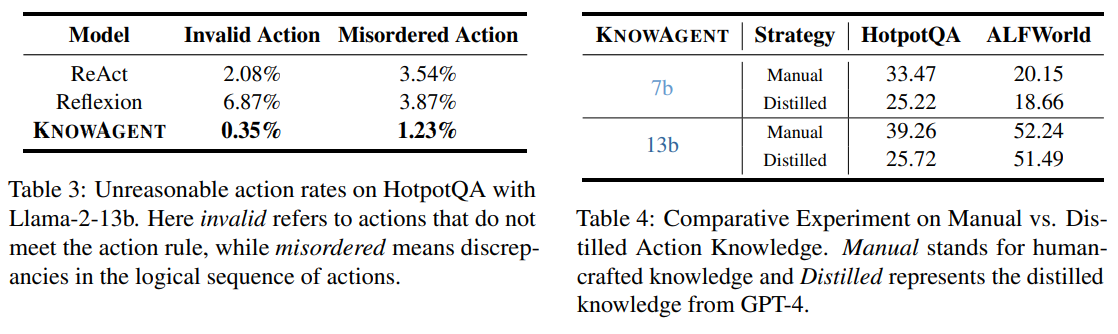

확실히 잘못된 Action을 취하는 확률이 ReAct나 Reflection보다 줄게 되었다.

학습을 통해 Agent의 성능을 향상시키는 것은 제가 이전부터 관심있게 봐오던 부분이라 이런 논문을 찾게 된 것은 굉장히 재밌는 일이었습니다.

도메인 특화되어 작은 모델도 GPT만한 성능을 낼 수 있도록 Fine-Tuning 혹은 강화학습이 진행되면 좋을 것 같네요

| 연구 동기 | - LLM 기반 에이전트가 복잡한 액션 시퀀스를 수행할 때, “Planning Hallucination(잘못된 액션 전이)”가 자주 발생함. - 단순 프롬프트 기법이나 모델 내재 지식만으로 해결이 어려우므로, 명시적 액션 지식을 활용해 해결을 시도. |

| 주요 목표 | - 외부 Action Knowledge(액션 지식)를 LLM의 계획 단계에 주입하여, 에이전트가 논리적으로 가능한 액션 시퀀스만 수행하도록 만듦. - 예: “문을 열기 전에 해당 위치로 이동해야 한다”, “Search → Retrieve → Lookup” 등 유효한 전이를 정의해 계획 오류를 방지. |

| 액션 지식베이스(Action KB) | - (1) 액션 집합(Ea): 모델이 사용할 수 있는 구체적 액션(예: Search, Retrieve, Lookup, Finish). - (2) 액션 전이 규칙(R): 액션 간 합리적 순서를 명시(예: “Search 후에 Lookup 가능”, “Finish는 마지막에만 가능”). - 이 두 요소가 합쳐져, 모델이 계획 시 유효한 액션만 생성하도록 강제. |

| 핵심 아이디어 | 1) 액션 지식을 텍스트로 변환해 LLM에 Prompt로 제공 2) LLM이 ActionPath–Thought–Action–Observation 순으로 단계별 출력을 생성 3) Knowledgeable Self-Learning: - 모델이 생성한 경로 중 올바른 것만 골라 미세조정(Fine-tuning) 데이터로 사용 - 반복(Iteration)을 통해 점진적으로 계획 정확도를 높임 |

| 주요 실험 | - HotpotQA (복합 질의응답): 멀티홉 추론이 필요한 QA 태스크 - ALFWorld (가정 환경 시뮬레이션): 물건 이동·열기·조작 등의 액션이 필요 - 다양한 LLM 백본(Llama-2, Vicuna, Mistral, GPT-3.5/4 등)에 적용하여, 프롬프트 방식 vs. 미세조정 방식 등과 성능 비교. - 목표 지표: (HotpotQA) F1, (ALFWorld) 성공률 등. |

| 실험 결과 | - 대부분의 비교 기법(ReAct, Reflexion, NAT, FireAct 등) 대비 동등 또는 우수한 성능 - HotpotQA에서 F1 상승, ALFWorld에서 성공률 개선을 확인 - “Search 없이 Lookup” 같은 무효 액션이 크게 감소해, “planning hallucination” 문제를 상당히 줄였음. - 일부 경우 GPT-4보다도 높은 성능 달성(특히 ALFWorld의 unseen 환경 등). |

| 장점·의의 | - 계획 오류(Planning Hallucination) 감소: 액션 규칙 기반으로 비합리적 액션 시퀀스 배제 - 자가학습(Self-Learning)으로 GPT-4 등 고성능 모델 의존도 낮춤 - QA와 가상 환경 양쪽에서 효과를 보여 범용성 시사. - 미래에는 웹 브라우징, 로보틱스 등 복합 액션이 필요한 다양한 영역에 적용 가능성이 높음. |

| 한계·개선점 | - 액션 지식(AK) 설계에 여전히 사람이 개입해 전이 규칙을 설정해야 함 - 장문·복합 텍스트 요약·추론 능력이 부족하면, 규칙을 지켜도 답을 잘못 낼 수 있음 - 멀티 에이전트 확장은 향후 과제(현재는 단일 에이전트 환경). |

| 결론 및 요약 | - KnowAgent는 “액션 지식 + 자기학습” 접근으로, LLM 에이전트의 복잡한 계획 실행 문제를 효과적으로 해결. - Planning Hallucination을 체계적으로 완화하고, QA·시뮬레이션 실험 전반에서 높은 성능을 검증. - 향후 액션 지식 자동화, 멀티 에이전트, 장문·복합 추론 연구에 중요한 레퍼런스로 작동할 것으로 기대됨. |

1. 문제 제기와 연구 동기

- LLM 에이전트의 복잡한 계획(Planning) 문제

- 대형 언어 모델(LLM)은 질의응답이나 간단한 추론에는 우수한 성능을 보이지만, 복잡한 작업에서 ‘실행 가능한 액션(actions)’을 순차적으로 수행해 나가는 상황에서는 여전히 한계를 드러냅니다. 특히, 외부 환경과 상호작용하며 복수 단계의 액션이 필요한 문제에서는 모델이 잘못된 행동 시퀀스를 생성하거나(“planning hallucination”), 논리적으로 모순된 순서대로 액션을 배치하는 문제가 빈번하게 발생합니다. 이러한 문제를 해결하기 위해서는 “액션 지식(action knowledge)”이 계획 경로를 형성할 때 명시적으로 반영되어야 합니다.

- Planning Hallucination

- 기존 LLM 기반 에이전트가 보이는 대표적 에러 중 하나로, “모델이 실제 실행 규칙 또는 상식과 맞지 않는 불필요한 액션을 생성”하는 현상을 뜻합니다. 예를 들어, 어떤 정보를 열람해야 하는데 검색(Search) 과정을 건너뛰고 Lookup을 한다거나, 없는 물건을 집으려고 시도하는 등 실제 규칙과 어긋나는 행동이 나타납니다. 이는 모델이 “어떤 순서로 어떠한 행동을 해야 하는지” 명시적으로 학습하지 못했기 때문입니다.

- 연구 목표

- KnowAgent는 위와 같은 계획 오류를 줄이기 위해, 명시적 액션 지식을 LLM의 계획(production) 과정에 결합하는 프레임워크입니다. 액션 지식을 포함한 외부 지식베이스를 통해, 모델이 논리적으로 올바른 액션 시퀀스를 생성하도록 유도하고, 이를 “Knowledgeable Self-Learning” 절차로 반복 학습하여 최적화하는 것입니다.

2. 제안 기법의 전체 구조

논문에서는 KnowAgent를 다음 세 가지 핵심 단계로 설명하고 있습니다.

- Action Knowledge 정의 (Definition of Action Knowledge)

- 액션 지식베이스(Action KB)는 (1) 액션 집합(Ea)과 (2) 액션 간 전이 규칙(R)로 이루어집니다.

- 예컨대 QA 작업에서 Search, Retrieve, Lookup, Finish 와 같은 액션이 있으며, Search → Retrieve, Retrieve → Lookup 과 같이 합리적인 액션 전이가 정의됩니다.

- 이러한 “액션-전이 규칙”을 통해 모델이 불필요하거나 불가능한 행동을 최소화하도록 유도합니다.

- Planning Path Generation (계획 경로 생성)

- 액션 지식(Action Knowledge)을 텍스트 형태로 모델에게 전달하여, 모델이 단계별로 어떤 액션을 취해야 하는지 결정하게 합니다.

- 이때, “ActionPath”, “Thought”, “Action”, “Observation” 순으로 진행 기록(trajectory)을 남기도록 설계합니다.

- 예:

(1) ActionPath: Start → Search → Retrieve …

(2) Thought: "현재 노드는 Search. 다음에는 Retrieve, Lookup, Finish가 가능하다. …"

(3) Action: 실제 실행할 액션 명령

(4) Observation: 액션 수행 결과.

- Knowledgeable Self-Learning (지식 기반 자기학습)

- 모델이 생성한 계획 경로(trajectory) 중 성공적으로 문제를 해결한 것만 걸러내고(Filtering), 이전 반복(iteration)에서 생성된 것과 Merge한 후에 모델을 재학습(Fine-tuning)합니다.

- 이런 과정을 여러 번 반복하며, 모델이 “액션 지식에 따른 합리적 경로”를 더욱 정확하게 학습하도록 돕습니다.

- 반복할수록 잘못된 액션 시퀀스는 제거되고, 효율적·합리적 시퀀스만 남아 모델을 개선합니다.

3. 구체적 방법론

- Action Knowledge를 Text로 변환

- 사람이 정의한 액션 규칙을 모델이 이해할 수 있도록 Prompt 형태로 작성합니다. “무엇을 검색(Search)하고, 어떤 경우에 Finish를 호출하는지” 등을 상세히 서술합니다.

- 사용 예: HotpotQA의 경우

- (1) Retrieve[entity]: 위키피디아에서 특정 엔티티 검색 후 첫 문단 반환

- (2) Search[topic]: Bing 검색

- (3) Lookup[keyword]: 마지막에 찾았던 문단에서 해당 키워드를 포함하는 다음 문장 반환

- (4) Finish[answer]: 최종 답변.

- 이렇게 명시적으로 “다음 단계에서 가능한 액션의 종류와 순서”를 대화형으로 안내해 주면, 모델은 그 제약을 지키려 노력하게 됩니다.

- Trajectory Filtering & Merging

- 모델이 생성한 액션 시퀀스가 실제 “액션 규칙(R)”을 따르는지 검사합니다. 불필요하거나 규칙에 어긋난 경로, 또는 정답을 얻지 못한 경로는 제외하고, 올바른 경로만 재학습 데이터로 활용합니다.

- 예를 들어, Search 없이 Lookup부터 시도하는 경우 등은 “규칙 위반”으로 필터링됩니다.

- 올바른 경로 중에서도 “효율성” 관점에서 더 짧은 액션으로 성공한 경로를 최종 선택하여 Merge한 후 모델을 업데이트합니다.

- 오류율(Planning Hallucination) 감소

- 위 구조 덕분에 모델이 올바른 행동을 순차적으로 학습하게 되고, 잘못된 액션 전이가 크게 줄어듭니다.

4. 실험 및 결과

논문에서는 HotpotQA(복합 질의응답)와 ALFWorld(가정 환경 시뮬레이션) 두 가지 태스크에서 KNOWAGENT를 검증합니다. 다양한 LLM 백본(예: Llama-2 시리즈)으로 실험한 결과, Prompt 방식 또는 타 Fine-tuning 기법보다 KNOWAGENT가 다음과 같은 이점을 보였습니다.

- HotpotQA (F1 스코어)

- 예: Llama-2-7b에서 KNOWAGENT는 33.47%로, 다른 기법(ReAct, Reflexion, NAT, FireAct 등)보다 우수하거나 비슷한 성능을 냈습니다.

- 특히, Llama-2-70b 대규모 모델에서는 Easy, Medium 난이도에서 각각 56.75%, 49.90%의 F1을 기록해 기존 방법을 능가했습니다.

- ALFWorld (집안 물체 조작)

- LLM 에이전트가 텍스트 기반 가상 환경에서 물건을 찾고, 옮기고, 조작하는 액션 시퀀스를 계획하는 작업입니다.

- Llama-2-13b 기준, “이전에 학습된 집안 환경(Seen)”과 “새로운 환경(Unseen)”을 각각 평가했는데, KNOWAGENT가 최대 58.71%(unseen)까지 성공률을 기록하며, GPT-4보다도 높은 결과를 달성했습니다.

- 오류율 감소

- HotpotQA 실험에서, ReAct나 Reflexion 같은 방법은 2~6% 정도의 잘못된 액션 수행(Planning Hallucination) 비율을 보였으나, KNOWAGENT는 이를 약 0.35~1.23% 수준으로 크게 낮췄습니다.

- 이는 액션 지식(AK)을 명시적으로 적용함으로써, 무의미하거나 논리에 어긋나는 시퀀스를 방지했다는 점을 입증합니다.

5. 의의 및 한계

- 의의

- 지식 기반 계획(Planning) 강화: 액션 지식을 명시적으로 사용함으로써 모델이 ‘가능한 행동 전이’를 더 정확히 인식하고, 계획 과정에서의 오류를 크게 줄였습니다.

- Self-Learning 구조: 모델 스스로 생성한 시퀀스 중 타당한 것을 선별해 다시 학습하는 구조이므로, GPT-4 등의 고성능 모델에 의존하지 않고도 고품질의 학습 데이터를 생성할 수 있음을 보였습니다.

- 범용 확장 가능성: 가정 내 물건 조작(ALFWorld)부터 멀티홉 QA(HotpotQA)까지 폭넓게 실험했으며, 향후 웹 브라우징, 로보틱스 등 다양한 도메인에 적용 가능성이 높다고 제시하였습니다.

- 한계

- 액션 지식베이스(Action KB) 설계 비용: 사람이 규칙과 액션을 설계해야 하므로, 초기 설정에 노력과 전문성이 필요합니다. GPT-4를 활용해 자동화 시도도 했지만, 아직까지는 “수작업 보정”을 통해 최적의 액션 룰을 구성해야 합니다.

- 장문 텍스트 처리 제한: 문제 자체가 복잡하거나 길이가 길어진 경우, LLM이 정확한 요약과 추론을 못해 최종 답이 틀리는 현상이 남아 있습니다.

- 멀티 에이전트 시나리오 부재: 현재 연구는 단일 에이전트에 초점을 맞추었으며, 여러 에이전트가 협력하는 상황으로는 확장하지 않았습니다.

6. 결론 및 향후 연구 방향

- 결론: KNOWAGENT는 “액션 지식”을 명시적으로 주입하여 언어 모델 기반 에이전트가 복잡한 계획(Planning) 작업에서 합리적인 액션 시퀀스를 생성하도록 돕는 효과적인 방안입니다. 실험 결과, 기존 방법 대비 높은 정확도와 낮은 오류율을 보였고, 자가학습 루프(Self-Learning)를 통해 GPT-4 등 고성능 모델에 의존하지 않고도 좋은 성능을 달성했습니다.

- 향후 방향:

- 액션 지식 자동화: 사람이 만드는 룰 대신, 더욱 정교한 모델을 통해 다양한 도메인 지식을 자동 생성·학습할 가능성이 있습니다.

- 장문 처리 및 복잡 추론: 모델의 긴 문서 이해, 요약 능력을 증진시키고, 멀티홉 추론의 정교화를 위해 추가적인 메커니즘이 필요합니다.

- 멀티 에이전트 협업: 여러 에이전트가 서로 다른 액션 지식을 바탕으로 협력하는 방식을 통해, 더욱 복잡한 태스크나 시나리오로 확장할 수 있을 것입니다.

요약

“KnowAgent”는 대형 언어 모델 기반 에이전트가 복잡한 액션 계획에서 발생하는 오류, 즉 “planning hallucination”을 줄이고자 고안된 프레임워크입니다. 명시적 액션 지식(Action KB)을 모델에 주입하여, 모델이 ‘가능한 액션 순서’를 제대로 인지하도록 하였고, Knowledgeable Self-Learning으로 올바른 계획 경로만 누적·학습함으로써 자체적인 성능 개선을 달성했습니다. 이를 통해 복합 질의응답(HotpotQA)과 가정 환경 시뮬레이션(ALFWorld)에서 경쟁력 있는 결과를 얻었으며, 액션 지식이 모델의 계획 능력을 구조적으로 향상시킨다는 사실을 실증했습니다.

연구자로서 이 접근법을 참고한다면, (1) 도메인별 적절한 액션 규칙을 어떻게 정의·설계할지, (2) 자가학습 루프를 효율적으로 어떻게 구성할지 등을 고민하여, 향후 다양한 AI 연구 및 응용을 확장할 수 있을 것입니다.

전체 개요

KnowAgent는 “액션(action) 기반의 지식베이스(knowledge base)”를 명시적으로 언어 모델(LLM)에 제시하여, 모델이 여러 단계를 거쳐 문제를 해결할 때 논리적으로 올바른 액션(행동) 시퀀스를 계획하도록 만드는 방법입니다.

이때,

- 액션 지식베이스(Action KB)를 정의하고,

- 이를 텍스트 형태(프롬프트)로 모델에 전달한 뒤,

- 여러 번의 자기학습(Self-Learning) 루프를 통해 점진적으로 고도화된 모델을 얻습니다.

1. 액션 지식베이스(Action Knowledge Base) 정의

1.1 액션 집합(Ea)

- 액션 집합(Ea): 모델이 실행할 수 있는 구체적 행동들의 목록입니다.

- 예: 멀티홉 QA에서

- Retrieve[entity]: 위키피디아에서 특정 엔티티를 가져온다

- Search[topic]: 검색 엔진(Bing 등)을 사용한다

- Lookup[keyword]: 마지막으로 가져온 문단 내에서 특정 키워드를 포함한 다음 문장을 탐색한다

- Finish[answer]: 최종 답변을 제출하고 종료한다

- 예: 멀티홉 QA에서

- 목적: LLM이 아무 텍스트나 무작정 생성하는 대신, 명시된 액션만 사용하게 하여 실행 가능한 행위만을 출력하도록 제약을 둡니다.

1.2 액션 전이 규칙(Rules)

- 전이 규칙: 액션 간 “합리적 순서”를 지정하여, 한 액션에서 다음 액션으로 어떻게 이동할 수 있는지 정의합니다.

- 예: Retrieve → Lookup은 합리적(우선 어떤 엔티티 페이지를 불러와야 그 안에서 Lookup을 할 수 있음)

- 반면 Lookup → Finish도 가능(중간에 더 찾아볼 필요 없이 답을 알게 되었을 수 있음)

- 하지만 Lookup → Retrieve 없이 바로 넘어가는 것은 무의미하거나, 혹은 Finish → Search는 불가능 등

- 구조적 표현: 종종 그래프나 트리 형태로 표현됩니다.

- 예:

- Start:(Search, Retrieve)

- Search:(Search, Retrieve, Lookup, Finish)

- Lookup:(Lookup, Search, Retrieve, Finish)

- Finish:() (더 이상 액션 없음)

- 예:

- 효과: 모델이 “예를 들어, 검색(Search) 없이 곧바로 Lookup을 한다” 같은 잘못된 순서를 시도할 확률을 현저히 줄여줍니다.

2. 액션 지식을 LLM에 제시하기 (Action Knowledge to Text)

- Prompt 형태로 전달

- 사람이 만든 액션 지식베이스(액션과 전이 규칙)를 텍스트로 풀어서, LLM에게 “이런 순서대로만 액션을 수행해야 한다”라고 알려줍니다.

- 예시(HotpotQA)

- The decision graph is constructed upon a set of principles known as "Action Knowledge", outlined as follows:

Start:(Search, Retrieve)

Retrieve:(Retrieve, Search, Lookup, Finish)

Search:(Search, Retrieve, Lookup, Finish)

Lookup:(Lookup, Search, Retrieve, Finish)

Finish:()

Here’s how to interpret the graph’s Action Knowledge:

From "Start", you can only "Search" or "Retrieve", ... ... (이후 각 액션 정의와 예시) ...

- 실행 시나리오 예시

- 실제로 모델에게 문제(“누가 첫 번째로 방송된 스폰지밥 에피소드인지?” 등)를 주며, “Start에서 출발해서 Finish로 갈 때까지” 각 단계 액션을 프롬프트에 기록하도록 지시합니다.

이 과정을 거치면, LLM은 답변을 생성할 때 “지정된 액션 + 규칙에 따른 시퀀스”를 준수하려고 시도합니다.

3. 계획 경로 생성(Planning Path Generation)

위에서 정의한 액션 지식을 토대로 계획 경로(Planning Path)를 만들어냅니다.

- 모델이 출력하는 형식

- ActionPath: 지금까지 어떤 액션들을 순차적으로 거쳐왔는지

- Thought: 현재 시점에서 모델이 생각하는 중간 추론(내부 사고)

- Action: 실제 실행할 액션(예: Search[topic], Finish[answer] 등)

- Observation: 액션 실행 후 얻은 결과(환경 피드백)

- 실제 예시(HotpotQA의 간단 버전)

- ActionPath: Start

- Thought(모델 내부 추론): “질문에 답변하려면 먼저 검색을 해야 할 것 같다.”

- Action: Search["에피소드 제목"]

- Observation: “검색 결과: ...”

- ActionPath: Start -> Search["에피소드 제목"]

- Thought: “검색 결과에 따르면 이 에피소드가 언제 방영되었는지 알 수 있다. 추가 조회가 필요하다.”

- Action: Lookup["air date"]

- Observation: “찾았다: 첫 번째 방송일은 ...”

- ActionPath: Start -> Search -> Lookup

- Thought: “정답을 알았다. 이제 Finish로 이동한다.”

- Action: Finish["에피소드 이름"]

- Observation: (정답 확인)

이처럼 규칙에 맞춰 Search -> Lookup -> Finish 순서로 진행된 경로가 최종적으로 생성됩니다.

4. Knowledgeable Self-Learning (자가학습 루프)

가장 핵심적인 단계로, 모델이 생성한 경로(trajectory) 중에서 정확하고 규칙에도 부합하는 것들만 선별하여(Filtering), 다음 학습에서 모델을 재훈련(Fine-Tuning)하는 과정을 반복합니다.

4.1 Trajectory Synthesis & Filtering

- 초기 모델(M0): 아직 액션 규칙을 잘 모르는 상태(또는 미세조정 전 기본 상태)

- Traj(M0, AK): M0에게 액션 지식을 프롬프트로 주고 문제를 풀게 하여 여러 경로(trajectory)를 생성

- Filtering:

- (1) 정답을 맞춘 경로만 남기고,

- (2) 액션 규칙을 어긴(예: Search 없이 Lookup을 먼저 쓴) 경로는 제거,

- (3) 같은 문제를 맞추더라도 더 짧은 경로(= 더 효율적인 액션 시퀀스)를 우선적으로 남김

- Fine-Tuning: 남은 양질의 데이터를 이용해 M0를 학습시켜 M1을 얻음

4.2 Iteration

- M1이 생성되었으면, 다시 같은 데이터(또는 추가 데이터)에 대해 재차 경로를 만들어냅니다. 그리고 같은 방식으로 Filtering & Fine-Tuning하여 M2를 얻습니다.

- 이를 성능 수렴 혹은 원하는 성능에 도달할 때까지 반복합니다.

- 반복이 진행될수록 모델은 “어떤 액션 시퀀스가 유효한지” 더 정확히 파악하게 되며, planning hallucination(잘못된 액션) 발생률이 줄어듭니다.

4.3 예시 (핵심 아이디어)

- Iteration 0:

- 모델이 “Lookup부터 시작”하는 잘못된 경로를 자주 생성

- 옳은 경로(정답) 비율이 낮음

- Iteration 1:

- 이전 단계에서 “올바른 시퀀스”만 남긴 데이터를 학습한 모델

- Lookup 시작 같은 오류가 크게 줄고, 정답율이 상승

- Iteration 2:

- 여전히 약간의 오답이나 비효율적 시퀀스는 남아있을 수 있으나, 더욱 견고하게 액션 지식 규칙을 지킴

- 최종적으로 더 높은 정확도를 달성

5. 예시로 보는 효과: Planning Hallucination 감소

- 기존 (ReAct 등) 방식

- “Search” 없이 바로 “Lookup” 시도 → 검색할 문서가 없어서 실패

- “Finish”를 너무 일찍 호출 → 질문에 대한 세부 정보를 얻지 못함

- KnowAgent 방식

- Start → Search → Lookup → Finish처럼 정해진 액션 전이를 지키도록 유도

- 잘못된 행동이 줄어들고, 최종 정답에 도달하는 빈도가 높아짐

특히 ALFWorld(가상 가정집 환경)에서는 “문을 열기(Open) 전에 반드시 그 장소로 이동(Goto)해야 한다”와 같은 제약을 명시해 두면,

- ReAct 같은 모델은 종종 Open(문)을 뜬금없이 호출해 실패하지만,

- KnowAgent는 “Goto(문) → Open(문) → Take(물건) …” 식으로 합리적인 액션 시퀀스를 따르게 됩니다.

6. 정리 및 시사점

- 명시적 액션 지식:

- LLM이 자율적으로 문제를 푸는 과정에서, 어떤 액션이 가능하고, 어떤 순서로 진행해야 하는지를 스스로 숙지하도록 돕습니다.

- 자기학습(Self-Learning) 루프:

- 모델이 스스로 만들어낸 문제 해결 과정을 다시 학습 데이터로 삼되, 잘못된 경로는 걸러내 점진적으로 성능을 높입니다.

- 실험적 성능:

- HotpotQA 및 ALFWorld 등에서 계획 오류(Planning Hallucination) 빈도를 크게 줄이고, 기존 방법 대비 F1, 성공률 등의 지표를 높였습니다.

- 적용 확장성:

- 복잡한 툴 사용, 웹 브라우징, 로보틱스 등 다양한 영역에서 액션 지식을 정의하고 KnowAgent와 유사한 프레임워크를 적용해볼 수 있습니다.

한눈에 보는 예시 요약

- [단계 1] 액션 지식 설계

- 예) Search → Retrieve → Lookup → Finish 식 규칙 정의

- [단계 2] 텍스트 변환

- 예) “Start 노드에서는 Search, Retrieve만 가능.

Retrieve 상태에서는 Search, Lookup, Finish 가능 …” 형태의 Prompt 제공

- 예) “Start 노드에서는 Search, Retrieve만 가능.

- [단계 3] 모델이 실제 경로 생성

- ActionPath: Start

- Thought: “지금 당장 문서를 찾아야겠다”

- Action: Search[키워드]

- Observation: “검색 결과 …”

- ActionPath: Start -> Search

- Thought: “문단 안에 원하는 키워드가 있는지 확인해보자”

- Action: Lookup[주요 키워드]

…

n) Action: Finish[정답]

- [단계 4] 학습 & 반복

- 옳은 경로만 모아서 Fine-Tuning → 성능 향상 → 다시 생성 → 다시 학습 → …

결론

KnowAgent의 방법론은 (1) 액션 지식 규칙을 활용하여 오류가 적은 경로를 생성하게 만들고, (2) 모델이 직접 만든 데이터 중 검증된(정확+규칙준수) 경로만 골라 재학습하는 반복 루프로 구성됩니다. 이를 통해 이전의 LLM 기반 에이전트가 흔히 겪던 계획 착오(Planning Hallucination)를 효과적으로 줄이고, 안정적인 문제 해결 성능을 달성할 수 있습니다.

앞으로 다양한 도메인(로봇공학, 의료, 웹 브라우징 등)에 이러한 원리를 적용한다면, “복잡한 순서의 행동이 필요한 작업”에서도 LLM이 더욱 신뢰도 높은 에이전트로 발전할 수 있을 것입니다.

1. 실험 결과 요약

- HotpotQA (복합 질의응답)

- F1 점수 기준으로, KNOWAGENT는 Llama 시리즈(7b, 13b, 70b) 모델에 적용했을 때 기존 기법(ReAct, Reflexion, FireAct, NAT 등)과 견주어 동등 또는 우수한 성능을 달성했습니다.

- 모델 규모가 커질수록 Easy·Medium 난이도에서 확실한 성능 향상을 보였으며, Hard 난이도에서도 planning 오류가 줄어드는 경향을 관찰했습니다.

- 중요 포인트: 단순 프롬프트 기반 접근법보다 Planning Hallucination(잘못된 액션 시퀀스) 발생이 현저히 줄어들었다는 점이 확인되었습니다.

- ALFWorld (가정 환경 시뮬레이션)

- 집 안 물체 조작, 열기/닫기, 옮기기 등 복수 단계 액션이 필요한 태스크에서도 KNOWAGENT가 성공률 지표에서 기존 접근법보다 더 높은 수치를 기록했습니다.

- 예를 들어, Llama-2-13b 모델 기준, ALFWorld의 unseen 환경에서 약 58% 수준의 성공률을 보이며, GPT-4의 성능을 일부 지표에서 상회했습니다.

- 특히, 명시적인 액션 규칙(예: 문을 열기 전에 꼭 그 장소로 이동한다)이 모델의 행동을 효과적으로 제한하여 에러율 감소 효과가 두드러졌습니다.

- Planning Hallucination 감소

- 액션 규칙 덕분에 “Search 없이 Lookup부터 진행” 등 잘못된 계획 시퀀스를 자동으로 거르거나 줄일 수 있었고,

- 그 결과, 잘못된 액션(Invalid Actions), 액션 순서 불일치(Misordered Actions) 비율이 다른 기법 대비 큰 폭으로 내려갔습니다.

2. 연구 결론

- 명시적 액션 지식(AK)의 중요성

- KNOWAGENT는 액션 지식베이스(Action KB)를 활용하여, LLM의 계획(Planning) 단계에서 허용 가능한 액션 전이를 명확히 제시함으로써 에이전트의 논리적 일관성을 높이는 데 성공했습니다.

- 이는 기존 LLM의 내재적 지식(파라미터 안에 배운 상식)만으로는 해결하기 어려운 “계획 오류(Planning Hallucination)” 문제를 실질적으로 완화한다는 점에서 의미가 큽니다.

- 자기학습(Self-Learning) 루프의 효용성

- 모델이 스스로 생성한 액션 경로(trajectory) 중, 올바른 시퀀스만 골라 다시 미세조정(Fine-tuning)에 반영하는 Knowledgeable Self-Learning 과정을 통해, 외부 초거대 모델(GPT-4 등)에 의존하지 않고도 효과적인 학습 데이터를 확보할 수 있음을 보였습니다.

- 반복 과정에서 점진적으로 성능이 향상되며, 학습 Iteration이 늘어날수록 불필요한(또는 규칙 위반) 액션이 줄어드는 경향을 확인했습니다.

- 범용 적용 가능성

- 본 연구는 멀티홉 QA(HotpotQA), 가상 환경(ALFWorld) 등 서로 다른 유형의 태스크에서 기법을 검증했습니다.

- 이를 통해, 액션 지식이 필요한 다양한 시나리오(웹 브라우징, 로보틱스, IoT, 의료 등)에 동일 원리를 적용할 수 있음을 시사합니다.

3. 마무리 및 향후 연구 방향

- KnowAgent의 의의

- 계획 기반 언어 에이전트가 보다 안정적이고 합리적인 액션을 수행하도록 만드는 효과적 방법론을 제시했습니다.

- 액션 지식 설계만으로도 LLM의 단순 프롬프트 기법 대비 높은 성능과 낮은 오류율을 확인함으로써, “LLM이 계획(Planning) 단계에서 얼마나 체계적 제약을 필요로 하는지”를 보여줬습니다.

- 한계와 개선점

- 액션 지식베이스 구축의 수작업 문제: 아직까지는 사람이 룰을 정의하거나 GPT-4 등의 도움을 받아도, 최종적으로는 전문가의 검수가 필요합니다.

- 장문 문서 요약/추론: 여러 문단에 걸친 복잡한 추론이 필요한 경우, 모델이 액션을 잘못 선택하거나 요약 실패를 일으키는 사례가 여전히 존재합니다.

- 멀티 에이전트 확장: 본 연구는 단일 에이전트에 집중했으나, 다수 에이전트가 협업·분업하는 환경으로의 확장은 앞으로의 과제가 될 수 있습니다.

- 추가 연구 가능성

- 자동 액션 지식 추출: 인간의 개입을 최소화하기 위해, 대규모 언어 모델이 직접 “액션 전이 규칙”을 학습·생성하는 기법에 대한 연구.

- 장기 추론 및 메모리 개선: 더 긴 컨텍스트를 다루거나, 시간 순으로 복잡하게 얽힌 작업(태스크)에 대한 액션 계획 능력을 향상시키는 방안.

- 다중 에이전트 협업: 여러 에이전트가 각자 다른 액션 지식베이스를 기반으로 상호작용하며 대규모 복합 문제를 해결하는 방향으로의 확장.

요약

- KNOWAGENT는 “액션 지식”을 LLM에 명시적으로 결합하여, 복잡하고 다단계의 액션 수행이 필요한 태스크(예: 멀티홉 QA, 가정 환경 시뮬레이션)에서 계획 오류를 효과적으로 줄이고 성능 지표(정답률, 성공률)를 높이는 데 성공했습니다.

- 여러 차례의 자가학습 루프를 통해 고품질 시퀀스만 누적·학습할 수 있었고, 작은 규모 LLM이라도 충분한 맥락 제약이 주어지면 상위 모델에 견줄 만한 성능을 낼 수 있음을 시사합니다.

- 결과적으로, KNOWAGENT는 “LLM의 내부 추론 과정과 액션 지식을 체계적으로 결합”하는 접근법의 가능성을 보여주었으며, 향후 로보틱스·웹 에이전트·자동화 시스템 등 다양한 영역에 확대 적용될 여지가 큽니다.

아래는 “KnowAgent: Knowledge-Augmented Planning for LLM-Based Agents” 논문이 제시한 연구가 얼마나 타당하며, 실험이 얼마나 엄밀하게 진행되었는지를 평가·분석한 내용입니다. 내용은 논문의 방법론, 실험 설계, 평가 지표 등을 종합적으로 검토한 결과입니다.

1. 연구 타당성(Validity) 평가

- 문제 설정의 적절성

- 문제 정의: 논문은 LLM 기반 에이전트가 복잡한 액션을 수행할 때 발생하는 planning hallucination 문제, 즉 “모델이 수행 불가능하거나 논리적으로 어긋나는 액션 시퀀스”를 생성하는 현상을 지적합니다.

- 연구 필요성: LLM이 가진 내재적 지식만으로는 제한적인 영역에서 여전히 비합리적 행동이 자주 일어나므로, 명시적 액션 지식을 통해 이를 보완하겠다는 목표가 합리적이며, AI 연구 커뮤니티에서 중요하게 다루는 현안입니다.

- 결론적으로, 연구 질문(액션 지식을 주입하여 계획 오류를 줄일 수 있는가?)이 명확하며, 자연어 QA나 가상 환경 작업 등 실제 응용 시나리오로 이어질 만한 주제를 다룹니다. 타당한 연구 문제 설정이라 볼 수 있습니다.

- 방법론적 근거 및 이론적 타당성

- 액션 지식(Action Knowledge)에 기반한 설계:

- 기존 LLM이 자유롭게 텍스트를 생성하는 대신, 유효 액션 집합(Ea)과 그 전이 규칙(R)을 명시적으로 주어 제약을 두는 것은, 전통적 계획(Planning) 연구에서 “상태 전이 모델”을 미리 정의하는 접근과 유사합니다.

- 이 아이디어는 계획 이론(planning theory)나 강화학습(RL)에서의 “합법적(action space) 제약”과 맥락을 같이 하므로 이론적으로 타당한 근거가 있습니다.

- Knowledgeable Self-Learning 루프:

- 모델이 직접 생성한 경로(trajectory) 중 올바른 것만을 다시 학습 데이터로 사용하여 “추가 미세조정(fine-tuning)”하는 것은, 일종의 self-consistency(스스로 생성·평가)를 강화하는 접근입니다.

- 이는 RLHF(인간 피드백 강화학습)나 반성(Reflexion) 기법 등과도 유사점을 갖습니다. 이 방식은 iterative refinement라는 학습 철학을 반영하며, 연구적 근거가 충분합니다.

- 액션 지식(Action Knowledge)에 기반한 설계:

- 실험 대상 선정의 타당성

- HotpotQA: 멀티홉 QA로서 실제로 검색(Search) → 조회(Retrieve) → 요약/추론(Lookup) → 최종 답변(Finish) 등 다양한 단계가 필요하므로, 액션 시퀀스의 타당성을 평가하기에 적절한 과제입니다.

- ALFWorld: 가정 환경 시뮬레이션으로, 실제 사물 조작 순서(“문을 열기 전에 그 위치로 이동해야 한다” 등)의 현실적 제약이 많습니다. 다양한 액션 조합이 필수적이므로, 계획 오류가 생기기 쉽고, KnowAgent의 효과가 두드러질 수 있습니다.

- 결론적으로, 두 테스트베드는 “추론 중심(HotpotQA)”과 “환경 중심(ALFWorld)”이라는 상이한 유형을 골랐다는 점에서 일반화 가능성을 높이려는 시도가 보입니다.

2. 실험의 엄밀성(Rigor) 평가

- 평가 지표 및 데이터 분할

- HotpotQA: F1 점수를 사용하며, easy/medium/hard로 난이도를 구분하여 세밀하게 측정한 점이 장점입니다. 이는 모델이 단일 액션으로 해결 가능한 쉬운 문제부터 복잡한 다중 액션이 필요한 어려운 문제까지 고루 살펴봄으로써, 결과를 보다 정교하게 해석할 수 있게 해줍니다.

- ALFWorld: goal-conditioned success rate(성공률)을 지표로 사용합니다. seen(학습에 등장했던)과 unseen(새로운) 두 범주로 나누어 평가해 일반화 성능을 측정한 점도 합리적입니다.

- 비교 기법(베이스라인) 선정

- ReAct, Reflexion, NAT, FireAct 등 다양한 방법(프로트 기반·미세조정 기반)을 비교 대상으로 삼았습니다.

- 이들은 이미 LLM 에이전트 연구에서 대표적 기법들로 알려져 있으며, 단일 에이전트 방식에서 자주 사용되는 방법들입니다.

- Prompt 전용 vs. Fine-tuning vs. Self-learning 등으로 범주가 나뉘어 있으므로, 경쟁 방법과의 성능 차이를 충분히 확인할 수 있습니다.

- 모델 규모·종류에 대한 폭넓은 실험

- Llama-2 (7b, 13b, 70b), Vicuna-7b, Mistral-7b, GPT-3.5, GPT-4 등 다양한 LLM 백본으로 확장 실험을 수행했습니다.

- 이를 통해, 단순히 특정 모델에만 국한된 성능 개선이 아니라, 여러 모델에서도 유의미한 향상을 보이는지를 검증했습니다.

- 특히 공개 모델(Llama-2, Vicuna, Mistral)에 대해서는 실제로 모델 파라미터를 사용하는 fine-tuning 실험을 수행해, 엄밀한 결과를 제시했습니다.

- 반복 학습(Iteration)에 따른 변화를 상세 분석

- “Iteration 0(초기 모델) → 1 → 2 → …” 등으로 성능이 얼마나 개선되는지 그래프 형태로 보여주어, Self-Learning 과정이 점진적 향상에 기여함을 논증하고 있습니다.

- 단순히 최종 결과치만 보여주는 것이 아니라, 각 단계에서의 성능 변화를 제시하여 알고리즘적 기여가 있음을 잘 드러냈습니다.

- 오류 사례 분석

- 논문 내에 “Misordered action”, “Invalid action” 등 구체적 지표와 예시(예: “Lookup부터 먼저 시작해 실패하는 경우”)를 제시했습니다.

- 이는 Qualitative 측면에서 모델이 실제로 어떤 부분에서 개선되었는지 확인할 수 있게 해주므로, 실험의 엄밀성·신뢰도를 높이는 요소입니다.

3. 한계 및 개선 가능성

논문이 자체적으로나 혹은 후속 연구 관점에서 언급 가능한 보완점은 아래와 같습니다.

- Action KB 설계의 수동성

- 액션 지식을 구축하는 과정에서 사람이 개입해 전이 규칙을 정해야 한다는 점이 남아 있습니다.

- GPT-4 등을 통해 일부분 자동화한다 해도, 여전히 최종 검수와 도메인별 전문성이 필요합니다.

- 이는 스케일 확장성에서 제약이 될 수 있으나, 본 연구가 이를 일정 부분 인정하고 후속 연구 가능성을 언급한 것은 타당합니다.

- 장문 추론에 대한 한계

- 여러 문서를 교차 참조하는 복잡한 시나리오에서, 액션 전이는 엄격하게 잘 지키더라도 “정보 요약 or 추론 능력”이 충분치 않으면 최종 답이 틀리는 상황이 등장합니다.

- 이는 “액션 지식을 잘 따르는 것”과 “언어 모델의 순수 추론·이해 능력”이 별개의 문제일 수 있음을 의미합니다.

- 다중 에이전트 환경 미적용

- 본 논문은 단일 에이전트에 초점을 맞춥니다. 여러 에이전트 간 협업이 필요한 복잡한 시나리오에서는 각 에이전트가 서로 다른 액션 지식을 보유할 수도 있어, 추가 연구가 필요합니다.

- 실제 애플리케이션과의 거리

- HotpotQA나 ALFWorld가 연구용으로는 훌륭하지만, 실제 산업적 애플리케이션과는 여전히 간극이 존재합니다.

- 웹 브라우저 자동화, 로보틱스, 혹은 특정 도메인(의료, 금융) 등에 대한 확장 적용 연구가 필요한데, 이것은 차후 과제로 언급되고 있습니다.

4. 최종 종합 분석

- 연구 타당성: LLM 에이전트의 계획 오류 문제, 특히 “논리적 액션 전이의 부재”라는 근본 원인을 짚고, “Action KB”와 “자가학습 루프”를 통해 개선하는 방법론은 문제 선정에서부터 접근까지 논리적으로 일관됩니다.

- 실험 엄밀성:

- 다양한 데이터셋(QA / 시뮬레이션),

- 여러 LLM 백본과

- 비교기법(Prompt-based/Fine-tuning) 및

- 정량·정성 평가가 모두 충실히 진행되어, 결과 재현성과 신뢰도가 높아 보입니다.

- 기여와 의의:

- 단순히 성능 수치만 올리는 것보다, 모델이 액션 지식을 활용해 합리적 시퀀스를 생성한다는 점에서 AI 플래닝·추론 영역에 좋은 레퍼런스가 됩니다.

- “계획(Planning)과 언어모델(LLM)”을 어떻게 결합할지 보여주는 하나의 틀(Framework)로 가치가 큽니다.

- 후속 연구 가능성:

- Action KB 자동화, 멀티 에이전트 협업, 극단적 장문/복합 시나리오로의 확장 등이 제시되어, 잠재적 발전 방향이 분명합니다.

결론적으로, KnowAgent 논문은 연구의 문제 설정, 방법론적 설계, 실험 검증 모두에서 충분히 엄밀하고 타당하게 작성되었다고 평가할 수 있습니다. 특히, “계획 오류”라는 명확한 과제를 해결하는 과정에서, 액션 지식 주입과 자기학습 루프가 효과적임을 실증적으로 입증했다는 점이 이 논문의 핵심 성과로 보입니다.

다만, Action KB 구성에 여전히 전문가 혹은 수동적 노력이 필요하다는 점이 확장성 측면에서 숙제로 남지만, 이는 대부분의 “지식 기반 AI” 연구가 필연적으로 안고 있는 한계입니다. 이를 포함해 다양한 개선 방향이 제시되므로, 본 논문은 추후 여러 형태의 AI 에이전트 연구에 참고될 만한 견고한 기초 연구라고 판단됩니다.