https://arxiv.org/abs/2311.05997

JARVIS-1: Open-World Multi-task Agents with Memory-Augmented Multimodal Language Models

Achieving human-like planning and control with multimodal observations in an open world is a key milestone for more functional generalist agents. Existing approaches can handle certain long-horizon tasks in an open world. However, they still struggle when

arxiv.org

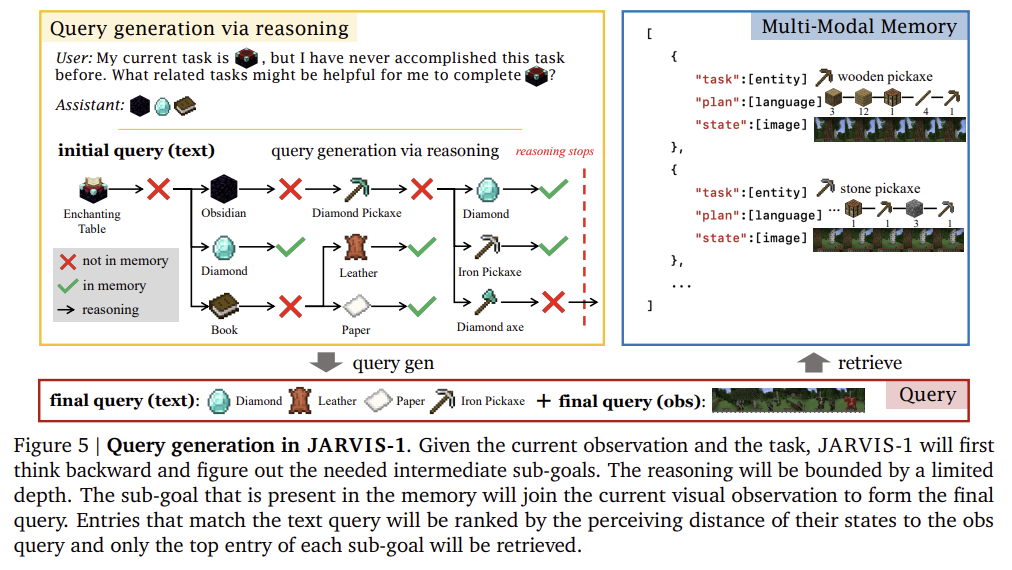

JARVIS-1은 멀티모달 언어 모델(MLM)과 멀티모달 메모리를 결합하여 개방형 환경에서 다중 작업을 수행하는 인공지능 에이전트입니다.

시각적 관찰과 언어적 명령을 통합하여 상황 적응형 플래닝을 수행하며, Self-check와 Self-explain 메커니즘으로 오류를 수정합니다.

공유된 멀티모달 메모리를 통해 경험 기반 학습과 작업 간 지식 전이를 실현하고, Self-instruct 방식으로 자기 개선 능력을 보여줍니다.

이를 통해 장기 작업에서도 기존 모델 대비 5배 높은 성능을 기록하며, 모델 업데이트 없이도 지속적으로 학습 성능을 향상시킵니다.

JARVIS-1은 개방형 환경에서의 자율 학습과 확장성을 강화한 차세대 AI 에이전트의 발전을 나타냅니다.

또 이 논문도 이 논문과의 차이점을 잘 이해해야 겠네요

Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge

https://arxiv.org/abs/2305.17144 Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based KnowledgeThe captivating realm of Minecraft has attracted substantial research interest in recent years

yoonschallenge.tistory.com

| 항목 | GITM | JARVIS-1 |

| 주요 목표 | Minecraft 기술 트리의 모든 아이템을 효율적으로 획득. | 다양한 작업 수행, 새로운 작업 생성(Self-instruct), 자기 개선(Self-improvement) 구현. |

| 사용된 기술 | - LLM 기반 계층적 목표 분해. - 텍스트 기반 지식(Minecraft Wiki) 활용. - 텍스트 메모리. |

- 멀티모달 통합(MineCLIP + LLM). - 멀티모달 메모리. - 분산 학습 기반 협력. |

| 플래닝 방식 | - 목표를 하위 목표로 분해. - 구조적 행동(Structured Actions)으로 변환. - 피드백으로 계획 수정. |

- 환경 변화를 실시간 반영한 상황 적응형 플래닝. - 과거 성공 경험을 메모리에서 검색하여 활용. |

| 학습 방법 | - 텍스트 기반 메모리에 성공 경험 기록. - 외부 지식을 활용해 학습 효율성 강화. |

- 분산 학습: 여러 에이전트가 메모리를 공유하며 경험을 축적. - 모델 자체는 업데이트하지 않음. |

| 효율성 | - 단일 CPU 노드(32코어)로 실행 가능. - RL보다 학습 효율성 10,000배 향상. |

- 메모리 검색 기반으로 효율적 실행. - 병렬 학습으로 작업 속도 향상. |

| 결과 | - 기술 트리의 모든 아이템(262개) 획득. - ObtainDiamond 작업 성공률 +47.5%. |

- 200여 개의 작업 성공적으로 수행. - 기존 모델 대비 장기 작업 성능 최대 5배 향상. |

| 한계 | - 텍스트 기반 지식에 의존하여 시각적 정보 부족. - 특정 환경(Minecraft)에 최적화됨. |

- 모델 학습 없이 메모리 기반 학습만 수행하여, 완전히 새로운 환경에서는 제한될 수 있음. |

| 장점 | - 높은 효율성과 실용성. - GPU 없이도 실행 가능한 경량화 모델. |

- 다양한 환경에서 적용 가능. - 자기 학습(Self-instruct)으로 확장성과 범용성 강화. |

| 의의 | - 특정 문제에서 RL의 한계를 극복. - 텍스트 기반 지식과 메모리를 활용한 고효율 학습 증명. |

- 다양한 작업 수행과 범용적 AI로의 진보. - 멀티모달 통합을 통해 시각적-언어적 협력 강화. |

| 연구 방향 | - 특정 작업 성공률 극대화. - 텍스트 기반 학습의 효율성 최적화. |

- 범용 AI 에이전트 설계. - 다양한 환경에서 적응 가능한 멀티모달 AI 발전. |

논문: JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models

1. 문제가 무엇인가?

- 목표: 개방형 환경(예: Minecraft)에서 다중 작업을 수행하고 점진적으로 개선하는 일반 인공지능 에이전트를 개발.

- 제약: 기존 에이전트는 다음과 같은 한계점을 가짐:

- 다중 감각 정보의 부족: LLM 기반 플래너는 텍스트뿐만 아니라 시각적 입력을 적절히 처리하지 못함.

- 장기 계획의 일관성 부족: 긴 작업을 효과적으로 수행할 수 있는 능력 부족.

- 자기 개선 능력 부족: 새로운 경험을 통해 학습하고 지속적으로 개선하는 능력의 부재.

2. 사용한 방법

- 시스템 아키텍처:

- 멀티모달 언어 모델(MLM): MineCLIP과 LLM을 결합하여 시각적/언어적 입력을 플래닝에 통합.

- 멀티모달 메모리: 에이전트가 환경에서 얻은 과거 성공 경험을 저장하고 재활용.

- 상황인지 계획: 현재 상태(위치, 시간, 자원 등)에 따라 계획을 조정.

- 인터랙티브 플래닝: 실행 중 실패 시 환경 피드백을 활용하여 계획을 실시간으로 조정.

- 학습 및 실행 과정:

- 에이전트는 자체적으로 새로운 작업을 생성(Self-Instruct)하며 학습.

- 멀티모달 메모리에서 과거 데이터를 검색하고 이를 참조하여 계획 생성.

- 계획이 실행되면 성공적인 경험을 메모리에 추가.

3. 결과

- Minecraft에서 200개 이상의 작업 수행:

- 단기 작업(예: 나무 자르기): 거의 완벽한 성공률.

- 장기 작업(예: 다이아몬드 곡괭이 제작): 기존 시스템보다 5배 높은 신뢰도.

- 자기 개선 실험: 시간이 지날수록 작업 성공률이 지속적으로 향상됨.

- 효율성:

- 기존 시스템(DEPS)보다 3배 높은 다이아몬드 관련 작업 성공률(8.99% vs. 2.42%).

- 재계획(re-planning) 평균 2-3회로 작업 수행.

4. 한계점

- 컨트롤러의 제한: 저수준 작업 수행 시 명령을 정확히 실행하지 못하는 경우 발생.

- 상황 설명의 복잡성: 시각적 데이터를 텍스트로 변환하는 단계에서 손실 가능성.

- 확장성 문제: 새로운 환경에서 동일한 성능을 보장하려면 추가적인 튜닝이 필요.

- 다이아몬드 작업에서 여전히 낮은 성공률(최대 12.5%)로 실험 조건의 제한성을 가짐.

5. 논문의 타당성

- 강점:

- LLM과 MLM의 조합은 텍스트와 비주얼 입력을 통합적으로 활용 가능.

- 멀티모달 메모리 도입으로 경험 기반 학습을 강화하여 일반화 능력 향상.

- Self-instruct 메커니즘을 통해 새로운 작업에 대한 자율적 학습 가능.

- 한계:

- 실험 범위가 Minecraft로 제한되어 있어 현실 세계나 더 복잡한 환경에서의 적용성 검증 필요.

- 멀티모달 메모리의 메모리 크기와 검색 속도가 시스템 성능에 미치는 영향을 추가로 분석해야 함.

6. 개선 아이디어

- AI Agent 연구 방향:

- 멀티모달 메모리를 기반으로 학습 가속화 전략 개발.

- 시각적 입력과 언어 입력 간의 관계를 강화하는 상호학습 모델 설계.

- 실제 세계 데이터를 기반으로 새로운 실험 환경에서의 일반화 능력 확장.

- 자기 개선을 통한 자동화된 실험 설계 및 실행으로 연구 생산성 향상.

이 요약과 한계점을 기반으로, 귀하의 AI 에이전트 연구에 적용할 세부적인 방향을 더 조율할 수 있습니다. 필요한 추가 정보나 논의할 세부 사항이 있다면 말씀해주세요!

이 논문과 연관된 논문을 정리해줘

JARVIS-1 논문과 연관된 주요 논문은 다음과 같습니다. 이 논문들은 인공지능 에이전트의 플래닝, 멀티모달 통합, 그리고 자기 개선 능력 등과 관련된 다양한 기법과 접근법을 다룹니다.

1. LLM 기반 플래닝

- ReAct: Yao et al. (2022) - 언어 모델을 통해 플래닝과 에이전트 상태 추론을 결합하여 작업 수행 성능을 개선.

- Inner Monologue: Huang et al. (2022b) - 에이전트가 플래닝 도중에 환경에서 얻은 피드백을 활용하여 더 정교한 플랜을 생성.

- SayCan: Brohan et al. (2022) - LLM과 스킬 실행 가능성 모델을 결합하여 실현 가능한 플랜을 생성.

- 이 연구들은 LLM 기반 플래닝을 통해 인간의 고수준 명령을 작업 가능한 플랜으로 변환하는 데 초점을 맞춤.

2. Minecraft 에이전트

- MineCLIP: Fan et al. (2022) - 비디오와 텍스트 데이터의 정렬을 학습하여 Minecraft에서 유의미한 보상을 제공.

- VPT (Video Pretraining): Baker et al. (2022) - 비디오 데이터를 기반으로 정책을 학습하여 행동 예측 성능을 향상.

- Steve-1: Lifshitz et al. (2023) - MineCLIP과 VPT를 결합하여 단기 목표를 효과적으로 해결.

- 이 연구들은 특히 Minecraft라는 복잡한 환경에서의 작업 수행에 초점을 맞췄으며, JARVIS-1의 개발에 중요한 배경을 제공.

3. 멀티모달 메모리 및 자기 개선

- RAG (Retrieval-Augmented Generation): Lewis et al. (2020) - 외부 지식을 검색하여 LLM의 응답 품질을 향상.

- Ghost in the Minecraft: Zhu et al. (2023) - 텍스트 기반 지식과 메모리를 활용하여 더 높은 추론 효율성을 갖춘 Minecraft 에이전트 설계.

- ProAgent: Zhang et al. (2023) - LLM을 사용하여 자율적으로 협력적인 작업을 수행할 수 있는 에이전트를 구축.

- 이 연구들은 JARVIS-1이 멀티모달 메모리를 통해 과거 경험을 활용하고 자기 개선을 가능하게 하는 데 중요한 역할을 함.

4. 멀티모달 학습

- Flamingo: Alayrac et al. (2022) - 멀티모달 입력을 통합하여 몇 가지 샘플만으로 학습할 수 있는 모델 개발.

- MMICL: Zhao et al. (2023) - 멀티모달 데이터를 기반으로 컨텍스트 학습을 강화하여 복잡한 환경에서의 작업 수행 능력 향상.

JARVIS-1과의 관계

이 논문들은 모두 JARVIS-1의 설계와 개발에 있어 중요한 개념적 기반을 제공합니다. 특히, 멀티모달 데이터를 통합하여 작업을 수행하는 능력, 과거 데이터를 활용한 메모리 기반 학습, 그리고 자기 주도적 탐구 및 학습 메커니즘 등이 핵심입니다.

이 중 어떤 논문에 더 깊이 집중해야 할지 결정하려면 구체적인 연구 방향과 목표에 따라 우선순위를 정할 필요가 있습니다. 추가로 필요한 분석이나 방향 설정이 있다면 말씀해주세요!

그럼 이러한 연관된 논문들에서 이 논문이 발전시킨 것을 설명 및 정리해줘

JARVIS-1 논문이 연관된 기존 연구들에 비해 발전시킨 주요 기여를 체계적으로 정리하면 다음과 같습니다:

1. 멀티모달 통합 능력 강화

- 기존 연구:

- MineCLIP (Fan et al., 2022): 텍스트와 비디오 정렬로 보상 신호를 학습하지만, 고수준 플래닝 능력은 부족.

- Flamingo (Alayrac et al., 2022): 멀티모달 데이터를 기반으로 몇 가지 샘플로 학습 가능하지만 복잡한 플래닝에는 한계.

- JARVIS-1의 발전:

- 멀티모달 언어 모델(MLM)을 사용하여 시각적 관찰과 언어적 명령을 통합.

- 시각적 입력과 언어적 피드백을 결합하여 상황에 적응하는 계획을 생성.

- LLM과 MineCLIP을 결합하여 높은 수준의 이해와 실행 가능한 플랜을 생성하는 통합 모델 설계.

2. 장기 플래닝 성능의 비약적 향상

- 기존 연구:

- Inner Monologue (Huang et al., 2022b): 피드백을 활용한 인터랙티브 플래닝을 제공했지만, 장기 목표에서는 오류 누적 문제가 발생.

- ReAct (Yao et al., 2022): 에이전트 상태를 추론하여 작업 수행을 개선했으나 긴 작업에서는 비효율적.

- JARVIS-1의 발전:

- Self-check와 Self-explain 메커니즘을 도입하여 플래닝 오류를 실시간으로 수정.

- 멀티모달 메모리 기반의 재계획(re-planning)과 상황 적응성으로 긴 작업에서도 높은 성공률을 기록 (예: 다이아몬드 곡괭이 작업 성공률 기존 2.5% → JARVIS-1 12.5%).

3. 멀티모달 메모리와 자기 개선(Self-improvement)

- 기존 연구:

- RAG (Lewis et al., 2020): 검색 강화 생성으로 외부 지식을 활용하지만 지속적인 자기 개선 능력은 제한적.

- Ghost in the Minecraft (Zhu et al., 2023): 메모리와 지식을 활용했으나, 작업 간 지식 전이를 효과적으로 다루지 못함.

- JARVIS-1의 발전:

- 멀티모달 메모리를 통해 과거 경험을 저장하고 적응적으로 검색.

- Self-instruct 메커니즘으로 에이전트가 스스로 작업을 생성하고 학습.

- 동일한 메모리를 공유하는 다중 에이전트 설정을 통해 분산 학습(distributed learning)과 효율적 경험 축적 가능.

4. 자율 학습을 통한 확장성

- 기존 연구:

- VPT (Baker et al., 2022): 비디오에서 행동 정책을 학습했지만, 환경에 대한 자율 학습 능력 부족.

- Steve-1 (Lifshitz et al., 2023): 짧은 작업 수행에는 효과적이지만 장기 작업이나 자율 학습에는 한계.

- JARVIS-1의 발전:

- 게임 내 기술 트리(Tech Tree)를 탐색하며 새로운 작업을 제안 및 학습.

- 자율 학습을 통해 시간이 지날수록 성능이 향상되는 Life-long Learning 구현.

5. 효율적인 자원 활용

- 기존 연구:

- DEPS (Wang et al., 2023b): 재계획을 통해 플래닝 정확성을 높였지만 LLM의 토큰 사용량이 많고 비효율적.

- JARVIS-1의 발전:

- 평균 2-3번의 재계획으로 작업 수행 가능(기존 DEPS는 6회 이상 필요).

- 멀티모달 메모리와 RAG를 활용해 플래닝 정확도를 높이는 동시에 토큰 사용량과 처리 시간 감소.

요약: JARVIS-1의 주요 차별점

- 멀티모달 입력 통합: 시각적, 언어적 데이터를 함께 처리하여 상황인지 및 플래닝 성능 강화.

- 메모리 중심 학습: 과거 데이터를 기반으로 계획과 성능을 지속적으로 향상.

- 장기 작업 처리: 기존 한계를 넘어 더 긴 작업에서도 높은 성공률 기록.

- 자율 학습 메커니즘: 스스로 작업을 생성하고 분산 학습을 통해 효율적으로 학습.

JARVIS-1은 기존 연구들의 한계를 극복하며 개방형 환경에서의 다중 작업 수행 및 학습 능력을 크게 향상시켰습니다. 이 모델을 기반으로 더 복잡한 에이전트 시스템 설계를 위한 구체적인 방향이 필요하다면 추가 논의 가능합니다!

방법론에 대해 예시를 통해 좀 더 자세하게 설명해줘

JARVIS-1의 방법론 상세 설명 (예시 포함)

JARVIS-1의 핵심은 멀티모달 언어 모델(MLM)과 멀티모달 메모리를 결합하여 개방형 환경에서 다양한 작업을 수행하고 자기 개선(Self-improvement)을 실현하는 데 있습니다. 아래에서는 방법론의 주요 구성 요소와 각 요소가 어떻게 작동하는지를 예시를 통해 설명합니다.

1. 멀티모달 언어 모델(MLM) 기반 상황인지 플래닝

- 작동 방식:

- MLM은 시각적 관찰(예: 화면에 보이는 환경)과 언어적 지시(예: "다이아몬드 곡괭이를 만들어라")를 통합하여 플랜을 생성.

- 시각적 입력은 텍스트로 변환하여 "지형"이나 "자원 상태"와 같은 상황 정보를 포함.

- 플래닝 도중, 관찰된 환경과 현재 작업을 기반으로 실행 가능한 다음 단계의 계획을 생성.

- 예시:

- 작업: "다이아몬드 곡괭이를 제작하라."

- 초기 상태:

- 관찰: "현재 위치는 평원. 근처에 나무와 양이 있음."

- 인벤토리: 빈 상태.

- 계획 생성:

- 나무를 베어 목재를 수집.

- 작업대를 제작.

- 석재 곡괭이를 만들기 위해 돌을 채집.

- 철광석을 채굴하고 제련.

- 다이아몬드를 채굴하고 곡괭이를 제작.

- 상황 변화 대응:

- 도중에 도구가 부러지면, 인벤토리를 확인해 "나무 부족"을 인지하고 목재를 추가로 채집.

2. 자기 검증(Self-check)과 피드백 활용(Self-explain)

- 작동 방식:

- 플랜 실행 전 Self-check로 예상 결과를 시뮬레이션하여 오류 탐지.

- 실행 중 오류 발생 시, 환경 피드백을 분석하여 Self-explain 메커니즘으로 수정된 플랜 생성.

- 예시:

- 작업: "석재 곡괭이를 제작하라."

- 초기 계획:

- 나무를 채집 → 목재를 제작 → 작업대 제작.

- 작업대를 이용해 석재 곡괭이를 제작.

- Self-check:

- 시뮬레이션 결과: "나무가 부족하여 작업대 제작 불가" 오류 탐지.

- 해결책: 목재를 추가로 채집하도록 플랜 수정.

- 실행 중:

- 도구 사용 중 부러짐 → 환경 피드백으로 현재 상태를 분석.

- 수정된 플랜: "추가로 나무를 채집하고 새 도구 제작."

3. 멀티모달 메모리를 활용한 경험 기반 학습

- 작동 방식:

- 과거 성공 경험(작업과 관찰)을 저장하고, 새로운 작업 시 유사한 경험을 검색하여 플래닝에 참조.

- 검색된 경험은 LLM의 입력 프롬프트로 사용되어 플래닝 성능 강화.

- 예시:

- 새로운 작업: "다이아몬드 곡괭이를 만들어라."

- 멀티모달 메모리에서 검색:

- 유사 작업: "철 곡괭이 제작"과 관련된 경험 검색.

- 검색된 경험:

- "석재 곡괭이 제작 → 철광석 채굴 → 제련 → 철 곡괭이 제작."

- 검색된 플랜을 기반으로 새로운 플랜 생성:

- 검색된 경험에 다이아몬드 채굴 단계를 추가하여 최종 플랜 완성.

4. 자율 학습(Self-instruct)

- 작동 방식:

- 에이전트가 스스로 작업을 생성하고 환경을 탐구하며 학습.

- 작업 생성 시, 기술 트리(Tech Tree)를 따라 더 복잡한 작업으로 확장.

- 예시:

- 초기 작업: "목재 채집."

- Self-instruct:

- 작업대 제작.

- 석재 곡괭이 제작.

- 철 곡괭이 제작.

- 다이아몬드 곡괭이 제작.

- 각 단계에서 성공 경험을 메모리에 저장하여 다음 작업에 참조.

5. 분산 학습(Distributed Learning)

- 작동 방식:

- 여러 JARVIS-1 에이전트가 동일한 메모리를 공유하며 다양한 환경에서 동시에 학습.

- 수집된 경험은 중앙 메모리에 저장되어 다른 에이전트의 플래닝 성능 강화.

- 예시:

- 에이전트 A: "다이아몬드 곡괭이 제작" 작업 중 환경 A에서 학습.

- 에이전트 B: 동일 작업을 환경 B에서 수행하며 A의 경험 참조.

- 공유 메모리를 통해 학습된 작업 성능이 점진적으로 향상.

요약: 방법론의 핵심

- 상황인지 플래닝: 멀티모달 입력을 기반으로 상황 적응형 플랜 생성.

- Self-check & Self-explain: 오류를 사전에 탐지하거나 실행 중 수정.

- 멀티모달 메모리: 경험 기반 플래닝으로 성능 향상.

- Self-instruct: 자율 작업 생성 및 학습으로 지속적 개선.

- 분산 학습: 다중 에이전트 협업으로 효율적 학습 실현.

이 접근 방식은 단순 플래닝을 넘어 자기 개선과 자율 학습을 강화하여 개방형 환경에서의 성능을 크게 향상시킵니다. 이 방식을 다른 AI Agent 연구에 통합할 수 있습니다!

여기서 사용한 자기 학습도 결국 메모리에 새로운 정보를 추가하는 것이지?

모델을 추가적으로 학습하는 것은 아니고??

맞습니다. JARVIS-1의 자기 학습(Self-learning)은 모델 자체를 추가적으로 학습(fine-tuning)하는 방식이 아니라, 멀티모달 메모리에 새로운 정보를 추가하여 이를 활용하는 접근 방식입니다. 이를 구체적으로 설명하자면:

1. 모델 추가 학습이 아닌 메모리 기반 학습

- JARVIS-1은 이미 사전 학습된 멀티모달 언어 모델(MLM)을 사용하며, 추가적인 파라미터 업데이트나 fine-tuning을 수행하지 않습니다.

- 대신, 새로운 환경에서 얻은 성공적인 작업 경험을 멀티모달 메모리에 저장하여 활용.

- 저장된 메모리를 검색(retrieval)하여 플래닝을 보완하거나 새로운 작업에서 참조점으로 사용.

2. 메모리 학습의 과정

- 경험 축적:

- 작업 성공 시, 작업의 조건(예: 관찰된 환경, 인벤토리 상태)과 실행한 플랜(성공적인 작업 흐름)을 저장.

- 메모리 검색:

- 새로운 작업을 수행할 때, 현재 상황(환경, 작업 요구 조건)과 유사한 메모리 항목을 검색.

- 검색된 경험은 LLM의 입력 프롬프트로 제공되어 플래닝 정확도를 높임.

- 효과:

- 모델 자체는 고정되어 있지만, 메모리에 저장된 데이터가 증가하면서 작업 수행 성능이 지속적으로 향상.

3. 자기 학습(Self-learning)의 본질

- 모델의 고정성:

- 모델 파라미터를 업데이트하지 않기 때문에 연산 비용이 줄고, 기존 성능이 저하되지 않음(예: catastrophic forgetting 문제 회피).

- 메모리 중심 학습:

- 새로운 작업을 수행할 때, 과거의 학습 경험을 참조하여 점진적으로 학습 성능을 강화.

- 자기 지도 학습(Self-instruct):

- 모델이 스스로 새로운 작업을 생성하고 수행하며 메모리에 추가적으로 데이터를 쌓아 학습을 가속화.

4. 모델 추가 학습(fine-tuning)과의 차이점

| 항목 | JARVIS-1(Self-learning) | 모델 추가 학습(Fine-tuning) |

| 학습 방식 | 메모리 저장 및 검색 | 모델 파라미터 업데이트 |

| 학습 비용 | 낮음 (메모리 업데이트만 수행) | 높음 (파라미터 최적화 연산 필요) |

| 기존 성능 유지 | 유지 가능 (모델 고정) | 위험 (catastrophic forgetting 가능성) |

| 새로운 작업 적응력 | 유사 작업에서 참조를 통해 적응 | 새로운 데이터 기반으로 재학습 필요 |

결론

JARVIS-1의 자기 학습은 멀티모달 메모리를 중심으로 한 학습 방식으로, 모델 자체를 추가 학습하지 않고도 점진적으로 성능을 향상시키는 효율적인 접근법입니다. 이는 연산 비용을 절약하면서도 다양한 작업을 처리할 수 있는 확장 가능한 구조를 제공합니다.

만약 연구 방향에서 모델 자체를 업데이트하지 않으면서 새로운 정보를 학습해야 한다면, JARVIS-1의 메모리 중심 접근이 적합할 것입니다. 반대로, 특정 작업 성능을 크게 향상시키고자 한다면 fine-tuning을 고려할 수도 있습니다.

그럼 분산학습도 결국 메모리에 있는 비슷한 경험을 통해 다른 작업에서도 좋은 결과로 이어진다는 것이네?

네, 정확합니다. JARVIS-1의 분산 학습(Distributed Learning)도 본질적으로 공유된 멀티모달 메모리를 활용하여 에이전트가 서로 다른 환경에서 얻은 경험을 공유하고, 이를 통해 다른 작업에서도 더 나은 결과를 도출하는 방식입니다. 이를 구체적으로 설명하면 다음과 같습니다:

1. 분산 학습의 구조

- 여러 에이전트가 동시에 다양한 환경에서 학습을 수행.

- 각각의 에이전트는 작업 수행 중 성공적인 경험(플랜, 관찰된 상태)을 공유된 멀티모달 메모리에 저장.

- 다른 에이전트는 새로운 작업 수행 시, 이 공유된 메모리에서 관련 경험을 검색하여 플래닝에 활용.

2. 메모리를 활용한 학습 확장

- 새로운 작업의 학습 가속화:

- A 에이전트가 특정 작업에서 성공적으로 학습한 경험은 B 에이전트가 유사한 작업을 수행할 때 참조로 사용.

- 예를 들어, A가 "석재 곡괭이 제작"에서 얻은 경험을 B가 "철 곡괭이 제작" 시 활용.

- 작업 간 지식 전이(Transfer Learning):

- 한 작업에서 축적된 경험이 다른 작업에서도 도움을 줌.

- 예: "다이아몬드 곡괭이 제작" 작업 수행 중 "석재 곡괭이 제작" 경험을 재사용.

3. 구체적인 예시

- 작업: 다이아몬드 곡괭이 제작

- A 에이전트는 작업 초기 단계에서 "나무 채집 및 작업대 제작"을 수행하고, 이를 메모리에 저장.

- B 에이전트는 "다이아몬드 곡괭이 제작"을 시도하며 메모리에서 A의 경험을 검색:

- "작업대 제작 경험" 검색 및 활용.

- 이후 단계를 효율적으로 계획(목재 부족 시 추가 채집 등).

- 결과:

- B 에이전트는 초기 작업 단계를 반복 학습하지 않고도 작업 속도를 가속화하고 성공 확률을 높임.

4. 분산 학습의 장점

- 학습 가속화:

- 에이전트가 서로 다른 환경에서 얻은 경험을 공유하여, 학습 시간이 단축.

- 작업 간 시너지 효과:

- 작업 간 유사성을 활용하여 지식 전이가 자연스럽게 발생.

- 메모리 기반 확장성:

- 각 에이전트의 학습 결과가 메모리에 축적될수록, 시스템의 전체 성능이 향상.

- 리소스 최적화:

- 개별 에이전트가 동일한 작업을 반복 학습하지 않고 새로운 작업에 집중할 수 있음.

5. 새로운 작업에서의 효과

- 유사 작업 지원:

- 새로운 작업을 수행할 때, 기존 메모리에서 관련된 경험을 검색하여 초기 플래닝의 품질이 높아짐.

- 자기 개선(Self-improvement):

- 시간이 지날수록 메모리에 더 많은 성공적인 경험이 축적되어, 모든 에이전트가 지속적으로 더 나은 성능을 발휘.

결론

JARVIS-1의 분산 학습은 개별 에이전트가 얻은 경험을 공유된 메모리를 통해 통합하여, 새로운 작업이나 더 복잡한 작업에서도 높은 성능을 발휘하도록 돕습니다. 이는 모델 자체를 재학습하지 않고도 지식 전이를 실현하는 효율적인 방법입니다. 특히, 연구 방향에서 분산 에이전트 구조를 고려하고 있다면, JARVIS-1의 메모리 중심 분산 학습이 유용한 아이디어를 제공할 수 있습니다.

JARVIS-1 vs. Ghost in the Minecraft (GITM): 주요 차이점

두 논문 모두 개방형 환경에서 일반화된 에이전트를 개발하기 위한 연구로, Minecraft라는 플랫폼을 사용하지만 접근 방식, 기술적 초점, 및 결과에 있어 차별점을 보입니다.

1. 접근 방식

JARVIS-1

- 멀티모달 기반: 시각적 관찰(MineCLIP)과 언어적 지시(LLM)를 통합하여 작업을 수행.

- 멀티모달 메모리: 과거 성공 경험을 저장하고 검색하여 플래닝에 반영.

- Self-instruct: 작업 생성 및 자기 개선(Self-improvement)을 통해 새로운 작업에 적응.

GITM

- 텍스트 기반 지식 활용: Minecraft Wiki 등 텍스트 기반 지식을 활용하여 작업 수행.

- 계층적 목표 분해: 목표를 하위 목표(sub-goal)로 분해하고 이를 기반으로 행동을 계획.

- 텍스트 메모리: 텍스트로 기록된 작업 경험을 요약하고 플래닝에 사용.

2. 플래닝 및 실행 메커니즘

JARVIS-1

- 상황 적응형 플래닝: 실행 중 환경 상태를 실시간으로 업데이트하며 계획 수정.

- 멀티모달 메모리 검색: 과거 경험에서 검색된 플랜을 기반으로 새로운 작업 계획.

GITM

- LLM 기반 계층적 플래닝: 목표를 단계적으로 분해(LLM Decomposer)하고 각 하위 목표를 실행 가능한 구조적 행동(Structured Actions)으로 변환.

- 피드백 메커니즘: 실패한 행동에 대한 피드백을 기반으로 계획 수정.

3. 학습 방식

JARVIS-1

- 분산 학습: 여러 에이전트가 공유된 멀티모달 메모리를 통해 서로의 학습 경험을 활용.

- 모델 업데이트 없음: 모델 자체는 고정되고, 메모리를 통해 경험이 축적됨.

GITM

- 텍스트 메모리 기반 학습: 모든 성공적인 작업을 텍스트로 기록하고 이를 참조하여 플래닝 효율성 향상.

- 외부 지식 통합: 텍스트 기반 외부 지식을 통해 작업 효율성을 높임.

4. 목표 및 결과

JARVIS-1

- 목표: 다양한 작업 수행 및 새로운 작업 생성(Self-instruct).

- 결과: 장기 작업 성공률이 기존 모델 대비 최대 5배 향상.

- 범위: 200여 개의 작업을 수행하며, 특히 장기 작업에서 높은 성능을 보임.

GITM

- 목표: Minecraft 전체 기술 트리(Technology Tree)의 모든 아이템 획득.

- 결과: 기술 트리의 100% 항목을 성공적으로 잠금 해제, 기존 모델 대비 +47.5% 높은 다이아몬드 작업 성공률.

- 범위: 특정 작업(Diamond 작업)을 넘어 모든 아이템에 대한 일반화된 성능 제공.

5. 구현 효율성

JARVIS-1

- 연산 비용: 멀티모달 메모리 검색과 플래닝 중심으로 비교적 경량화.

- 분산 에이전트: 여러 에이전트가 병렬 학습하여 작업 수행 속도 향상.

GITM

- 연산 비용: GPU를 필요로 하지 않고 단일 CPU 노드(32코어)에서 실행 가능.

- 효율성: 기존 RL 기반 모델 대비 학습 샘플 효율성이 10,000배 이상 향상.

요약

| 항목 | JARVIS-1 | GITM |

| 데이터 소스 | 멀티모달(MineCLIP, LLM) | 텍스트 기반 지식(Minecraft Wiki 등) |

| 플래닝 방식 | 실시간 상황 적응형 플래닝 | 계층적 목표 분해 및 구조적 행동 생성 |

| 학습 방법 | 분산 학습 및 멀티모달 메모리 활용 | 텍스트 메모리 기반 경험 축적 |

| 결과 목표 | 새로운 작업 생성 및 장기 작업 성능 향상 | 기술 트리 완전 정복 및 작업 일반화 |

| 연산 효율성 | 메모리 검색 중심으로 비교적 저비용 | 단일 CPU 기반으로 매우 높은 샘플 효율성 |

JARVIS-1은 작업 수행에서의 적응성과 다양성에 중점을 두고, GITM은 기술 트리 전체 잠금 해제라는 특정 목표에 더 포커스하며 효율성을 극대화합니다. 연구 방향에 따라 이 두 접근 방식을 혼합하거나 특정 모델을 선택하여 적용할 수 있습니다.

나는 GITM이 좀 더 발전된 모델 같은데 왜 JARVIS-1이 더 늦게 나온 논문이야?

GITM이 기술적으로 더 발전된 모델처럼 보이지만, JARVIS-1이 더 늦게 발표된 이유는 두 논문의 목표, 초점, 그리고 발전 방향의 차이 때문입니다. 이를 자세히 분석해보면 다음과 같습니다:

1. 초점의 차이

GITM:

- 기술 트리 완전 정복: Minecraft의 모든 아이템을 잠금 해제하고 획득하는 것을 목표로 설정.

- LLM 활용 최적화:

- 텍스트 기반 지식을 활용하여 기존 RL의 한계를 극복.

- 효율성을 강조하여 GPU 없이 실행 가능하며, RL보다 10,000배 이상 효율적.

- 고도로 구조화된 행동 생성: LLM이 계층적으로 목표를 분해해 실행 가능한 행동으로 변환.

JARVIS-1:

- 다양성 및 확장성: 단순한 기술 트리 정복을 넘어 다양한 작업을 수행하고 새로운 작업을 생성(Self-instruct)하는 일반화된 AI 에이전트를 목표로 함.

- 멀티모달 통합:

- 시각적 관찰(MineCLIP)과 언어적 플래닝(LLM)을 결합하여 더 넓은 범위의 작업 수행.

- 멀티모달 메모리 도입으로 다양한 경험 저장 및 검색.

- 분산 학습: 여러 에이전트가 공유 메모리를 활용해 협력하며 학습.

⇒ JARVIS-1은 GITM보다 더 광범위한 응용 가능성과 일반화된 성능을 목표로 함.

2. 연구 방향의 차이

GITM:

- Minecraft라는 특정 환경 내에서 작업 성능 극대화에 초점.

- 계층적 목표 분해와 텍스트 기반 지식을 통한 효율성 증대가 주요 기여점.

- 제한된 GPU 리소스로도 높은 성능을 달성하며 실용적인 접근법을 제공.

JARVIS-1:

- 특정 환경에 국한되지 않고, 더 복잡한 작업과 환경에서 일반적으로 사용할 수 있는 에이전트 설계.

- 새로운 작업 생성(Self-instruct)과 자기 개선(Self-improvement)을 통해 스스로 발전하는 AI 모델 구현.

- 멀티모달 데이터를 통합하여 시각적/언어적 이해를 결합한 차세대 에이전트 방향 제시.

⇒ JARVIS-1은 GITM에서 다루지 않은 더 일반화된 AI 문제를 목표로 발전.

3. 기술적 우선순위

- GITM은 Minecraft라는 환경에 최적화되어, 단일 목표(기술 트리 완전 정복)를 달성하기 위한 구체적인 솔루션을 제공.

- JARVIS-1은 특정 목표를 넘어 더 광범위하고 다양한 환경에서의 응용을 염두에 둔 기술적 진화.

⇒ GITM은 특정 문제를 해결하기에 더 적합하지만, JARVIS-1은 AI의 일반화 가능성을 탐구하며 학계의 장기적 비전을 반영.

4. 발표 시점 차이의 이유

- GITM이 더 빠르게 나온 이유:

- 특정 문제(Minecraft 기술 트리 정복)에 초점, 비교적 명확한 목표로 빠른 모델 개발 가능.

- 텍스트 기반 지식 활용이라는 잘 정의된 방법론을 적용.

- JARVIS-1이 늦게 발표된 이유:

- 범용성과 확장성에 대한 초점을 맞추어 더 복잡한 시스템 설계 요구.

- 멀티모달 통합, 분산 학습, 자기 개선 등 여러 기술적 혁신을 통합하며 개발 시간이 더 필요.

결론

GITM은 Minecraft라는 특정 환경에서 최적화된 고효율 솔루션으로, 단기적이고 구체적인 성과를 강조합니다. 반면, JARVIS-1은 AI의 범용성과 장기적인 연구 방향을 목표로 한 더 광범위한 접근법을 제안하며, 이는 연구의 복잡성과 시간이 더 필요했기 때문입니다.

이러한 차이는 두 논문의 목적과 가치를 판단할 때 고려해야 할 중요한 요소입니다. 연구 방향에 따라 특정 모델을 선택하거나, 두 접근법을 결합한 새로운 시스템을 설계할 수도 있습니다.

그럼 대화내용을 총 정리해서 이 논문의 의의와 마무리를 정리해줘

JARVIS-1과 GITM의 비교 및 연구적 의의

1. 핵심 비교 요약

- GITM:

- 목표: Minecraft 기술 트리의 모든 아이템을 효율적으로 잠금 해제.

- 특징:

- LLM 기반 계층적 목표 분해: 목표를 하위 목표로 세분화해 효율적 플래닝 수행.

- 텍스트 기반 지식과 메모리: 외부 텍스트 지식(Minecraft Wiki 등)과 메모리를 활용하여 작업 성능 극대화.

- 효율성: RL보다 10,000배 빠르고, GPU 없이 단일 CPU로도 실행 가능.

- 의의: 특정 문제를 극복하는 데 초점을 맞춰 효율성을 극대화하며, 기술적으로 RL의 한계를 넘어선 접근법.

- JARVIS-1:

- 목표: 다양한 작업 수행 및 새로운 작업 생성(Self-instruct)과 자기 개선(Self-improvement)을 통해 범용적 에이전트를 구축.

- 특징:

- 멀티모달 통합: 시각적(MineCLIP) 및 언어적(LLM) 데이터를 통합하여 상황 적응형 플래닝 수행.

- 분산 학습: 여러 에이전트가 공유 메모리를 활용해 협력 학습.

- Self-instruct: 새로운 작업을 스스로 학습하고 확장 가능.

- 의의: 특정 환경에 국한되지 않고 다양한 응용과 범용성을 목표로 한 AI의 진보.

2. 두 모델의 의의

- GITM:

- 한계 문제의 해결:

- 기존 RL 기반 접근법의 높은 학습 비용과 낮은 확장성을 해결.

- 특정 작업의 높은 성공률(예: ObtainDiamond)로 Minecraft 연구에서 새로운 표준 제시.

- 실용적 접근법:

- 텍스트 기반 지식을 효과적으로 활용한 학습 효율성 증대.

- AI 시스템이 특정 문제를 빠르게 해결할 수 있는 실질적 가치를 증명.

- 한계 문제의 해결:

- JARVIS-1:

- AI의 범용성에 대한 도전:

- 단일 작업을 넘어 다양한 작업 수행과 자기 개선 능력을 통한 범용 AI로의 진화.

- 멀티모달 기술의 진보:

- 시각적 관찰과 언어적 플래닝을 결합한 차세대 멀티모달 AI 접근법 제시.

- 장기적 비전:

- AI 에이전트의 확장성과 응용 가능성을 높여 차세대 범용 AI 모델 개발에 기여.

- AI의 범용성에 대한 도전:

3. 연구적 의의

- GITM과 JARVIS-1의 상호 보완성:

- GITM은 특정 문제 해결에 특화된 효율적인 접근법을 보여줌으로써 실제 응용의 가능성을 증명.

- JARVIS-1은 더 광범위한 AI 응용을 목표로 하여 장기적으로 일반화된 AI 시스템 개발에 기여.

- 두 접근법은 목표와 범위에서 차이가 있지만, 이를 통합하면 효율성과 범용성을 동시에 갖춘 새로운 AI 시스템 설계 가능.

- AI 연구 방향성 제시:

- GITM은 작업 효율성과 실행 가능성을 강조하며 AI의 단기적 실용적 목표에 기여.

- JARVIS-1은 장기적 AI 비전, 특히 범용성과 자율 학습이라는 방향성을 제시.

4. 마무리

GITM과 JARVIS-1은 모두 Minecraft라는 복잡한 환경을 연구 플랫폼으로 사용하며, AI 에이전트의 발전을 위한 서로 다른 방향성을 보여줍니다. GITM은 특정 목표의 높은 성공률과 효율성을 입증한 반면, JARVIS-1은 범용성을 추구하며 AI 연구의 새로운 가능성을 제시합니다.

두 연구는 단순한 기술적 진보를 넘어 AI가 실세계 문제를 해결하고, 더 나아가 인간처럼 다양한 작업에 적응할 수 있는 범용 인공지능으로 발전하기 위한 중요한 발판입니다.

연구자는 두 모델의 장점을 통합하거나, 연구 목적에 따라 특정 모델을 선택하여 AI 에이전트를 설계할 수 있습니다. 이를 통해 개별적인 목표 수행뿐 아니라 장기적이고 일반화된 AI 발전을 추구할 수 있을 것입니다.