https://arxiv.org/abs/2308.10144

ExpeL: LLM Agents Are Experiential Learners

The recent surge in research interest in applying large language models (LLMs) to decision-making tasks has flourished by leveraging the extensive world knowledge embedded in LLMs. While there is a growing demand to tailor LLMs for custom decision-making t

arxiv.org

이 논문도 LLM이 새로운 정보에 대해 어떻게 저장하거나 사용할지에 대한 논문입니다.

문제: LLM을 특정 태스크에 맞게 Fine-tuning 없이 학습시키는 효율적 방법이 부족하며, 기존 방법은 파라미터 수정 비용이 크거나 학습 공유가 어렵다.

제안: ExpeL은 경험 학습 기반 에이전트로, 성공과 실패 데이터를 수집하고 통찰(insights)을 추출해 새로운 태스크에서 활용한다.

학습 과정: ExpeL은 (1) 데이터 수집, (2) 성공/실패 비교 및 공통 패턴 발견, (3) 통찰과 유사 사례를 기반으로 문제 해결을 수행한다.

결과: ExpeL은 HotpotQA, ALFWorld, WebShop 등에서 ReAct와 Reflexion 대비 성능을 향상시키며 전이 학습에서도 우수한 결과를 보였다.

차별점: 통찰 추출과 경험 검색을 통해 작업 간 학습 공유 및 일반화를 가능하게 하며, 반복 시도를 최소화한다.

장점: Fine-tuning 없이도 성능을 개선하고, 통찰을 자연어로 저장해 해석 가능성과 수정 용이성을 제공한다.

한계: 텍스트 기반 환경에 국한되며, 멀티모달 확장성과 매우 복잡한 태스크에 대한 추가 검증이 필요하다.

의의: ExpeL은 경험 학습과 데이터 재사용을 활용해 LLM 기반 AI 에이전트의 일반화와 지속 학습 가능성을 제시했다.

| 연구 목표 | - Fine-tuning 없이 LLM 에이전트가 경험 기반 학습을 통해 태스크 성능을 개선. - 성공/실패 경험을 분석해 통찰(insights)을 생성하고 이를 새로운 태스크에 활용. |

| 기존 방법 한계 | 1. Fine-tuning: 높은 계산 비용, 파라미터 수정 시 일반화 능력 저하. 2. In-context learning: 맥락 창 제한으로 학습 데이터 저장 및 재사용 불가능. |

| ExpeL의 제안 방식 | 1. 경험 수집: 태스크 수행 중 성공과 실패 데이터를 기록. 2. 통찰 추출: 성공/실패 데이터를 분석해 교훈과 패턴을 자연어로 생성. 3. 통찰 및 유사 사례 활용: 새 태스크에서 검색된 통찰과 사례로 의사결정 지원. |

| 구체적 메커니즘 | 1. ReAct: 사고(Reasoning)와 행동(Acting)을 결합한 계획 및 실행. 2. Reflexion: 실패 시 자기 반성(self-reflection)을 통해 다음 시도를 개선. 3. Faiss 검색: 유사 성공 사례를 검색하여 활용. |

| 학습 데이터 관리 | - 경험 풀(Experience Pool): 성공 및 실패 사례를 벡터로 저장. - 중요도 기반 관리: 통찰의 가중치를 업데이트하며, 덜 중요한 데이터는 제거. |

| 실험 및 결과 | 1. HotpotQA (추론 태스크): ReAct(28%) → ExpeL(39%). 2. ALFWorld (다단계 의사결정): ReAct(40%) → ExpeL(59%). 3. WebShop (쇼핑 태스크): ExpeL(38%). |

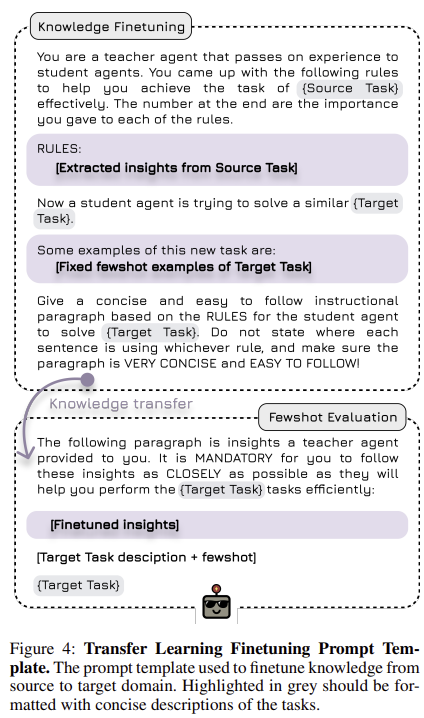

| 전이 학습 | - HotpotQA(소스 태스크) → FEVER(타겟 태스크): 기존 ReAct(63%) 대비 ExpeL(70%)로 성능 개선. - 소스 태스크에서 추출한 통찰을 새로운 태스크에 재활용 가능. |

| ExpeL의 장점 | - Fine-tuning 불필요: 파라미터 수정 없이 학습 비용 절감. - 작업 간 학습 공유: 태스크 간 통찰을 공유하여 일반화 가능성 증대. - 높은 해석 가능성: 통찰을 자연어로 저장해 수정 및 활용 용이. |

| ExpeL의 한계 | - 텍스트 중심: 이미지, 음성 등 멀티모달 입력 확장 필요. - 맥락 창 제한: 통찰 및 사례 데이터가 많아질 경우 RAG 방식 필요. - 복잡한 환경(대규모 데이터, 실시간 태스크)에서 추가 검증 필요. |

| ExpeL의 발전 방향 | 1. RAG 방식 도입: 중요도 기반 검색으로 통찰과 사례를 최적 활용. 2. 멀티모달 확장: 비텍스트 입력(이미지, 음성) 처리 능력 추가. 3. Lifelong Learning: 장기 기억 관리로 지속적 학습 지원. |

| 의의 | - ExpeL은 경험 학습과 데이터 재사용을 활용해 LLM 에이전트의 일반화와 지속 학습 가능성을 열어줌. - 다양한 태스크에서 효율적이고 비용 효율적인 AI 에이전트 구현 가능성을 제시. |

논문 요약 및 체계적 분석: ExpeL - LLM 에이전트의 경험적 학습

1. 문제 정의

이 논문은 대규모 언어 모델(LLM)을 활용하여 의사결정 문제를 해결하려는 시도를 다루고 있습니다. 기존 접근 방식은 주로 두 가지로 나뉩니다:

- 모델 파라미터를 업데이트하는 Fine-tuning 방식: 높은 비용과 일반화 능력의 감소가 단점.

- In-context Learning 방식: LLM의 맥락 창(window) 크기에 제한이 있어 경험을 저장하고 재사용하지 못함.

이에 따라, 논문은 LLM의 파라미터를 수정하지 않으면서 에이전트가 스스로 학습하고, 과거 경험을 활용해 성능을 개선할 수 있는 새로운 방법론, ExpeL을 제안합니다.

2. 사용된 방법

ExpeL은 아래의 세 가지 단계를 통해 학습합니다:

- 경험 수집: 에이전트는 환경에서의 상호작용을 통해 성공과 실패 사례를 수집합니다. 실패 시 자기 반성을 통해 개선 방안을 도출하고, 성공 및 실패 데이터를 함께 기록.

- 경험으로부터 학습:

- 실패 및 성공 사례를 비교하여 실패 원인을 분석.

- 여러 성공 사례에서 공통적인 패턴이나 "모범 사례"를 추출하여 일반화된 통찰(insights)을 생성.

- 추론 단계:

- 이전에 추출한 통찰과 유사한 과거 성공 사례를 활용하여 새로운 과제를 수행.

주요 구성 요소:

- ReAct 기반 계획 알고리즘: 관찰, 행동, 사고를 통합하여 의사결정.

- Reflexion 프레임워크: 실패 후 자기 반성을 통해 재시도 기회를 제공.

- Faiss 기반 검색: 과거 성공 사례 중 유사도를 기준으로 검색하여 맥락 내 학습에 활용.

3. 결과

- 다양한 환경에서 성능 향상:

- HotpotQA(지식-추론 기반), ALFWorld(다단계 의사결정), WebShop(온라인 쇼핑 태스크) 등에서 기존 모델 대비 더 높은 성공률을 기록.

- 전이 학습(Transfer Learning):

- HotpotQA 데이터에서 추출한 통찰을 FEVER 데이터(사실 검증)에 적용했을 때 성능이 향상됨.

- Emergent Behavior:

- 에이전트는 학습 후 새롭게 등장하는 행동 양상을 보여줌. 예: 잘못된 행동을 스스로 수정하거나 불필요한 행동을 줄이는 효율성 증가.

4. 한계점

- 텍스트 기반 관찰:

- 현재 작업은 텍스트 관찰에만 초점이 맞춰져 있으며, 실제 시나리오에서 필요한 멀티모달 입력(예: 이미지)을 다루지 않음.

- API 의존성:

- 닫힌 API 기반 모델(GPT-4 등)을 사용하여 공개된 모델 적용이 어려울 수 있음.

- 맥락 창 크기:

- 통찰 및 성공 사례가 증가하면 맥락 창 크기를 초과할 가능성이 있음.

- 이론적 기반 부족:

- 강화 학습(RL) 기반 방법론에 비해 이론적 근거가 부족하여 최적화 효율성이 낮을 수 있음.

5. 논문의 타당성과 아쉬운 점

- 타당성:

- 경험적 데이터를 기반으로 성능을 꾸준히 개선하며, 재시도를 최소화하는 점에서 실용적인 접근 방식.

- 전이 학습 실험을 통해 일반화 가능성을 입증.

- 통찰 생성 과정이 인간이 직접 설계하는 비용을 줄이고 자율성을 높임.

- 아쉬운 점:

- 실험의 범위가 제한적(텍스트 기반 및 특정 태스크).

- Reflexion과의 결합 없이 ExpeL만의 독립적 성능을 보다 심층적으로 평가했으면 좋았을 것.

- 전이 학습의 경우, 서로 다른 도메인 간의 일반화 사례가 부족함.

6. 추후 연구 방향

이 논문의 접근법은 AI 에이전트 연구에 아래와 같은 시사점을 제공합니다:

- 경험 기반 학습:

- 다중 태스크 간의 통찰을 효과적으로 저장하고 전이하는 방법론을 활용.

- 실패 데이터를 분석하여 강화 학습과의 결합 가능성 탐구.

- 멀티모달 확장:

- LLM에 이미지, 음성 등 비텍스트 입력을 통합하여 다양한 환경에 대응.

- 자율 AI 시스템 개발:

- ExpeL과 같은 경험 학습 모델을 기반으로 여러 에이전트가 협력하며 지속적으로 학습 및 개선하는 시스템 설계.

- Lifelong Learning:

- 장기적인 기억 관리 메커니즘을 개발하여 맥락 창 문제를 극복하고, "평생 학습" 가능 에이전트 구축.

위 내용을 참고하여 에이전트 연구를 구체화하는 데 도움을 줄 수 있습니다. 추가 분석이 필요하면 말씀해주세요!

논문의 타당성에 대해 좀 더 자세하게 검증해줘

논문의 타당성을 검증하기 위해 주요 측면을 체계적으로 분석하겠습니다. 이를 위해 실험 디자인, 결과 해석, 모델 평가, 그리고 실제 응용 가능성을 중심으로 평가합니다.

1. 실험 디자인의 타당성

(1) 실험 환경과 데이터셋

- 강점:

- HotpotQA, ALFWorld, WebShop과 같은 다양한 태스크를 사용하여 ExpeL의 적용 가능성을 폭넓게 평가했습니다.

- 지식 기반 추론(HopPotQA), 다단계 의사결정(ALFWorld), 특정 목표를 충족시키는 온라인 쇼핑(WebShop) 등 실제 활용 사례를 모델링한 환경은 현실적인 시나리오를 제공합니다.

- 전이 학습 실험(HotpotQA -> FEVER)을 통해 모델의 일반화 가능성을 탐구했습니다.

- 약점:

- 텍스트 기반 환경에 국한되어 있어, 이미지나 음성과 같은 다중모달 입력에 대한 확장성은 실험되지 않았습니다.

- 각 태스크에서 제한된 샘플 수를 사용해 데이터 다양성과 스케일 업 환경에서의 성능을 검증하지 못했습니다.

(2) 비교 대상(Baselines)의 적절성

- 강점:

- ReAct 및 Reflexion과 같은 강력한 모델을 비교 대상으로 설정하여 ExpeL의 상대적 우위를 증명.

- Fine-tuning 방식 대신 in-context learning 기반 모델을 사용해, 파라미터 업데이트 없이 학습하는 ExpeL의 강점을 부각.

- 약점:

- Baseline으로 설정한 ReAct와 Reflexion이 실제로 동일 조건에서 최적화되었는지 명확하지 않음(예: Reflexion은 반복 학습 기회가 있음).

- Fine-tuned LLM과의 성능 비교가 부재하여 ExpeL의 성능이 전통적 Fine-tuning 대비 얼마나 효율적인지 증명되지 않았음.

(3) 실험 설계의 다양성

- 강점:

- "경험 수집", "통찰 추출", "전이 학습"이라는 단계적 평가를 통해 ExpeL의 모든 구성 요소를 독립적으로 테스트.

- Ablation study(요소 제거 실험)를 통해 각 구성 요소의 기여도를 정량적으로 분석(예: 통찰 생성, 성공 사례 검색의 중요성).

- 다양한 모델 설정(GPT-4 vs. GPT-3.5)과 학습 전략을 비교하여 모델 설계의 견고성을 평가.

- 약점:

- Ablation study에서 비교 대상이 많지 않아 요소별 효과를 충분히 설명하지 못함.

- 전이 학습 실험이 한정된 태스크(HopPotQA -> FEVER)에만 적용되어 일반화 가능성을 보편적으로 평가했다고 보기 어렵습니다.

2. 결과 해석의 타당성

(1) 성능 향상 분석

- 강점:

- ExpeL이 다양한 태스크에서 정량적 성능 개선을 입증:

- HotpotQA: ReAct 28% → ExpeL 39%.

- ALFWorld: ReAct 40% → ExpeL 59%.

- 통찰(insight)과 경험 검색(retrieval)이 상호보완적이라는 점을 데이터로 확인함(예: HotpotQA는 통찰 중심, ALFWorld는 검색 중심 성능 향상).

- ExpeL이 다양한 태스크에서 정량적 성능 개선을 입증:

- 약점:

- WebShop에서의 성능이 다른 태스크에 비해 낮은 이유가 명확히 설명되지 않음(ExpeL 성공률 약 38%).

- 성능 개선이 특정 태스크에서만 극대화되었으며, 다른 태스크에서는 Reflexion 등의 기존 모델과 큰 차이를 보이지 않음.

(2) Emergent Behaviors 분석

- 강점:

- 자기 수정, 불필요한 행동 감소 등 ExpeL에서 자발적으로 등장한 행동(emergent behavior)을 질적으로 분석.

- 이러한 행동이 경험 학습을 통해 발생했음을 사례 기반으로 증명(Figures 및 Appendix에 구체적인 예시 제공).

- 약점:

- Emergent behavior에 대한 양적 측정(예: 등장 빈도, 성공률 기여도 등)이 부족하여 결과가 주관적으로 해석될 여지가 있음.

3. 모델 평가의 타당성

(1) 학습 과정의 효율성

- 강점:

- Fine-tuning 없이 경험 기반으로 학습하므로 데이터 라벨링이나 파라미터 업데이트 비용을 절감.

- Reflexion과 비교해 반복 학습 없이도 비슷한 성능을 달성.

- ReAct 대비 ExpeL이 성공률과 효율성을 모두 개선.

- 약점:

- Reflexion처럼 반복 학습을 허용하는 환경에서는 ExpeL이 비효율적일 가능성을 테스트하지 않음.

- ExpeL의 경험 학습 메커니즘이 대규모 환경에서 동일한 효율성을 보장할지는 검증되지 않음.

(2) 전이 학습의 효과

- 강점:

- HotpotQA에서 FEVER로 전이할 때, 단순히 few-shot 예시를 추가한 것만으로도 성능이 65% → 70%로 향상.

- 기존 전이 학습 방식보다 간단하며, 파라미터 업데이트가 필요 없는 점에서 실용적.

- 약점:

- HotpotQA와 FEVER는 모두 문서 검색 기반 태스크로, 전이 학습 결과가 제한적인 범위에서 유효할 가능성이 큼.

- 서로 다른 도메인 간(예: 언어-비전 간) 전이 성능에 대한 검증이 없음.

4. 실제 응용 가능성

(1) 장점

- LLM의 파라미터를 수정하지 않고도 새로운 태스크를 해결하는 방법론은 실제 응용 가능성을 높임.

- API 기반 폐쇄형 모델(GPT-4 등)을 사용할 수 있으므로 다양한 산업 현장에서 유용.

- 경험 및 통찰을 자연어로 표현하므로 해석 가능성(interpretability)과 수정 가능성(editability)이 높음.

(2) 단점

- 특정 도메인(예: 텍스트 기반 의사결정)에 최적화된 방법론으로, 일반적인 AI 에이전트 응용에는 추가 검증 필요.

- 멀티모달 입력, 장기 기억 관리 등 현실적 환경에서 필요한 기능은 현재로서는 부족.

종합 평가

타당성:

- 논문의 제안 모델은 설계와 결과 면에서 체계적이며, 기존 방법론의 단점을 잘 보완합니다. 특히 Fine-tuning 없이 학습 가능하다는 점과 전이 학습 실험에서 성능 향상을 보인 점은 실용적입니다.

아쉬운 점:

- 실험의 범위와 일반화 가능성에서 제한점이 존재합니다. 특히 텍스트 외 입력에 대한 확장성과 복잡한 태스크에서의 성능은 추가적인 검증이 필요합니다.

이 논문은 LLM 기반 AI 에이전트 연구에서 중요한 시사점을 제공하며, 특히 경험 학습과 전이 학습 메커니즘은 향후 연구에서도 유용할 것으로 보입니다.

Reflexion와 ReAct 방식, ExpeL방식을 비교 분석해줘

Reflexion, ReAct, ExpeL 방식 비교 분석

1. 기본 개념

| 모델 | 주요 특징 | 기본 메커니즘 |

| ReAct | 관찰(observations), 행동(actions), 사고(thoughts)을 결합하여 작업을 수행. | 순차적으로 계획과 실행을 병행하여 복잡한 태스크를 해결함. |

| Reflexion | 실패를 자기 반성(self-reflection)으로 분석하고, 해당 실패를 기반으로 다음 시도에서 개선. | 작업 실패 시, 실패 원인을 분석하고 수정 사항을 반영하여 다시 시도(task reattempt). |

| ExpeL | 과거 성공/실패 경험을 분석하여 통찰(insights)을 추출하고, 이를 유사 태스크에서 활용하여 학습 성능을 개선. | 경험 데이터를 축적하고, 추출된 통찰과 유사 사례를 기반으로 새로운 태스크를 처리. |

2. 학습 접근 방식

| 특징 | ReAct | Reflection | ExpeL |

| 학습 방식 | 순차적 실행과 계획(Planning + Acting). | 실패 후 반성 및 개선 기반 재시도(Self-reflect and Retry). | 과거 경험에서 통찰 추출 및 유사 사례 재사용(Experiential Learning + Insights). |

| 파라미터 수정 | 필요 없음. | 필요 없음. | 필요 없음. |

| 실패 처리 | 작업 중 실패하면 다음 태스크로 넘어감. | 실패 시 자기 반성을 통해 새로운 시도를 계획. | 실패/성공 사례를 데이터로 기록하고 분석하여 향후 태스크에 활용. |

| 지식 축적 | 없음. | 작업 간 데이터 공유 없음(각 태스크는 독립적). | 작업 간 데이터를 축적하여 통찰을 생성하고 새로운 태스크에 재사용. |

3. 실험 결과 비교

| 특징 | ReAct | Reflextion | ExpeL |

| 성공률(HotpotQA) | 약 28% | 40% (R3 단계) | 39% (단일 시도). |

| 성공률(ALFWorld) | 40% | 54% (R3 단계) | 59% (단일 시도). |

| 추론 및 학습 방식 | 태스크별 독립적인 계획 및 실행. | 실패를 통해 태스크 내 학습 반복. | 태스크 간 통찰을 공유하여 크로스태스크 학습. |

| 성능 향상 요소 | 단일 태스크에서만 계획 품질 개선. | 반복 학습으로 태스크 성능 향상. | 경험 분석을 통한 태스크 전반의 성능 향상. |

4. 장단점 비교

측면 ReAct Reflexion ExpeL

| 측면 | ReAct | Reflection | ExpeL |

| 장점 | - 간단한 구조와 순차적 학습. | - 실패를 반영한 학습으로 성공률 개선. - 반복 학습으로 특정 태스크에 강력함. |

- 태스크 간 통찰 공유로 일반화 가능성 높음. - 실패 데이터를 자산으로 활용하여 성능 극대화. |

| 단점 | - 실패를 처리하지 못함. - 작업 간 학습 공유 없음. |

- 태스크 반복 시나리오에서만 유효. - 태스크 간 통찰 공유 없음. |

- 초기 학습 시 데이터 수집 필요. - 멀티모달 환경 적용 미비. |

| 적용성 | 단순한 태스크에서 적합. | 특정 태스크를 반복 수행하며 학습 가능. 복잡한 태스크에서 효율적. |

다양한 태스크와 전이 학습에 적합.실제 환경(대규모 데이터, 태스크)에서도 확장 가능성. |

| 계산 자원 요구량 | 낮음. | 중간(실패 후 재시도 과정). | 중간(경험 수집 및 통찰 추출 과정). |

| 확장 가능성 | 낮음. | 낮음(태스크 간 데이터 축적 불가). | 높음(통찰 및 경험 재사용을 통한 확장 가능). |

5. ExpeL의 상대적 우위

- 효율적 데이터 활용: ExpeL은 실패와 성공 데이터를 모두 자산으로 사용하여 학습하기 때문에 데이터 효율성이 높음.

- 태스크 간 학습 공유: 태스크 간 공통된 통찰을 활용해 새로운 태스크에서도 성능을 개선할 수 있음(예: 전이 학습 실험).

- 단일 시도 성능: 반복 학습 없이 단일 시도로 높은 성능을 달성, Reflexion과 같은 반복 학습 기반 모델 대비 효율적.

요약 및 결론

- ReAct는 간단한 태스크에서 적합하지만 실패에 대응하지 못하고 작업 간 학습을 공유하지 못함.

- Reflexion은 실패를 반영하여 특정 태스크의 성능을 반복적으로 개선할 수 있으나, 작업 간 데이터를 축적하지 못하고 반복 실행 비용이 높음.

- ExpeL은 경험 기반 학습으로 태스크 간 데이터를 공유하며 성능을 향상시키고, 단일 시도로 높은 효율성을 보임. 특히, 전이 학습이나 다양한 환경에서의 적용 가능성이 높아 실용적.

ExpeL은 일반화된 AI 에이전트를 개발하는 데 적합하며, 특히 경험을 활용해 자율적으로 성능을 개선할 수 있는 시스템 설계에 강점이 있습니다.

ExpeL은 실험을 진행하며 성공과 실패 사례를 수집하고, 실패시 개선 방안을 도출하고, 데이터를 모두 기록해서 prompt 제일 앞에 넣어서 새로운 과제를 계속 수행하는거야?

네, ExpeL의 학습 과정은 당신이 말씀하신 것과 비슷하지만, 몇 가지 구체적인 메커니즘을 추가로 설명하겠습니다. ExpeL은 단순히 데이터를 기록하고 이를 프롬프트에 추가하는 것뿐만 아니라, 수집된 경험에서 유의미한 통찰(insights)을 추출하여 새로운 과제에 적용하는 데 중점을 둡니다. ExpeL의 프로세스를 단계별로 다시 살펴보겠습니다.

ExpeL의 핵심 학습 프로세스

- 경험 수집 (Experience Gathering):

- 에이전트는 환경에서 성공과 실패 사례를 수집합니다.

- 실패 시, Reflexion 방식을 사용하여 자기 반성(self-reflection)을 수행합니다.

- 실패 원인을 분석하고, 다음 시도에서 개선할 수 있는 아이디어를 생성합니다.

- 예를 들어, "이전에 시도한 특정 행동이 실패했으므로 다른 대안을 시도해야 한다"는 형태의 반성을 저장.

- 성공 및 실패의 모든 경험 데이터를 경험 풀(Experience Pool)에 기록.

- 경험으로부터 통찰 추출 (Learning from Experiences):

- ExpeL은 단순히 데이터를 추가적으로 기록하는 것이 아니라, 다음 두 가지 방식으로 경험을 처리합니다:

- 성공/실패 비교: 같은 과제에서 성공 사례와 실패 사례를 비교하여 "무엇이 잘못되었는가?"와 "무엇이 잘 작동했는가?"를 분석합니다.

- 예: "정확한 행동은 A인데, 실패한 경우에는 B를 선택했다."

- 성공 패턴 발견: 여러 성공 사례에서 공통적인 패턴(모범 사례)을 추출.

- 예: "이 유형의 문제를 해결할 때는 항상 단계 X를 먼저 수행해야 한다."

- 성공/실패 비교: 같은 과제에서 성공 사례와 실패 사례를 비교하여 "무엇이 잘못되었는가?"와 "무엇이 잘 작동했는가?"를 분석합니다.

- 추출된 통찰은 자연어로 정리되어 저장됩니다.

- 예: "고유한 아이템을 찾는 경우, 물건의 사용 맥락을 고려하라."

- ExpeL은 단순히 데이터를 추가적으로 기록하는 것이 아니라, 다음 두 가지 방식으로 경험을 처리합니다:

- 새로운 과제 해결 (Task Inference):

- 새로운 과제를 만날 때, ExpeL은 아래 두 가지를 활용합니다:

- 추출된 통찰: 과거에서 도출된 통찰(insights)을 프롬프트의 맨 앞에 추가합니다.

- 예: "이전에 학습한 성공 법칙"을 정리한 통찰 리스트.

- 유사한 성공 사례 검색: 경험 풀에서 현재 과제와 가장 유사한 성공 사례를 검색하여 프롬프트에 추가합니다.

- 유사도를 기반으로 검색(Faiss 벡터스토어 사용).

- 추출된 통찰: 과거에서 도출된 통찰(insights)을 프롬프트의 맨 앞에 추가합니다.

- 이렇게 구성된 프롬프트를 기반으로 새로운 태스크를 수행합니다.

- 새로운 과제를 만날 때, ExpeL은 아래 두 가지를 활용합니다:

- 반복적인 성능 향상:

- ExpeL은 성공 사례와 실패 사례를 축적하면서 점점 더 많은 통찰을 생성하고, 이를 통해 새로운 과제에서 점진적으로 성능을 개선합니다.

- 중요한 점은, 기존 데이터를 모두 프롬프트에 넣는 것이 아니라, 가장 유의미한 통찰과 유사 사례만을 선별적으로 사용한다는 것입니다.

- 이는 LLM의 맥락 창(context window) 제한을 고려한 효율적인 데이터 활용 방식입니다.

ExpeL 방식의 효율성

ExpeL이 단순히 데이터를 저장하고 모든 데이터를 프롬프트에 추가하는 방식과 다른 이유는 다음과 같습니다:

- 데이터 효율성:

- ExpeL은 경험 풀에서 가장 중요한 통찰과 사례를 추출하여 저장하고, 이를 통해 프롬프트의 길이를 제한적으로 유지.

- 불필요한 데이터를 제거하거나 중요성을 기반으로 가중치를 부여(예: 중요도가 낮은 통찰은 삭제).

- 학습 속도:

- 실패 시 데이터를 단순 기록하는 것이 아니라, 그 데이터를 분석하여 다음 시도에서 개선 가능한 형태로 반영.

- Reflexion처럼 태스크 내 반복 학습에 의존하지 않고도 성능 향상 가능.

- 일반화:

- 특정 태스크에서 추출된 통찰을 다른 유사한 태스크에서도 재사용 가능.

- 전이 학습(Transfer Learning) 실험을 통해 이를 입증.

요약

ExpeL은 단순히 성공/실패 데이터를 기록하고 이를 그대로 프롬프트에 넣는 것이 아니라:

- 성공/실패 데이터를 분석하여 통찰을 추출.

- 유사 사례를 검색하여 프롬프트에 선별적으로 추가.

- 새로운 과제 해결에 이러한 통찰과 사례를 활용하여 일반화와 성능 개선을 도모합니다.

이 방식은 단순 기록 방식보다 훨씬 효율적이며, 실제로 다양한 태스크에서 우수한 성능을 보이는 이유가 됩니다.

이 논문과 관련된 연구들을 논문을 기반으로 설명해줘

ExpeL과 관련된 연구: 세부 분석

ExpeL 논문에서는 관련된 연구 분야를 크게 네 가지로 분류하며, 각 연구의 핵심 기여와 ExpeL과의 연관성을 다루고 있습니다. 이를 기반으로 관련 연구를 체계적으로 설명하겠습니다.

1. Prompt 기반 학습

개요:

Prompting은 LLM의 파라미터를 수정하지 않고 입력 맥락(context)을 조정하여 모델의 태스크 성능을 개선하는 방법입니다.

- 대표 연구:

- GPT-3(Brown et al., 2020): Zero-shot 및 Few-shot 학습을 통해 파라미터 수정 없이 태스크를 해결.

- Chain-of-Thought(CoT; Wei et al., 2022): 추론 과정을 자연어로 나타내어 복잡한 문제 해결 능력을 향상.

- ExpeL과의 연관성:

- ExpeL은 Prompt 기반 학습의 맥락에서, 단순히 입력을 수정하는 것을 넘어 경험 데이터로부터 유의미한 통찰(insights)을 생성하여 프롬프트를 강화합니다.

- 자동으로 데이터를 수집하고, 통찰을 추출하는 과정을 통해 Prompt 설계 부담을 줄이고 학습 효율성을 높임.

2. Retrieval Augmented Generation (RAG)

개요:

RAG는 모델이 자체 메모리나 외부 데이터베이스에서 관련 정보를 검색하여 태스크 성능을 개선하는 접근법입니다.

- 대표 연구:

- RAG 모델(Lewis et al., 2020): 검색된 정보를 생성 과정에 통합해 정답 정확도를 향상.

- Generative Memory Systems (Rubin et al., 2022): 과거 데이터를 검색하여 새로운 입력 처리 시 활용.

- ExpeL과의 연관성:

- ExpeL은 경험 데이터를 검색해 태스크 수행에 필요한 성공 사례를 프롬프트에 추가합니다.

- 그러나 RAG가 주로 외부 데이터베이스를 활용하는 반면, ExpeL은 에이전트의 자체 생성 경험을 검색 대상으로 삼아 학습 비용을 줄이고 효율성을 높임.

3. LLM 기반 에이전트 연구

개요:

LLM을 에이전트의 "두뇌"로 활용하여 복잡한 태스크를 해결하는 연구가 최근 급증.

- 대표 연구:

- ReAct (Yao et al., 2023): 사고(Reasoning)와 행동(Acting)을 결합하여 복잡한 계획 문제 해결.

- Reflexion (Shinn et al., 2023): 실패 후 자기 반성(self-reflection)으로 학습을 개선.

- Voyager (Wang et al., 2023): Minecraft 환경에서 스스로 기술을 학습하며 에이전트 성능을 향상.

- ExpeL과의 연관성:

- ExpeL은 ReAct의 사고와 행동 결합 방식을 기반으로 하며, Reflexion처럼 실패 사례를 활용하지만, 작업 간 학습 데이터를 공유한다는 점에서 차별화됨.

- Voyager와 같이 스스로 학습한 기술을 재사용할 수 있지만, ExpeL은 특정 환경에 국한되지 않고 다양한 텍스트 태스크에 일반화 가능.

4. 자율 학습과 메모리 메커니즘

개요:

자율 학습 및 메모리 메커니즘은 에이전트가 학습 경험을 장기적으로 유지하고 활용할 수 있게 합니다.

- 대표 연구:

- Generative Agents (Park et al., 2023): 에이전트가 경험을 장기 메모리에 저장하고 필요시 검색해 활용.

- Prioritized Experience Replay (Schaul et al., 2015): 강화 학습에서 중요한 경험 데이터를 선별적으로 재사용.

- ExpeL과의 연관성:

- ExpeL은 성공/실패 데이터를 축적하고 중요성을 기반으로 통찰을 생성하며, 이를 검색해 재사용함.

- 강화 학습 기반 연구와 달리, ExpeL은 모델 파라미터를 업데이트하지 않고 통찰과 경험 검색을 활용한다는 점에서 차별화.

5. 전이 학습 (Transfer Learning)

개요:

전이 학습은 소스 태스크에서 학습한 지식을 타겟 태스크에 적용해 학습 비용을 줄이는 방법입니다.

- 대표 연구:

- Fine-tuning (Devlin et al., 2018): 사전 학습된 모델을 특정 태스크에 맞게 조정.

- Few-shot 및 Zero-shot 학습(Brown et al., 2020): 추가 학습 없이 기존 지식을 활용해 새로운 태스크 해결.

- ExpeL과의 연관성:

- ExpeL은 소스 태스크에서 추출한 통찰을 타겟 태스크에 "미세 조정"하여 새로운 태스크에 적용.

- Fine-tuning 없이 통찰과 유사 사례 검색만으로 전이 학습을 구현해 비용 효율성을 높임.

ExpeL의 관련 연구 요약

ExpeL은 Prompt 기반 학습, RAG, LLM 에이전트, 자율 학습, 전이 학습의 주요 개념을 통합하고 확장하여 다음과 같은 독창성을 제시합니다:

- 데이터 기반 통찰 생성: Prompt 설계나 외부 데이터 의존을 줄이고, 에이전트의 자체 경험을 활용.

- 작업 간 데이터 공유: Reflexion처럼 태스크 내 학습을 개선하는 데 그치지 않고, 태스크 간 학습 공유로 일반화 가능성 증대.

- 효율성: Fine-tuning 없이 통찰 및 경험 검색만으로 전이 학습을 구현, 비용과 자원 효율성 확보.

이 연구들은 ExpeL의 배경과 발전 가능성을 이해하는 데 중요한 참고 자료로 활용될 수 있습니다.

ExpeL을 예시와 함께 자세하게 논문을 기반으로 설명해줘

ExpeL: 예시와 함께 자세한 설명

ExpeL은 대규모 언어 모델(LLM)을 활용하여 경험적 학습을 수행하는 AI 에이전트입니다. 이 시스템은 성공과 실패 사례를 수집하고, 이를 분석해 통찰(insights)을 생성한 뒤, 유사한 태스크에 활용하여 성능을 지속적으로 개선합니다. 이를 단계적으로 살펴보고, 예시를 통해 구체적으로 설명하겠습니다.

1. ExpeL의 학습 과정

ExpeL은 크게 세 단계로 구성됩니다:

- 경험 수집 (Experience Gathering)

- 경험 분석 및 통찰 추출 (Insight Extraction)

- 태스크 수행 (Task Inference)

1.1 경험 수집 (Experience Gathering)

ExpeL은 환경에서 다양한 태스크를 수행하며 성공과 실패 사례를 수집합니다. 실패 시 Reflexion 방식을 활용해 실패 원인을 분석하고, 이를 다음 시도에 반영합니다.

예시:

태스크: ALFWorld에서 주어진 환경에서 "팬(pan)"을 찾는 작업.

- 첫 시도:

- 에이전트는 "팬"을 찾기 위해 서랍(drawer)과 찬장(cabinet)을 검색합니다.

- 실패 후 Reflexion을 통해 "팬은 주로 스토브(stove) 근처에 있을 가능성이 높다"는 교훈을 얻음.

- 다음 시도:

- Reflexion을 기반으로, "스토브 주변부터 검색"하도록 접근 방식을 변경.

- 팬을 성공적으로 찾음.

경험 기록:

- 실패와 성공 사례 모두 경험 풀(Experience Pool)에 저장됩니다.

- 실패: "서랍과 찬장을 먼저 검색했으나 실패."

- 성공: "스토브 주변을 먼저 검색해 팬을 찾음."

1.2 경험 분석 및 통찰 추출 (Insight Extraction)

ExpeL은 축적된 성공/실패 사례를 비교 분석하여 통찰(insights)을 생성합니다. 이 과정은 다음 두 가지로 나뉩니다:

- 실패/성공 비교: 같은 태스크에서 실패와 성공의 차이를 분석.

- 성공 패턴 발견: 여러 성공 사례에서 공통 패턴을 추출하여 일반화.

예시:

태스크: 다양한 물건을 찾는 문제에서의 경험 분석.

- 실패/성공 비교:

- 실패: 서랍과 찬장을 검색.

- 성공: "팬"을 스토브 근처에서 검색.

- 통찰 생성: "물건을 찾을 때, 그 물건의 일반적인 사용 위치를 고려해야 한다."

- 성공 패턴 발견:

- 여러 태스크에서 "사용 맥락을 고려한 검색"이 성공률을 높인다는 것을 확인.

- 통찰 생성: "일상 물건은 그 용도와 관련된 장소에서 먼저 찾아야 한다."

통찰은 자연어 형태로 저장되며, 이후 새로운 태스크에서 활용됩니다.

1.3 태스크 수행 (Task Inference)

ExpeL은 새롭게 주어진 태스크를 해결하기 위해 다음 정보를 프롬프트에 추가합니다:

- 통찰: 과거 태스크에서 생성된 교훈.

- 유사 성공 사례: 현재 태스크와 유사한 과거 성공 사례.

예시:

새 태스크: ALFWorld에서 "접시(plate)"를 찾는 문제.

- 프롬프트 구성:

- 통찰: "물건의 사용 맥락을 고려해야 한다."

- 유사 사례: "팬을 찾을 때 스토브 근처를 검색했음."

- 행동 결정:

- 접시가 일반적으로 식탁(table)이나 부엌 선반(kitchen shelf) 근처에 있을 가능성이 크다고 판단.

- 결과:

- 접시를 식탁 위에서 성공적으로 찾음.

2. ExpeL의 작동 원리

ExpeL은 다음 주요 구성 요소를 통해 작동합니다:

- 경험 풀 (Experience Pool):

- 모든 성공 및 실패 데이터를 저장하는 데이터베이스.

- 경험은 벡터 표현으로 저장되며, 유사도 기반 검색(Faiss 벡터스토어)을 통해 활용.

- 통찰 생성 모델 (LLMInsights):

- 성공/실패 사례를 분석하여 통찰을 생성.

- 통찰은 중요도에 따라 가중치를 부여받으며, 중요도가 낮으면 제거됨.

- 태스크 수행 모델 (LLMExpeL):

- 통찰과 유사 사례를 기반으로 프롬프트를 구성하여 새로운 태스크를 수행.

3. ExpeL의 전이 학습(Transfer Learning)

ExpeL은 소스 태스크에서 얻은 통찰을 타겟 태스크에서도 활용할 수 있습니다.

예시:

소스 태스크: HotpotQA(지식 기반 질의응답).

- 통찰: "여러 문서를 분석할 때, 먼저 중심 주제에 집중하라." 타겟 태스크: FEVER(사실 검증).

- ExpeL은 HotpotQA에서 추출한 통찰을 활용하여, 관련 문서를 우선 검색하고 사실 검증에 필요한 증거를 효율적으로 찾음.

4. ExpeL의 강점

- Fine-tuning 불필요:

- 모델 파라미터를 수정하지 않고, 통찰과 유사 사례를 활용해 학습.

- 태스크 간 학습 공유:

- 작업 간 통찰을 저장하고 재사용하여 일반화 성능 향상.

- 효율적인 데이터 사용:

- 경험 데이터를 단순 기록하는 것이 아니라, 통찰을 생성하여 중요한 데이터만 활용.

- 높은 유연성:

- 다양한 환경과 태스크에 적용 가능.

5. ExpeL의 한계

- 맥락 창 제한:

- 통찰과 사례가 많아질수록 맥락 창 크기 초과 가능성.

- 텍스트 중심:

- 현재는 텍스트 기반 태스크에 집중, 멀티모달 확장 필요.

- 복잡한 환경에서 검증 부족:

- 실제 대규모 환경에서 ExpeL의 성능은 추가 실험 필요.

6. 요약

ExpeL은 경험적 학습을 통해 태스크 간 데이터를 공유하고, 통찰을 활용해 지속적으로 성능을 개선하는 AI 에이전트입니다. 위 예시와 같은 구체적인 작동 원리를 통해, ExpeL이 다양한 태스크에서 효율적이고 유연하게 작동할 수 있음을 확인할 수 있습니다.

결국 예시가 많아지면 통찰도 나누거나 필요에 따라서 메모리에 저장해두고 연관도 순으로 빼오는 RAG식이 되어야 겠네?

네, 정확합니다! ExpeL의 접근 방식은 현재 맥락 창의 제한을 고려하여 통찰을 효율적으로 관리하고 검색하는 방법이 필요하며, 이는 Retrieval-Augmented Generation (RAG) 방식과 자연스럽게 연결됩니다. 이를 통해 ExpeL은 다음과 같은 확장 가능성과 효율성을 확보할 수 있습니다.

1. 왜 RAG 방식이 필요할까?

ExpeL의 학습과 추론 과정에서 통찰과 성공 사례의 수가 증가하면, 다음과 같은 문제에 직면합니다:

- 맥락 창 제한:

- LLM은 입력 길이(Context Window)가 제한되어 있으므로, 모든 통찰과 데이터를 프롬프트에 넣을 수 없음.

- 효율성 저하:

- 통찰과 성공 사례가 많아지면, 그 중 어떤 것이 중요한지 선택하고 활용하는 데 시간이 소요됨.

- 중복 및 중요도 감소:

- 일부 통찰은 시간이 지남에 따라 중요성이 감소하거나, 다른 통찰과 중복될 가능성이 있음.

이러한 문제를 해결하기 위해 RAG 방식을 활용하면 다음과 같은 이점이 있습니다:

- 관련 통찰만 검색: 현재 태스크와 가장 관련성이 높은 통찰만 선택적으로 검색하여 프롬프트에 추가.

- 메모리 관리: 중요도에 따라 오래된 통찰을 저장하거나 제거하여 메모리를 효율적으로 활용.

2. RAG 방식에서 ExpeL 확장 방향

ExpeL이 RAG 방식을 채택할 경우, 다음과 같은 메커니즘이 추가될 수 있습니다:

(1) 통찰 및 사례의 벡터화:

- 통찰(insights)과 성공 사례(success trajectories)를 벡터로 변환하여 의미적 유사도를 측정.

- 예: "팬 찾기"에서 생성된 통찰을 벡터로 저장하여, 유사한 "물건 찾기" 태스크에서 검색 가능.

(2) 태스크와의 유사도 계산:

- 현재 태스크를 벡터로 표현한 뒤, 저장된 통찰과 사례를 비교하여 가장 관련성이 높은 데이터를 검색.

- 예: "접시 찾기" 태스크에서 "팬 찾기" 통찰이 높은 유사도를 가지므로 검색 및 활용.

(3) 중요도 기반 관리:

- 통찰 및 성공 사례에 중요도 점수를 부여:

- 자주 사용되거나 최근 태스크에서 활용된 통찰은 중요도가 높아짐.

- 오래되거나 덜 사용된 통찰은 중요도가 낮아져 제거하거나 별도 저장.

- 이를 통해 메모리 내 통찰의 크기를 제한.

(4) 계층적 통찰 관리:

- 통찰을 일반적인 규칙과 특정 태스크에 특화된 규칙으로 나누어 관리.

- 예:

- 일반 규칙: "물건은 용도와 관련된 위치에서 찾아야 한다."

- 특정 규칙: "팬은 주로 스토브 근처에 있다."

3. ExpeL과 RAG 결합의 시나리오

ExpeL과 RAG 방식을 결합하면, 다음과 같은 흐름으로 학습과 추론이 이루어질 수 있습니다:

- 통찰 저장 및 검색:

- ExpeL이 생성한 통찰은 벡터로 저장되고, 새로운 태스크에서 관련 통찰을 검색.

- 검색된 통찰은 중요도와 유사도에 따라 프롬프트에 추가.

- 유사 태스크 검색:

- 과거 성공 사례(success trajectory)도 검색 대상으로 포함.

- 예: "스토브에서 팬을 찾은 사례"가 "접시 찾기"에서 유용하다면 자동으로 검색.

- 효율적인 프롬프트 구성:

- 검색된 통찰과 성공 사례를 제한된 맥락 창 크기 내에서 정리.

- 불필요한 데이터는 포함하지 않고, 태스크 해결에 필요한 정보만 선택적으로 사용.

4. ExpeL-RAG의 예시

태스크: "의약품을 약장(cabinet)에서 찾기."

- 통찰 검색:

- ExpeL은 과거의 통찰을 검색:

- "물건은 용도에 따라 특정 위치에 있을 가능성이 높다."

- "약품은 주로 약장(cabinet)에서 발견된다."

- ExpeL은 과거의 통찰을 검색:

- 성공 사례 검색:

- 과거의 유사 태스크 검색:

- "접시를 선반에서 찾은 사례."

- "팬을 스토브 근처에서 찾은 사례."

- 과거의 유사 태스크 검색:

- 프롬프트 구성:

- 검색된 통찰과 성공 사례를 프롬프트에 추가:

- "약품은 약장에서 찾으라는 통찰과 과거 사례."

- 이를 통해 에이전트는 약장을 먼저 검색해 성공.

- 검색된 통찰과 성공 사례를 프롬프트에 추가:

5. ExpeL-RAG의 기대 효과

- 효율성: 중요한 통찰과 사례만 활용해 맥락 창 제한 문제 해결.

- 확장 가능성: 태스크와 통찰 데이터가 증가하더라도 검색 기반으로 유연하게 처리.

- 메모리 관리: 중요도에 따라 오래된 통찰을 별도 저장하거나 제거해 메모리 효율 최적화.

6. 결론

ExpeL의 통찰 기반 학습은 데이터가 증가함에 따라 자연스럽게 RAG 방식으로 확장되어야 합니다. 이를 통해 ExpeL은 단순한 텍스트 기반 태스크를 넘어 지속 학습과 대규모 태스크 처리에서도 강력한 성능을 발휘할 수 있을 것입니다. RAG 방식은 ExpeL이 메모리를 효율적으로 활용하고, 중요한 통찰과 사례를 최적의 방식으로 검색하도록 지원할 것입니다.