https://arxiv.org/abs/2305.13172

Editing Large Language Models: Problems, Methods, and Opportunities

Despite the ability to train capable LLMs, the methodology for maintaining their relevancy and rectifying errors remains elusive. To this end, the past few years have witnessed a surge in techniques for editing LLMs, the objective of which is to efficientl

arxiv.org

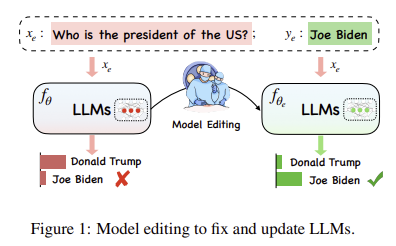

이 논문은 새로운 정보를 반영하지 못 하는 LLM의 단점을 보안하기 위해 LLM을 새로 학습하거나 추가적인 방법을 통해 LLM에 새로운 정보를 주입하는 논문입니다.

저도 LLM에 새로운 정보를 주입할 때 RAG를 활용하여 일시적인 Prompt에 정보 제공보다는 fine-tuning을 통한 정보 제공을 찾고 있었어서 제가 원하던 논문이었네요

여기서도 프롬프트를 통한 주입이나 추가적인 모듈을 통한 주입보다는 관련 파라미터를 찾아 수정하거나 메모리 기반으로 진행하는 것에서 좋은 성능을 보였습니다.

한 번 이런 논문을 더 자세히 봐야 겠네요

논문 요약: "Editing Large Language Models: Problems, Methods, and Opportunities"

문제 정의: 해결하려는 문제

- 배경:

- 대규모 언어 모델(LLMs)은 강력한 성능을 보이나, 시간이 지나면서 새로운 정보 반영 및 오류 수정이 필요.

- 모델 재학습은 비용이 크므로, 특정 영역에서만 효율적으로 수정하는 방법이 요구됨.

- 핵심 문제:

- 특정 지식이나 오류를 수정하면서 모델의 다른 부분(예: 다른 입력에 대한 성능)을 유지해야 함.

- 이를 위해 모델 편집(Model Editing)의 개념이 등장함.

- 목표:

- 효율적으로 모델의 특정 영역을 수정하여 정확성을 높이고, 부작용을 최소화하는 방법을 개발 및 평가.

방법론: 사용된 접근 방식

- 모델 편집의 두 가지 패러다임:

- 모델 파라미터를 유지하는 방법:

- 메모리 기반 접근법: 특정 편집 데이터를 메모리에 저장하고 이를 활용해 모델 출력을 조정.

- 추가 파라미터 활용: 원래 모델을 수정하지 않고 추가적인 모듈(예: Adapters, Neurons)을 통해 편집.

- 모델 파라미터를 수정하는 방법:

- Locate-Then-Edit: 특정 지식 관련 파라미터를 찾아 수정(예: Knowledge Neuron, ROME).

- Meta-learning: 초매개변수를 학습해 수정 업데이트를 계산.

- 모델 파라미터를 유지하는 방법:

- 평가 방법:

- 세 가지 주요 지표 사용:

- 신뢰성: 편집 대상 사례의 정확성.

- 일반화: 편집 사례와 유사한 사례에서의 성능.

- 지역성: 모델의 다른 비관련 사례에 대한 영향 최소화.

- 세 가지 주요 지표 사용:

결과: 주요 발견 및 성과

- 모델 평가:

- ROME과 SERAC은 신뢰성과 일반화에서 우수한 성능을 보임.

- MEMIT은 다중 사례 편집에서 강점이 있지만, 일반화 성능은 떨어짐.

- IKE는 특정 맥락 기반 학습에 의존해 높은 성능을 보임.

- 확장성과 효율성:

- 대규모 모델(OPT-13B, GPT-NEOX-20B)에서는 일부 방법론(ROME, MEMIT)이 성능 저하.

- 다중 사례(batch) 편집에서는 MEMIT이 높은 효율성을 보임.

- 부작용(Locality):

- 대부분의 방법론이 비관련 속성에는 영향을 미치지 않으나, 인접 맥락에서 혼란이 발생할 가능성 존재.

한계 및 논의

- 편집 범위:

- 감정, 의견 등 비사실적 데이터의 편집 가능성에 대한 연구 부족.

- 다중 언어 지원 및 다양한 모델 아키텍처(예: LLaMA)에 대한 일반화가 미흡.

- 효율성 문제:

- 대부분의 방법론이 높은 메모리 및 시간 소모를 요구.

- "Black-box" 모델 편집(ChatGPT와 같은 API 기반 모델) 연구는 초기 단계.

- 평가 방법의 제한:

- 기존 평가는 단일 편집 또는 단순 데이터셋에 집중.

- 편집 지식의 연쇄적 영향(One-hop reasoning) 평가가 추가적으로 필요.

타당성 분석 및 아쉬운 점

- 타당성:

- 모델 편집 연구는 대규모 모델의 유지보수와 효율성을 높이는 중요한 방향으로 보임.

- 다양한 접근법을 체계적으로 비교한 점에서 연구 기여도가 높음.

- 아쉬운 점:

- 대규모 모델에서의 성능 저하 문제를 해결할 구체적 방법 부족.

- 메모리 기반 접근법은 신뢰성이 높으나, 일반화 성능은 상대적으로 낮음.

- 다중 사례에서의 일관성과 효율성을 높이는 방법이 더 연구되어야 함.

연구 방향 제언: AI Agent와 연계

- 지식 편집 자동화:

- 다중 사례 및 연쇄적 지식 편집을 지원하는 방법론(MEMIT)을 활용, 에이전트 간 지식 공유 및 업데이트 자동화.

- 효율적 모델 편집:

- Black-box 모델에 대한 효율적 편집 연구를 통해, API 기반 에이전트가 실시간으로 업데이트 가능하도록 설계.

- 윤리적 고려:

- 편집된 지식의 신뢰성과 부작용을 검증하는 메커니즘 구축.

- 에이전트 간 협업에서 비의도적 지식 왜곡 방지.

위 요약이 추후 AI Agent 연구 방향 설정에 도움이 되길 바랍니다. 추가 논의가 필요하면 알려주세요!

모델을 수정하는 방식이 신뢰성과 일반화 성능이 좋은거네?

리소스는 많이 먹기는 하지만

맞습니다. 모델 파라미터를 직접 수정하는 방식은 신뢰성과 일반화 성능에서 확실히 강점이 있지만, 리소스 소모가 크다는 한계가 있습니다. 이를 조금 더 세부적으로 분석하자면:

모델 수정 방식의 강점

- 신뢰성:

- 특정 사례에 대해 높은 정확도로 원하는 출력을 제공.

- 예를 들어, ROME은 causal mediation analysis를 통해 편집이 필요한 부분을 정확히 찾아 수정하므로 목표 사례에서 매우 높은 성능을 보임.

- 일반화 성능:

- 편집된 지식이 관련된 유사 사례에도 효과적으로 전이됨.

- 예를 들어, MEMIT은 여러 사례를 동시에 편집하면서 관련된 데이터에 대한 성능 유지.

- 다중 사례 편집:

- MEMIT은 한 번에 많은 지식을 수정할 수 있으며, 편집 과정에서의 효율성도 상대적으로 뛰어남.

한계점

- 리소스 소모:

- 대규모 모델에서 수정 작업이 복잡하고, 메모리와 시간 소모가 큼.

- 예를 들어, ROME과 MEMIT은 사전 통계 계산(Matrix Inversion)에 시간이 걸리며, 메모리 사용량도 증가.

- 모델 구조 의존성:

- 일부 방법은 모델의 FFN(Feed-Forward Network) 구조를 활용하는데, 특정 모델 아키텍처(예: OPT-13B)에서 실패하는 사례가 발견됨.

- 이는 편집 방법이 모델 설계와 강하게 결합되어 있음을 의미.

- 다중 편집의 누적 효과:

- 다중 편집이나 연속적 편집에서 성능이 점진적으로 감소하는 경향.

- 예를 들어, ROME은 10회 이상 연속 편집에서 성능 저하를 보임.

이 한계를 어떻게 극복할 수 있을까?

- 효율성 개선:

- 기존의 matrix inversion 대신 더 경량화된 최적화 방법 연구.

- 예를 들어, 저차원 공간에서의 학습(Gradient Decomposition)을 활용하여 메모리와 연산량을 줄일 수 있음.

- 다중 사례 편집의 안정화:

- 다중 편집 시, 독립적 메모리 블록 또는 로컬 업데이트 기법을 통해 누적된 부작용을 최소화.

- MEMIT과 유사한 방식으로 여러 편집을 일괄적으로 처리할 수 있는 방법 고도화.

- 모델 독립적 접근법 개발:

- 특정 아키텍처에 종속되지 않는 방법(예: Meta-learning 기반)을 통해 다양한 모델에 적용 가능하도록 설계.

- 특히, Black-box 모델(GPT-4, ChatGPT)에 대한 편집 방법 연구는 매우 중요.

AI Agent 연구에서의 활용 가능성

이러한 신뢰성과 일반화 성능을 활용하면, AI Agent 간 협력이나 독립적 학습 시스템을 설계할 때 다음과 같은 가능성을 기대할 수 있습니다:

- 지식 공유 및 업데이트: Agent가 자체 모델을 지속적으로 수정하여, 변화하는 환경에 적응 가능.

- 효율적 협력: 다중 Agent 간 지식 편집이 간섭 없이 이루어져 협업 효율성을 극대화.

- 리소스 최적화: 효율적인 수정 알고리즘과 경량화된 메모리 사용을 통해 대규모 AI 시스템에서도 원활히 작동.

이 내용을 기반으로 리소스 효율성을 고려한 신뢰성 높은 모델 수정 방법을 초점으로 연구 방향을 설정하면 좋을 것 같습니다. 더 깊이 논의할 사항이 있으면 알려주세요!

ROME와 SERAC 방식이 모델의 파라미터를 어떤 형식으로 바꾸는데 좋은 성능을 가지는거야?

ROME와 SERAC 방식은 모델 파라미터 수정에서 각각 독특한 메커니즘을 통해 신뢰성과 일반화 성능을 달성합니다. 두 접근법의 차이점과 그 성능이 좋은 이유를 분석해 보겠습니다.

1. ROME (Rank-One Model Editing)

작동 방식:

- Causal Mediation Analysis:

- 모델의 특정 지식을 저장하는 파라미터(주로 FFN의 특정 부분)를 찾아냄.

- 이를 위해 causal trace를 사용해 특정 지식이 어떤 파라미터에서 활성화되는지 분석.

- Matrix Inversion:

- 선택된 FFN 매트릭스에서 편집이 필요한 영역을 찾아 수정.

- 구체적으로, 새로운 지식을 삽입하기 위해 Least Squares Optimization을 사용하여 해당 영역을 업데이트.

- 국소적 수정:

- 모델의 다른 영역에 영향을 최소화하기 위해, 변경 사항을 특정 영역에 제한.

- 이를 통해 로컬 편집(Locality)과 신뢰성을 확보.

좋은 성능의 이유:

- 국소성: 수정된 지식이 모델의 다른 지식에 영향을 미치지 않도록 매트릭스의 작은 부분만 변경.

- 효율적 위치 탐지: Causal Mediation Analysis로 관련 없는 영역을 건드리지 않고 정확히 수정해야 할 위치를 찾아냄.

- 수학적 안정성: Least Squares 방식은 수정 과정에서 최적의 해를 보장, 불필요한 부작용을 줄임.

한계점:

- Matrix Inversion의 한계: 특정 모델(예: OPT-13B)에서는 매트릭스가 비가역적일 수 있어 실패 가능.

- 다중 사례 편집에 약점: 한 번에 하나의 사실만 수정할 수 있어 대규모 편집에는 비효율적.

2. SERAC (Selective Retrieval and Counterfactual Generation)

작동 방식:

- Memory-Based Editing:

- 편집해야 할 사례를 메모리에 저장하고, 새로운 입력에 대해 해당 사례를 검색.

- 예: “현재 미국 대통령은 누구인가?”라는 입력이 들어오면, 메모리에서 관련된 편집된 정보를 검색하여 출력에 반영.

- Counterfactual Model Integration:

- 원래 모델은 수정하지 않고, Counterfactual Model을 별도로 학습해 특정 입력에서만 다른 출력을 생성.

- 새로운 입력이 수정된 사례와 연관되지 않으면 원래 모델이 작동하도록 함.

- Scope Classifier:

- 입력이 메모리에 저장된 사례와 관련 있는지 판단.

- 관련이 있다면 Counterfactual Model이 작동, 없으면 원래 모델의 결과를 출력.

좋은 성능의 이유:

- 원본 모델 보존: 모델 파라미터 자체를 변경하지 않아 안정적이며, 수정이 독립적으로 이루어짐.

- 강력한 신뢰성: 메모리에 저장된 수정 사항을 정확히 검색하고 반영, 수정된 사례에서 매우 높은 성능을 보임.

- 모듈성: 수정된 데이터와 원래 데이터를 독립적으로 관리할 수 있어 확장성이 좋음.

한계점:

- 일반화 부족: 수정된 데이터와 유사한 새로운 사례를 처리하는 데 약점이 있음.

- 메모리 및 추가 모델 필요: 추가적인 Counterfactual Model과 메모리 시스템이 필요해 리소스 사용이 늘어남.

ROME와 SERAC의 성능이 좋은 이유 비교

| 요소 | ROME | SERAC |

| 신뢰성 | FFN의 국소적 변경으로 목표 사례에서 높은 성능 | 메모리 기반 검색으로 수정 사례에 대해 높은 정확도 |

| 일반화 성능 | 편집된 지식을 관련 사례에 전이 가능 | 유사 사례 일반화는 약점 |

| 지역성 (부작용) | 다른 입력에 영향을 최소화 | 원본 모델을 수정하지 않아 안정적 |

| 리소스 소모 | Matrix Inversion에 높은 계산량 | 추가 모델과 메모리 시스템으로 리소스 소모 증가 |

| 확장성 | 다중 사례에서 성능 저하 | 다중 사례 처리에는 상대적으로 유리 |

연구 적용 아이디어

- ROME 기반:

- 특정 AI Agent에서 지식 업데이트가 매우 정확해야 하는 경우(예: 법적 정보 갱신)에 활용 가능.

- 하지만 대규모 편집이 필요한 경우, MEMIT 같은 확장형 기법과 혼합할 수 있음.

- SERAC 기반:

- 다중 에이전트 시스템에서 독립적인 지식 관리에 유리.

- 원래 모델은 유지하면서 에이전트 간의 지식 공유나 수정이 필요한 상황에서 적합.

결론적으로, 두 방식 모두 특정 상황에 맞는 강점이 있으므로 연구 목적에 따라 병합하거나 선택적으로 적용하는 것이 효과적입니다. 추가적으로 논의하고 싶은 세부 사항이 있다면 말씀해주세요!

그럼 ROME에서 Least Squares Optimization을 통해 업데이트할 구역을 찾는다고 하는데 자세하게 어떻게 작동하는거야??

ROME에서 Least Squares Optimization을 사용하는 과정은 매우 구조적이며, 편집하고자 하는 지식을 저장하고 있는 FFN의 특정 파라미터 영역을 찾아내고 수정하는 데 초점이 맞춰져 있습니다. 이를 상세히 설명하자면:

1. ROME의 기본 구조

FFN에서 지식 저장

- ROME은 모델의 Feed-Forward Network (FFN) 레이어가 지식을 저장하는 핵심 역할을 한다고 가정합니다.

- FFN의 중간 표현에서 활성화된 뉴런이 특정 지식(예: "미국 대통령은 조 바이든")을 나타낸다고 분석합니다.

- 이 활성화된 뉴런들이 Key-Value 쌍의 메모리 역할을 하며, 이를 수정하여 모델 출력을 변경할 수 있습니다.

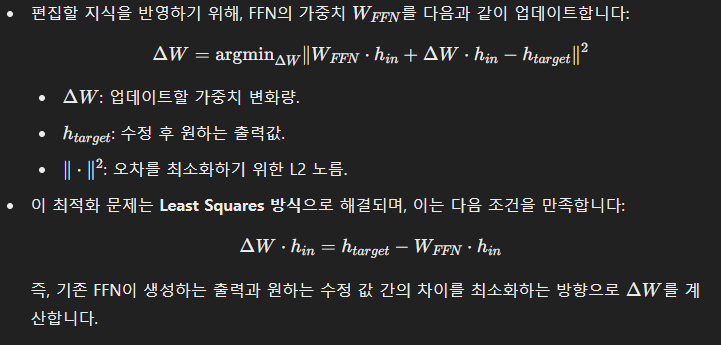

2. Least Squares Optimization의 역할

ROME의 핵심은 지식 변경을 위해 FFN의 일부 파라미터를 국소적으로 업데이트하는 것입니다. 이를 단계적으로 설명하면 다음과 같습니다:

Step 1: 대상 뉴런 식별

- Causal Tracing 기법을 사용하여 특정 지식(예: "조 바이든")이 모델 출력에 어떤 영향을 미치는지 분석.

- 이를 통해 해당 지식이 FFN 레이어의 어떤 뉴런 활성화에 주로 의존하는지 식별합니다.

Step 2: 선형 모델로 근사

- FFN은 수학적으로 다음과 같은 선형 모델로 근사할 수 있습니다:

h_{out} = W_{FFN} ⋅ h_{in} + b- h_{in}: FFN의 입력 값.

- W_{FFN}: FFN의 가중치 행렬.

- h_{out}: FFN의 출력 값.

- b: 편향 (bias).

Step 3: 업데이트가 필요한 영역 정의

- 특정 지식에 관련된 입력 벡터 h_{in}가 출력 벡터 h_{out}로 변환될 때, 원하는 수정 값을 반영하기 위해 W_{FFN}의 특정 부분을 수정해야 합니다.

- 이때 수정 대상은 W_{FFN}에서 특정 행렬 영역(블록)으로 한정됩니다.

Step 4: Least Squares Optimization 적용

3. 왜 Least Squares Optimization을 사용하는가?

장점

- 수학적 안정성:

- Least Squares는 주어진 입력에서 출력값을 가장 잘 근사하는 방향으로 파라미터를 업데이트하여 모델이 안정적으로 작동하도록 보장합니다.

- 국소적 수정:

- W_{FFN} 전체를 변경하지 않고, 수정이 필요한 특정 영역(행렬 블록)만 업데이트하므로 부작용이 적음.

- 효율성:

- 해당 작업은 W_{FFN}의 특정 뉴런에만 영향을 미치기 때문에 계산량이 제한적입니다.

4. 업데이트 구역의 수학적 해석

선형 구역 결정

- 업데이트가 필요한 영역은 기본적으로 W_{FFN}의 특정 뉴런 집합에 한정됩니다.

- 이 뉴런 집합은 Causal Tracing으로 분석한 결과와, FFN에서 활성화된 벡터의 기하학적 위치로 결정됩니다.

모든 입력에 영향을 최소화

- 업데이트된 W_{FFN}는 수정된 지식과 관련된 입력에만 영향을 미칩니다.

- 이 외의 입력은 ΔW⋅h_{in} 항이 0 또는 미미한 값을 유지하도록 설계됩니다.

5. ROME의 강점과 한계

강점:

- 특정 지식을 정확히 수정하고, 수정된 지식이 관련된 유사 사례에 일반화되는 성능이 우수.

- 기존 모델의 구조를 크게 변경하지 않으므로 다른 입력에 대한 영향(부작용)이 적음.

한계:

- Matrix Inversion의 제약:

- 특정 모델(예: OPT-13B)에서는 FFN 가중치 행렬이 비가역적이어서 실패 가능.

- 다중 사례 처리 한계:

- 한 번에 하나의 사실만 수정 가능, 대규모 편집에는 효율적이지 않음.

ROME의 Least Squares Optimization은 FFN 내 국소적 수정으로 모델의 신뢰성, 일반화 성능, 지역성을 모두 만족시키는 핵심 기술입니다. 추가적으로 구현 과정이나 이론적 배경이 더 필요하다면 말씀해주세요!

전체적으로 논문의 요지를 잘 파악하셨고, 본인의 연구 방향과 관련성을 연결한 점이 좋습니다. 하지만 조금 더 구체적으로 표현하거나 논문의 핵심 내용을 명확히 드러내기 위해 다음과 같은 수정과 추가를 제안드립니다.

수정 및 추가 제안

- 논문의 목적 명확화:

- 논문은 단순히 "새로운 정보를 주입"하는 것을 넘어, 효율적이고 부작용을 최소화하면서 모델을 편집하는 방법을 제안합니다. 이를 강조하면 논문의 기여도를 더 명확히 드러낼 수 있습니다.

- 예시: "이 논문은 새로운 정보를 반영하지 못하는 LLM의 단점을 보완하기 위해, 효율적이고 지역성을 유지하며 모델을 수정하는 다양한 방법을 제안합니다."

- 파라미터 수정과 메모리 기반 방식에 대한 구체성 추가:

- 논문에서 ROME과 SERAC 같은 방식이 언급되었는데, 이들이 각각 어떻게 작동하고 어떤 상황에서 더 적합한지를 간단히 언급하면 좋습니다.

- 예시: "이 논문에서는 특히 ROME 방식이 causal mediation 분석을 통해 FFN의 특정 파라미터를 국소적으로 수정함으로써 높은 신뢰성과 일반화를 달성했음을 보여줍니다. 반면, SERAC은 메모리 기반으로 관련 데이터를 저장하고 검색하여 원본 모델에 영향을 최소화한 채 정보를 주입하는 방식입니다."

- Fine-tuning과의 차별성 강조:

- Fine-tuning과 모델 편집은 모두 모델 수정에 사용되지만, 논문에서 제안된 방법은 기존 모델의 재학습 없이 특정 지식을 효율적으로 삽입하려는 것이 핵심입니다. 이 차이를 언급하면 더 논리적인 연결이 됩니다.

- 예시: "프롬프트를 통한 일시적 정보 제공이나 Fine-tuning과 달리, 이 논문은 모델 전체를 재학습하지 않고 특정 영역만 수정하는 방법론(ROME, MEMIT 등)을 제시합니다."

- 본인의 연구와의 연결 강화:

- 현재 연구와 이 논문의 구체적인 접점을 더 명확히 하면, 왜 이 논문이 중요한지 강조할 수 있습니다.

- 예시: "저도 RAG를 활용한 LLM의 정보 주입 방식을 연구 중인데, 이 논문의 접근법은 일시적인 프롬프트 기반 방식의 한계를 보완하고, Fine-tuning 없이 효율적으로 모델을 수정하는 대안을 제시한다는 점에서 제 연구에 큰 영감을 줄 수 있습니다."

- 마무리에서 연구 방향 제시:

- 논문을 "더 자세히 봐야겠다"는 결론을 보완하여, 구체적으로 어떤 점에 주목할 것인지 언급하면 좋습니다.

- 예시: "특히, ROME 방식이 causal tracing을 통해 파라미터를 효율적으로 수정하는 과정과, MEMIT 방식이 다중 사례를 한 번에 처리하면서도 일반화를 유지하는 방법에 대해 더 깊이 연구해보고 싶습니다."

수정된 예시

이 논문은 새로운 정보를 반영하지 못하는 LLM의 단점을 보완하기 위해, 효율적이고 지역성을 유지하며 모델을 수정하는 다양한 방법을 제안합니다. 특히, 모델 전체를 재학습하지 않고 특정 영역만 수정하는 방식으로, 기존 Fine-tuning이나 프롬프트 기반 접근법과 차별화됩니다.

논문에서는 파라미터 수정 방식(ROME, MEMIT)과 메모리 기반 방식(SERAC)이 각각 좋은 성능을 보였는데, ROME은 causal mediation 분석을 통해 FFN의 특정 파라미터를 국소적으로 수정하여 높은 신뢰성과 일반화를 달성한 반면, SERAC은 메모리 기반으로 관련 데이터를 저장하고 검색하여 원본 모델에 영향을 최소화한 채 정보를 주입하는 방식을 사용했습니다.

저도 RAG를 활용한 LLM의 정보 주입을 연구 중인데, 이 논문은 Fine-tuning 없이도 효율적으로 모델을 수정할 수 있는 대안을 제시한다는 점에서 큰 영감을 줄 수 있습니다. 특히, ROME의 파라미터 수정 기법과 MEMIT의 다중 사례 편집 방식에 대해 더 깊이 연구하여, 제 연구 방향에 적용할 방법을 모색해보고 싶습니다.

이와 같이 논문의 구체적인 기여도를 명확히 하고, 본인의 연구와 연결성을 강조하면 더 설득력 있는 요약과 분석이 될 것입니다. 수정한 예시가 도움이 되었길 바랍니다!