https://arxiv.org/abs/2403.19647

Sparse Feature Circuits: Discovering and Editing Interpretable Causal Graphs in Language Models

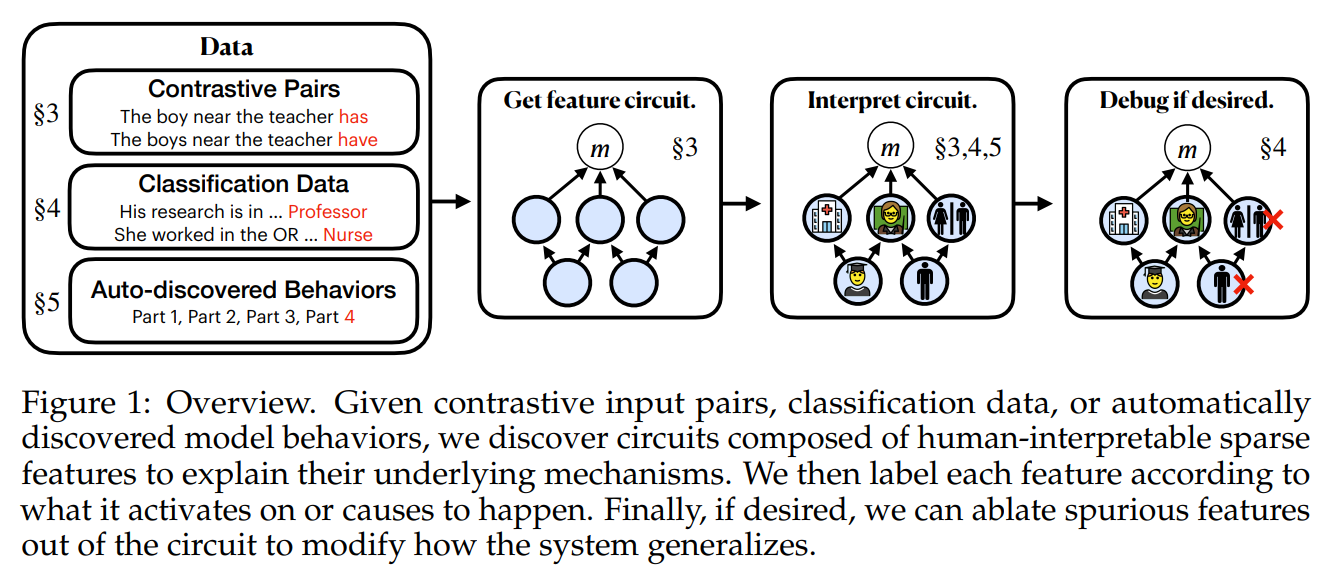

We introduce methods for discovering and applying sparse feature circuits. These are causally implicated subnetworks of human-interpretable features for explaining language model behaviors. Circuits identified in prior work consist of polysemantic and diff

arxiv.org

이 논문은 학습된 SAE에서 각각의 Feature랄 확실하게 나누고, Feature 중에서 직업에 성별이 영향을 주는 등 그러한 편향이 있다면 SHIFT 방식을 활용하여 Feature를 제거하고, 그러한 편향이 없도록 다시 학습시키는 논문입니다.

그래도 출력에 대한 Bias가 사라지지는 않고, 그저 Feature 수준에서만 확인하네요

이 논문은 언어 모델(이하 LM)에서 인간이 이해할 수 있는 방식으로 모델 동작을 설명하고, 불필요한 기능을 제거하여 일반화 성능을 개선하는 방법론을 제안합니다. 이를 위해 Sparse Autoencoder(SAE)를 활용해 모델의 해석 가능성을 높이는 '스파스 특징 회로(Sparse Feature Circuits)'를 발견하고 편집하는 과정을 설명합니다.

1. 해결하려는 문제

언어 모델의 예상치 못한 행동을 인간이 이해할 수 있게 설명하는 것은 해석 가능성 연구의 핵심 문제입니다. 기존에는 신경망의 다양한 구성 요소(예: 뉴런, 어텐션 헤드 등)를 분석해 모델 행동을 설명하려고 했으나, 이러한 접근법은 여러 의미(polysemantic)를 가질 수 있어 해석이 어렵습니다. 따라서, 이 논문은 세분화된 해석 가능한 구성 요소를 기반으로 스파스 특징 회로를 통해 예상하지 못한 모델 메커니즘을 밝혀내고, 이를 다운스트림 과제에 적용하는 것을 목표로 합니다.

2. 시도한 방법

- Sparse Autoencoder 활용: 스파스 오토인코더를 사용하여 LM의 잠재 공간에서 해석 가능한 방향성을 나타내는 특징을 식별합니다.

- Linear Approximation을 통한 원인 분석: 발견한 회로가 LM의 출력에 얼마나 기여하는지 분석하기 위해 간단한 선형 근사 방법을 사용합니다.

- SHIFT 기법 도입: 다운스트림 과제에서 사람의 판단에 따라 불필요한 특징을 제거하여 모델이 의도하지 않은 신호에 민감하지 않도록 하는 방법입니다.

3. 사용된 방법

- 스파스 오토인코더(SAE): 각 층별로 SAE를 사용하여 특정 데이터 포인트에 대한 인간 해석이 가능한 특징을 학습하고 모델의 다양한 활성화 값들을 분해하여 잠재적인 의미를 설명합니다.

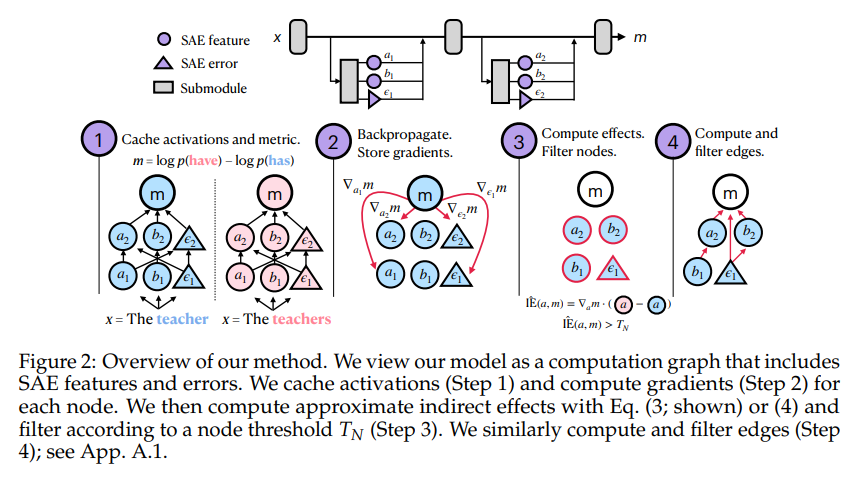

- 간접 효과 계산: LM의 계산 그래프 상의 각 노드가 모델 출력에 미치는 간접 효과를 분석합니다. 주어진 입력 쌍에 대해 특정 노드의 상태를 조작하여 노드가 모델 결정에 미치는 영향을 측정합니다.

- SHIFT 기법: 해석된 특징 중 불필요한 부분을 제거함으로써 다운스트림 모델의 일반화 성능을 높입니다.

4. 결과

- 해석 가능성: 스파스 특징 회로는 기존의 뉴런 기반 회로보다 해석 가능성이 높아 사람이 더 쉽게 이해할 수 있음을 입증하였습니다.

- 일관성 있는 일반화: 주어진 언어 태스크에서 불필요한 성별 편향을 제거하여 성능을 개선하였으며, 이는 SHIFT 기법이 다운스트림 성능을 향상시킬 수 있음을 보여줍니다.

- 확장 가능성: 자동으로 수천 개의 모델 행동을 발견하고 이에 대한 회로를 생성하여 자동 해석 가능성 파이프라인의 확장 가능성을 시연하였습니다.

5. 한계점

- SAE 접근 방식의 한계: 고성능의 SAE 모델을 학습하는 데 많은 컴퓨팅 자원이 필요하며, 이는 현재 방법론이 크게 의존하는 요소입니다.

- 정성적 평가: 일부 평가 지표는 정성적인 접근에 기반하므로, 보다 엄밀한 양적 평가가 필요할 수 있습니다.

이 논문은 앞으로 LM의 행동을 해석하고 이해하는 데 있어 중요한 기여를 할 것으로 보입니다.

여기서 사용한 방법론에 대해 좀 더 자세하게 설명해주고, 타당한지 말해줘

논문에서 사용한 방법론을 요약하면 스파스 오토인코더(Sparse Autoencoder, SAE)를 활용해 언어 모델(LM)의 잠재 공간에서 해석 가능한 특징을 추출하고, 이를 기반으로 스파스 특징 회로를 구성하여 모델의 동작을 설명하는 접근입니다. 여기서 주요 구성 요소와 타당성에 대해 자세히 살펴보겠습니다.

1. Sparse Autoencoder(SAE)를 활용한 해석 가능한 특징 학습

- 방법: SAE는 모델의 특정 지점에서 활성화된 정보를 압축하여 모델이 해석 가능한 방향성을 찾습니다. 이 논문에서는 특히 잠재 공간 내에서 인간이 이해하기 쉬운 특징을 학습하는 데 SAE를 사용합니다. 각 층별로 SAE를 학습하여 어텐션 층의 출력이나 MLP 층의 출력을 재구성하고, 이를 통해 특정 데이터 포인트에 대해 모델의 세부적인 특징을 추출합니다.

- 평가: SAE를 통해 추출한 특징은 기존 뉴런 기반 분석보다 더 해석 가능성이 높다고 보고되었으며, 사람의 해석을 바탕으로 보다 의미 있는 분석이 가능하다는 장점이 있습니다.

2. Linear Approximation을 통한 간접 효과(Indirect Effect) 분석

- 방법: 모델의 계산 그래프 상에서 각 노드가 모델 출력에 미치는 영향을 간접 효과로 정의하고, 이를 선형 근사 기법을 통해 빠르게 계산합니다. 이 접근은 전통적인 간접 효과 측정 방식보다 계산이 효율적이며, 각 특징이 모델의 출력 결정에 얼마나 기여하는지 평가할 수 있도록 해줍니다.

- 타당성 평가: 선형 근사는 계산 효율성 측면에서 타당하지만, 비선형성을 가진 깊은 신경망에서는 정확도가 떨어질 수 있습니다. 따라서 모델이 비선형 구조를 가진 경우 결과가 완벽히 일치하지 않을 가능성이 있으며, 비선형 효과를 포함한 방법론이 보완될 필요가 있습니다.

3. SHIFT (Sparse Human-Interpretable Feature Trimming) 기법을 통한 다운스트림 과제 개선

- 방법: SHIFT는 해석 가능한 특징을 선택적으로 제거하여 모델이 의도하지 않은 신호(예: 편향된 신호)에 덜 민감하도록 합니다. 이는 사람이 임의로 태스크와 무관한 특징을 제거함으로써, 특정 예측에 부정적 영향을 미치는 신호를 차단하는 방법입니다.

- 타당성 평가: 이 접근은 사람이 직접 개입해 특징을 제거하는 방식으로 타당성을 어느 정도 보장할 수 있지만, 사람이 주관적으로 판단한 특징을 제거하는 데 있어 정확성이 필요합니다. 다만, 사람이 판단한 정보가 항상 올바른 것은 아니므로, 모델의 성능이 왜곡될 가능성도 있습니다. 따라서, 장기적으로는 사람의 판단을 자동화할 수 있는 보조 알고리즘 개발이 필요할 수 있습니다.

4. 해석 가능한 회로 생성과 자동화 파이프라인 구축

- 방법: 논문에서는 행동 탐지와 회로 발견을 자동화하여 모델 내 수천 개의 동작을 분석할 수 있는 파이프라인을 구축했습니다. 이 과정에서 Pythia-70M과 같은 모델을 사용하여 다양한 모델 행동을 클러스터링하고, 각 클러스터에 대해 해석 가능한 특징 회로를 생성하여 모델의 구조적 원인을 설명합니다.

- 타당성 평가: 자동화 파이프라인을 구축한 점은 해석 가능성 연구에 큰 기여를 할 수 있으나, 회로가 진정한 원인 관계를 잘 설명하는지에 대한 평가가 더 필요합니다. 또한 클러스터링된 결과가 인간의 해석과 얼마나 일치하는지 평가할 필요가 있으며, 이 부분의 신뢰성 확보가 관건입니다.

타당성 검토 결론

제안된 방법론은 언어 모델의 해석 가능성을 높이기 위해 여러 혁신적인 요소를 포함하고 있으며, 특히 SAE를 활용해 해석 가능한 특징을 찾고 불필요한 신호를 제거함으로써 모델 성능을 향상시키는 점에서 실용적인 의미가 있습니다. 그러나 몇 가지 한계도 존재합니다. SAE의 높은 계산 비용, 선형 근사의 정확성 문제, 사람이 해석해야 하는 SHIFT의 주관성, 자동화된 회로 분석의 신뢰성 등이 향후 개선될 필요가 있습니다.

이를 통해 LM을 분석하고, 이를 활용한 연구를 진행할 때는 이러한 한계를 염두에 두고 보다 고도화된 비선형 근사 기법과 자동화된 해석 기법을 보완해 나가는 것이 바람직할 것으로 보입니다.

각 노드가 출력에 미치는 영향을 간접 효과로 정의하고, 선형 근사 기법을 통해 빠르게 계산한다는 것이 이해가 잘 안가네. 어떻게 진행한 것인지 자세하게 설명해줘

논문에서 언급한 각 노드의 간접 효과(Indirect Effect)를 계산하는 방식은, 모델의 특정 노드나 특징이 출력에 미치는 영향을 효율적으로 파악하기 위한 방법입니다. 이는 특히 언어 모델과 같은 복잡한 신경망 구조에서 해석 가능한 특징 회로를 찾기 위해 활용됩니다. 여기서는 해당 간접 효과를 계산하는 과정과 선형 근사 기법이 어떻게 사용되는지 단계별로 설명하겠습니다.

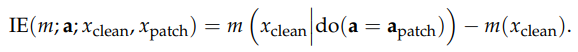

1. 간접 효과(Indirect Effect)란 무엇인가?

간접 효과는 특정 노드(특정 층의 활성화값)가 모델 출력에 미치는 영향을 수치적으로 평가하는 것을 의미합니다. 이를 통해 모델의 계산 과정에서 특정 노드나 특징이 얼마나 중요한 역할을 하는지 파악할 수 있습니다.

논문에서는 "간접 효과"를 다음과 같이 정의합니다:

이 식에서:

- m은 특정 평가 지표, 즉 모델 출력의 특정 함수(예: 출력 확률)입니다.

- a는 모델 계산 그래프의 특정 노드 (예: 특정 뉴런 또는 활성화값)입니다.

- xclean와 xpatch는 서로 다른 입력 데이터 쌍입니다.

- do(a=apatch)는 xclean 입력에 대해 a 노드를 xpatch에서 얻은 값으로 대체한다는 의미입니다.

이 개념은 원래 xclean를 기준으로 평가할 때, 특정 노드 a의 값이 바뀌었을 때 모델 출력이 얼마나 달라지는지 측정하는 것이라고 할 수 있습니다. 이렇게 함으로써 특정 노드가 출력에 미치는 기여도를 평가할 수 있습니다.

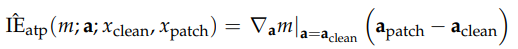

2. 선형 근사(Linearly Approximation)를 사용한 간접 효과 계산

직접적으로 간접 효과를 계산하는 것은 비용이 많이 들고 비효율적입니다. 이를 해결하기 위해, 논문은 선형 근사(linear approximation)를 통해 빠르게 간접 효과를 추정합니다.

선형 근사의 원리

신경망의 복잡한 계산 과정에서 특정 노드의 활성화 값이 출력에 미치는 영향을 일일이 계산하는 대신, 그 변화를 1차 테일러 전개(Taylor expansion)를 이용해 선형 근사할 수 있습니다. 즉, 입력의 작은 변화가 출력에 미치는 영향을 계산할 때 테일러 전개를 이용하면, 이 변화에 대한 예측을 빠르게 할 수 있습니다.

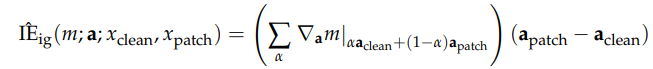

구체적으로는 다음과 같은 식을 사용하여 근사합니다:

이 식은 미분 값을 사용해 특정 노드 a의 작은 변화가 출력 m에 미치는 영향을 계산합니다.

- ∇am은 a의 변화가 m에 미치는 기울기(또는 변화율)로, 특정 위치 a=aclean에서 계산됩니다.

- (apatch−aclean)은 두 입력 간의 활성화 값 차이를 나타냅니다.

따라서 이 근사 방식은 두 번의 순방향 계산(forward pass)과 한 번의 역방향 계산(backward pass)으로 모든 노드에 대한 간접 효과를 계산할 수 있습니다.

통합된 기울기(Integrated Gradients)를 활용한 더 정확한 근사

간단한 선형 근사 방식이 정확도가 충분하지 않다면, 논문에서는 더 정교한 방식인 통합 기울기(Integrated Gradients) 방법을 사용합니다. 통합 기울기는 선형 근사보다 계산 비용이 더 들지만, 더 정확하게 간접 효과를 계산할 수 있습니다.

이 식에서는 α를 여러 값으로 설정하여 a의 변화에 따른 영향을 단계적으로 누적해 계산하므로, 보다 정교한 근사를 수행할 수 있습니다.

3. 요약: 간접 효과 계산의 타당성

이 방식은 선형 근사로 간접 효과를 효율적으로 계산할 수 있다는 점에서 타당합니다. 특히, 전체 모델의 각 노드가 출력에 미치는 영향을 모두 확인하는 것이 아니라, 이 선형 근사 기법을 통해 중요 노드를 효율적으로 필터링할 수 있습니다. 이 방식은 복잡한 신경망 구조에서도 계산 효율성을 유지하면서 간접 효과를 평가하는 데 유리합니다.

다만, 선형 근사 기법은 비선형성이 큰 모델 구조에서는 정확도가 떨어질 수 있습니다. 이를 보완하기 위해 통합 기울기를 이용한 보다 정교한 근사 기법을 사용하기도 하므로, 계산 효율성과 정확성 간의 균형을 맞춘 접근이라 볼 수 있습니다.

그럼 이제 SHIFT 방법을 논문에 기반해서 자세하게 설명해줘

SHIFT(Sparse Human-Interpretable Feature Trimming)는 논문에서 제안한 기법으로, 특정 특징이 모델의 예측에 미치는 영향을 조절하여 다운스트림 과제의 성능을 개선하고, 모델이 의도하지 않은 신호에 덜 민감하게 하는 방법입니다. SHIFT의 핵심은 해석 가능한 특징을 선별적으로 제거함으로써 모델의 예측을 원하는 방향으로 조정하는 데 있습니다.

SHIFT 기법을 자세히 설명하면 다음과 같습니다.

1. SHIFT 기법의 필요성

기존의 모델들은 종종 의도하지 않은 신호에 영향을 받아 편향된 예측을 할 수 있습니다. 예를 들어, 성별과 직업을 예측하는 데이터셋에서 성별 정보가 직업 예측에 지나치게 영향을 미치는 경우가 있습니다. SHIFT는 이러한 의도하지 않은 신호를 모델에서 제거하여 더 공정하고 일반화된 예측을 하도록 돕습니다.

2. SHIFT 기법의 주요 단계

SHIFT는 크게 4단계로 구성됩니다:

단계 1: 해석 가능한 특징 회로(Sparse Feature Circuit) 생성

먼저, 주어진 데이터셋과 모델에 대해 스파스 특징 회로(Sparse Feature Circuit)를 생성합니다. 논문에서는 특정 입력 데이터에 대해 각 특징이 모델의 성능에 얼마나 기여하는지를 간접 효과(Indirect Effect)를 통해 평가하고, 기여도가 높은 특징들을 필터링하여 회로를 구성합니다. 이 단계는 SAE(Sparse Autoencoder)를 통해 학습된 특징을 바탕으로 이루어지며, 이 특징들이 모델의 출력에 미치는 간접적인 영향을 평가합니다.

예를 들어, 직업과 성별 데이터에서 모델이 예측하는 직업(label)에 대해 간접 효과가 높은 특징을 선별하여 회로로 구성합니다.

단계 2: 특징의 과제 연관성 판단

회로에 포함된 각 특징을 사람이 직접 판단하여 해당 특징이 주어진 과제에 연관성이 있는지 평가합니다. 이 단계는 사람이 직접 해석하여, 예측 결과에 불필요하게 영향을 줄 수 있는 의도하지 않은 신호(예: 성별)에 민감한 특징을 구별하는 과정입니다. 이를 위해 각 특징이 특정 상황에서 어떻게 활성화되는지 확인하며, 예측에 영향을 미치는 방식이 적절한지 검토합니다.

논문에서는 예를 들어, 성별 편향이 직업 예측에 지나치게 영향을 주는 특징을 분리해내고, 직업 예측과 직접적인 관계가 없는 특징으로 판단한 경우 제거하도록 판단합니다.

단계 3: 불필요한 특징 제거

SHIFT의 핵심적인 부분으로, 사람이 의도하지 않은 신호로 판단한 특징을 모델에서 제거합니다. 이 과정은 해당 특징이 모델 예측에 미치는 영향을 억제하기 위해, 해당 특징을 회로에서 제거하거나 제로-어블레이션(zero-ablation) 방식으로 처리합니다. 제로-어블레이션은 해당 특징의 값들을 0으로 설정하여, 모델이 해당 특징에 의존하지 않도록 합니다.

이 과정을 통해 모델이 불필요한 특징에 민감하게 반응하지 않도록 하고, 의도한 신호만을 기반으로 예측할 수 있게 합니다.

단계 4: 선택적 재학습 (Optional Fine-tuning)

SHIFT 기법을 적용한 후, 모델 성능을 보완하기 위해 선택적으로 재학습(fine-tuning)할 수 있습니다. 특히 제거한 특징이 모델의 성능에 큰 영향을 주는 경우, 재학습을 통해 모델이 필요한 신호에만 반응하도록 조정합니다. 이 과정은 데이터셋 전체에 대해 모델이 다시 적응하도록 하여, SHIFT 과정에서 성능 저하가 발생하지 않도록 합니다.

3. SHIFT 기법의 평가

SHIFT 기법은 논문에서 여러 가지 측면에서 평가되었습니다. 예를 들어, 직업과 성별 예측에서 직업에 대한 예측 성능은 유지하면서 성별 편향을 제거하는 데 성공하였음을 입증했습니다. 또한, SHIFT는 뉴런 기반의 제거 방식보다 더 정교한 결과를 보였으며, 사람의 판단을 기반으로 했을 때 성능이 더 높았음을 보여주었습니다.

4. SHIFT 기법의 장점과 한계

- 장점: SHIFT 기법은 사람의 해석을 통해 불필요한 특징을 제거하여 모델의 편향을 줄이고, 더 공정하고 일반화된 예측을 가능하게 합니다. 또한 해석 가능한 특징을 기반으로 하기 때문에, 모델의 예측 과정을 사람이 이해하고 통제할 수 있다는 이점이 있습니다.

- 한계: 이 기법은 사람이 직접 특징을 해석하고 판단하는 과정이 필요하므로, 대규모 모델이나 복잡한 특징에서는 효율성이 떨어질 수 있습니다. 또한, 사람이 판단을 잘못 내릴 경우 모델 예측의 신뢰성을 저하시킬 위험도 있습니다.

SHIFT 기법은 모델의 해석 가능성과 신뢰성을 높이는 데 중요한 기여를 할 수 있으며, 모델이 불필요한 편향된 신호에 민감하지 않도록 조정하는 효과적인 방법입니다.

그럼 결국 이 논문은 SAE를 활용해서 각각 특징을 뽑아내고, 그 Feature가 영향을 주는 정도를 확인하여 이상한 편향이 조금 포함되어 있다면 그것을 제거하고, 다시 학습하여 정확하고 편견 없는 Feature를 뽑는 것이 목표인가?

네, 정확하게 이해하셨습니다. 이 논문의 핵심 목표는 SAE(Sparse Autoencoder)를 활용하여 언어 모델 내에서 해석 가능한 특징(Feature)을 뽑아내고, 각 특징이 모델의 예측에 얼마나 영향을 미치는지를 확인하여 편향이 있는 특징을 식별하고 제거함으로써 정확하고 편견 없는 모델을 만드는 데 있습니다.

이 논문의 접근을 다시 정리하면 다음과 같습니다:

- 해석 가능한 특징 식별: SAE를 사용하여 모델 내부의 잠재 공간에서 사람도 이해할 수 있는 특징을 학습합니다. 이 과정에서 특징이 보다 해석 가능하도록 구성하여, 모델의 예측을 설명할 수 있는 회로(circuit)를 구성합니다.

- 간접 효과 평가: 각 특징이 모델 예측에 미치는 영향을 간접 효과로 계산하여, 해당 특징이 특정 출력에 얼마나 중요한 역할을 하는지 확인합니다. 이를 통해 모델이 불필요하게 의존하는 신호(편향된 신호)가 있는지를 판단합니다.

- 편향 제거 (SHIFT 기법): 편향된 특징을 확인한 뒤, 해당 특징이 예측에 미치는 영향을 억제하거나 제거합니다. 이로써 모델이 의도하지 않은 편향에 의존하지 않도록 하며, 필요한 경우 재학습을 통해 모델이 주요 신호에 집중할 수 있게 합니다.

- 공정하고 일반화된 모델 구축: 이러한 과정을 통해 모델은 특정 편향에서 자유로운 예측을 하게 되며, 해석 가능한 특징을 기반으로 예측을 수행하게 됩니다.

따라서, 이 논문은 편향 없는 예측을 목표로 하는 해석 가능한 언어 모델을 만드는 것이 핵심입니다. 이를 위해 SAE와 SHIFT 기법을 결합하여 모델 내 특징들을 조절하고, 불필요하거나 편향된 신호가 포함된 특징을 제거해 공정성을 높이려는 것이 이 연구의 중요한 포인트입니다.

그런데 이 것이 모델 출력에 편향을 없도록 하는 것은 아니네?

맞습니다. 이 논문의 접근은 모델 출력에서 편향을 완전히 없애기보다는 모델이 특정 편향된 신호에 덜 의존하도록 돕는 것에 가깝습니다. 즉, 모델이 불필요한 편향된 신호에 덜 민감하게 반응하게 하여 예측 과정에서 이러한 신호가 덜 작용하도록 만드는 것이 목표입니다.

편향 제거의 한계

SHIFT 기법이 모델 출력의 편향을 줄이는 데 기여할 수는 있지만, 다음과 같은 이유로 완벽히 편향을 없애지는 못합니다:

- 편향된 데이터의 존재: 모델이 학습한 데이터 자체에 편향이 있다면, SHIFT 기법을 통해 일부 편향된 특징을 억제하더라도 다른 편향 요소들이 여전히 남아 있을 수 있습니다. SHIFT는 식별된 특정 편향된 신호를 억제할 뿐이지, 모델이 전체 데이터의 편향을 인식하지 않도록 완전히 제어하지는 못합니다.

- 해석 가능한 특징에 한정: SHIFT 기법은 SAE를 통해 학습된, 사람이 해석 가능한 특징에만 적용됩니다. 따라서, 해석이 어려운 잠재적인 편향 요소는 여전히 모델에 남아 있을 가능성이 있습니다. 예를 들어, SAE가 충분히 높은 해석 능력을 제공하지 못한다면 일부 편향이 탐지되지 않고 남아 있을 수 있습니다.

- 주관적 편향 제거: 사람이 직접 특정 특징이 편향되었다고 판단하여 제거하는 과정이 포함되기 때문에, SHIFT 기법의 효과는 사람의 판단에 따라 달라질 수 있습니다. 즉, 사람이 잘못 판단하거나 편향을 충분히 인식하지 못하는 경우 일부 편향이 여전히 모델에 남을 수 있습니다.

결론: 편향 완화와 출력의 공정성 개선

SHIFT와 SAE를 통해 특정 편향된 신호를 식별하고 억제하는 것은 모델 예측 과정에서 편향을 줄이는 효과를 기대할 수는 있지만, 모델의 모든 편향을 완벽하게 제거하는 것은 아닙니다. 이 접근법은 편향이 특정 신호에 덜 의존하도록 돕는 데 중점을 두고 있으며, 그 결과로 모델 출력의 공정성을 개선할 수는 있지만 모든 종류의 편향을 완전히 없애지는 못한다는 한계가 있습니다.