https://openreview.net/forum?id=vc1i3a4O99

Interpreting and Steering LLM Representations with Mutual...

Large language models (LLMs) excel at addressing general human queries, yet they can falter or produce unexpected responses in specific scenarios. Gaining insight into the internal states of LLMs...

openreview.net

여태가지 다 해봤던 내용인 것 같아서 크게 특별한 것이 안보이네요

1. 학습한다!

2. 이 뉴런이 어떤 단어,토큰에 강하게 반응하는지 찾는다

3. 뉴런을 강화, 혹은 약화하여 출력을 변경한다.

제가 이전에 튜토리얼에서 진행했던 것과 동일하게 진행하네요

문제 해결 목표:

대형 언어 모델(LLM)은 일반적인 인간의 요청에 효과적으로 대응하지만, 특정 상황에서 실패하거나 예상치 못한 응답을 생성할 수 있습니다. 이 논문은 이러한 LLM의 내부 상태를 이해하고, 그 성공과 실패 요인을 분석하여 모델의 성능을 개선하려는 목표를 가지고 있습니다. 특히, Sparse Autoencoder를 사용하여 LLM의 숨겨진 공간을 해석하는 방법을 탐구하고, LLM의 행동을 제어하려고 했습니다.

시도한 방법:

기존 Sparse Autoencoder는 다중의 의미를 가진 폴리세만틱(polysemantic)한 특성 때문에 해석하기 어려웠습니다. 논문에서는 이 문제를 해결하기 위해 Sparse Autoencoder로 학습된 특징을 설명할 수 있는 새로운 방법을 제안했습니다. 기존 방식들이 언어적 패턴에 너무 치우쳐 실제 의미를 잘 설명하지 못하는 문제를 해결하기 위해, 고정된 어휘 집합을 사용해 학습된 특징을 설명하고, 상호 정보량(Mutual Information) 이론에 기반한 설명 목표를 도입했습니다.

사용된 방법:

- Sparse Autoencoder 사용: Top-K Sparse Autoencoder를 사용하여 LLM의 토큰 수준 표현을 재구성할 수 있는 희소한 특징을 학습했습니다. 이러한 특징은 해석 가능하도록 설계되었습니다.

- 상호 정보량 기반 설명 기법: 학습된 특징이 언어적 패턴보다 더 의미 있는 담론 수준의 주제를 설명할 수 있도록 상호 정보량을 사용해 특징을 설명했습니다. 구체적으로는, 고정된 어휘 집합을 기반으로 학습된 특징과 어휘 간의 상호 정보를 극대화하여 특징의 의미를 도출했습니다.

- LLM 제어: 학습된 특징을 이용하여 LLM의 행동을 제어하는 두 가지 방법을 제안했습니다.

- 증폭(Amplification): 특정 특징을 활성화하여 LLM의 반응을 강화하거나 억제하는 방식.

- 보정(Calibration): 특정 특징을 강조하여 LLM이 그 특징을 더 신경 쓰도록 하는 방식.

결과:

실험 결과, 제안된 방법이 기존 설명 방식보다 더 담론 수준의 설명을 생성했으며, LLM의 동작을 효과적으로 제어할 수 있음을 보여주었습니다. 특히, 제안된 방법을 사용하면 실세계에서 발생하는 "Jailbreak" 공격(LLM이 원치 않는 방식으로 동작하는 공격)을 방어하는 데 성공적으로 활용될 수 있었습니다. 또한, 실험에서 제안된 방법이 안전성을 강화하면서도 일반적인 쿼리에 대한 응답 성능에 큰 손실을 주지 않았다는 것을 확인했습니다.

한계점:

- 상호 정보량 기반 설명 방법이 일부 특징에서는 여전히 해석 가능한 수준의 설명을 제공하지 못할 수 있다는 점이 한계로 지적되었습니다.

- Sparse Autoencoder가 담론 수준의 주제뿐만 아니라 언어적 패턴도 학습하는 경향이 있으며, 이는 특정 응용에 대한 설명력에 한계를 줄 수 있습니다.

- 모델의 행동을 제어하는 과정에서 모든 상황에서 동일한 성능을 보장하지 못할 수 있습니다.

이 논문을 통해, 향후 인공지능 해석 연구에서 Sparse Autoencoder와 상호 정보량을 기반으로 한 특징 해석 방법이 유용하게 활용될 수 있음을 시사합니다.

여기서 사용된 방법에 대해 논문을 기반으로 더 설명해줘

어떻게 증폭하고 보정하였는지, 상호 정보량 기반 설명 기법이 무엇인지

1. 증폭(Amplification)과 보정(Calibration)

Sparse Autoencoder를 통해 학습된 희소한 특징을 기반으로 LLM의 행동을 제어하는 두 가지 주요 전략이 제안되었습니다: 증폭과 보정.

증폭(Amplification)

증폭 방법은 LLM의 특정 행동이나 특징을 더 강조하거나 약화시키는 방식입니다. 학습된 특징 벡터들 중 특정 특징이 특정 LLM 행동에 연관된 경우, 그 특징을 활성화하거나 비활성화하는 방식으로 LLM의 반응을 제어합니다. 증폭의 공식은 다음과 같습니다:

- X′=X+α⋅ReLU(XS)S^T

여기서, X는 LLM의 입력에 대한 숨겨진 표현이고, S는 특정 행동과 관련된 학습된 특징들의 행렬입니다. α는 증폭의 정도를 결정하는 하이퍼파라미터입니다. 예를 들어, α>0일 때는 해당 특징을 증폭시키고, α<0일 때는 그 특징을 억제합니다. 특히 α=−1일 경우, 해당 특징을 완전히 비활성화하여 LLM이 그 특징을 인지하지 못하게 할 수 있습니다.

보정(Calibration)

보정 방법은 LLM이 특정 특징을 보다 신경 쓰도록 강제하는 방식입니다. 이는 LLM의 숨겨진 표현을 특정 특징 벡터의 중심으로 이동시키는 방식으로 이루어집니다. 보정의 공식은 다음과 같습니다:

- X′=X−ReLU(XS)ST+β⋅s‾

여기서 s‾-는 선택된 특징 집합의 평균 벡터이며, β-는 LLM이 해당 특징을 얼마나 강조할지를 결정하는 하이퍼파라미터입니다. 이 방법을 통해 LLM이 특정 특징을 더 많이 고려하도록 유도할 수 있습니다.

2. 상호 정보량 기반 설명 기법

이 기법의 목표는 Sparse Autoencoder로 학습된 특징들의 의미를 자연어로 설명하는 것입니다. 이때 상호 정보량(Mutual Information)을 사용하여 각 특징이 의미하는 바를 설명합니다.

상호 정보량 기반 설명 기법의 과정

기존의 특징 해석 방법들은 학습된 특징 벡터와 최대한 활성화되는 단어들을 나열하는 방식으로 특징을 설명하려 했으나, 이는 종종 언어적 패턴에 치우쳐 담론 수준의 중요한 의미를 놓치곤 했습니다. 이를 해결하기 위해, 논문에서는 상호 정보량을 사용해 다음과 같은 방식으로 특징을 설명했습니다:

- 고정된 어휘 집합 사용: 특징 설명을 위해 고정된 어휘 집합을 사용합니다. 이는 특징 벡터와 어휘 간의 상호 정보량을 측정하여, 특정 특징이 해당 어휘와 얼마나 연관이 있는지를 계산합니다. 이를 통해 특징 벡터가 단순히 언어적 패턴이 아닌, 담론 수준의 주제를 더 잘 설명할 수 있게 합니다.

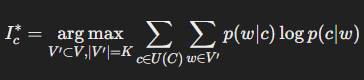

- 상호 정보량 공식:

- 상호 정보량 기반의 설명 목표는 다음과 같이 정의됩니다:

상호 정보량 기반 기법의 장점:

- 상호 정보량을 사용함으로써 자주 등장하는 언어적 패턴에 집중하는 기존 방식의 한계를 극복하고, 담론 수준에서 더 중요한 의미를 포착할 수 있게 합니다.

- 학습된 특징이 단순한 텍스트 패턴이 아닌, 실제로 중요한 주제나 개념을 설명할 수 있도록 돕습니다.

이와 같은 방법을 통해, 논문에서는 Sparse Autoencoder로 학습된 특징을 더 잘 해석하고, 이를 LLM의 행동을 제어하는 데 효과적으로 활용할 수 있음을 보여주었습니다

그럼 상호 정보량 기반 설명 방법을 좀 더 자세하고 예시를 들어 설명해줘

상호 정보량(Mutual Information, MI) 기반 설명 방법은 Sparse Autoencoder로 학습된 특징들이 어떤 의미를 가지는지 해석하는데 중요한 역할을 합니다. 이 기법은 특징 벡터와 어휘 사이의 상호 정보를 측정하여, 학습된 특징이 담고 있는 의미를 구체적으로 자연어로 설명하는 방식입니다.

이를 더 자세히 설명하고 예시를 들어 이해를 돕겠습니다.

1. 상호 정보량이란 무엇인가?

상호 정보량(MI)은 두 변수가 서로 얼마나 의존하는지를 나타내는 척도입니다. 즉, 하나의 변수(여기서는 특징 벡터)가 다른 변수(여기서는 단어)의 정보를 얼마나 잘 설명할 수 있는지를 수량화하는 것입니다.

공식적으로 상호 정보량은 다음과 같이 정의됩니다:

여기서 p(x,y)는 두 변수 X와 Y가 동시에 발생할 확률을 나타내며, p(x)와 p(y)는 각각의 변수에 대한 주변 확률을 나타냅니다.

2. 상호 정보량 기반 설명 방법의 동작 원리

Sparse Autoencoder로 학습된 각 특징 벡터는 해당 벡터가 활성화될 때 어떤 단어들이 함께 자주 등장하는지를 바탕으로 해석할 수 있습니다. 하지만, 단순히 자주 등장하는 단어만으로는 해당 특징이 무엇을 설명하는지 알기 어렵습니다. 예를 들어, 빈번히 등장하는 단어들이 항상 중요한 의미를 담고 있지 않을 수 있습니다. 이를 극복하기 위해 상호 정보량을 사용하여 각 특징 벡터가 의미하는 바를 더 구체적으로 해석합니다.

과정은 다음과 같습니다:

- 단어와 특징 벡터의 관계 측정: 각 특징 벡터 Wc가 어떤 단어 집합을 잘 설명할 수 있는지를 상호 정보량을 통해 측정합니다. 이는 해당 특징 벡터가 특정 단어를 얼마나 잘 설명하는지를 보여주는 척도입니다. 예를 들어, 특정 벡터가 "감정", "행동", "경험"이라는 단어들을 자주 활성화시키는 경우, 이 벡터는 "심리 상태"에 관련된 내용을 설명한다고 해석될 수 있습니다.

- 어휘 집합 선택: 고정된 어휘 집합 V에서 각 특징 벡터 Wc가 설명할 수 있는 최적의 단어 집합 Ic를 찾습니다. 이 단어 집합은 상호 정보량 I(C;V′)을 최대화하는 단어들로 구성됩니다.

- 단어 임베딩 사용: 각 단어와 특징 벡터 간의 연관성을 계산하기 위해 단어 임베딩을 사용합니다. 구체적으로, 단어 임베딩 ew와 특징 벡터 Wc 간의 내적을 통해 두 벡터의 유사성을 측정하여 p(w∣c)와 p(c∣w)를 계산합니다.

3. 상호 정보량 기반 설명 예시

예를 들어, 특정 Sparse Autoencoder의 특징 벡터 W1이 "감정", "우울", "행복", "기쁨" 등의 단어들과 자주 연관이 있다고 가정해봅시다. 이 경우 상호 정보량을 통해 W1 벡터가 "심리 상태"라는 주제를 잘 설명한다는 결론을 도출할 수 있습니다.

- 특징 벡터 W1의 활성화는 주로 감정과 관련된 단어들과 관련이 있으므로, 이 특징 벡터는 "감정 상태"라는 의미를 설명하는 것으로 해석할 수 있습니다.

- 상호 정보량을 계산해보면, W1 벡터와 감정 관련 단어들 사이의 상호 정보량이 높을 경우, 이 벡터는 감정 상태와 관련된 주제를 담고 있다고 설명할 수 있습니다.

- 이렇게 상호 정보량을 통해 학습된 특징을 구체적으로 설명하게 되면, 해당 특징이 특정 주제에 맞게 LLM이 어떻게 동작하는지 제어할 수 있는 기초가 됩니다. 예를 들어, "행복"이라는 단어를 강조하고 싶을 때는 해당 벡터의 활성화를 증폭시키는 방식으로 LLM의 출력을 조정할 수 있습니다.

4. 상호 정보량 기반 설명의 이점

- 빈도 편향 해결: 단순히 자주 등장하는 패턴이나 단어에만 의존하지 않고, 실제로 중요한 의미를 지닌 단어들을 학습된 특징과 연결합니다.

- 설명력 향상: LLM의 특징 벡터가 단순한 텍스트 패턴에만 의존하는 것을 피하고, 담론 수준에서 더 중요한 주제나 개념을 설명할 수 있게 합니다.

이 상호 정보량 기반 설명 기법은 특징 벡터의 해석 가능성을 높이고, LLM의 동작을 더 효율적으로 제어할 수 있는 강력한 도구로 작용합니다

아 그럼 여기서 논문이 진행하는 방법이 1. 학습 2. 뉴런이 어떤 단어에 반응하는지 찾기 3. 그 뉴런을 강화하거나 약화하여 출력에 변화를 주는 것이네?

네, 정확합니다! 논문에서 진행하는 방법을 요약하면 다음과 같은 순서로 이루어집니다:

1. 학습 (Sparse Autoencoder 학습)

먼저 Sparse Autoencoder를 이용하여 LLM의 숨겨진 공간에서 특징 벡터를 학습합니다. Sparse Autoencoder는 LLM이 각 입력 텍스트에 대해 희소한 (sparse) 특징을 활성화하도록 학습됩니다. 즉, 텍스트 데이터의 중요한 요소들을 추출해내는 역할을 하며, 이 과정에서 각 특징 벡터가 특정 단어, 주제, 혹은 개념과 관련된 정보를 내포하게 됩니다.

2. 뉴런이 어떤 단어에 반응하는지 찾기

학습된 특징 벡터들(뉴런들)이 어떤 단어들에 반응하는지 확인합니다. 여기서 중요한 것은 단순히 자주 등장하는 단어들을 찾는 것이 아니라, 상호 정보량(Mutual Information)을 사용하여 각 특징 벡터가 어떤 단어들에 특히 강하게 반응하는지를 계산합니다. 이렇게 함으로써 각 특징 벡터가 특정 주제나 개념과 어떻게 연결되어 있는지 파악합니다.

예를 들어, 어떤 뉴런이 "행복", "기쁨", "감정" 같은 단어에 주로 반응한다면, 이 뉴런은 "감정 상태"에 대한 정보를 담고 있다고 해석할 수 있습니다. 이 과정에서 고정된 어휘 집합을 사용하여 상호 정보량 기반으로 어떤 단어가 해당 뉴런과 가장 관련성이 높은지 찾습니다.

3. 뉴런을 강화하거나 약화하여 출력에 변화를 주기

이제 학습된 뉴런(특징 벡터)의 활성화를 강화(Amplification)하거나 약화(Calibration)하여, LLM의 출력을 조정할 수 있습니다.

- 강화(Amplification): 특정 뉴런이 활성화될 때 그 반응을 증폭시킴으로써 LLM이 해당 개념을 더 많이 반영하도록 할 수 있습니다. 예를 들어, "안전성"과 관련된 뉴런을 강화하면, LLM은 답변에서 더 안전한 내용을 생성하게 됩니다.

- 약화(Calibration): 특정 뉴런의 반응을 억제하여 해당 개념이 출력에 반영되지 않도록 할 수 있습니다. 예를 들어, "유해한 정보"를 포함하는 뉴런을 약화시키면, LLM이 그러한 내용을 포함하지 않게 출력할 수 있습니다.

이러한 제어 과정을 통해, 모델의 출력에 실시간으로 변화를 줄 수 있습니다. 예를 들어, 특정 단어 또는 주제에 대해 LLM의 반응을 제어하거나, 유해한 정보를 포함하지 않도록 조정할 수 있는 기능을 제공하게 됩니다.

핵심 포인트:

- Sparse Autoencoder로 뉴런(특징 벡터)을 학습.

- 각 뉴런이 어떤 단어에 반응하는지 상호 정보량을 통해 분석.

- 뉴런의 활성화를 조절하여, LLM의 출력을 강화하거나 약화시킴으로써 모델의 행동을 제어.

이 방법을 통해 LLM을 더 잘 해석하고, 특정 시나리오에 맞게 출력을 조정하는 능력이 강화됩니다