https://arxiv.org/abs/2402.07197

GraphTranslator: Aligning Graph Model to Large Language Model for Open-ended Tasks

Large language models (LLMs) like ChatGPT, exhibit powerful zero-shot and instruction-following capabilities, have catalyzed a revolutionary transformation across diverse fields, especially for open-ended tasks. While the idea is less explored in the graph

arxiv.org

LLM의 발달로 open-ended(정답이 정해져있지 않은)작업을 잘 처리하게 되었다.

그래프도 LLM과 같이 open-ended task도 잘 해야하고 발전해야한다.!

GM 강화로 LLM을 사용한 경우 pre-difined task는 잘하지만 open-ended task를 잘 못하고, 설명성이 부족하다.

그래프의 노드와 엣지를 텍스트화 해서 LLM에 넣어봤다. - open-ended task를 잘하지만 높은 비용과 할루시네이션 문제가 있다,

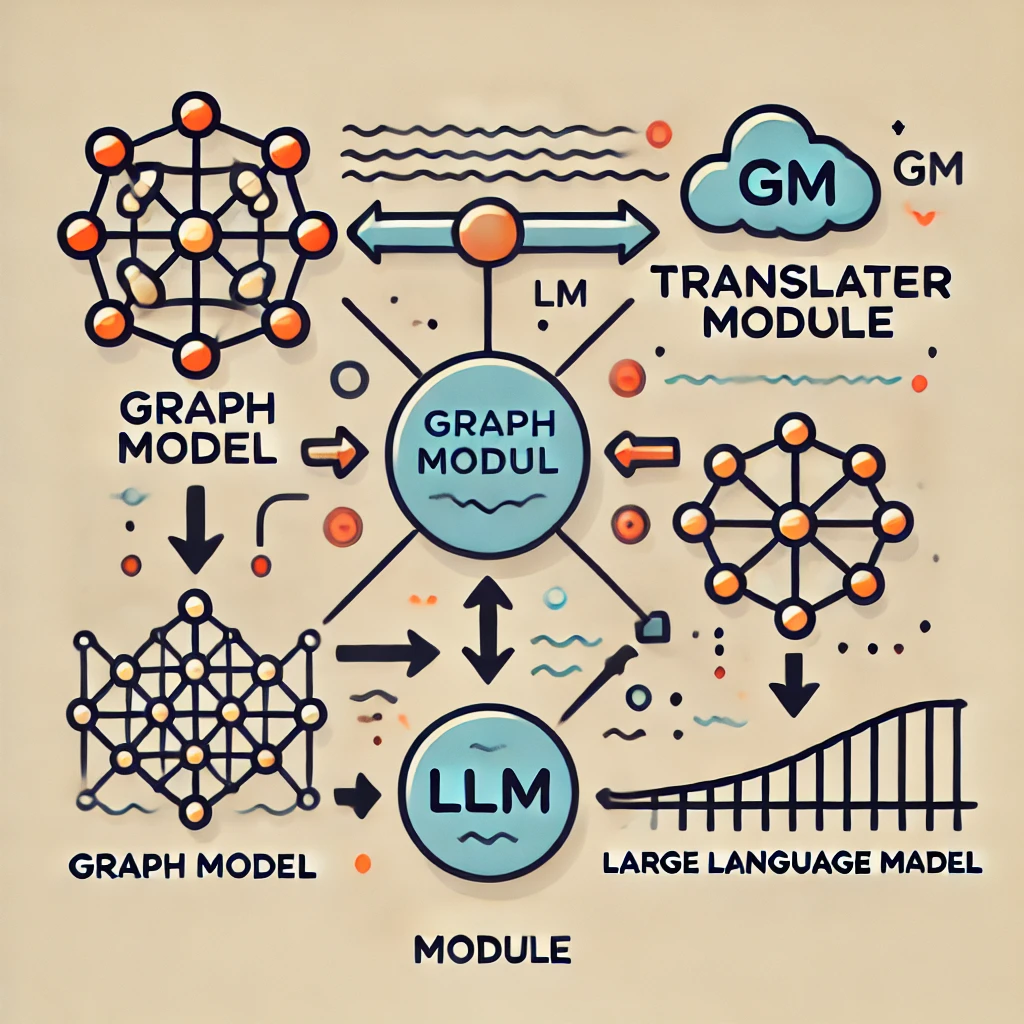

GM이 pre-trained task처리하고, 출력을 Translator을 통해 LLM에 집어 넣는다. - open-ended task를 해결할 수 있지만 할루시네이션 문제가 있고, 높은 코스트를 가져온다.

=> GM을 pretrained하여 LLM에 연결하여 GM은 pre-difined작업을 해결하고, LLM은 사용자와 GM간의 정보의 전달을 담당하여 필요한 작업에 대한 GM의 결과를 LLM이 해석하여 사용자에게 전달해준다.

문제

- LLM은 토큰을 통해 사람이 사용하는 자연어를 이해한다. GM은 임베딩 데이터를 사용하여 출력 데이터가 맞지 않는다.

- 두 모델을 연결하기 위한 데이터가 없다.

해결

- Translator

- LLM을 통해 생산한다.

Graph Translator - GM의 임베딩을 LLM이 이해할 수 있도록 토큰으로 변환해준다.

이 이미지는 GraphTranslator라는 모델의 구조와 훈련 과정을 보여줍니다. 주요 구성 요소와 단계를 순서대로 설명하겠습니다:

- Frozen Graph Model (동결된 그래프 모델):

- 그래프 데이터를 처리하고 노드 임베딩(zᵥ)을 생성합니다.

- Producer (생성기):

- LLM (Large Language Model, 대규모 언어 모델)을 사용하여 노드 정보, 이웃 정보, 공통점에 대한 텍스트 설명(tᵥ)을 생성합니다.

- Translator (번역기):

- Query Tokens (쿼리 토큰, Q)와 Description Tokens (설명 토큰)을 입력받습니다.

- Shared Self-Attention (공유 자기 주의) 레이어를 통해 정보를 처리합니다.

- Cross Attention (교차 주의) 레이어를 사용하여 쿼리와 설명 간의 관계를 모델링합니다.

- 최종적으로 Hᵥ와 Tᵥ를 생성하여 Stage 1 Loss (1단계 손실)를 계산합니다.

- Frozen LLM (동결된 대규모 언어 모델):

- Translator의 출력을 받아 Projection (투영) 레이어를 통해 처리합니다.

- 주어진 Instruction (지시)에 따라 Language Response (언어 응답)을 생성합니다.

- Training Phases (훈련 단계):

- Stage 1 Training Phase (1단계 훈련 단계): Translator만 훈련됩니다.

- Stage 2 Training Phase (2단계 훈련 단계): Translator이 훈련됩니다.

- Inference Phase (추론 단계):

- 훈련된 Translator가 그래프 임베딩(zᵥ)을 처리합니다.

- LLM이 주어진 Instructions (지시)에 따라 Responses (응답)을 생성합니다.

주요 특징:

- Frozen (동결된) 컴포넌트는 훈련 중 가중치가 업데이트되지 않습니다.

- Trainable (훈련 가능한) 컴포넌트는 최적화 과정에서 가중치가 조정됩니다.

- 이 모델은 그래프 데이터를 텍스트로 변환하고, 이를 LLM과 연결하여 다양한 작업을 수행할 수 있게 합니다.

LLM = ChatGLM - 이중 국어 모델(중, 영)로 frozen하여 매개변수를 훈련시키지 않고, Autogressive blank infilling task로 사전학습되었다.

결국 여기선

Frozen Graph Model

Producer - 그래프의 노드 정보, 이웃 정보, 모델 정보를 말해준다.

Translator - 그래프의 임베딩을 LLM의 토큰으로 바꿔줌

Frozen LLM

이 사용된다.

학습

- GM - LLM 정렬을 위한 학습

네, 이 논문의 학습 과정을 단계별로 설명해드리겠습니다. 이 모델은 그래프 모델(GM)과 대규모 언어 모델(LLM)을 연결하는 Translator 모듈을 학습시키는 과정을 설명하고 있습니다.

- 전체 학습 과정 개요:

- 두 단계로 나누어 학습을 진행합니다.

- 첫 번째 단계: GM과 텍스트 간의 정렬(alignment)을 학습합니다.

- 두 번째 단계: GM과 LLM 간의 정렬을 학습합니다.

- 첫 번째 단계: GM-텍스트 정렬 학습

a) 목표: 노드 임베딩(zᵥ)에서 텍스트 설명(tᵥ)과 가장 관련 있는 정보를 추출하는 Hᵥ를 생성합니다.- 대조 목적 함수(Contrastive objective):

• Hᵥ와 tᵥ의 [CLS] 토큰 임베딩 간의 상호 정보를 최대화합니다.

• 긍정적 쌍의 유사도를 높이고 부정적 쌍의 유사도를 낮춥니다. - 생성 목적 함수(Generative objective):

• 주어진 zᵥ를 기반으로 텍스트를 생성하도록 학습합니다.

• 쿼리 토큰 Q를 사용하여 zᵥ의 중요 정보를 추출합니다.

• 생성된 텍스트와 실제 설명 tᵥ 간의 교차 엔트로피 손실을 최소화합니다. - 매칭 목적 함수(Matching objective):

• Hᵥ의 각 토큰과 Tᵥ의 [CLS] 토큰 간의 세밀한 정렬을 학습합니다.

• 이진 분류기를 사용하여 매칭 점수를 계산합니다.

- 대조 목적 함수(Contrastive objective):

- b) 세 가지 목적 함수를 동시에 최적화합니다:

- 두 번째 단계: GM-LLM 정렬 학습

a) 목표: Translator의 출력을 LLM이 이해할 수 있는 형태로 변환합니다.- Translator의 출력 Hᵥ를 LLM의 단어 임베딩 차원과 동일하게 투영합니다.

- 투영된 임베딩을 소프트 프롬프트로 사용하여 사용자 지시사항과 연결합니다.

- 이를 LLM의 입력으로 사용하여 생성 학습을 수행합니다.

- Translator의 매개변수를 조정하여 노드 임베딩 zᵥ가 LLM의 단어 임베딩과 정렬되도록 합니다.

- b) 과정:

- 주요 포인트:

- 사전 학습된 노드 표현은 고정(frozen)된 상태로 유지합니다.

- Translator 모듈만 학습됩니다.

- 첫 번째 단계에서는 그래프 정보와 텍스트 정보 간의 연결을 학습합니다.

- 두 번째 단계에서는 그래프 정보를 LLM이 이해할 수 있는 형태로 변환하는 방법을 학습합니다.

이 학습 과정을 통해 모델은 그래프 데이터의 구조적 정보를 텍스트 형태로 변환하고, 이를 LLM이 이해하고 활용할 수 있는 형태로 만듭니다. 이는 그래프 기반 작업과 자연어 처리 작업을 통합하는 데 중요한 역할을 합니다.

논문 요약: GraphTranslator: Aligning Graph Model to Large Language Model for Open-ended Tasks

핵심 아이디어:

- GraphTranslator는 그래프 모델(GM)과 대형 언어 모델(LLM)을 연결하여 미리 정의된 작업과 개방형 작업을 동시에 처리하는 새로운 프레임워크를 제안합니다.

- GM은 미리 정의된 작업(예: 노드 분류)을 효율적으로 처리하고, LLM은 자연어 명령을 기반으로 다양한 개방형 작업을 처리합니다.

중요한 점:

- GraphTranslator는 노드 임베딩을 토큰으로 변환하여 LLM이 언어 지시를 기반으로 예측을 수행할 수 있도록 합니다.

- Producer 모듈을 통해 노드 정보, 이웃 정보 및 모델 정보를 포함한 그래프-텍스트 정렬 데이터를 생성합니다.

해결된 문제:

- 기존의 그래프 모델은 미리 정의된 작업에 제한되며 새로운 범주나 개념에 일반화하는 데 어려움을 겪었습니다.

- LLM을 그래프에 적용하는 기존 방법은 미리 정의된 작업과 개방형 작업을 동시에 처리하지 못했습니다.

기존 방식에서 개선된 점:

- GraphTranslator는 GM과 LLM을 Translator 모듈로 연결하여, GM이 미리 정의된 작업을 처리하는 동안 LLM은 개방형 작업을 지원하도록 합니다.

- Producer 모듈을 통해 노드 임베딩과 텍스트 설명을 생성하여 GM과 LLM 간의 모달리티 간극을 해소합니다.

결과:

- 실험 결과, GraphTranslator는 제로샷 노드 분류에서 높은 성능을 보여줍니다.

- 그래프 질문 응답 실험은 GraphTranslator가 언어 지시를 기반으로 한 다양한 개방형 작업에서 뛰어난 잠재력을 가지고 있음을 나타냅니다.

한계점:

- Producer의 품질이 Translator 모델의 전반적인 품질을 결정짓는 중요한 역할을 합니다.

- 현재는 ChatGLM2-6B를 사용하여 설명을 생성했지만, 더 큰 LLM을 사용하여 텍스트 설명의 품질을 향상시킬 필요가 있습니다.

- 개방형 작업에서 모델의 능력을 완전히 평가하기 위해서는 평가 데이터셋과 적절한 평가 메트릭스가 필요합니다.

중요 아이디어:

- Translator 모듈을 통해 노드 임베딩을 토큰 임베딩 공간으로 변환하여 GM과 LLM을 연결합니다.

- LLM의 강력한 텍스트 생성 능력을 활용하여 GM의 임베딩 정보를 텍스트로 변환합니다.

- GM이 미리 정의된 작업을 효율적으로 처리하고, LLM은 개방형 작업을 처리하여 상호작용성과 해석 가능성을 제공합니다.

이 논문은 그래프 모델과 대형 언어 모델을 효과적으로 결합하여 다양한 작업을 처리할 수 있는 새로운 방법을 제안하며, 이를 통해 실질적인 산업 환경에서의 적용 가능성을 높입니다.

그래프의 사용

그래프는 소셜 미디어와 전자상거래 분야에서 복잡한 관계와 상호작용을 모델링하는 데 매우 유용하게 사용됩니다. 이 분야에서 그래프의 활용을 구체적으로 설명해드리겠습니다:

- 소셜 미디어에서의 그래프 사용:

- 사용자 네트워크 모델링: 각 사용자를 노드로, 친구 관계를 엣지로 표현합니다.

- 콘텐츠 전파 분석: 게시물이나 정보의 확산을 그래프로 표현하여 추적합니다.

- 영향력 분석: 네트워크 내에서 가장 영향력 있는 사용자를 식별합니다.

- 커뮤니티 탐지: 유사한 관심사를 가진 사용자 그룹을 찾아냅니다.

- 전자상거래에서의 그래프 사용:

- 제품 추천 시스템: 사용자-제품 상호작용을 그래프로 모델링하여 개인화된 추천을 제공합니다.

- 고객 세분화: 구매 패턴과 행동을 기반으로 고객 그룹을 식별합니다.

- 사기 탐지: 비정상적인 거래 패턴을 그래프로 표현하여 감지합니다.

- 공급망 최적화: 제품, 공급업체, 물류 센터 간의 관계를 그래프로 모델링합니다.

- 텍스트 속성의 활용:

- 소셜 미디어 게시물 내용, 제품 리뷰, 사용자 프로필 등의 텍스트 정보를 노드나 엣지의 속성으로 포함시킵니다.

- 이를 통해 감성 분석, 토픽 모델링, 콘텐츠 기반 추천 등 더 풍부한 분석이 가능해집니다.

- 실시간 데이터 처리:

- 그래프 구조를 사용하여 빠르게 변화하는 소셜 미디어나 전자상거래 데이터를 효율적으로 처리하고 업데이트할 수 있습니다.

- 복잡한 쿼리 처리:

- 그래프 데이터베이스를 사용하여 복잡한 관계 기반 쿼리를 빠르게 처리할 수 있습니다.

이러한 방식으로 그래프는 소셜 미디어와 전자상거래 플랫폼에서 데이터의 구조화, 분석, 의사결정 지원 등 다양한 목적으로 활용됩니다. 그래프의 유연성과 확장성은 이러한 동적이고 복잡한 환경에서 특히 유용합니다.

Pre-defined?

이 맥락에서 "pre-defined"의 의미를 설명해드리겠습니다:

- Pre-defined의 기본 의미:

- "미리 정의된" 또는 "사전에 정의된"이라는 뜻입니다.

- 즉, 시스템이나 모델을 설계할 때 미리 정해놓은 특정 작업이나 기능을 말합니다.

- 그래프 모델에서의 pre-defined 작업:

- 노드 분류, 링크 예측, 그래프 분류 등과 같이 그래프 분석에서 일반적으로 수행되는 표준화된 작업들을 의미합니다.

- 이러한 작업들은 모델 개발 시점에 명확하게 정의되고, 특정한 입력과 출력 형식을 가집니다.

- Pre-defined 작업의 특징:

- 구조화된 입력과 출력: 입력 데이터의 형식과 예상되는 출력 결과가 명확히 정의되어 있습니다.

- 평가 메트릭스의 존재: 이러한 작업의 성능을 측정할 수 있는 표준화된 평가 방법이 있습니다.

- 최적화된 알고리즘: 이러한 작업을 위해 특별히 설계되고 최적화된 알고리즘이 존재합니다.

- Pre-defined 작업 vs 개방형 작업:

- Pre-defined 작업은 융통성이 제한적이지만, 특정 목적에 대해 높은 정확도와 효율성을 제공합니다.

- 반면, 개방형 작업은 사용자의 다양한 요구에 유연하게 대응할 수 있지만, 정확도나 효율성 면에서 challenges가 있을 수 있습니다.

- 산업 시나리오에서의 딜레마:

- 논문에서는 pre-defined 작업에 최적화된 방법과 개방형 작업을 처리할 수 있는 방법 사이의 trade-off를 지적하고 있습니다.

- Pre-defined 작업에 특화된 방법은 정확도는 높지만 유연성이 부족하고, 반대로 개방형 작업을 위한 방법은 유연하지만 비용이 높거나 정확도가 떨어질 수 있습니다.

결론적으로, "pre-defined"는 모델이나 시스템이 처리하도록 미리 설계된 특정 작업을 의미하며, 이는 개방형이고 유연한 작업과 대비됩니다. 논문은 이 두 접근 방식의 장단점을 균형있게 활용하는 방법을 모색하고 있습니다.

LLM이 GM의 인터페이스?

이 문장에서 "LLM이 GM의 인터페이스가 된다"는 개념을 설명해드리겠습니다:

- GM (Graph Model)의 역할:

- GM은 그래프 데이터를 처리하고 미리 정의된(pre-defined) 작업을 수행하는 데 특화되어 있습니다.

- 예를 들어, 노드 분류, 링크 예측 등의 작업을 효율적으로 수행합니다.

- LLM (Large Language Model)의 역할:

- LLM은 자연어 처리 능력이 뛰어나고, 다양한 형태의 질문에 답변할 수 있습니다.

- 여기서 LLM은 GM과 사용자 사이의 '인터페이스' 역할을 합니다.

- LLM이 GM의 인터페이스가 된다는 의미:

- 사용자와의 상호작용: LLM이 사용자의 자연어 질문이나 요청을 받아들입니다.

- 질문 해석: LLM이 사용자의 요청을 이해하고 해석합니다.

- GM 활용: LLM이 필요한 정보나 작업을 GM에 요청합니다.

- 결과 해석 및 전달: GM의 출력을 LLM이 해석하고, 사용자가 이해할 수 있는 형태로 변환하여 응답합니다.

- 개방형 작업 지원:

- 이러한 구조를 통해 미리 정의되지 않은 다양한 개방형 작업을 수행할 수 있게 됩니다.

- 사용자는 자연어로 복잡한 질문을 할 수 있고, LLM은 이를 해석하여 GM의 능력을 활용해 답변을 생성합니다.

- 예시:

- 사용자: "이 소셜 네트워크에서 가장 영향력 있는 사용자는 누구인가요?"

- LLM: 이 질문을 해석하고, GM에게 중심성 분석을 요청합니다.

- GM: 중심성 분석을 수행하고 결과를 LLM에 전달합니다.

- LLM: GM의 결과를 바탕으로 사용자에게 이해하기 쉬운 답변을 생성합니다.

- 장점:

- 유연성: 미리 정의되지 않은 다양한 질문에 대응할 수 있습니다.

- 해석 가능성: 복잡한 그래프 분석 결과를 이해하기 쉽게 설명할 수 있습니다.

- GM의 효율성 유지: 복잡한 그래프 연산은 여전히 효율적인 GM이 처리합니다.

결론적으로, LLM이 GM의 인터페이스가 된다는 것은 LLM이 사용자와 GM 사이의 중개자 역할을 하며, 사용자 친화적인 방식으로 그래프 분석 기능을 제공한다는 의미입니다.

TAG, 표현 학습이란

네, TAG와 표현 학습에 대해 설명해 드리겠습니다.

- TAG (Text-Attributed Graphs, 텍스트 속성 그래프):

- 정의: TAG는 노드가 텍스트 엔티티를 나타내고, 엣지가 이들 간의 관계를 나타내는 그래프입니다.

- 노드의 예: 문서, 문장, 단어 등의 텍스트 단위

- 엣지의 예: 문서 간 유사성, 문장 간 의미적 관계, 인용 관계 등

- 특징: 각 노드는 텍스트 정보를 속성으로 가지고 있어, 그래프 구조와 텍스트 내용을 동시에 활용할 수 있습니다.

- 표현 학습 (Representation Learning):

- 정의: 데이터의 원시 형태에서 유용한 정보를 자동으로 발견하여 더 나은 형태로 변환하는 기계학습 기법입니다.

- 목적: 복잡한 데이터를 더 간결하고 의미 있는 형태로 변환하여 다양한 작업에 활용할 수 있게 합니다.

- TAG에서의 적용:

- 노드의 텍스트 내용과 그래프 구조를 동시에 고려하여 각 노드를 벡터 형태로 표현합니다.

- 이렇게 생성된 벡터는 노드의 의미와 그래프 내 위치 정보를 모두 포함하게 됩니다.

- TAG에서의 표현 학습의 중요성:

- 텍스트와 구조 정보의 통합: 텍스트 내용과 노드 간 관계를 함께 고려하여 더 풍부한 정보를 표현할 수 있습니다.

- 다양한 응용: 텍스트 분류, 가짜 뉴스 탐지 등 여러 분야에 적용될 수 있습니다.

- 성능 향상: 텍스트만 사용하거나 그래프 구조만 사용하는 것보다 더 나은 성능을 제공할 수 있습니다.

- 응용 예시:

- 텍스트 분류: 문서 노드의 벡터 표현을 사용하여 주제별로 분류합니다.

- 가짜 뉴스 탐지: 뉴스 기사 간의 관계와 내용을 동시에 분석하여 신뢰성을 평가합니다.

- 추천 시스템: 사용자와 아이템 간의 관계를 그래프로 모델링하고, 텍스트 리뷰 정보를 활용하여 더 정확한 추천을 제공합니다.

TAG에서의 표현 학습은 텍스트 데이터의 풍부한 의미와 그래프 구조의 관계 정보를 효과적으로 결합하여, 복잡한 텍스트 네트워크 데이터를 다루는 데 매우 유용한 접근 방식입니다.

자기회귀적 공백 채우기 작업???

네, 이 문장을 더 자세히 설명해드리겠습니다.

- ChatGLM2-6B:

- 이는 중국 Tsinghua University에서 개발한 대규모 언어 모델(Large Language Model, LLM)입니다.

- '6B'는 모델이 약 60억 개의 매개변수를 가지고 있음을 나타냅니다.

- 자기회귀적 공백 채우기 작업(Autoregressive blank infilling task):

- 자기회귀(Autoregressive): 모델이 이전에 생성한 출력을 기반으로 다음 출력을 예측하는 방식입니다.

- 공백 채우기(Blank infilling): 텍스트의 일부분이 비어있고, 모델이 그 빈 부분을 채우는 작업입니다.

- 이 작업에서 모델은 주어진 문맥을 이해하고 적절한 텍스트로 빈 곳을 채워야 합니다.

- 사전 훈련 작업의 일반적인 설계 철학:

- 사전 훈련(Pretraining)은 대규모 데이터셋을 사용하여 모델에 일반적인 언어 이해와 생성 능력을 부여하는 과정입니다.

- 대부분의 사전 훈련 작업은 모델이 자연스럽게 언어를 이해하고 생성할 수 있도록 설계됩니다.

- ChatGLM2-6B의 접근 방식:

- 이 모델은 자기회귀적 공백 채우기를 사용하여 훈련됩니다.

- 이는 모델이 문맥을 이해하고 적절한 텍스트를 생성하는 능력을 개발하는 데 도움을 줍니다.

- 이러한 방식은 실제 대화나 텍스트 생성 상황과 유사하여, 모델의 실제 사용 성능을 향상시킬 수 있습니다.

- 왜 이 방식이 중요한가:

- 이 접근법은 모델이 문맥을 이해하고 적절한 응답을 생성하는 능력을 향상시킵니다.

- 실제 대화나 텍스트 생성 작업과 유사한 환경에서 훈련되므로, 실제 응용에서 더 나은 성능을 보일 수 있습니다.

- 이는 대부분의 최신 언어 모델들이 채택하고 있는 효과적인 훈련 방식과 일치합니다.

요약하면, ChatGLM2-6B는 문맥을 이해하고 적절한 텍스트를 생성하는 능력을 개발하기 위해 자기회귀적 공백 채우기 작업을 사용하여 훈련되었으며, 이는 현대 언어 모델 훈련의 일반적인 접근 방식과 일치합니다.

결론

실험 요약

3.1 실험 설정

3.1.1 데이터셋

- Taobao 데이터셋: Taobao e-commerce 플랫폼에서 추출된 98만 개의 노드와 179만 개의 엣지로 구성되어 있으며, 사용자의 구매, 검색, 브라우징 등의 행동 데이터를 포함합니다.

- ArXiv 데이터셋: ArXiv 연구 논문으로 구성된 그래프로, 169,343개의 노드와 1,166,243개의 엣지를 포함하며, 논문의 제목과 초록 등의 텍스트 속성을 갖고 있습니다.

3.1.2 비교 대상

- BERT 및 BERT*: 마스킹된 언어 모델링을 활용한 사전 학습된 트랜스포머 모델. BERT*는 주어진 데이터셋에서 미세 조정된 버전입니다.

- RoBERTa 및 RoBERTa*: 추가적인 학습 기법과 데이터 증강 전략을 포함한 BERT 모델의 변형입니다. RoBERTa*는 주어진 데이터셋에서 미세 조정된 버전입니다.

- LLM+𝑠𝑣: 원래의 속성 설명을 명령어에 추가하여 ChatGLM2-6B에 입력합니다.

- LLM+𝑠𝑣+𝑠N(𝑣): 노드와 이웃의 텍스트 속성을 명령어에 병합하여 ChatGLM2-6B에 입력합니다.

3.1.3 모델 세부사항

- 그래프 모델: Taobao 데이터셋에서는 GraphSAGE를 사용하여 노드 임베딩을 생성하고, ArXiv 데이터셋에서는 동일한 설정을 사용하되 중간 차원을 1024로 설정합니다.

- 대형 언어 모델: ChatGLM2-6B를 사용하며, 6억 개의 매개변수를 포함합니다.

- 번역 모듈: BERT를 기반으로 구현되며, Taobao 데이터셋에는 BERT-base-Chinese, ArXiv 데이터셋에는 BERT-base-English를 사용합니다.

3.1.4 실험 환경

모든 실험은 4개의 GPU(Tesla V100, 메모리 32G)와 CPU(Intel Xeon Platinum 8163)로 구성된 Linux 서버에서 수행되었습니다.

3.2 제로샷 노드 분류

- 제로샷 분류 실험에서 GraphTranslator는 대부분의 비교 대상보다 우수한 성능을 보였습니다. 이는 그래프 모델이 대형 언어 모델(LLM)의 도움을 크게 받을 수 있음을 나타냅니다.

- GraphTranslator는 특히 긍정 사례에 대한 리콜에서 두드러진 향상을 보였습니다. 예를 들어, Taobao 데이터셋에서 고양이 소유자 예측에서 GraphTranslator는 제품 관련 정보를 암묵적으로 요약하여 정확도를 높였습니다.

3.3 그래프 질문 응답(GQA)

- GraphTranslator의 상업적 가치를 입증하기 위해 Taobao 데이터셋에서 그래프 질문 응답 실험을 수행했습니다.

- 다중 턴 대화 형식으로 LLM을 쿼리하여 GraphTranslator가 보이지 않는 노드 임베딩을 추출, 설명 및 추론하는 능력을 심층 조사했습니다.

- 평가 결과, GraphTranslator는 Vanilla LLM에 비해 Q1과 Q3에서 일관되게 더 나은 성능을 보였습니다. 이는 GraphTranslator가 노드 임베딩을 기반으로 그래프 정보를 추출하는 능력이 뛰어남을 나타냅니다.

4 결론

- GraphTranslator는 그래프 모델(GM)과 대형 언어 모델(LLM)을 정렬하여 다양한 개방형 작업을 수행할 수 있는 새로운 프레임워크를 제안합니다.

- 실험 결과, GraphTranslator는 제로샷 노드 분류에서 뛰어난 성능을 보였으며, 그래프 질문 응답 실험을 통해 상업적 가치를 입증했습니다.

이 논문은 그래프 모델과 대형 언어 모델을 효과적으로 결합하여 다양한 작업을 처리할 수 있는 새로운 방법을 제안하며, 이를 통해 실질적인 산업 환경에서의 적용 가능성을 높입니다 .