https://arxiv.org/abs/2402.03746

Tuning Large Multimodal Models for Videos using Reinforcement Learning from AI Feedback

Recent advancements in large language models have influenced the development of video large multimodal models (VLMMs). The previous approaches for VLMMs involved Supervised Fine-Tuning (SFT) with instruction-tuned datasets, integrating LLM with visual enco

arxiv.org

https://github.com/yonseivnl/vlm-rlaif

GitHub - yonseivnl/vlm-rlaif

Contribute to yonseivnl/vlm-rlaif development by creating an account on GitHub.

github.com

아직 코드는 공개되지 않았습니다.

논문 요약: "Tuning Large Multimodal Models for Videos using Reinforcement Learning from AI Feedback"

논문 개요

이 논문은 영상과 텍스트를 효과적으로 정렬하기 위한 새로운 방법론을 제시합니다. 기존의 비디오 대형 다중 모달 모델(VLMMs)은 주로 감독 학습(SFT)과 인간 피드백을 사용하여 정렬되었지만, 이 논문에서는 AI 피드백을 이용한 강화 학습(RLAIF)을 통해 자체적으로 개선하는 접근 방식을 제안합니다. 이 방법은 영상 내용을 보다 명확하게 이해하기 위해 상세한 비디오 설명을 맥락으로 활용하는 '맥락 인식 보상 모델링(context-aware reward modeling)'을 통합합니다.

주요 기여

- 새로운 정렬 방법 제안: 영상과 텍스트 모달리티를 효과적으로 정렬하기 위해 AI 피드백을 활용한 강화 학습(RLAIF)을 제안.

- 맥락 인식 보상 모델링: 비디오 내용을 보다 명확하게 이해하기 위해 상세한 비디오 설명을 활용하여 AI의 피드백을 향상.

- 추가 데이터와 커리큘럼 학습 전략: SFT 모델의 훈련을 위한 추가적인 지시 조정 데이터 도입과 단순한 커리큘럼 학습 전략 적용.

- 우수한 성능 입증: 다양한 비디오 이해 벤치마크에서 제안된 VLM-RLAIF의 우수성을 실험적으로 입증.

해결된 문제

- 비디오와 텍스트의 정렬 문제: 기존의 모델들은 비디오와 텍스트의 정렬이 불충분하여 비디오 내용에 적절히 기반하지 않는 응답을 생성하는 문제가 있었습니다. RLAIF를 통해 이러한 문제를 해결.

- 데이터 부족 문제: 기존의 멀티모달 지시 조정 데이터의 양과 질이 부족한 문제를 인간이 라벨링한 데이터와 객체 중심의 멀티모달 지시 조정 데이터로 보완.

실험 결과

- VLM-RLAIF는 다양한 비디오 벤치마크에서 기존 방법들보다 우수한 성능을 보였습니다. 비디오 질문 응답, 텍스트-비디오 검색, 액션 인식 등의 작업에서 두드러진 향상을 보였습니다.

- 실험 결과는 VLM-RLAIF가 기존의 VLM-SFT 모델 대비 성능이 크게 향상되었음을 보여줍니다. 예를 들어, 비디오 기반 생성 성능에서 VLM-SFT보다 정답률, 세부 정보, 맥락 이해, 시간적 일관성 등 다양한 측정 지표에서 높은 성능을 기록했습니다.

중요한 점

- 자체 피드백: AI 피드백을 활용하여 모델이 스스로의 응답을 평가하고 개선할 수 있는 능력을 갖추도록 함.

- 맥락 정보 활용: 비디오를 작은 클립으로 나누고 각 클립의 설명을 생성하여 이를 종합함으로써 보다 정교한 맥락 정보를 제공.

- 데이터 증강과 커리큘럼 학습: 데이터 증강과 단순한 커리큘럼 학습 전략을 통해 모델의 학습 효과를 극대화.

결론

이 논문은 비디오와 텍스트의 효과적인 정렬을 위해 AI 피드백을 활용한 새로운 접근 방식을 제시하였으며, 이를 통해 다양한 비디오 이해 벤치마크에서 우수한 성능을 입증했습니다. 추가 연구를 통해 더욱 정교한 데이터 생성과 다양한 응용 분야에서의 모델 적용 가능성을 탐구할 수 있습니다.

멀티 모달 학습을 위한 데이터 셋이 부족하다 -> 그래서 우린 강화학습을 통해 멀티 모달(VLMMs)을 학습시킬 것이다. -> VLM-RLAIF는 다양한 비디오 이해 벤치마크에서 우수성을 입증하였다.

파인 튜닝을 진행한 SFT모델도 RLAIF만큼은 아니지만 성능이 많이 좋아졌다.

RLHF는 인간 피드백을 통한 강화학습인데 이건 리소스가 너무 많이 든다. 그래서 AI 피드백을 통한 강화학습인 RLAIF가 떠올랐다.

RLAIF 학습 단계

1. LLM을 비전 인코더와 파라미터 추가 및 파인튜닝하여 SFT 모델을 만든다.

2. SFT가 선호도를 평가하고, 이에 대해 강화학습을 진행한다.

3. PPO알고리즘을 활용하여 강화학습 진행

PPO?

Proximal Policy Optimization (PPO) 알고리즘

Proximal Policy Optimization(PPO)은 OpenAI에서 개발한 강화 학습 알고리즘으로, 정책 최적화를 통해 에이전트가 주어진 환경에서 최적의 행동을 학습하도록 합니다. PPO는 기존의 정책 경사 방법에 비해 안정성과 효율성을 높이기 위해 설계되었습니다. 다음은 PPO 알고리즘의 주요 특징과 작동 방식입니다.

주요 특징

- 클리핑(clipping) 방법:

- PPO는 새로운 정책과 기존 정책 사이의 변화를 제한하기 위해 클리핑 기법을 사용합니다. 이는 큰 정책 업데이트로 인해 발생할 수 있는 불안정성을 줄입니다.

- 클리핑은 손실 함수에서 정책 비율을 제한하여 급격한 변화를 방지합니다.

- 목표 함수(objective function):

- PPO의 목표 함수는 기존 정책과 새 정책 사이의 차이를 최소화하는 것입니다. 이를 통해 정책의 변화를 제어하면서도 학습을 진행합니다.

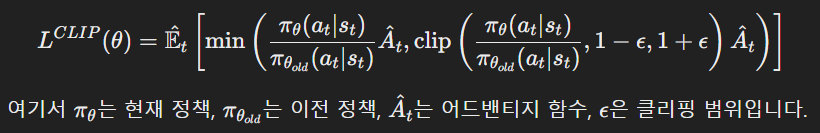

- 클리핑된 목표 함수는 다음과 같습니다:

- 에포크(epoch) 업데이트:

- PPO는 정책을 여러 번 업데이트하기 위해 여러 에포크 동안 미니 배치(mini-batch)를 사용합니다. 이를 통해 효율적인 학습이 가능합니다.

- 에포크 동안 정책을 여러 번 업데이트함으로써 안정적이고 효율적인 학습을 보장합니다.

- 샘플 효율성:

- PPO는 여러 번의 에포크 동안 동일한 샘플을 재사용함으로써 샘플 효율성을 높입니다. 이는 샘플의 활용도를 극대화하여 데이터 효율성을 향상시킵니다.

작동 방식

- 환경과 상호작용:

- 에이전트는 현재 정책을 사용하여 환경과 상호작용하고, 상태(state), 행동(action), 보상(reward)을 수집합니다.

- 어드밴티지 함수 계산:

- 어드밴티지 함수 ( \hat{A}_t )를 계산하여 특정 행동이 얼마나 좋은지를 평가합니다.

- 정책 업데이트:

- 수집된 데이터를 사용하여 목표 함수를 최적화합니다. 클리핑 기법을 사용하여 정책의 변화를 제한하고, 여러 에포크 동안 업데이트를 반복합니다.

- 반복:

- 정책이 수렴할 때까지 위 과정을 반복합니다.

요약

Proximal Policy Optimization(PPO)은 강화 학습에서 안정적이고 효율적인 정책 최적화를 위해 설계된 알고리즘입니다. 클리핑 기법을 사용하여 큰 정책 변화를 제한하고, 에포크 동안 정책을 반복적으로 업데이트함으로써 안정성을 보장합니다. PPO는 샘플 효율성을 높여 데이터 활용도를 극대화하고, 다양한 강화 학습 문제에서 성공적으로 적용되고 있습니다.

여기서 SFT가 평가하기 위해 비디오의 내용 이해 및 맥락 인식 선호도(비디오를 작은 클립으로 나누기 -> 각 클립에 대한 설명 생성 -> 설명을 종합하여 비디오 전체 서술 생성 -> 이 내용을 바탕으로 SFT가 응답을 평가)를 선택해야 한다.

기존 데이터에서 다양한 데이터로 확장하고, 쉬운 것부터 천천히 시작하여 점점 난이도를 올려간다.

실험 설정 및 결과

4.1 실험 설정

모델 세부 사항

- VLM-SFT 학습 시작: 사전 학습된 이미지-텍스트 모델을 바탕으로 비디오-텍스트 지시 조정 데이터를 사용하여 VLM-SFT를 학습합니다.

- 비디오 프로젝션 층(NLP가 이해할 수 있도록 feature를 변환해준다): 두 개의 선형 층과 ReLU 활성화 함수로 구성된 비디오 프로젝션 층을 사용합니다.

- 보상 모델 학습: VLM-SFT를 바탕으로 보상 모델(RM)을 학습하고, 선호도 데이터를 생성합니다. 이후, 강화 학습(VLM-RLAIF)을 통해 RM을 학습합니다.

- 정책 모델 초기화: VLM-SFT로부터 초기화되며, 가치 모델은 RM으로부터 초기화됩니다.

데이터셋 세부 사항

- SFT 데이터셋: 오픈 소스 비디오-텍스트 지시 조정 데이터셋(80k)과 비디오 질문 응답 데이터셋(67k)을 사용합니다. 또한, 객체 중심의 내러티브 비디오-텍스트 지시 조정 데이터셋(180k)을 생성하여 VLM-SFT를 학습합니다.

- 커리큘럼 학습: 지시 조정 데이터를 난이도에 따라 '쉬운'(214k)과 '어려운'(113k) 데이터로 나눕니다. RM을 학습하기 위해 기존 지시 조정 데이터에서 응답을 생성하고 선호도를 생성하여 사용합니다(40k). 이후, RL을 위해 학습된 RM을 사용하여 기존 지시 조정 데이터셋(100k)을 사용합니다.

훈련 세부 사항

- 비디오 입력: 각 비디오에서 50 프레임을 균일하게 샘플링하고, CLIP 비주얼 인코더를 사용하여 공간적 및 시간적 특징을 추출합니다.

- 두 단계의 SFT: LoRA 랭크와 α를 각각 32로 설정하고, 각 단계에서 VLM-SFT를 한 에포크 동안 학습합니다.

- 강화 학습: QLoRA를 사용하여 정책 모델을 한 에포크 동안 학습합니다. 모든 모델은 8×NVIDIA A100 GPUs (80G)를 사용하여 학습합니다.

4.2 정량적 분석

비디오 기반 생성 성능

- 평가 기준: 생성된 텍스트의 비디오 내용 관련성, 세부 사항 및 맥락 캡처 능력, 시간적 이해 및 일관성을 평가합니다.

- 성능 비교: VLM-RLAIF는 GPT-4V와 비교하여 더 적은 계산 자원으로 유사한 성능을 보이며, 이전 접근 방식과 VLM-SFT를 능가합니다.

제로샷 비디오 질문 응답

- 평가 데이터셋: 세 가지 데이터셋에서 비디오 질문 응답 능력을 평가합니다.

- 성능 비교: VLM-RLAIF는 VLM-SFT를 포함한 이전 접근 방식을 크게 능가하며, 정확도와 점수에서 더 높은 성능을 기록합니다.

제로샷 텍스트-비디오 검색

- 평가 절차: CLIP 점수를 비교하여 생성된 설명과 실제 캡션의 일치도를 평가합니다.

- 성능 비교: VLM-RLAIF는 MSVD와 MSRVTT 데이터셋에서 다른 방법들보다 높은 성능을 보입니다.

제로샷 액션 인식

- 평가 데이터셋: UCF101과 HMDB51 데이터셋을 사용하여 액션 인식 능력을 평가합니다.

- 성능 비교: VLM-RLAIF는 VLM-SFT를 포함한 다른 방법들보다 높은 성능을 보입니다.

4.3 상세 분석

SFT 훈련 절차 분석

- 추가 데이터의 효과: 추가 지시 조정 데이터셋을 사용하여 SFT 성능을 향상시키는 효과를 확인합니다. 커리큘럼 학습을 적용하여 성능이 더욱 향상됨을 보여줍니다.

선호 데이터 크기의 효과

- 데이터 크기 증가: 선호 데이터의 크기를 증가시킴에 따라 성능이 단조롭게 증가함을 관찰합니다.

맥락 인식 선호 라벨링

- 맥락 정보의 효과: 맥락 정보를 사용하는 것이 성능 향상에 기여함을 확인합니다. 비디오를 여러 클립으로 나누고 각 클립에 대한 설명을 생성하여 맥락을 강화합니다.

4.4 질적 분석

VLM-SFT와 VLM-RLAIF의 성능 비교

- 예시 분석: VLM-RLAIF가 VLM-SFT보다 더 정확한 응답을 생성하는 것을 확인합니다. 자세한 인식과 시각적 입력에 더 잘 맞는 응답을 생성합니다.

위의 실험 결과와 분석을 통해 VLM-RLAIF는 다양한 비디오 이해 작업에서 높은 성능을 보이며, VLM-SFT를 포함한 기존 접근 방식을 능가하는 성능을 입증합니다.

만약 SFT의 파인튜닝이 제대로 되지 않아 좋은 성능을 보이지 못한다면 RLAIF의 성능도 보장하지 못한다는 한계점, 다양한 벤치마크가 존재하지 않는다는 한계점이 있다.

네, 맞습니다. RLAIF(Reinforcement Learning from AI Feedback)는 기본적으로 SFT(Supervised Fine-Tuning) 모델의 성능에 크게 의존합니다. SFT 모델이 좋은 성능을 보이지 못한다면, RLAIF의 강화 학습 과정에서 얻는 피드백의 질도 낮아질 수 있으며, 이는 최종 모델의 성능에 부정적인 영향을 미칠 수 있습니다. 이를 좀 더 구체적으로 설명하겠습니다:

RLAIF와 SFT의 관계

- SFT 모델의 역할:

- SFT 모델은 RLAIF의 기초를 형성합니다. SFT 모델은 합성된 비디오-텍스트 지시 조정 데이터로 감독 학습을 통해 학습되며, 초기 정책 모델로 사용됩니다.

- SFT 모델은 초기 응답을 생성하고, 이러한 응답은 RLAIF에서 피드백을 생성하는 데 사용됩니다.

- 피드백의 품질:

- RLAIF는 SFT 모델이 생성한 응답을 평가하여 피드백을 제공합니다. 이 피드백은 보상 모델을 학습하는 데 사용됩니다.

- SFT 모델의 응답 품질이 낮다면, 피드백의 신뢰성과 정확성도 낮아질 수 있습니다. 이는 보상 모델이 잘못된 평가를 할 가능성을 높이고, 강화 학습 과정에서 부정확한 학습을 초래할 수 있습니다.

- 강화 학습의 효율성:

- 강화 학습 과정은 보상 모델이 제공하는 피드백에 따라 정책을 최

적화합니다. 따라서 보상 모델이 잘못된 피드백을 제공하면, 강화 학습 과정에서 정책이 잘못된 방향으로 최적화될 수 있습니다.

- 이로 인해 최종적으로 얻는 모델이 기대하는 성능을 발휘하지 못할 가능성이 높아집니다.

해결 방안

- SFT 모델의 성능 개선:

- SFT 모델의 성능을 최대한 높이기 위해 고품질의 지시 조정 데이터셋을 사용하고, 커리큘럼 학습을 통해 단계적으로 학습하는 방법을 사용할 수 있습니다.

- 다양한 데이터 소스를 통합하여 SFT 모델이 다양한 시나리오에서 잘 작동하도록 학습시킵니다.

- 보상 모델의 품질 보장:

- 보상 모델의 학습을 위해 가능한 한 정확하고 다양한 피드백 데이터를 수집합니다. 초기에는 인간 피드백을 사용하여 보상 모델을 사전 학습시키는 것도 한 방법입니다.

- 맥락 인식 보상 모델링을 통해 비디오 내용을 보다 정확히 이해하고 평가할 수 있도록 합니다.

- 지속적인 평가와 개선:

- RLAIF 과정에서 얻은 피드백과 결과를 지속적으로 평가하여, 필요한 경우 보상 모델과 SFT 모델을 개선합니다.

- 다양한 벤치마크와 실제 시나리오에서 모델을 테스트하여 성능을 확인하고, 이를 바탕으로 모델을 조정합니다.

결론

RLAIF는 SFT 모델의 성능에 크게 의존하기 때문에, SFT 모델의 성능이 낮다면 강화 학습의 효과도 제한적일 수밖에 없습니다. 따라서 SFT 모델의 성능을 최적화하고, 보상 모델의 품질을 보장하는 것이 중요합니다. 이를 통해 RLAIF의 강화 학습 과정이 효과적으로 진행될 수 있으며, 최종적으로 높은 성능을 발휘하는 모델을 얻을 수 있습니다.

코드가 있으면 한번 진행해보면서 시각화 해봐도 좋을 것 같은데...