728x90

728x90

목표 - 파인 튜닝 시 모델 성능 최적화를 위한 하이퍼 파라미터 튜닝에 대해 이해할 수 있다.

1. 이전의 학습 내용을 까먹는다.

2. 데이터의 크기가 작을수록 학습이 불안정하다.

사전 학습 때 A 데이터로 학습하고 B 데이터에 대해 학습하면 전이 학습의 효과를 사용하지 못할 수 있다.

성공한 모델, 실패한 모델 모두 일어나니 전이학습의 일반적인 결과이다.

A 작업을 잘 하길 원하는 것이 아니기 때문에 감수하고 진행하는 사람들도 있다.

학습을 많이 하면 분산이 줄어든다 -> 학습을 많이(오버피팅 전) 시켜야 한다.

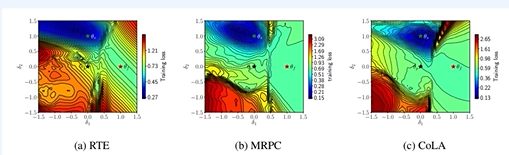

s 는 성공적으로 학습하여 파란색에 가있다.

f는 학습이 하나도 되지 않았다.

f는 로컬 미니멈에 있는 거나 기울기 소실 현상이 일어났다.

초반부터 learning rate를 작게 줘서 기울기 소실 현상을 막고, 이상한 곳에 가지 않게 한다.

Drop out - 일부를 학습에 안쓴다 = 특정 노드에 일반화 방지(중요도 쏠림 방지) -> 오버피팅 방지

Weight decay - 가중치가 너무 커지지 않도록 막는다.

learning rate를 scheduling한다. -> 이상한 방향으로 가지 않도록 막는다.

일반적으로 통용되는 값들이 있으므로, 학습이 불안정하다면 해당 값으로 설정해서 진행해보고 해결되지 않는다면 적절한 파라미터를 탐색

728x90

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 python 실습 - 파인 튜닝 실습 (2) | 2024.03.30 |

|---|---|

| 자연어 처리 모델 학습 - 파인 튜닝된 모델 분석 및 평가 (0) | 2024.03.30 |

| 자연어 처리 모델 학습 - 파인 튜닝 방법 1 (0) | 2024.03.29 |

| 자연어 처리 모델 학습 - 파인 튜닝(Fine tuning)이란? (1) | 2024.03.29 |

| 자연어 처리 모델 학습 - 전이 학습(Transfer Learning)이란 (0) | 2024.03.29 |