728x90

728x90

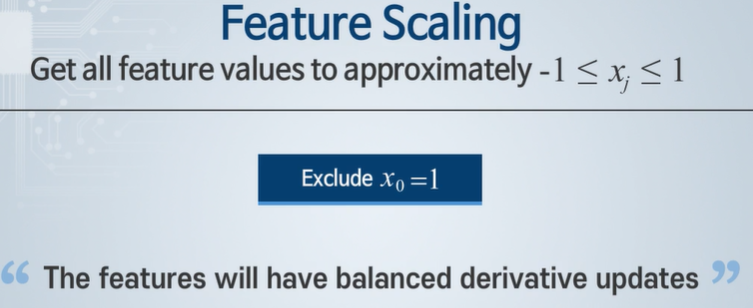

내가 아는 스케일 - 값의 차이를 적당한 범위로 맞춰준다.

큰 값이 영향을 크게 주게 된다!

경사 하강법이 잘 적용되지 않을 수 있다.

그럼 최솟값이 안맞지 않나?

Feature Scaling

밸런스를 가지도록 스케일링 한다!

평균 값을 빼주는 이유 : 특징 값이 좌우 균등하게 분포하도록!

스케일링 시 - 경사하강법이 빨라 질 수 있다. 분류 문제에서도 경사 하강법에 도움을 준다.

범위가 너무 다른 경우 적용한다!

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 머신러닝 3주차 4차시 - 새로운 특징 값 만들기 (0) | 2024.03.19 |

|---|---|

| 머신러닝 3주차 3차시 - 경사 하강, 학습 속도 (0) | 2024.03.18 |

| 머신러닝 3주차 1차시 - 다 변수 선형 회귀 (1) | 2024.03.18 |

| 인공지능과 빅 데이터 3주차 3차시 - 규칙기반 시스템, 전문가 시스템 (1) | 2024.03.18 |

| 인공지능과 빅 데이터 3주차 2차시 - 지식 표현과 추론, 지식 표현의 불확실성 (2) | 2024.03.18 |