https://arxiv.org/abs/2408.00754

Coarse Correspondences Boost Spatial-Temporal Reasoning in Multimodal Language Model

Multimodal language models (MLLMs) are increasingly being applied in real-world environments, necessitating their ability to interpret 3D spaces and comprehend temporal dynamics. Current methods often rely on specialized architectural designs or task-speci

arxiv.org

기존 Multi-Modal은 3D 공간을 해석하는데 fine-tuning에 의존하였음

이 방법론에선 모델 구조 변경이나, fine-tuning 없이 프롬프트 만으로 시공간 추론 능력을 향상함

이제 여기선 입력할 데이터를 전처리합니다.

object tracking을 진행한 뒤 제일 많이 나오는, 비중이 높은 k개를 고르며, frame 감소도 같이 진행합니다.

이제 여기에 시각적 마킹을 추가하여 모델 입력에 넣어주면 높은 성능을 가진다고 합니다.

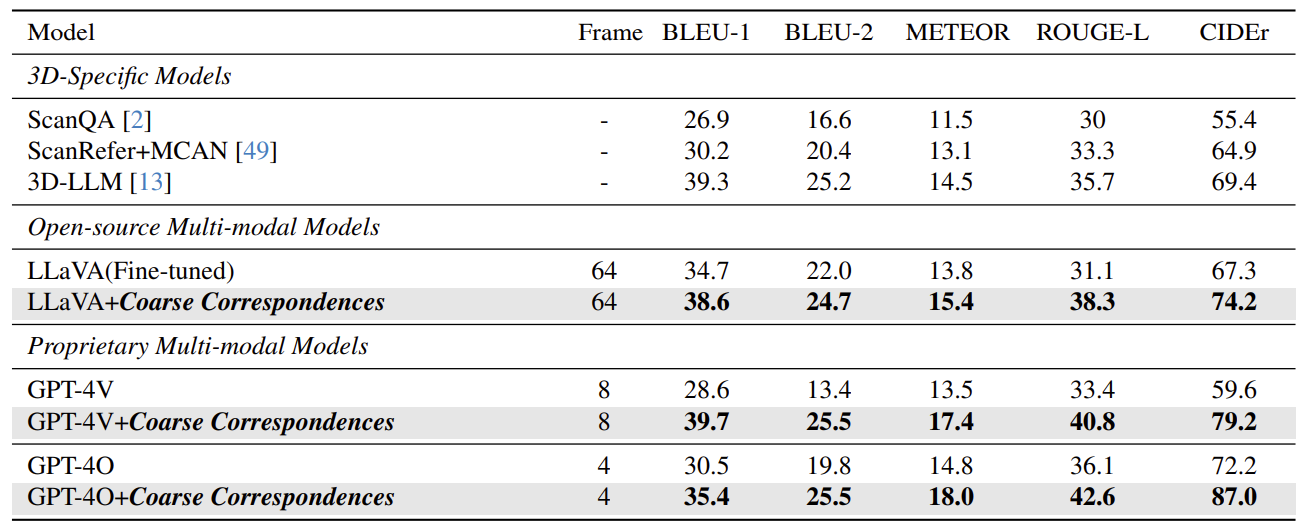

파인 튜닝 모델보다 높은 성능을 가지는 것을 볼 수 있다.

그런데 3D-Specific 모델이 좀 강하긴 하네요

이 벤치마크에 대한 이해가 부족한 것 같아서..

논문의 3.1 Spatial Understanding 실험 파트에서는 COARSE CORRESPONDENCES가 3D 공간 인식 능력을 얼마나 향상시키는지를 두 개의 대표적인 벤치마크(SCANQA, OpenEQA)를 통해 평가합니다. 아래에 이 실험 파트를 벤치마크 설명, 모델 비교 기준, 평가지표, 의미 있는 결과 해석까지 AI 연구자 관점에서 정리해드릴게요.

🧭 1. 평가 대상 벤치마크 설명

📌 1-1. ScanQA

| 항목 | 내용 |

| 📚 데이터 구성 | 총 4675개 질문이 71개 3D 장면(Scene)에 대해 출제됨 |

| 📍 질문 성격 | - 물체 식별 (object recognition) - 3D 공간 내 위치 추정 (3D localization) - 시각-언어 통합된 공간 추론 (embodied 3D QA) |

| 🎯 답변 형식 | 자유형 문장 (free-form answer) — 정답이 정해진 단답형이 아님 |

| ✅ 정답 처리 | 정답은 2개 ground truth 답변이 존재하며, 생성된 답변을 이들과 비교 |

| 📥 입력 정보 | 2D 이미지 뷰포인트 다수 (point cloud 아님) |

📌 1-2. OpenEQA (EM-EQA subset)

| 항목 | 내용 |

| 🎥 데이터 성격 | 에이전트가 3D 공간을 이동하며 관측한 이미지 시퀀스를 기반으로 함 |

| 🧠 평가 목적 | Episodic memory 능력을 측정 → 시간에 따라 변화하는 공간 구조 이해 |

| 🧾 질문 수 | 약 1600개의 고품질 사람이 작성한 질문 |

| 🔓 특징 | open-vocabulary QA — 정해진 후보 정답이 아니라, 자유로운 언어 이해 필요 |

⚙️ 2. 비교 모델 (Baselines)

| 범주 | 모델 |

| ✅ 일반 다목적 MLLM | GPT-4, GPT-4V, GPT-4O, Claude 3, Gemini |

| 🔍 특수 3D 모델 | 3D-LLM, ScanRefer+MCAN 등 — 3D 데이터나 point cloud 기반으로 학습된 모델 |

| ⚠️ 언어 편향 기준선 | LLaMA2 (텍스트-only 모델) — 시각 정보를 제거한 조건에서의 성능 |

이 비교를 통해 COARSE CORRESPONDENCES가 단순 시각 정보 보강을 넘어서 진짜 3D reasoning을 향상시키는지 검증합니다.

📏 3. 평가 지표 (Metrics)

🧮 ScanQA에서는 기존 2D VQA 기준에 맞는 정량 평가 사용:

| 지표 | 설명 |

| BLEU-1, BLEU-2 | n-gram precision (정답과 생성 문장의 어휘 일치율) |

| METEOR | synonym matching, alignment 기반 정밀 평가 |

| ROUGE-L | Longest common subsequence (서술형 응답에서 유사한 서술 구조 측정) |

| CIDEr | 이미지 캡션 평가 기반 문장 유사도 — 사람 선호도와 가장 잘 맞음 |

➡️ 자유형 답변이기 때문에 단순 정답 일치보다는 문장 품질, 의미 유사성 평가 중심

🧠 OpenEQA는 다소 특이한 평가 방식을 사용:

- 생성된 응답과 정답을 GPT-4가 자동 평가자(judge)로 비교

- 즉, GPT-4가 두 문장(생성 응답 vs ground truth)을 비교하고 점수를 할당

- 이 점수를 평균하여 최종 성능 산출 (100점 척도 유사)

📌 이 방식은 OpenEQA 논문에서 제안한 공식 평가법이며, 자유형 응답 비교에 있어서 유연성과 의미 비교력이 높습니다.

📊 4. 주요 실험 결과 해석

🎯 ScanQA 결과 예시 (GPT-4O 기준)

| 지표 | 기본 입력 | +CC 적용 | 향상폭 |

| BLEU-2 | 19.8 | 25.5 | +5.7 |

| METEOR | 14.8 | 18.0 | +3.2 |

| ROUGE-L | 36.1 | 42.6 | +6.5 |

| CIDEr | 72.2 | 87.0 | +14.8 |

➡️ CC를 통해 간단한 시각 프롬프트만 삽입했음에도 불구하고, fine-tuned 3D 모델보다 성능이 우수함

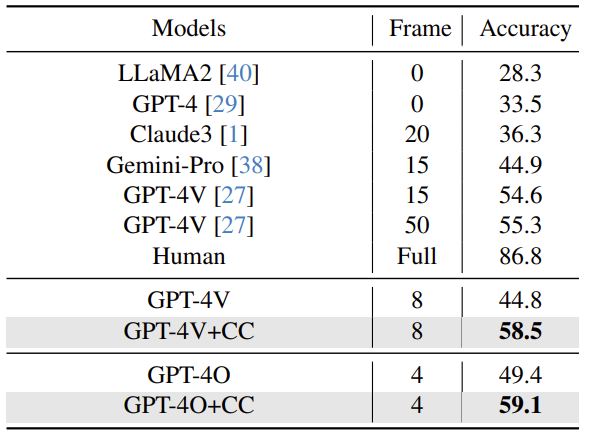

🎯 OpenEQA (EM-EQA) 결과 예시 (GPT-4O 기준)

| 조건 | 정확도 (%) |

| GPT-4O (4프레임) | 49.4 |

| GPT-4O + CC (4프레임) | 59.1 (+9.7) |

➡️ 특히 적은 수의 뷰(4장)만으로도 시공간 기반 QA 능력을 향상시킴 → 효율성 + 추론력 동시 향상

💡 요약 인사이트

| 항목 | 설명 |

| 벤치마크 다양성 | 고정 3D QA (ScanQA) vs 시간 변화 포함 3D QA (OpenEQA) |

| 정성/정량 평가 조합 | BLEU, ROUGE 등의 객관 평가 + GPT 기반 의미 평가 (OpenEQA) |

| 모델 편향 제거 | 텍스트-only 모델 포함시켜 시각 정보의 실제 효과 검증 |

| 효율성 고려 | 적은 프레임으로도 성능을 올릴 수 있음을 입증 |

더 적은 입력으로 높은 정확도를 낼 수 있는 것을 보여주고 있습니다.

여기서도 프레임 감소와 정확도 증가!

너무 많은 마크가 사용되면 시각적 정보를 가리고, 크기 또한 시각적 정보를 가리는 방해 효과가 있기에 적절한 수와 크기가 중요하다.

마크 사이즈, 크기, 모량에 따라 성능이 왔다갔다 하는 모습을 볼 수 있다.

논문 “Coarse Correspondences Boost Spatial-Temporal Reasoning in Multimodal Language Model”는 다중모달 언어모델(Multimodal LLM, 이하 MLLM)의 공간적·시간적 추론 능력을 증강시키기 위해 훈련 없이 간단한 시각 프롬프트 기법(Coarse Correspondences, 이하 CC)을 제안합니다. 아래에서 이 논문을 단계별로 체계적, 논리적으로 정리하겠습니다.

🧩 1. 문제 정의

🔍 연구의 핵심 문제

MLLM은 2D 이미지 기반의 질의응답, 설명 등에서는 우수한 성능을 보이지만, 3D 공간 이해와 시간적(temporal) 정보 이해, 즉 spatial-temporal reasoning에서는 한계를 보임.

📌 기존 한계점

- 고성능을 위해서는 3D 포인트 클라우드 입력, 특화된 아키텍처, 혹은 task-specific fine-tuning이 필요

- 이는 비용이 크고 범용성이 떨어짐

🧠 2. 제안 방법: Coarse Correspondences

🔧 목적

- 특수 아키텍처 변경 없이

- fine-tuning 없이

- 단순한 visual prompting 방식으로

- MLLM의 공간-시간 추론 능력 강화

🔄 전체 파이프라인

- Tracking correspondences

- 오프더셸프 영상 트래킹 모델(예: Tracking Anything)을 사용해 영상의 instance segmentation mask를 얻음

- Sparsify frames

- 긴 영상에서 m << n개의 대표적인 프레임을 균일하게 추출

- Select coarse correspondences

- 전체 object track 중 가장 자주 등장하는 상위 K개 객체만 선택

- Visualize coarse correspondences

- 각 프레임에 object 위치를 숫자 마크로 시각적으로 표시하여 입력 이미지 시퀀스를 구성

📌 이 방식은 객체 간 정확한 픽셀 매칭 없이도 공간-시간적 상관관계를 MLLM에 전달해줌

🔬 3. 실험 설정 및 결과

🧭 실험 대상 모델

- Proprietary MLLMs: GPT-4V, GPT-4O, Claude3, Gemini

- Open-source MLLMs: LLaVA 등

🧪 평가 대상 태스크

| Task | 설명 | 개선폭 |

| ScanQA | 3D 공간 질의응답 | +20.5% (GPT-4V 기준) |

| OpenEQA | 공간 기억 기반 질의응답 | +9.7% |

| EgoSchema | 3분짜리 롱 비디오 기반 질의응답 | +6.0% |

| R2R (VLN-CE) | 실내 내비게이션 | +11.0% |

| SQA3D | 새로운 3D QA 데이터셋 | +3.1% (LLaVA 기준) |

📊 주요 결과 요약

- 단 4~8개의 프레임만으로도 fine-tuned 3D 모델보다 뛰어난 성능

- Open-source 모델에서도 학습 및 추론 시 CC 사용 → 성능 증가

🧪 4. 분석 및 Ablation

🔎 Ablation 결과

| 실험 항목 | 결과 |

| 마크 수 | 너무 많으면 오히려 성능 하락 |

| 마크 크기 | 너무 작으면 무시됨, 너무 크면 occlusion 발생 |

| 마크 형태 | segmentation outline 추가 시 object grounding 향상 |

| 마크 위치 | 중심 좌표 기준 정확하게 마크함 |

🌀 카메라 이동 불변성 강화

- 좌→우 vs 우→좌 시퀀스 비교 실험

- CC 없이는 순서 바뀌면 성능 저하

- CC 사용 시 순서에 무관한 공간 이해 성능 향상

🔗 5. 기존 기법과의 비교

| 방법 | 방식 | 한계 |

| Set-of-Marks | 이미지에 마크만 찍음 | 공간 관계 표현 불가 |

| 3DAxiesPrompts | 축 좌표 표시 | 인식 오류 유발 |

| Chain-of-Thought | 텍스트 기반 단계적 사고 | 공간 관점 전환 실패 |

| Coarse Correspondences (본 논문) | 객체의 시공간 대응 관계 시각화 | 공간-시간 인식 능력 향상 |

🔚 6. 결론 및 의의

- 간단한 시각적 프롬프트만으로도 MLLM의 공간-시간 추론 능력을 크게 향상시킬 수 있음

- 학습 없이 inference만으로도 성능 향상 가능

- 다양한 모델 및 태스크에 범용적으로 적용 가능

- 미래에는 훈련용 데이터 증강 방식으로도 활용 가능성

📌 핵심 아이디어 요약표

| 항목 | 내용 |

| 제안 방식 | 영상 기반 instance correspondence 시각화 프롬프트 |

| 아키텍처 변경 | 없음 |

| 학습 필요성 | 없음 (inference only 가능) |

| 향상 영역 | 3D QA, 영상 QA, 내비게이션 등 시간·공간 추론 필요 태스크 |

| 대표 성능 향상 | ScanQA +20.5%, R2R +11%, EgoSchema +6% |

| 추가 장점 | 연산량 감소, open-source 모델에서도 학습/추론 모두 효과 |

좋습니다. 이 논문에서 제안한 COARSE CORRESPONDENCES 방법론은 MLLM(Multimodal Large Language Model)의 3D 공간 및 시간적 추론 능력을 향상시키기 위한 프롬프트 기반 시각적 기법입니다.

🧠 COARSE CORRESPONDENCES: 전체 개요

목표: 일반적인 MLLM이 단순한 2D 이미지 시퀀스만을 입력받아도 3D 공간 이해 및 시간 흐름에 따른 변화 인식을 할 수 있도록 만드는 것.

핵심 아이디어: 영상에서 객체 간의 시간적/공간적 대응관계(object correspondences)를 추출하고, 이를 마크로 시각화(visual prompting)하여 MLLM에 전달

🔄 전체 파이프라인 (4단계)

1️⃣ Step 1. Tracking correspondences (객체 대응관계 추적)

목적:

여러 이미지(또는 영상 프레임)에서 동일한 객체를 식별하고 추적하기 위함

구현:

- Tracking Anything 모델(예: Segment Anything + Tracker)을 활용하여,

- 각 프레임에서 클래스 비의존 instance segmentation mask를 생성함

결과:

- 각 프레임마다, 각 픽셀이 어떤 객체에 속하는지 알려주는 M_i 매트릭스를 생성함

- 예시:

- Frame1: 소파(ID=1), 선풍기(ID=2), 문(ID=3) Frame2: 소파(ID=1), 선풍기(ID=2), 문(ID=3)

2️⃣ Step 2. Sparsify frames (프레임 샘플링 및 축소)

목적:

- 모든 프레임을 처리하면 계산량이 커지므로 정보를 최대한 보존하면서 프레임 수를 줄임

- 핵심 프레임만 사용해서 MLLM의 입력 부담을 줄임

구현:

- 전체 n 프레임 중 m개만 균일하게 샘플링 (m ≪ n)

- 해당 m개 프레임에 대해서만 마스크 M_s1, ..., M_sm 사용

예시:

3분짜리 비디오(90초 = 2700프레임) → 매 20초당 하나씩 9개 프레임 선택

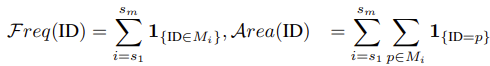

3️⃣ Step 3. Selecting Coarse Correspondences (대표 객체 선택)

문제:

너무 많은 객체를 마킹하면 정보 과부하로 성능이 떨어짐

해결 방법:

- 가장 자주 등장하고, 면적이 큰 상위 K개 객체만 선택

- 객체 ID별 빈도수와 면적을 계산:

- 이 두 수치를 기준으로 상위 k개의 객체 ID를 선택 → T_1, ..., T_k

예시:

- 문(ID=7), 소파(ID=3), 선풍기(ID=39)

- 이 3개의 객체가 여러 프레임에 계속 등장하므로 선택됨

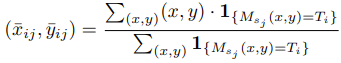

4️⃣ Step 4. Visualizing correspondences (객체 마킹하여 시각화)

목적:

MLLM이 동일 객체를 시각적으로 인식할 수 있도록 일관된 마크(label) 부여

구현:

- 각 프레임의 객체 마스크에서 해당 객체의 중심좌표(x̄, ȳ)를 계산:

- 해당 위치에 동그라미 모양 마크와 숫자를 오버레이

예시:

| 프레임 | 객체 위치 | 마크 예시 |

| Frame 1 | 소파(좌측 하단) | 빨간 원 안에 숫자 '3' |

| Frame 2 | 소파(중앙) | 같은 숫자 '3' |

👉 이렇게 하면 MLLM은 "이 두 마크는 같은 객체"임을 추론 가능

🧪 예시 시나리오: “문은 어디에 있습니까?”

입력:

- 당신은 소파에 앉아 있고, 선풍기가 왼쪽에 있다

- 문은 어디에 있는가?

시각적 마크 입력:

- Frame 1: 선풍기(39), 문(7)

- Frame 2: 소파(3), 선풍기(39)

MLLM의 reasoning:

- Frame1에서 문(7)이 선풍기(39) 옆에 있음

- Frame2에서 선풍기(39)는 소파 기준 왼쪽

- 따라서 문(7)은 사용자의 앞 왼쪽(A)에 위치함

🎯 정확한 답변 도출!

✨ 왜 이 방법이 효과적인가?

| 항목 | 설명 |

| 추론 유도 | 동일한 마크를 통해 객체 간 시공간 연속성을 유추 가능 |

| 계산 효율 | 전체 프레임이 아니라 일부 선택된 프레임만 처리 |

| 모델 불변성 | 아키텍처 수정 없이, 다양한 MLLM에 적용 가능 |

| 범용성 | open-source 모델(LLaVA 등)에도 학습/추론에 사용 가능 |

| 카메라 방향 무관 | 입력 순서가 바뀌어도 공간 추론 성능 유지됨 |

📌 정리

| 단계 | 핵심 작업 | 목적 |

| 1단계 | 객체 추적 (Tracking) | 객체 ID 대응 관계 추출 |

| 2단계 | 프레임 샘플링 | 계산량 감소 및 주요 정보 유지 |

| 3단계 | 대표 객체 선택 | 정보 과부하 방지 |

| 4단계 | 시각 마크 생성 | MLLM이 객체를 추론할 수 있도록 유도 |

다음은 논문 “Coarse Correspondences Boost Spatial-Temporal Reasoning in Multimodal Language Model”의 실험 결과, 결론, 한계점 및 마무리에 대한 체계적인 정리입니다. 각 요소는 AI 연구자로서 실험적 의의와 실용적 고려사항을 바탕으로 분석하였습니다.

✅ 1. 실험 결과 요약 (Results)

🎯 주요 개선 성능 (주요 벤치마크 기준)

| 벤치마크 |

태스크 | 모델 | COARSE CORRESPONDENCES 성능 향상 |

| ScanQA | 3D 공간 질의응답 | GPT-4V | +11.0 CIDEr+11.3 BLEU-1 |

| GPT-4O | +14.8 CIDEr+4.9 BLEU-1 | ||

| OpenEQA (EM-EQA) | 시공간 기억 기반 QA | GPT-4V | +13.7% 정확도 상승 (44.8 → 58.5) |

| GPT-4O | +9.7% 정확도 상승 (49.4 → 59.1) | ||

| EgoSchema | 롱 비디오 QA | GPT-4O | +6.0% (67.2 → 73.2%) |

| R2R (VLN-CE) | 실내 내비게이션 | GPT-4O | 성공률 +11.0% (12% → 23%) |

| SQA3D | 도메인 외 3D QA | LLaVA | +3.1% (train+test 시) |

📌 특징 요약

- 모든 모델에서 성능 향상 (GPT-4V, GPT-4O, Claude, Gemini, LLaVA)

- 영상 프레임 수는 대폭 줄였지만 성능은 오히려 증가

- 예: GPT-4O는 단 4프레임만으로도 SoTA 모델보다 우수

- Zero-shot 추론에서도 Fine-tuned 3D 모델보다 좋은 성과

🧠 2. 결론 (Conclusion)

🔑 핵심 결론

- 단순한 visual prompting 기법(COARSE CORRESPONDENCES)으로도 MLLM의 3D 공간 및 시간 인식 능력을 크게 향상시킬 수 있음

- 아키텍처 변경, 학습(fine-tuning) 불필요 — inference에서 바로 적용 가능

- 범용성 강함: Open-source 모델과 Closed-source 모델(GPT-4V, Claude 등) 모두에 적용 가능

- 내비게이션, 영상 QA, 3D QA 등 다양한 실세계 태스크에 직접 활용 가능

- 학습 시 데이터 증강(data augmentation) 기법으로도 응용 가능

⚠️ 3. 한계점 (Limitations)

| 항목 | 설명 |

| 📉 시각적 오버레이의 한계 | 마킹이 너무 많거나 클 경우, 시각 정보가 가려져 성능 저하 가능 (ablation 실험에서 확인됨) |

| 🎨 Prompt 해석력 제한 (open-source) | 일부 open-source MLLM은 마크나 시각적 프롬프트를 제대로 해석하지 못함 → fine-tuning 필요 |

| 🎥 영상 처리 한계 | 단순한 프레임 샘플링 기반 접근으로, 복잡한 시계열 변화를 완전하게 반영하진 못함 |

| 🧠 인과추론 부족 | 단순한 correspondence 기반이라 고차원적인 인과관계 추론(causal reasoning)까지는 확장 어려움 |

| 📦 객체 간 정밀 관계 미포함 | point-level이 아닌 instance-level 관계만 다룸 → 미세한 spatial reasoning에는 한계 있음 |

📌 4. 마무리 및 향후 방향

💡 향후 연구 가능성

- Temporal abstraction 확장:

- 시계열 내 의미 단위 이벤트 추출

- MLLM에 high-level dynamics 학습 유도

- Prompt 타입 다양화:

- 텍스트 기반 정보와의 결합 (Hybrid prompt)

- Prompt의 attention 유도 방식 다양화

- Video grounding + Planning 통합:

- Agent 시스템에서 navigation reasoning 또는 instruction-following 강화

- Coarse → Dense 확장:

- 추론 능력이 향상된 모델에서는 dense correspondence도 사용 가능성

🧾 요약 정리

| 항목 | 내용 |

| 주요 성과 | Zero-shot 상황에서 MLLM의 공간·시간 추론 대폭 향상 |

| 기술적 장점 | 아키텍처 변경 없음, 학습 필요 없음, 간단한 시각 프롬프트만으로 성능 향상 |

| 적용 가능 모델 | GPT-4V, GPT-4O, Claude, Gemini, LLaVA 등 다양한 MLLM |

| 적용 가능 태스크 | 3D QA, 영상 QA, 내비게이션 등 실제 환경 기반 문제 해결 |

| 한계 | 너무 많은 마킹은 시각적 오염 발생, open MLLM의 해석력 제한, 정밀한 spatial 관계 처리의 한계 |

| 향후 방향 | 고차원 temporal reasoning, multimodal fusion, agent에 통합한 환경 적응성 증대 가능 |

이 논문은 시각적 대응 관계를 활용한 prompting이 단순히 pretraining만으로도 강력한 시공간 추론 능력을 유도할 수 있다는 점에서, 매우 실용적이면서도 이론적 시사점을 동시에 제공합니다.

정확한 질문 감사합니다.

논문 “Coarse Correspondences Boost Spatial-Temporal Reasoning in MLLMs”서 말하는 "프롬프트에 추가된다"는 것은 텍스트 프롬프트를 수정하는 것이 아니라, 시각적 입력(이미지)에 직접 마크를 삽입하는 방식을 말합니다.

✅ 핵심 결론

Coarse Correspondences는 “프롬프트 텍스트를 수정하지 않고, 이미지 자체에 마크(숫자 또는 도형)를 삽입하여 시각적으로 프롬프트를 구성하는 방식입니다.

즉, 프롬프트는 "텍스트" + "수정된 이미지들"로 구성됩니다.

🔍 구체적으로 어떻게 프롬프트에 추가되는가?

1. 이미지에 직접 마크를 삽입함 (Visual Prompting)

- 예를 들어, 객체 추적 결과 소파가 instance ID 3으로 추적되었다면:

- 해당 프레임 이미지 내 소파의 중심 위치에 "3"이라는 숫자가 적힌 원형 마크를 삽입함

- 이 마크는 크기, 색상, 텍스트 폰트가 고정되어 있어 모델이 시각적으로 쉽게 식별 가능

📌 시각적 프롬프트 예시 (변경된 이미지)

[IMG1: 소파에 "3", 문에 "7", 선풍기에 "39" 마크 표시]

[IMG2: 소파에 "3", 선풍기에 "39" 마크 표시]

2. 텍스트 프롬프트는 그대로 유지하거나, 아주 간단한 형태로 유지

- 논문에서는 텍스트에 좌표나 ID를 명시적으로 추가하지 않습니다.

- MLLM(GPT-4V, GPT-4O 등)은 이미지 내에 동일한 숫자가 다른 프레임에 반복 등장하는 것을 통해 "이 객체는 같은 물체다"라고 추론함.

예를 들어 사용자가 묻는 질문은 다음과 같습니다:

"당신은 소파에 앉아 있고, 선풍기가 왼쪽에 있습니다. 문은 당신의 어느 방향에 있습니까?"

그리고 모델은 이미지 내 마크들(예: "3", "7", "39")를 보고, 시공간적 위치 관계를 유추합니다.

✨ 요약 정리

| 구성 요소 | 내용 |

| 텍스트 프롬프트 | 일반 자연어 질문 그대로 유지 (좌표, ID 추가 없음) |

| 이미지 프롬프트 | 추적된 객체의 중심 위치에 숫자 마크(예: 원형 안에 "3")를 삽입하여 시각 정보 제공 |

| VLM의 역할 | 각 프레임 간 동일 마크 ID를 통해 객체의 시공간 변화를 추론함 |

| 프롬프트 구성 | [텍스트 질의] + [시각적 마킹이 포함된 이미지들] |

💡 추가 아이디어 (당신의 질문에서 파생 가능)

"만약 모델이 숫자 마크만으로 이해하지 못한다면, 텍스트로 해당 숫자의 정체를 명시해주는 것도 도움이 될 수 있을까?"

이 질문은 매우 유효합니다. 그리고 이는 future work로 확장 가능성이 있습니다.

예시 확장 프롬프트:

- 이미지 내 숫자 3은 소파입니다.

- 숫자 7은 문입니다.

- 숫자 39는 선풍기입니다.

이러한 방식은 특히 open-source 모델이 마킹만으로는 추론이 어려울 때, 텍스트 grounding 보조 정보로 활용될 수 있습니다. 실제로 LLaVA 같은 모델에는 이런 식의 training이 필요했습니다.

좋은 관찰입니다. 질문을 정리하자면:

논문 "2. Method" 부분에서, 시각 정보를 변형한 후 다시 LLM에 넣는 것처럼 보이는데,

이 구조는 LLM → 시각 변형 → 다시 MLLM 순서로 후처리하는 것인가요?

❌ 아니요. 이 논문에서 말하는 구조는 그런 후처리 방식(postprocessing)이 아닙니다.

COARSE CORRESPONDENCES는 LLM으로 먼저 처리하고 결과를 다시 multimodal model에 넣는 방식이 아니라,

이미지를 가공한 뒤(Mark 추가 등) 해당 가공된 이미지를 multimodal LLM (MLLM)에 바로 넣는 구조입니다.

🔄 전체 파이프라인 다시 정리

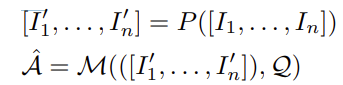

수식 요약:

- 여기서:

- P: 시각적 전처리 함수 (tracking + 마크 삽입 포함)

- M: 멀티모달 언어 모델 (예: GPT-4V, GPT-4O)

- A^: 모델이 생성한 답변

- 즉, MLLM은 가공된 이미지들 [I′]과 질의 Q를 동시에 입력받고, 직접 추론을 수행함.

🔍 왜 혼동될 수 있었는가?

질문하신 부분에서 아래와 같은 표현이 혼동을 줄 수 있습니다:

"We evaluate the prompt by measuring its utility in prompting an MLLM"

이 문장은 “LLM이 먼저 수행한 후 시각 프롬프트로 다시 넣는다”가 아니라,

“시각 프롬프트가 얼마나 MLLM의 reasoning에 도움을 주는지를 평가한다”는 뜻입니다.

즉, LLM → 후처리 → MLLM이 아니라,

시각 전처리(P) → MLLM 추론(𝓜) 순서가 맞습니다.

📌 결론

| 오해 가능 구조 | 실제 구조 (논문 방식) |

| LLM에 먼저 입력 → 뭔가 후처리 → 다시 MLLM에 넣음 | ❌ |

| 이미지 세트를 시각적으로 전처리(P) → 해당 이미지들과 질문을 MLLM에 바로 입력 | ✅ |

추가로, Socratic prompting이나 Chain-of-thought + Captioning 방식에서는

실제로 "이미지를 텍스트로 바꾼 뒤 LLM에 넣고, 다시 LLM 출력을 사용하는 방식"을 취하는 경우가 있습니다.

하지만 이 논문은 End-to-End MLLM을 가정한 구조로,

전처리 후 직접 MLLM에 넣는 것을 전제로 합니다.