https://openreview.net/pdf?id=gjeQKFxFpZ

https://arxiv.org/abs/2306.13063

Can LLMs Express Their Uncertainty? An Empirical Evaluation of Confidence Elicitation in LLMs

Empowering large language models to accurately express confidence in their answers is essential for trustworthy decision-making. Previous confidence elicitation methods, which primarily rely on white-box access to internal model information or model fine-t

arxiv.org

기존 Uncertainty 측정은 화이트박스 모델로 현재 gpt나 클로드에선 사용할 수 없는 방법이다.

이 문제를 더 분석하기 위해 Prompting, Sampling, Aggregation을 통해 Uncertainty를 측정하였다.

여기선 이러한 접근 방법을 Confidence elicitation이라고 명한다.

이 논문에서 사용하는 3가지 구성요소가 포함된 그림이다.

Prompt를 통해 답변의 질을 바꾸고, Confidence도 다양하게 측정해 봅니다.

Aggregation의 전략에는 3가지가 있다.

1. 그냥 단순 등장 횟수

2. 등장 횟수에 confidence 추가

3. top-k 순위 기반인데

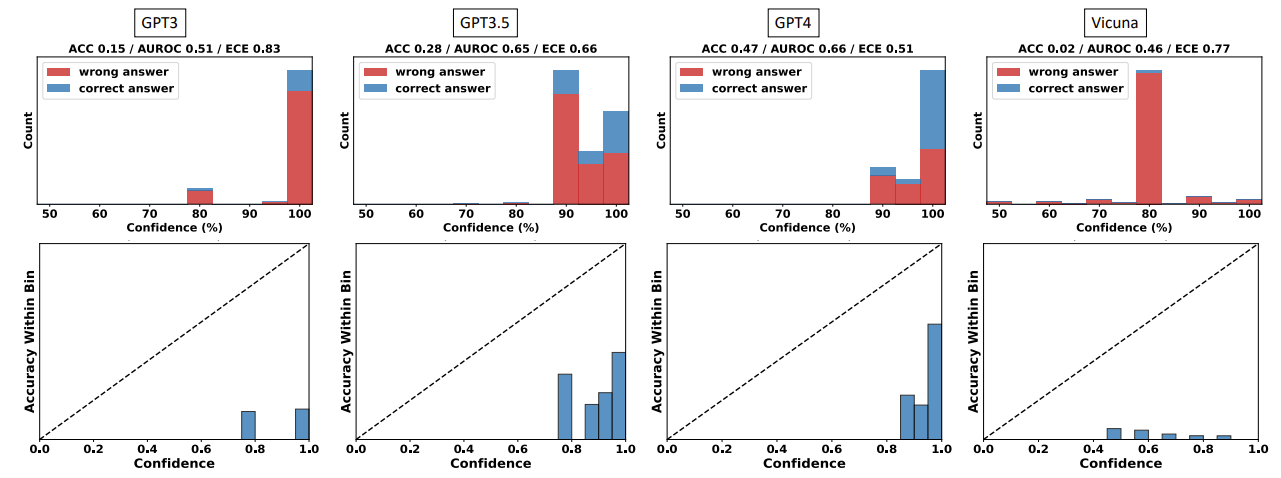

정확도가 낮은 것을 보아 상당히 과신하는 것을 볼 수 있다.

ECE=0이면 모델의 Confidence와 실제 정답이 완벽일치하는 것이고, ECE가 크면 과신하는 것이다.

| 모델 | Accuracy | AUROC | ECE | 해석 |

| GPT-3 | 0.15 | 0.51 | 0.83 | 성능 낮고, confidence가 매우 과신됨. 거의 모든 답이 100%라고 답하지만 실제 정답률은 매우 낮음 |

| GPT-3.5 | 0.28 | 0.65 | 0.66 | 과신은 여전히 존재하나, 정답/오답 구분(AUROC)이 꽤 개선됨 |

| GPT-4 | 0.47 | 0.66 | 0.51 | 정확도 향상과 함께 과신도 개선됨. 실질적 유용성 가장 높음 |

| Vicuna | 0.02 | 0.46 | 0.77 | 거의 랜덤에 가까운 예측. confidence도 엉터리 수준 (80% 확신인데 전부 오답) |

바닐라는 뭘 하든 높은 성능을 보여주진 못 하네요

샘플링도 너무 많이 해봤자 큰 의미 없고 나중에는 수렴한다고 하네요

| 🧠 연구 목적 | LLM이 자신의 답변에 대한 confidence를 표현할 수 있는가?, 특히 black-box 환경에서 가능한지 실증적으로 분석 |

| 🎯 연구 배경 | 기존 confidence 추정 방식은 대부분 **white-box 접근(fine-tuning, token probability 등)**이므로 API-only LLM에는 부적합함 |

| 🧱 제안 프레임워크 | Prompting + Sampling + Aggregation 기반 black-box confidence elicitation framework |

| 🔧 주요 구성 요소 | - Prompting: Vanilla, CoT, Self-Probing, Multi-step, Top-K - Sampling: Self-Random, Misleading, Prompt Variation - Aggregation: Consistency, Avg-Conf, Pair-Rank |

| 📊 평가 과제 | - Confidence Calibration: ECE (정답률과 confidence 일치 정도) - Failure Prediction: AUROC, AUPRC (정오 판별 능력) |

| 📚 사용한 모델 | GPT-3, GPT-3.5, GPT-4, Vicuna-13B, LLaMA 2-70B |

| 📁 데이터셋 유형 | Commonsense (StrategyQA), Arithmetic (GSM8K), Symbolic, Law, Ethics (MMLU 등 총 8개) |

| 🧪 핵심 결과 요약 | - LLM은 **과신(overconfident)**하는 경향 - 모델 규모가 클수록 ECE는 개선, 하지만 failure prediction 성능은 미흡 - Sampling + Aggregation 기법이 가장 효과적 (AUROC 최대 +30% 향상) - Prompting만으로는 성능 향상 한계 |

| 🏆 최고 성능 조합 | Top-K Prompt + Self-Random Sampling + Avg-Conf 또는 Pair-Rank Aggregation → 실용성과 성능 균형 |

| 📈 white-box 비교 | token-likelihood 기반 방법보다 성능은 약간 낮지만 격차는 작음 (AUROC 약 0.52 vs 0.60) → black-box에서도 충분히 실용 가능 |

| ⚠️ 주요 한계 | - Open-ended QA, summarization 미포함 - 계산 비용 및 실시간 적용 고려 부족 - Downstream task 연결 부족 (예: hallucination filtering 적용 예시 없음) |

| 📚 학문적 기여 | - black-box 환경에서의 confidence elicitation에 대한 최초의 통합 프레임워크 제시 - Prompting/Sampling/Aggregation 전략을 모듈화하여 확장 가능 |

| 🔭 향후 연구 방향 | - Open-ended task로 확장 - Hybrid 방식 (부분 white-box 접근) 탐색 - Downstream 응용(예: risk-aware LLM, hallucination filtering) 연계 실험 |

| 💬 핵심 한 줄 요약 | "LLM은 confidence를 표현할 수는 있지만, 아직 정확하진 않다. Black-box에서도 uncertainty 추정은 가능하며, Sampling과 Aggregation이 핵심이다." |

🔍 연구 문제 (What Problem Is Being Solved?)

문제 인식:

- LLM이 자신의 답변에 대한 확신(confidence)을 표현하는 능력은, 신뢰 가능한 AI 시스템 구현에 필수적입니다.

- 하지만 기존의 confidence 추정 방법은 대부분:

- 모델 내부 정보를 요구하는 white-box 접근 방식이나,

- fine-tuning이 필요합니다.

- 이는 GPT-4와 같은 폐쇄형 API LLM에는 적용이 어렵습니다.

연구 질문:

- Black-box 환경(text input/output만 가능한 상황)에서, LLM의 confidence를 추론하거나 표현하는 것은 가능한가?

- 효과적인 방법론은 무엇이며, 이를 어떻게 체계적으로 평가할 수 있는가?

🧠 방법론 (What Methods Were Used?)

🔧 전체 프레임워크 구성 (3단계 구성):

논문은 LLM의 confidence elicitation을 위한 black-box 기반 프레임워크를 제안하며, 이는 다음 3가지 요소로 구성됩니다:

| 구성 요소 | 설명 |

| 1. Prompting | 모델에게 자신감(confidence)을 말로 표현하도록 유도하는 프롬프트 설계 |

| 2. Sampling | 동일 질문에 대해 여러 응답을 생성함으로써 불확실성 관찰 |

| 3. Aggregation | 여러 응답으로부터 최종 confidence score를 산출하는 집계 방법 |

🧾 1. Prompting Strategy (프롬프트 전략)

- Vanilla: 단순히 답변 + confidence를 말하도록 유도

- Chain-of-Thought (CoT): 단계적 사고를 유도한 후 confidence 표현

- Self-Probing: 이미 생성된 답변에 대해 "이 답변이 맞다고 생각하나?"를 다시 물음

- Multi-step: 문제를 step으로 나눠 각 단계의 confidence를 합성하여 최종 confidence 도출

- Top-K: 가능한 K개의 답을 제시하고 각각의 확률을 함께 출력

🧠 핵심 아이디어: 인간의 confidence 표현 습관을 모사하여 LLM이 불확실성을 보다 의미 있게 verbalize 하도록 유도

🎲 2. Sampling Strategy (샘플링 전략)

- Self-Random: 같은 질문을 여러 번 입력하여 자연스러운 확률 분산 유도

- Prompting Variation: 질문을 다양하게 바꾸어 여러 응답 생성

- Misleading: 일부러 오답 가능성이 있는 힌트를 줘서 모델의 반응을 유도

🧠 핵심 아이디어: 모델의 응답 다양성을 통해 불확실성(uncertainty)의 신호를 포착

📊 3. Aggregation Strategy (응답 집계 전략)

- Consistency: 동일한 답변이 얼마나 자주 등장하는지로 confidence 측정

- Avg-Conf: verbalized confidence를 가중치로 이용하여 응답 일치도를 계산

- Pair-Rank: Top-K 응답의 순서를 바탕으로 pairwise ranking 기반 분포 추정

🧠 핵심 아이디어: verbalized confidence와 응답 일치도를 함께 고려하면 더 나은 예측이 가능

🧪 실험 설계

평가 항목:

- Calibration: confidence와 실제 정확도 일치도 (ECE로 측정)

- Failure Prediction: 정답/오답을 confidence로 분류할 수 있는 능력 (AUROC, AUPRC로 측정)

데이터셋 유형:

| 유형 | 데이터 셋 |

| Commonsense | StrategyQA, SportsUnderstanding |

| Arithmetic | GSM8K, SVAMP |

| Symbolic | DateUnderstanding, ObjectCounting |

| Professional | MMLU - Law |

| Ethics | MMLU - Business Ethics |

모델:

- GPT-3, GPT-3.5, GPT-4, Vicuna-13B, LLaMA2-70B

📈 실험 결과 (What Were the Results?)

1️⃣ LLM은 대체로 과도하게 자신감 있음

- confidence가 거의 항상 80~100%이며, 5의 배수로 표현됨

- 인간처럼 자신감 표현하는 것을 학습했을 가능성

2️⃣ 프롬프트 전략은 부분적인 개선

- CoT, Self-Probing, Top-K 등은 ECE 개선에 효과

- 그러나 AUROC는 여전히 낮음 → 오답 예측은 어려움

- 정답/오답의 confidence 차이가 크지 않음

3️⃣ 샘플 수 증가 → failure prediction 개선

- Self-Random + Aggregation으로 AUROC 92.7%까지 향상 (GSM8K 기준)

- 샘플 수 M 증가 시 성능은 개선되지만, 수렴 구간 존재

4️⃣ Aggregation 방식에 따라 최적 목표 달라짐

- Pair-Rank → calibration (ECE↓)에 강점

- Avg-Conf → failure prediction (AUROC↑)에 강점

- Consistency-only 방식은 가장 성능이 낮음

✅ 결론 및 실무 권장 사항 (Takeaways)

📌 주요 결론:

- Verbalized confidence는 지나치게 낙관적이고, 아직 실무에서 단독으로 쓰기엔 부족

- 샘플링과 aggregation 기법을 조합하면 실용적인 성능 확보 가능

- White-box vs Black-box 성능 격차는 좁지만, 전반적으로 둘 다 아직 미흡

🔧 실무 권장 조합:

- Top-K Prompt + Self-Random Sampling + Avg-Conf 또는 Pair-Rank Aggregation

| 목적 | 추천 조합 |

| Calibration 중심 | Pair-Rank Aggregation |

| Failure Prediction 중심 | Avg-Conf Aggregation |

📌 향후 연구 방향

- Open-ended QA, summarization 등으로 확장 필요

- 부분 white-box 정보 활용하는 hybrid 접근법 가능성 있음

- Training 데이터 내 인간의 부정확한 uncertainty 표현이 문제일 수 있음 → 학습 커리큘럼 개선 필요

원하시면 각 프롬프트 전략별 예시, 실험 그래프 분석, 구현 방식 및 개선 아이디어까지 확장해서 정리해드릴 수 있습니다. 이 논문을 바탕으로 연구 계획을 세우고 싶으시다면, 어떤 task나 응용 목표를 염두에 두고 계신지도 알려주세요.

물론입니다. 아래는 ICLR 2024 논문 "Can LLMs Express Their Uncertainty?"를 기반으로 한 관련 연구(related works) 및 이 논문의 차별점(differences)에 대한 상세한 설명입니다.

🔍 관련 연구 (Related Works)

LLM의 불확실성 표현(confidence elicitation)과 관련된 연구들은 주로 다음 두 방향으로 나뉩니다:

1. White-box 기반 불확실성 추정

모델 내부 정보(logits, token probability 등)에 접근할 수 있는 경우:

- 🔧 Token-likelihood 기반 방법: 각 토큰의 확률을 기반으로 전체 문장의 확률 또는 특정 정답 토큰의 확률을 추정하여 confidence 계산

- 예: Kadavath et al., 2022, Malinin & Gales, 2020

- 🔧 Calibration 기법: 모델 출력과 실제 정답 간의 차이를 보정하는 기술

- 예: Guo et al., 2017 (temperature scaling), Jiang et al., 2021

👉 하지만 GPT-4처럼 내부 정보를 제공하지 않는 폐쇄형 API에서는 사용할 수 없습니다.

2. Black-box 기반 불확실성 추정

모델 입출력만 사용 (open API 대응):

- 🧾 Verbalized Confidence (언어로 confidence 표현 유도):

- Lin et al., 2022: LLM이 직접 확률을 말하도록 유도. 다만 fine-tuning 필요.

- 🧠 Prompting을 통한 confidence 유도:

- Tian et al., 2023: 다양한 prompting 방식으로 모델이 잘 calibrated 되도록 유도 (CoT, Top-K 등)

- 📊 External Calibrator (보조 모델을 학습시켜 confidence 추정):

- Mielke et al., 2022: GPT output을 입력으로 받아 confidence를 추정하는 별도 모델 훈련 → 하지만 내부 hidden state 필요

✨ 본 논문의 차별점 (How This Work Differs)

| 구분 | 기존 연구 | 본 논문 |

| 접근 방식 | 대부분 white-box 방식 (내부 토큰 확률 사용) | 완전 black-box 환경에서 confidence 추정 가능성 탐색 |

| 모델 사용 범위 | 특정 모델(예: GPT-2, GPT-3) 또는 RLHF fine-tuned 모델에 한정 | GPT-3, 3.5, 4, LLaMA2, Vicuna 등 다양한 scale의 모델에 적용 |

| 전략 다양성 | Prompt 기반 일부 실험 (Top-K 등) | Prompting + Sampling + Aggregation 전략을 체계적으로 분해 및 통합 |

| 평가 지표 | Calibration 위주 (ECE 중심) | Calibration(ECE) + Failure Prediction (AUROC, AUPRC) 다면적 평가 |

| 실험 범위 | 비교적 적은 task에 제한됨 | 5개 task 유형 × 8개 dataset × 5개 모델을 아우르는 대규모 실험 |

| Verbalized confidence 평가 | 간단한 표현 수준 | **사람처럼 confidence를 표현하는 경향(80~100% 5의 배수)**을 실증적으로 분석 |

📘 논문별 대표 요약 비교

| 논문 | 주요 아이디어 | 한계 |

| Lin et al. (2022) | LLM이 직접 confidence를 verbalize 하도록 fine-tuning | fine-tuning 필요, zero-shot generalization 안됨 |

| Mielke et al. (2022) | external calibrator 학습 → output으로부터 confidence 추정 | white-box 필요 (hidden state 활용) |

| Tian et al. (2023) | prompting 전략(Top-K 등)을 사용한 zero-shot calibration | 특정 prompting에 국한, framework 수준의 확장은 부족 |

| 본 논문 | prompting/sampling/aggregation을 아우르는 통합 프레임워크 제안 및 비교 평가 | black-box만으로는 한계 존재, 전문지식 task에는 여전히 부정확 |

🔚 요약

- 이 논문은 기존 연구들이 fine-tuning 또는 모델 내부 접근에 의존하는 경향이 있던 반면,

- "진정한 black-box" 환경에서도 LLM이 스스로 confidence를 표현할 수 있는가?라는 질문을 처음으로 대규모 실험 + 체계적인 구성으로 분석했습니다.

- 다양한 전략 조합을 통해, 실무적 효율성과 이론적 정합성 사이의 균형점을 제시한 점에서 기존 연구 대비 확장성과 실용성 모두에서 강점을 가집니다.

더 깊이 있는 분석(예: 각 논문 수식 비교, Top-K 방식의 한계, CoT+Self-Random 실험 비교 등)이 필요하시면 말씀해주세요. Fine-tuning 기반 방법과의 정량적 성능 비교도 정리해드릴 수 있습니다.

🧠 핵심 목표:

LLM이 답변할 때 자신이 얼마나 확신하고 있는지(confidence)를 black-box 환경에서도 정확히 추론하거나 표현하도록 만드는 것.

⚙️ 전체 프레임워크 개요

이 논문은 LLM의 불확실성을 추론하는 시스템을 다음 3가지 핵심 컴포넌트로 나누어 설명합니다:

✅ 1. Prompting Strategy (프롬프트 전략)

모델에게 "답과 함께 자신감(confidence)을 말하라"고 요청하는 방법

✅ 2. Sampling Strategy (샘플링 전략)

동일 질문에 대해 여러 개의 응답을 생성함으로써 답변 분산 정도로부터 불확실성을 추정

✅ 3. Aggregation Strategy (집계 전략)

여러 개의 응답 결과와 confidence를 통합하여 최종 confidence score를 산출

🔍 Step-by-Step: 프레임워크 구성 자세히 보기

✅ 1. Prompting Strategy

LLM에게 다음과 같은 프롬프트(prompt)를 주어 자신의 확신 수준을 verbalize하게 유도합니다.

📌 대표적인 프롬프트 종류:

| 방법 | 설명 | 예시 |

| Vanilla | "답과 자신감을 숫자로 말해줘" | Q: 2+2 = ? A: 4, 100% |

| Chain-of-Thought (CoT) | 단계적으로 생각하고 마지막에 confidence 말함 | Q: 2+2? A: 생각: 2+2는 4니까 → 정답: 4,Confidence: 100% |

| Self-Probing | 주어진 답이 맞는지 평가하게 유도 | Q: “2+2=5”라는 답이 있어. 얼마나 맞다고 생각해? A: 잘못된 추론 같음 → Confidence: 20% |

| Multi-step | reasoning 과정을 나눠 각 단계에 confidence 부여 | Step1: 2는 짝수 (100%) Step2: 2+2 = 4 (95%)→ 최종 Confidence: 95% |

| Top-K | 여러 개의 답과 각각의 확률을 말하게 함 | A1: 4 (80%) A2: 5 (10%) A3: 3 (10%) |

📌 인사이트:

- Vanilla는 간단하지만 과신(overconfidence) 경향 있음.

- CoT, Self-Probing은 사고 과정과 신뢰 간 관계를 유도함.

- Top-K는 불확실성 분포를 반영하기에 좋음.

✅ 2. Sampling Strategy

같은 질문에 대해 다양한 답변을 수집하여 불확실성을 추론

📌 주요 방법:

| 전략 | 설명 | 예시 |

| Self-Random | 동일 질문을 반복해서 입력 → 생성 결과 다양성 활용 | "What is 17×23?"을 5번 물음 → [391, 391, 390, 391, 389] |

| Prompt Variation | 질문을 살짝 다르게 바꿔서 입력 | “What is 2+2?” / “Calculate two plus two” 등 |

| Misleading Prompt | 오답을 암시하는 힌트 포함 | Q: “내 생각엔 답이 5인 것 같아. 너는 어떻게 생각해?” |

📌 인사이트:

- 답변 간 variance가 높을수록 모델은 불확실한 상태

- 사람처럼, LLM도 오답 힌트에 약해지면 불확실하다는 신호로 해석 가능

✅ 3. Aggregation Strategy

여러 응답을 모아 최종 confidence score를 계산하는 방법

📌 대표적인 집계 방식:

| 방법 | 설명 | 계산 방식 |

| Consistency | 동일한 답이 얼마나 많이 나왔는가 | 5개의 답 중 3개가 "391" → confidence = 3/5 = 60% |

| Avg-Conf | 응답별 verbalized confidence를 가중 평균 | "391"이 3회, 각각 90%, 80%, 70% → weighted 평균 |

| Pair-Rank | Top-K 응답 간 순위 정보를 MLE 기반으로 추론 | "391>392>389" → pairwise 비교로 확률 분포 학습 |

📌 예시 시나리오:

- 모델이 “17×23 = 391”을 세 번 말했고, 각각 90%, 80%, 70%의 confidence를 부여했다면:

- Avg-Conf = (0.9 + 0.8 + 0.7) / 3 = 80%

- Consistency = 3/5 = 60%

- Pair-Rank = 전체 순위 간 비교를 통해 더 정교한 추정

💡 실제 적용 예시

문제: “17 × 23은 얼마인가요?”

✨ 모델 응답들 (sampling 5회):

응답 Confidence| 391 | 90% |

| 391 | 80% |

| 390 | 70% |

| 391 | 60% |

| 389 | 40% |

🔢 Aggregation 예시:

- Consistency = 3/5 → 60%

- Avg-Conf (391 기준) = (90+80+60)/3 = 76.7%

- Pair-Rank → 391이 항상 1위면 P(391) ≈ 85~90%

→ 최종적으로 "391"이라는 답을 85% 확신이라고 추정할 수 있음

🎯 요약 정리 (표 형태)

컴포넌트 목적 주요 방법 효과| Prompting | 언어로 confidence 유도 | Vanilla, CoT, Top-K 등 | 사람처럼 확신 표현 유도 |

| Sampling | 응답 다양성으로 불확실성 추정 | Self-Random, Misleading | 확신 낮은 질문일수록 응답 다양성 ↑ |

| Aggregation | 여러 응답을 종합하여 최종 confidence 산출 | Consistency, Avg-Conf, Pair-Rank | 정답일 확률 수치화 |

✅ 결론

이 프레임워크는 LLM의 confidence를 언어로 직접 묻고, 반복 질문을 통해 그 일관성(consistency)을 측정하고, 이를 수치화하여 calibration/failure prediction에 활용할 수 있도록 설계된 것입니다.

이는 기존의 white-box 방식에서 벗어나, API-access-only 환경에서도 신뢰 가능한 AI 시스템 구축에 필요한 불확실성 추론을 실현한다는 점에서 의미 있는 진보입니다.

✅ 결과 요약 (Experimental Results Summary)

논문은 제안된 프레임워크(Prompting + Sampling + Aggregation)를 바탕으로 다음 두 가지 주요 task에서 성능을 평가했습니다:

- Confidence Calibration

- 평가 지표: Expected Calibration Error (ECE)

- 목표: 모델의 confidence가 실제 정답률과 얼마나 잘 맞는지

- Failure Prediction

- 평가 지표: AUROC, AUPRC-Positive, AUPRC-Negative

- 목표: 모델이 정답과 오답을 confidence로 구별할 수 있는지

🎯 주요 결과

📌 1. LLM은 기본적으로 과도한 자신감을 보임 (Overconfidence)

- Vanilla prompt 기반 verbalized confidence는 대부분 80~100%의 confidence로 표현됨

- 특히 5의 배수 형태가 많아, 인간 표현 방식을 모방한 것으로 보임

- 실제 정답 여부와 관계없이 높은 confidence → calibration error (ECE) 큼

📌 2. 모델 크기가 클수록 calibration과 failure prediction은 개선되나, 여전히 불완전

- GPT-3 < GPT-3.5 < GPT-4 순으로 전반적 성능 향상

- GPT-4의 경우 ECE는 낮아졌지만, AUROC (failure prediction)은 62.7% 수준 → 랜덤 추측(50%)보다는 낫지만 부족

📌 3. Prompting 전략은 일부 개선 효과 있음

- CoT, Self-Probing, Top-K 등은 vanilla보다 ECE 개선에 효과

- 하지만 AUROC은 큰 개선 없음 → confidence가 잘 맞더라도 정답/오답 구분은 여전히 어려움

📌 4. Sampling + Aggregation 전략이 failure prediction 성능을 크게 향상시킴

- 예: GSM8K에서 CoT+Self-Random Sampling+Consistency Aggregation을 사용하면 AUROC이 54.8% → 92.7%로 상승

- 응답 개수가 많을수록 성능이 향상되지만, M=5~7 정도에서 수렴

📌 5. Aggregation 방식은 목적에 따라 선택 필요

| Aggregation | 장점 | 용도 |

| Pair-Rank | 낮은 ECE → 잘 calibrated됨 | 위험도 평가, 신뢰 기반 선택 |

| Avg-Conf | 높은 AUROC → 실패 예측에 강함 | hallucination 탐지, selective generation |

| Consistency | 단순하지만 성능 낮음 | baseline용 |

✅ 결론 (Conclusion)

논문에서 강조한 결론은 다음과 같습니다:

📌 1. LLM은 "자신의 불확실성"을 표현할 수는 있지만, 정확하지는 않다

- Verbalized confidence는 사람처럼 말하지만, 잘 calibrated되지 않음

- 오답조차도 100% confident로 답변하는 경우 다수 존재

📌 2. Prompt만으로는 부족하고, Sampling + Aggregation의 결합이 효과적

- 특히 Sampling 기반 방법은 white-box 기법(예: token probability)과 비교해도 큰 성능 차이가 나지 않음

- → black-box 환경에서도 신뢰성 추정 가능성 입증

📌 3. 모든 방법이 복잡한 task (예: 법률, 윤리 문제)에서는 여전히 한계

- 즉, 모델이 스스로 자신을 의심하는 메커니즘은 아직 완전하지 않음

- 전문 지식이 필요한 영역에서 confidence 판단 능력이 크게 떨어짐

🧩 마무리 및 향후 연구 방향 (Discussion & Future Work)

🛠 실무자 권장 조합 (Best Practice Recommendation)

- Top-K Prompt + Self-Random Sampling + Avg-Conf 또는 Pair-Rank Aggregation

- 목적에 따라 aggregation 전략을 선택하라는 명확한 가이드 제시

⚠️ 한계 (Limitations)

- 정답이 유일하지 않거나 open-ended한 질문에는 적용 불가

- 일부 sampling 전략은 계산량이 많아 실무 적용 어려움

- verbalized confidence의 학습 자체가 부정확한 인간 표현에 기반

🔭 향후 연구 방향

- Summarization, Multi-modal QA, open-ended generation 등 복잡한 task로 확장

- 부분 white-box 정보 활용하는 hybrid 방식 고려 (ex: GPT-3의 logit 정보 일부 활용)

- 학습 데이터 자체의 uncertainty 표현 강화 (예: human-annotated confidence corpus 구축)

✅ 요약 한 줄 정리

LLMs는 자신이 얼마나 확신하는지를 말할 수는 있지만, 그것을 "정확히 판단"하지는 못한다.

Sampling + Aggregation을 통해 black-box 환경에서도 이를 보완할 수 있으며, calibration과 failure prediction을 분리해 접근하는 것이 핵심 전략이다.

🧠 논문 타당성 평가: 전체 검토 관점에서

✅ 1. 연구 동기 및 문제 설정의 타당성

| 항목 | 검토 내용 |

| 연구 문제의 명확성 | “LLM이 자신감(confidence)을 얼마나 정확하게 표현할 수 있는가”라는 질문은 명확하며, GPT-4 등 상용 API 모델의 확산에 따라 중요한 문제임 |

| 기존 연구와의 차별화 | 기존 연구가 fine-tuning 또는 white-box 환경에 집중된 반면, 이 논문은 완전한 black-box 환경을 대상으로 하여 현실적인 문제 해결 방향 제시 |

| 연구의 필요성 | ChatGPT, Claude 등 실사용 모델들이 내부 로그 확률을 제공하지 않기 때문에, black-box에서 confidence를 추정하는 기술은 실질적 응용에서 절실히 필요함 |

➡️ 결론: 문제 설정이 타당하고, 현실적 필요에 기반한 잘 정의된 연구

✅ 2. 프레임워크 및 방법론의 완성도

| 항목 | 검토 내용 |

| 모듈화 구조 | Prompting, Sampling, Aggregation이라는 깔끔한 3요소 모듈 구성은 명료하고 확장성 있음 |

| 방법론의 일반화 가능성 | 다양한 prompting/sampling 기법을 조합 가능한 형태로 분해했기 때문에 새로운 전략을 쉽게 추가 가능함 |

| 수학적 정합성 | Pair-Rank aggregation은 MLE 기반으로 정교하게 정의되어 있고, 수식 유도도 정확함 (Proposition 3.1 증명 포함) |

| 기술적 난점 고려 | Token likelihood 기반 white-box 방식과 비교하면서, black-box 접근이 의미 있는 이유를 충분히 논증 |

➡️ 결론: 이론적 설계와 실제 응용이 모두 강건함

✅ 3. 실험 설계의 적절성

| 항목 | 검토 내용 |

| 모델 다양성 | GPT-3, GPT-3.5, GPT-4, Vicuna-13B, LLaMA2-70B 등 다양한 크기와 아키텍처의 모델 사용 |

| 데이터셋 다양성 | Arithmetic (GSM8K), Commonsense (StrategyQA), Symbolic, Law, Ethics 등 5개 영역, 8개 데이터셋 사용 |

| 평가지표의 정당성 | Calibration(ECE), AUROC, AUPRC-P/N 등 다양한 지표로 다각도 평가 |

| 실험 반복성 | Sampling 수(M=1~13)에 따른 성능 변화를 정량적으로 분석 (Figure 7 등), 매우 정교한 세팅 |

| Baseline 적절성 | white-box baseline(토큰 확률 기반)과의 직접 비교도 수행하여 성능 차이 분석 (Appendix B.1) |

➡️ 결론: 실험 설계는 매우 체계적이며, 다각도로 robustness를 확보

✅ 4. 결과 해석 및 논리 전개

| 항목 | 검토 내용 |

| 데이터 해석의 정확성 | Confidence 분포 분석 결과에서 "80~100%, 5의 배수" 현상을 인간 표현 방식 학습 결과로 해석 → 매우 설득력 있음 |

| 지표 해석 정합성 | ECE 감소가 꼭 failure prediction 능력 향상은 아님을 강조 → 지표에 대한 명확한 인식 |

| 한계 인식 | 전문 지식이 필요한 task에서 실패 예측 성능이 낮음을 인정하고, 이후 연구 방향으로 제시 |

➡️ 결론: 결과 해석이 데이터 기반이며, 약점도 투명하게 기술됨

✅ 5. 누락된 요소 또는 개선 여지

| 항목 | 검토 내용 |

| ❗ Open-ended task 미포함 | Summarization, open QA 등 정답이 명확하지 않은 문제에 대한 confidence 표현은 미포함 → 후속 연구 과제로 제시했지만, 연구 확장성이 다소 제한됨 |

| ❗ 실제 downstream task와의 연결 부족 | Failure prediction이 어떤 downstream task에 어떻게 쓰이는지 예시 부족 (예: LLM filtering, hallucination mitigation 등) |

| ❗ Zero-shot vs Few-shot 차이 비교 없음 | Prompting 전략이 few-shot일 때 성능이 어떻게 변하는지도 추가되면 좋았을 것 |

| ⚠ Aggregation 전략 계산 비용 고려 부족 | Pair-Rank는 MLE 최적화가 필요하므로 계산 비용에 대한 언급이 조금 더 있었으면 좋았음 |

➡️ 결론: 논문이 매우 탄탄하지만, 실제 시스템 적용 시나리오, 계산 비용 고려 등 몇 가지 현실적 요인 보완 여지 존재

🧾 종합 평가 (요약 표)

| 평가 항목 | 평가 | 비고 |

| 연구 문제의 명확성 | ✅ 매우 우수 | 현실과 연결됨 |

| 방법론의 설계 | ✅ 매우 우수 | 프레임워크화 성공 |

| 실험 설계 | ✅ 매우 우수 | 모델, 데이터, 지표 모두 풍부 |

| 결과 해석 | ✅ 우수 | 정량적 & 정성적 분석 균형 |

| 타 논문 대비 차별성 | ✅ 강함 | black-box 특화 + 프레임워크 통합 |

| 누락/한계 | ⚠ 일부 존재 | Open QA, 실용적 연결 부족 |

✅ 최종 결론

이 논문은:

- 문제 정의가 명확하고,

- 프레임워크가 설계적으로 강건하며,

- 실험 또한 풍부하고 재현 가능한 구조로 되어 있으며,

- 결과 해석과 한계 인식도 정확합니다.

📌 결론적으로, 이 논문은 ICLR 수준의 톱 티어 논문으로 충분한 가치가 있으며, black-box 환경에서 LLM 신뢰도를 추론하는 연구의 탄탄한 기준선(baseline) 역할을 합니다.

필요하시다면 이 논문을 기반으로 후속 연구 아이디어, 혹은 실제 LLM 시스템에 confidence calibration을 접목시키는 설계방안도 도와드릴 수 있습니다. 어떤 방향으로 확장해보고 싶으신가요?