https://arxiv.org/abs/2411.10979

VidComposition: Can MLLMs Analyze Compositions in Compiled Videos?

The advancement of Multimodal Large Language Models (MLLMs) has enabled significant progress in multimodal understanding, expanding their capacity to analyze video content. However, existing evaluation benchmarks for MLLMs primarily focus on abstract video

arxiv.org

Abstract

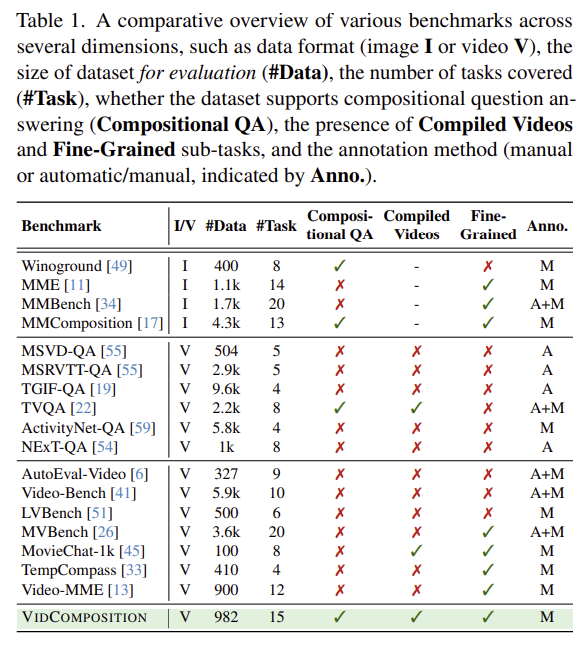

Multimodal LLM(MLLMs)는 상당히 발달했고, 비디오 콘텐츠 분석하는 능력도 생겼다. 그러나 기존 벤치 마크는 abstract한 비디오 이해에 초점을 맞추고 있었으며, composition을 이해하는 능력, 시각적 요소가 고도로 컴파일된 비디오 컨텍스트 내에 상호작용하는 방식의 미묘한 해석에 대한 평가가 부족하다

-> 새로운 벤치마크인 VidComposition은 카메라 움직임, 각도, 샷 크기, narrative 구조, Action 및 감정 등 다양한 측면을 다루는 982 비디오가 포함된 객관식 문제다.

비디오 구성 이해의 5가지 측면과 15가지 task 수행을 통해 MLLM의 성과를 보여준다.

Intro

MLLM은 Multi-Modality를 이해하는 능력이 크게 향상되었으나 현재 MLLM의 벤치마크는 비디오 구성 즉 시각적 요소가 어떻게 결합되고, 컴파일된 비디오 내에서 상호작용하는지에 대한 미묘한 해석에 대해 자세한 설명이 부족하다.

Compiled Video = 영화, TV, Vlog와 같이 여러 화면들이 합쳐지고, 편집된 비디오

이러한 Compiled Video는 매끄러운 흐름을 만들기 위해 제작되었으며 더 많은 구성을 포함하고 있어 분석 능력이 필요하다.

이 Figure를 통해 어떻게 영상을 어떻게 5가지 요소로 나누었는지, 그 5가지에서 15개의 task로 나누었는지 확인할 수 있습니다.

좋습니다. 업로드해주신 Figure 2는 논문 VIDCOMPOSITION의 핵심 구성요소인 15가지 세부 태스크(Task)와 이를 포함한 5개 대분류 영역을 시각적으로 정리한 매우 중요한 도식입니다. 아래에 각 요소에 대한 전문가 관점의 설명을 추가하여 상세히 해설드리겠습니다.

🖼️ Figure 2 설명: VIDCOMPOSITION의 QA 태스크 체계 시각화

🧩 개요

이 도식은 VIDCOMPOSITION 벤치마크가 다루는 총 15개의 고품질 QA 태스크를 5가지 주요 영상 구성 요소(aspects)로 나누어 제시한 것입니다.

| 🎥 Cinematography Analysis | 카메라의 움직임, 앵글, 샷 크기 등 촬영 기법 분석 |

| 👥 Character Understanding | 인물의 감정, 동작, 복장, 소품 등 캐릭터 중심 해석 |

| 📖 Narrative Understanding | 장면의 플롯 순서, 스크립트 일치 여부 등 이야기 흐름 이해 |

| 🖼️ Scene Perception | 배경, 조명, 장면 수 등 장면 속 구성 요소 분석 |

| 🛠️ Making Analysis | 예술 스타일, 특수 효과, 컷 수 등 제작 기술 분석 |

🔍 5개 대분류 및 하위 태스크 상세 해설

🎥 1. Cinematography Analysis (시네마토그래피 분석)

| ① Camera Movement Perception | 카메라가 줌 인/아웃, 팬, 고정인지 구분 | Zoom in, pan left 등 |

| ② Shot Size Perception | 장면의 샷 크기 인식 (클로즈업, 롱샷 등) | medium shot, close-up |

| ③ Camera Angle Perception | 앵글이 버즈아이, 로우앵글, 오버숄더인지 판단 | worm's eye view 등 |

🎬 전문가 예시: 감독은 감정을 강조하기 위해 ‘클로즈업 + 로우 앵글’을 사용한다. 모델은 이를 정확히 파악해야 한다.

👥 2. Character Understanding (인물 이해)

| ④ Emotion Perception | 등장 인물의 감정 식별 | fear, sadness 등 |

| ⑤ Action Perception | 행동 유형 식별 (운전, 대화 등) | running, driving 등 |

| ⑥ CMP (Costume, Makeup, Props) Perception | 복장, 메이크업, 소품 구분 | coat, hammer 등 |

| ⑦ Character Counting | 장면 속 등장인물 수 세기 | 4명 |

🎭 전문가 예시: 특정 장면에서 등장 인물 수를 인식하고, 소품이 캐릭터 성격을 어떻게 드러내는지 판단

📖 3. Narrative Understanding (서사 이해)

| ⑧ Script Matching | 대사나 설명이 어떤 장면에 대응되는지 추론 | Anna tried to open... |

| ⑨ Plot Ordering | 여러 장면 순서를 맞추기 | (2)(3)(1)(5)(4) 등 |

📚 전문가 예시: 컷의 순서와 내러티브 흐름이 어긋나 있을 때, 이를 재구성하여 의미를 복원해야 함

🖼️ 4. Scene Perception (장면 인식)

| ⑩ Background Perception | 배경이 호수, 숲, 설원인지 식별 | snow-covered landscape 등 |

| ⑪ Scene Counting | 서로 다른 씬(로케이션, 환경 등) 수 세기 | 2 |

| ⑫ Lighting Perception | 조명의 조도, 색감, 분위기 파악 | high-key, low-key 등 |

💡 전문가 예시: 낮은 조도 + 블루 필터 → 우울한 분위기 암시

🛠️ 5. Making Analysis (제작 분석)

| ⑬ Art Style Perception | 아트 스타일 분류 (2D 셀, CG 등) | Japanese cel anime 등 |

| ⑭ Cut Counting | 영상의 컷 수 세기 | 15 컷 |

| ⑮ Special Effect Perception | 눈, 비, 폭발 등 특수효과 감지 | explosion 등 |

🎨 전문가 예시: 셀 애니메이션과 3D 렌더링을 구분하는 것은 영상 스타일 이해에 필수

✅ 요약 정리

| 목적 | MLLMs가 영상의 구성적 요소를 얼마나 정밀하게 이해하는지 평가 |

| 구성 | 15개의 QA 태스크로, 영상의 5대 요소를 세분화 |

| 방식 | 각 태스크마다 다지선다형 질문(MCQ) + 시각적 입력 |

| 특징 | 시네마토그래피 이론 기반으로 실제 감독/편집자 시야를 모델에 요구 |

| 중요성 | 단순한 객체 인식 → 편집, 연출, 내러티브 구성까지 아우르는 AI 해석 능력 측정 가능 |

Figure 2는 논문의 전체 구성과 연구 목적을 시각적으로 가장 압축적으로 담고 있는 핵심 도식입니다.

이 구조를 이해하는 것은 후속 연구에서 어떤 방향으로 벤치마크를 확장하거나, 세부 태스크를 수정할 것인지 결정하는 데 매우 중요합니다.

첫 번째 그룹의 벤치마큰 정적 이미지에 초점을 맞춰 시각적 콘텐츠의 동적 측면을 간과

두 번째 그룹은 질문 유형이 제한되어 MLLM의 특정 한계를 해결하는데 덜 효과적

세 번째 그룹은 비디오 이해 능력을 평가하기 위해 개발되었지만 여전히 제한적이고, 자연스러운 영상으로 컴파일된 비디오를 효과적으로 해석하는데 어려움을 겪는다.

이러한 기존 방법과의 격차를 통해 VidDecomposition을 소개!

982개의 비디오, 1706개의 객관식 문제

| Main Category | Sub-tasks | 약어 |

| 🎬 Cinematography Analysis (CA) | ① Camera Movement Perception | CamM-P |

| 촬영 분석 | ② Shot Size Perception | SS-P |

| ③ Camera Angle Perception | CamA-P | |

| 👤 Character Understanding (CU) | ④ Emotion Perception | E-P |

| 캐릭터 이해 | ⑤ Action Perception | A-P |

| ⑥ Costume, Makeup, and Props Perception | CMP-P | |

| ⑦ Character Counting | Cha-C | |

| 📖 Narrative Understanding (NU) | ⑧ Script Matching | S-M |

| 서사 이해 | ⑨ Plot Ordering | P-O |

| 🖼️ Scene Perception (SP) | ⑩ Background Perception | B-P |

| 장면 인식 | ⑪ Scene Counting | S-C |

| ⑫ Lighting Perception | L-P | |

| 🛠️ Making Analysis (MA) | ⑬ Art Style Perception | AS-P |

| 제작 분석 | ⑭ Cut Counting | Cut-C |

| ⑮ Special Effect Perception | SE-P |

데이터는 평균 20분, 자막이나 스크립트가 있으면 시작과 끝의 타임 스탬프 추출

이 데이터를 794프레임으로 일관된 섹션으로 세분화 및 오디오 제거...? 왜!

AP, EP, CMP-P, BP, Cha-C, SC, Cut-C와 같은 작업은 사람들이 잘못된 옵션과, 정답을 작성

CamM-P, SS-P, CamA-P, LP, SE-P, AS-P는 선택 가능한 레이블 세트 제공해서 답 고르기

SM은 자막 파일에서 추출한 해설 스크립트가 GT고 나머진 주변 스크립트에서 그럴듯한 대안 만들기

PO는 해설 스크립트를 여러 부분으로 분할, 섞어 질문에 삽입 -> 정답이 원래 스크립트 순서, 다른 옵션은 무작위 지정

피드백을 통해 오류 최소화, 명확성 개선

Inference를 진행하기 위해 미리 정의된 프롬프트 탬플릿 P를 사용하며 질문과 옵션 O_q를 포함하고 있음

그렇게 구성된 프롬프트 I_q는 모델 M에 들어가 하나의 옵션을 고르거나 확률 적으로 높은 쪽을 선택한다. 만약 매칭이 없다면 랜덤 선택으로 수행하기도 한다.

그래서 정답 맞으면 1점, 틀리면 0점으로 진행해서 몇 문제나 맞췄나 진행을 한다.

사람은 높은 점수를 받지만 VLM들은 점수가 낮은 것을 보고 아직은 성능이 많이 떨어졌음을 알 수 있습니다.

Cu나 SP 작업에선 높은 성능을 가지는 것을 볼 수 있습니다.

MA작업도 인간보다는 부족하지만 과하게 떨어지지 않는 모습을 보이기도 합니다.

그러나 CA나 NU와 같이 복잡한 구성 작업에 상당한 어려움을 겪으며 영화 기술에 대한 이해에 상당한 격차가 있고, 스크립트와 실제 비디오 차이에 격차 격차 때문에도 차이가 벌어집니다.

인간은 스크립트와 비디오의 격차를 직관적으로 메울 수 있지만 MLLM은 비전-텍스트 쌍에 의해 학습되므로 이런 능력이 제한 됩니다ㅏ.

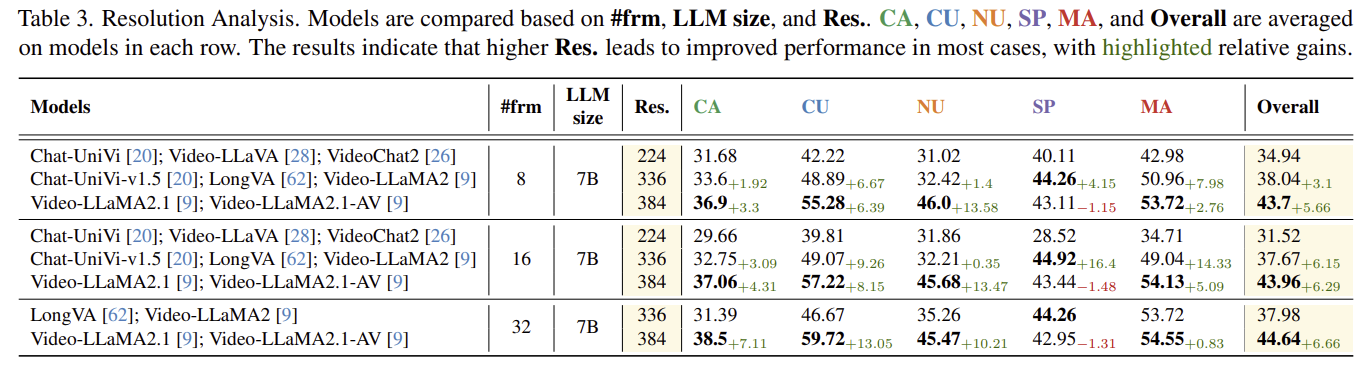

해상도에 따라서는 5가지 주요 task 성능이 일관되게 증가하는 것을 볼 수 있습니다.

그러나 이런 개선 중 고해상도 인코더 때문인지, 모델 자체 판단 때문인지는 판단 불가능한 점이 있다고 저자는 말합니다.

해상도가 높은 모델과 낮은 모델의 차이 때문에 벌어진 것인지 확신할 수 없다고 합니다..

훌륭한 질문입니다. 이 문단에서 말하는 "판단이 불가능하다"는 부분은, 단순히 해상도(resolution)가 올라갔다고 해서 성능이 오른 것이 정확히 "해상도 때문인지", 아니면 모델 구조 자체가 다르기 때문인지 단정할 수 없다는 뜻입니다.

아래에 전문가 관점에서 정확하게 해석해드릴게요.

📌 요약: 왜 판단이 불가능한가?

핵심 이유:

해상도(Resolution)가 다른 모델들은 대부분 아키텍처(모델 구조)도 다르기 때문에,

성능 향상이 해상도 때문인지, 아니면 모델 자체가 더 뛰어나서인지를 분리해서 확인할 수 없음.

🔍 구체적으로 설명하면…

예시 상황

| 모델 | 해상도 | LLM 크기 | 기타 |

| 모델 A | 224×224 | 7B | LLaVA v1.5 |

| 모델 B | 448×448 | 7B | LLaVA v1.6 (다른 백본 사용) |

| 모델 C | 336×336 | 7B | Gemini variant |

| 모델 D | 448×448 | 7B | 다른 pre-training 방식 |

이때 모델 B가 더 높은 성능을 낸다면:

❓ 그것이 448 해상도 덕분인가?

❓ 아니면 시각 백본이 좋아서인가?

❓ 아니면 멀티모달 alignment가 더 잘돼서인가?

⛔ 이걸 분리해서 실험하지 않았기 때문에 단정할 수 없다

🧠 왜 해상도만의 영향을 따로 측정하기 어려운가?

- 모델별 해상도는 고정되어 있음

- 대부분 MLLM은 내장된 해상도 크기로 학습되어 있음

- 해상도를 바꾸려면 모델 구조나 토크나이저, PE 등도 수정해야 함

- 해상도 변경 시 성능 변화 실험이 불가능하거나 비정상적

- 고정된 이미지 크기를 전제로 학습된 인코더에 해상도만 임의로 바꾸면 오류/왜곡 발생

- 해상도 높은 모델들은 보통 다른 아키텍처도 함께 사용

- 예: LLaVA-One은 336, LLaVA-v1.6은 448 해상도지만 Visual Encoder 백본도 다름

- 따라서 “해상도 때문에 좋아진 것”이라고 단정하기 어려움

✅ 결론 요약

| 질문 | 답변 |

| 해상도가 올라가면 성능이 좋아지나? | 네, 전반적으로 성능 향상 관찰됨 |

| 그게 해상도 자체 때문인가? | ❌ 확정 불가. 다른 요인이 섞여 있음 |

| 왜 판단이 어려운가? | 모델마다 인코더, 학습 방식, 구조가 다르므로 해상도만의 영향이 독립적으로 실험되지 않았기 때문 |

🧪 연구자에게 주는 시사점

- 해상도 변화의 영향을 제대로 분석하려면

→ 동일한 모델 구조에서 해상도만 다르게 조정한 실험이 필요 - 예를 들어, 같은 LLaVA 아키텍처에서 224, 336, 448 등 다양한 버전만 따로 fine-tune 해야 진짜 해상도의 영향력을 구분 가능

필요하시면, 실제로 해상도 변화만 실험하는 아블레이션(ablated) 실험 설계도 도와드릴 수 있습니다.

입력 프레임이 모델 성능에 기여하지 않음을 알 수 있습니다. 안정적인 경우도 있고, 무작위로 변동하기도 하였습니다.

계산 작업인 (Cha-C, SC, Cut-C)에서 이점을 가져올 것이라는 예상과는 어긋나게 소량의 유용한 정보가 많은 양의 중복 정보와 섞여 모델이 효과적으로 추출할 수 없었다고 저자는 보고 있습니다.

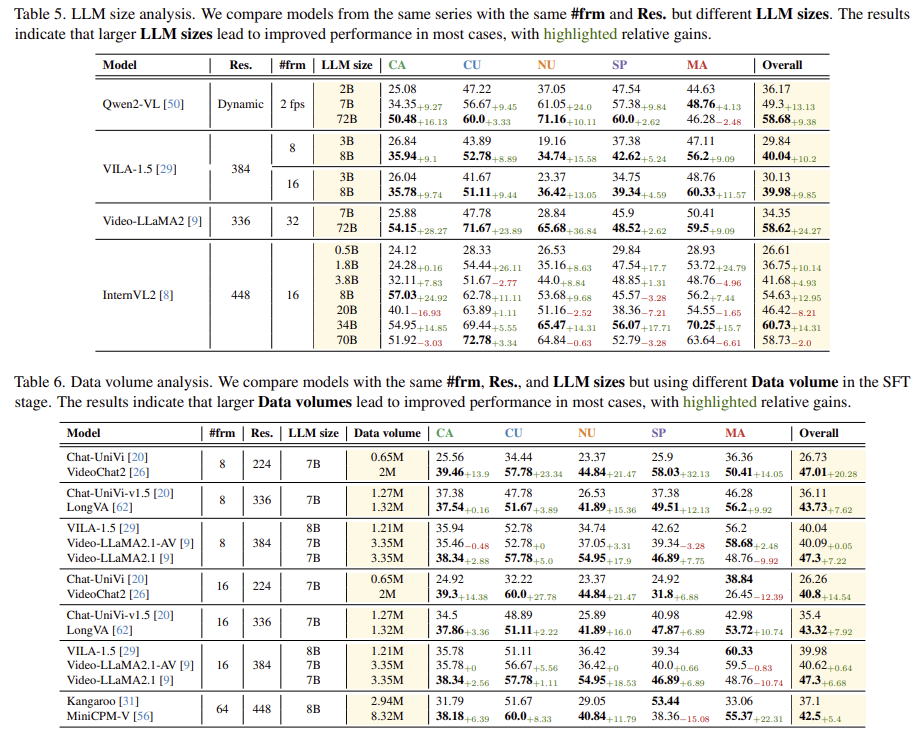

모델 크기와 데이터 볼륨이 클수록 높은 점수를 가지는 것을 볼 수 있습니다.

모델 크기가 성능에 미치는 영향은 NU Task에서 주로 나타났습니다. 개별 프레임을 인식할 뿐 아니라 시퀸스 전체에서 논리적, 인과 관계를 확립해야 하기 때문에 디코더에서의 이점을 얻지 않았을까 싶습니다.

MA 과제에선 LLM 자체의 지식도 도움이 되었습니다.

정성적 분석에선 장면 전환이나 미묘한 관점 변화로 인해 어려움을 겪는 경우가 많았습니다.

인간은 시각적 맥락을 사용해 쉽게 구별하는 것을 볼 수 있습니다.

여기선 대화 형식으로 설명을 제공하게 시켰습니다.

| 🎯 연구 목적 | MLLMs가 편집된 영상(compiled videos)에서의 시네마틱 구성 이해 능력을 평가할 수 있는 벤치마크 구축 |

| 🎬 문제의식 | 기존 벤치마크는 자연 장면 기반으로, 영상의 편집 구조, 연출 기법, 구성적 이해를 평가하지 못함 |

| 📦 벤치마크 구성 | - 총 982개 영상 클립 - 총 1,706개 다지선다형 질문(MCQ) - 영상은 자막 기반으로 분할, 오디오 제거 |

| 🧩 세부 태스크 | 5개 대분류, 15개 세부 태스크로 구성 ① Cinematography (CamM-P, SS-P, CamA-P) ② Character (E-P, CMP-P, Cha-C) ③ Narrative (S-M, P-O) ④ Scene Perception (L-P, S-C, B-P) ⑤ Making/Style (AS-P, SE-P, Cut-C) |

| 🤖 평가 방식 | - 각 모델에 영상(프레임) + QA 입력 - 디렉터 시점 프롬프트 사용 - 정답률 기반 평가 (MCQ: A/B/C/D 선택) |

| 🧠 평가 대상 | 총 33개 MLLMs (27개 공개 모델 + 6개 API) 예: LLaVA-One, GPT-4o, InternVL2, Gemini 등 |

| 📊 주요 결과 | - Human: 86.26% - Best MLLM (LLaVA-One-72B): 63.31% - Average MLLM: 43.44% - 랜덤 기준: 25.33% |

| 📉 어려운 태스크 | - CamM-P (카메라 무빙) - SS-P (샷 크기) - Cut-C (컷 수 세기) - P-O (내러티브 순서) 등 |

| 🧪 성능 영향 요소 | - 프레임 수: 영향 거의 없음 - 해상도: 높을수록 성능 ↑ - LLM 크기: 클수록 추론 성능 ↑ - SFT 데이터량: 많을수록 정확도 향상 |

| 🔍 오류 경향 | - Zoom vs Pan 혼동 - 저조한 구성 추론 - 컷 편집 전환 인지 실패 - 시점 판단 미스 |

| 🧠 결론 요약 | - 현재 MLLMs는 시각적 구성과 연출 의도 추론 능력이 부족 - 영상 이해의 수준을 객체 인식 → 구성적 해석으로 끌어올려야 함 |

| 🌱 향후 과제 | - 구성 기반 영상 생성/이해 모델 개발 - Camera-aware modules, Scene transition encoder 등 연구 필요 - 내러티브 구조와 시각 연출의 연결 추론 강화 |

| 🧭 연구적 의의 | - AGI 비전에서의 영상 언어(Visual Language) 이해 기반 마련 - 기존 벤치마크와 달리 시네마토그래피 기반 추론 능력 평가 가능 |

🔍 연구 배경 및 문제의식

기존의 MLLMs는 이미지/영상에 대한 일반적인 이해 능력(예: 객체 인식, 설명 생성 등)은 갖추고 있지만, 영상의 세밀한 구성요소 분석 능력, 특히 편집된 영상(compiled video)에서의 시네마틱 구성(cinematic composition) 이해에 한계가 있습니다.

⚠ 기존 벤치마크의 한계

- 대부분 자연스러운 장면(natural-shot) 기반이며, 편집된 영상(composed/compiled video)의 복잡한 장면 연결과 구성 요소 분석이 어려움.

- 영상 구성 이해를 위한 fine-grained 분석, 예: 카메라 무빙, 샷 크기, 내러티브 순서 등, 을 요구하지 않음.

- 기존 벤치마크는 단순한 QA(질문-답변) 수준에서 그치며, 실제 영상 제작에서 중요한 시네마토그래피 요소 분석이 부족함.

🎯 연구 목표

본 논문은 VIDCOMPOSITION이라는 새로운 벤치마크를 제안함으로써 다음을 달성하려 합니다:

- 편집된 영상에서의 시네마틱 구성 이해 평가를 위한 고품질 QA 데이터셋 구성

- 다양한 SOTA MLLMs 모델을 평가하여 현재 기술의 한계 파악

- 모델 성능에 영향을 주는 요소들(프레임 수, 해상도, 모델 크기, 데이터량 등)을 진단하여 미래 모델 개선 방향 제시

📦 VIDCOMPOSITION 벤치마크 구성

📁 데이터셋 구성

- 982개의 편집된 영상 (주로 영화 리뷰, 드라마, 애니메이션 등)

- 1,706개의 다지선다형(MCQ) 질문

- 오디오 제거, 자막 기반 구간 분할

- 5개 대분류 + 15개 세부 태스크

| 대 분류 | 새부 테스크 |

| 🎥 Cinematography Analysis (CA) | CamM-P, SS-P, CamA-P |

| 🎭 Character Understanding (CU) | E-P, A-P, CMP-P, Cha-C |

| 📖 Narrative Understanding (NU) | S-M, P-O |

| 🖼️ Scene Perception (SP) | B-P, S-C, L-P |

| 🛠️ Making Analysis (MA) | AS-P, Cut-C, SE-P |

예:

- CamM-P: 카메라 움직임 감지 (Zoom In/Out, Pan 등)

- CMP-P: 캐릭터의 의상, 소품 등 인식

- P-O: 내러티브 순서 재구성

- Cut-C: 컷 수 세기

- SE-P: 특수효과 감지 등

🧪 실험 및 결과

📊 평가 대상

- 총 33개의 MLLMs (27개 오픈소스 + 6개 API 기반)

- 예: LLaVA-OneVision, InternVL2, GPT-4o, Gemini, Qwen2 등

📈 성능 결과 (전체 정확도 기준)

- 🧠 Human: 86.26%

- 🥇 LLaVA-OneVision-72B: 63.31%

- 🥈 InternVL2-40B: 60.73%

- 📉 평균 MLLM 정확도: 43.44%

- ⚠️ 랜덤 베이스라인: 25.33%

📌 잘하는 영역 vs. 못하는 영역

| - Action/Emotion Perception (CU) |

| - Lighting/Art Style Perception (SP, MA) |

| - Special Effects 감지 |

| - 카메라 무빙/샷 사이즈 인식 (CA) |

| - 스크립트 매칭/플롯 순서 파악 (NU) |

| - 인물/씬/컷 수 세기 (Cha-C, S-C, Cut-C) |

특히 CamM-P, SS-P, P-O, Cut-C는 대부분의 모델이 인간에 비해 훨씬 낮은 성능을 보임.

🔍 성능에 영향을 주는 요인 분석 (Diagnostic Analysis)

📹 프레임 수 (# of Frames)

- 입력 프레임 수 증가가 성능에 유의미한 영향 없음

- 이유: 중복 정보가 많아 모델이 유용 정보 추출에 실패

🖼️ 영상 해상도

- 고해상도 인코더일수록 성능 향상 효과 뚜렷

🧠 LLM 크기

- LLM 크기가 클수록 성능 증가

- 특히 내러티브 이해(Narrative Understanding)에 긍정적 영향

📚 학습 데이터량

- SFT(미세조정) 시 데이터량이 많을수록 대부분의 영역에서 성능 향상

🔬 정성적 오류 분석 (Qualitative Analysis)

- GPT-4o, LLaVA 등 최신 모델조차도 “Pan Left vs Zoom In”, “Eye-level vs Low Angle” 등의 미묘한 시각 차이를 잘 구별하지 못함

- 사람은 편집과 시점 이동을 쉽게 따라가지만, MLLM은 장면 전환에서 혼란을 겪음

🧠 결론 및 향후 과제

📌 핵심 기여

- VIDCOMPOSITION: 영상 구성 이해를 평가하는 최초의 고품질 벤치마크

- 33개 MLLMs에 대한 종합 평가 및 한계 진단

- 모델 성능에 영향을 주는 프레임 수, 해상도, 크기, 데이터량에 대한 체계적 분석

🧩 향후 연구 방향

- 영상 구성 분석을 위한 시네마틱 수준의 fine-grained 학습 방식 필요

- 영상-텍스트 간 비직접적, 암시적 연결성을 추론하는 능력 강화

- 시간적 추론 + 다중 클립 통합 이해력을 동시에 요구하는 새로운 모델 설계 필요

이 논문은 영상 생성 AI나 비디오 편집 AI, 또는 AGI의 시각-언어 추론 강화에 매우 중요한 기준을 제공합니다. 영상 속 시각적 표현의 문맥적, 서사적, 기술적 해석 능력은 차세대 MLLM의 핵심 능력이 될 것입니다.

추후 관련 연구 방향을 설정하시려면, 위의 다섯 영역(CA, CU, NU, SP, MA) 중 어느 부분에 집중하고 싶은지 알려주시면 구체적인 제안도 드릴 수 있습니다.

물론입니다. 논문 VIDCOMPOSITION에서 소개된 내용을 기반으로 관련된 연구와 논문들을 정리하고, 본 논문의 기존 연구와의 차이점을 인공지능 전문가 관점에서 체계적으로 설명해드리겠습니다.

📚 관련 연구 정리: 영상 기반 MLLM 평가 및 구성 이해

1. 📷 이미지 기반 MLLM 평가 벤치마크

| 벤치마크 | 특징 | 한계 |

| Winoground [49] | 언어-비전 조합성 평가 | 이미지 한정, 단순 조합성 중심 |

| MME [11] | 이미지+텍스트 멀티태스크 평가 | 비구성적, Fine-Grained 부족 |

| MMBench [34] | 다양한 V+L 태스크 포함 | 영화적 문맥 결여 |

| MMComposition [17] | 이미지 기반 조합성 이해 | 영상 시퀀스 불포함 |

✅ 위 연구들은 MLLM의 조합성(compositionality)을 정적 이미지 수준에서 측정하지만, 시간성과 편집성이 핵심인 영상에서는 한계가 있음.

2. 🎞 전통적인 영상 이해 벤치마크

| 벤치마크 | 특징 | 한계 |

| MSVD-QA [55], TGIF-QA [19] | 단순 동작 및 QA | 시나리오 구조, 카메라 연출 등 미포함 |

| TVQA [22] | 대화/장면 기반 QA, 다중 프레임 포함 | 조합성 질문은 “who/what/when” 수준의 coarse-grained |

| ActivityNet-QA [59], NExT-QA [54] | 행동 기반 추론 | 영상 구성의 기술적/미학적 요소 무시 |

✅ 이들은 대부분 자연 장면(natural-shot) 기반으로, 영상 편집 구조와 내러티브 구성 요소 분석은 수행하지 않음.

3. 🧠 최근 MLLMs 영상 이해 벤치마크

| 벤치마크 | 특징 | 한계 |

| Video-MME [13] | 다양한 영상 QA 포함 | 영상 조합성에 대한 세밀한 분석 부족 |

| MovieChat [45] | 영화 기반 대화 QA | 텍스트 중심, 시네마 구성 요소 분석 제한 |

| TempCompass [33] | 시간적 추론 위주 | 카메라 움직임, 조명, 스타일 등 고려 안 됨 |

| LVBench [51], VideoBench [41] | 장시간 영상 이해 | 미학적 구성 분석 없음 |

✅ 대부분은 영상의 서사/행동/시간적 관계를 추론하지만, 카메라 워크, 컷, 스타일, 조명 등 영상 제작의 조합적 요소는 평가하지 않음.

🧬 본 논문의 차별점 및 기여 요약

🔑 핵심 차이점 1: "Compiled Video"에 집중

- 기존 벤치마크는 자연스러운 연속된 영상에만 초점

- 본 논문은 여러 장면이 편집되어 구성된 영상(e.g. 영화 리뷰, 하이라이트, 애니메이션 요약 등)을 사용

- 이러한 영상은 장면 전환, 내러티브 압축, 복합적 구성 등 시네마틱 이해를 요구

🎬 기존 벤치마크: “이 캐릭터가 뭘 하고 있나?”

🧠 VIDCOMPOSITION: “왜 이 장면에서 줌 인을 쓰고, 다음 장면에 컷이 들어갔을까?”

🔑 핵심 차이점 2: Fine-Grained 구성 요소 중심의 태스크 분류

- 총 15개 태스크로 구성, 각 태스크는 영상 제작에 필수적인 요소를 커버:

| CamM-P (Camera Movement Perception) | Zoom, Pan, Static 등 구분 |

| Cut-C (Cut Counting) | 장면 컷 수 세기 |

| AS-P (Art Style Perception) | 영상의 아트 스타일 구분 (e.g. cel 애니메이션, 3D) |

| S-M (Script Matching) | 스크립트와 영상 일치성 분석 |

➡ 기존 벤치마크는 대부분 “장면 이해”나 “질문 응답” 중심이나, 이 논문은 촬영기법과 제작기법 중심의 추론을 요구함

🔑 핵심 차이점 3: 전문가 관점에서 만든 Prompt 및 QA 설계

- 모델이 “감독/시네마토그래퍼의 시선”으로 판단하도록 프롬프트 구성

- 영상 제작의 미학적/기술적 판단 기준을 평가 대상으로 삼음

🔑 핵심 차이점 4: 체계적인 성능 분석 (Ablation & Diagnostic)

- 기존 연구들은 단순 정확도 비교에 그치나,

- VIDCOMPOSITION은 다음 네 가지 요인에 대해 정량적 영향 분석을 수행:

- 입력 프레임 수 (#frames)

- 인코더 해상도 (resolution)

- LLM 크기 (decoder size)

- Fine-tuning 데이터량 (SFT data volume)

➡ 이 분석은 모델 아키텍처 설계에 직접적으로 활용 가능한 통찰을 제공

🧠 인공지능 연구자로서의 함의

- 기존의 MLLMs가 “장면 인식 수준”에 머물러 있었다면,

VIDCOMPOSITION은 “연출 의도와 표현 방식까지 해석”하는 모델 능력을 요구 - 이 연구는 단지 QA 정확도를 높이는 것이 아니라, 모델이 어떻게 “영상 언어”를 해석할 수 있을지를 묻는 실험

- 향후 AGI를 위한 비주얼 이해에서, “시네마틱 추론”, “구성 기반 평가”는 필수적인 요소

✨ 향후 연구 연결 제안

✅ 모델 방향

- Vision Backbone을 Temporal-Aware 구성으로 확장 (e.g. 3D Conv, Video Transformer)

- Attention 기반 Cut Detector, Camera Movement Encoder 등 모듈 추가

✅ 태스크 설계

- 영상 생성(GEN) 모델에 VIDCOMPOSITION 기반 생성 평가 지표 적용

- 멀티프레임 Multi-choice Reasoning + 설명 생성 융합

필요하시면 이 논문을 기반으로 다음 연구 아이디어 도출, 실험 설계, 논문 주제 제안 등도 도와드릴 수 있습니다.

어느 방향이 가장 흥미로운가요? 🧪

🔧 1. 방법론 개요

본 논문에서의 방법론은 크게 다음과 같이 구성됩니다:

① 벤치마크 설계

→ 영상 구성(Composition)을 다루는 세분화된 QA 태스크 구성

→ 영상 클립 수집, 세분화, 인간 어노테이션

② MLLM 평가 프로토콜

→ 사전 정의된 프롬프트 템플릿을 사용하여 모델 응답 수집

→ 정확도 기반 정량 평가

③ 성능 분석

→ 모델의 프레임 수, 해상도, 크기, 데이터량 등의 요소가 성능에 주는 영향 진단

🎥 2. 데이터셋 구축 방식

📌 (1) 편집 영상(compiled video) 중심 수집

- YouTube, 영화 리뷰, 애니메이션 요약 등 다양한 소스의 편집된 영상 수집

- 오디오 제거, 자막 기반으로 시퀀스 분할

🎬 예시: 한 유튜브 영화 리뷰 영상에서 4~5개의 장면이 이어지며 "카메라 앵글", "컷 수", "조명 변화" 등을 관찰 가능

📌 (2) 15가지 세부 태스크 설계

이 태스크들은 시네마토그래피 이론에 기반하며, 인간 전문가가 수행하는 영상 분석 방식을 반영합니다.

| 카테고리 | task | 예시 |

| 📷 CA (촬영기법) | CamM-P | 카메라가 팬(pan)하는지, 줌하는지 식별 |

| 👥 CU (캐릭터) | E-P | 감정 인식 (분노, 슬픔 등) |

| 📖 NU (내러티브) | P-O | 장면 순서 맞추기 |

| 🖼️ SP (장면) | L-P | 조명 식별 (로우키/하이키 등) |

| 🛠️ MA (제작기법) | AS-P | 아트 스타일 분류 (2D cel, 3D CG 등) |

🧠 전문가의 예시:

- “카메라가 주인공을 따라가면서 우측으로 팬하는 장면 → 감정이 고조됨”

- “컷 수가 매우 짧은 영상 → 액션이 빠르고 박진감 있음”

이런 직관은 기존 MLLM이 아직 처리하지 못하는 은연중의 연출 의도를 포함하고 있음.

📌 (3) 인간 어노테이션 방식

- 각 영상 구간별로 다지선다형(MC) 질문 생성

- 정답 외에 3개의 의도적 오답(Distractor) 추가

- 일부 태스크는 선택지 셋 제공 (e.g. CamM-P는 ‘Zoom In, Pan Left, Static’ 등)

🎯 예시 - CamA-P 질문:

“이 장면에서 사용된 카메라 앵글은 무엇인가?”

(A) 버즈아이 뷰 (B) 로우 앵글 (C) 아이 레벨 (D) 오버숄더

🤖 3. MLLM 평가 방식

🧾 입력 프롬프트 템플릿

- 디렉터 시점에서 사고하도록 유도하는 명시적 프레이밍 사용

Given a video, a multiple-choice question, and several options,

ensure you select the option that correctly answers the question...

Think like a professional director and cinematographer.

Answer with the option’s letter directly.

🔁 모델 입력-출력 구조

- 영상 (프레임 또는 클립) + 질문 + 보기 → MLLM 입력

- 출력은 A, B, C, D 중 하나 (or fallback/random 처리)

✅ 평가 기준: 정확도 (Accuracy)

- 각 태스크 단위 정확도 및 전체 평균 정확도 계산

- 총 1706개의 QA 쌍 사용

예를 들어, 모델이 ‘Pan Left’와 ‘Zoom In’을 혼동하면 → CamM-P 정확도 낮음

🔍 4. 성능 분석 방법 (Diagnostic Evaluation)

논문은 단순 평가를 넘어서 MLLM 설계/튜닝에 대한 인사이트를 주기 위해 다음 4가지 요소를 실험합니다.

| 요소 | 실험 방식 | 결과 |

| 📹 입력 프레임 수 | 4, 8, 16, ..., 128 | 큰 효과 없음 (중복 정보 많아 학습 어려움) |

| 🖼️ 인코더 해상도 | 224, 336, 384, 448 | 고해상도일수록 성능 향상 |

| 🧠 LLM 크기 | 2B ~ 72B | LLM 클수록 NU 성능 향상, 논리적 추론력 향상 |

| 📚 SFT 데이터량 | 0.65M ~ 8.3M | 더 많은 데이터 → 대부분 성능 개선 (특히 CU, MA 등) |

🧠 전문가 예시로 풀어보는 방법론

🎬 시나리오: 영화 <인셉션> 클립 분석

장면: 건물이 기울어지며 주인공이 달리는 장면

카메라 무빙: 기울어진 환경을 따라 Steadicam 사용

질문: "이 장면에서 사용된 카메라 무빙은?"

- (A) Zoom Out

- (B) Pan Right

- (C) Tracking

- (D) Static

인간 전문가는 이를 보고 “카메라가 인물을 따라 이동하므로 ‘Tracking’이다”라고 판단

하지만 MLLM은 흔들리는 배경에 주의를 빼앗겨 ‘Pan’이나 ‘Zoom’으로 잘못 선택하는 경우 발생

➡ 본 방법론은 이런 인간 수준의 영상 문법 해석 능력을 테스트하는 방식으로 구성됨

📌 요약: 방법론의 핵심 정리

| 구성 요소 | 설명 |

| 🎞️ 데이터 | 982편 편집 영상 + 1706개 QA, 사람 수작업 |

| 🎯 태스크 | 15개 영상 구성 요소 중심 Fine-Grained QA |

| 🧠 모델 입력 | 영상 클립 + QA + 선택지 → 프롬프트 형태 |

| 📊 평가 | Accuracy (정답률) 기반 + 다양한 ablation |

| 🔬 분석 | 프레임 수, 해상도, 모델 크기, 데이터량 등 요인별 성능 영향 분석 |

이처럼 VIDCOMPOSITION의 방법론은 단순한 QA 벤치마크를 넘어서, 시네마틱 언어를 이해할 수 있는 MLLM의 가능성을 타진하는 실험적 틀을 제공합니다.

이 방법론을 기반으로 새로운 평가 지표 설계, 모듈 단위의 시각 구성 분석기 개발, 영상 생성 품질 평가에 활용하는 것도 가능합니다.

원하시면 이 구조를 바탕으로 여러분의 연구 방향에 맞는 실험 계획이나 파생 태스크 제안도 도와드릴게요!

📊 1. 결과 분석 (Results)

📌 전체 정확도 결과

| 평가 대상 | 정확도 |

| 🧠 Human (사람) | 86.26% |

| 🥇 LLaVA-One-72B | 63.31% |

| 🥈 InternVL2-40B | 60.73% |

| 평균 MLLM (33개 모델 평균) | 43.44% |

| ⚠️ 랜덤 선택 기준 | 25.33% |

✅ 결론적으로, 최고 성능 모델조차도 인간 성능과 약 23% 이상의 차이

⛔ 특히 fine-grained 구성 판단이 필요한 태스크에서 성능 급감

📌 세부 태스크 성능 비교

| 잘 수행한 task | 어려운 task |

| - 감정 인식 (E-P) | |

| - 조명/아트스타일 식별 (L-P, AS-P) | |

| - 특수 효과 감지 (SE-P) | - 카메라 무빙/샷 크기 (CamM-P, SS-P) |

| - 컷 수 계산 (Cut-C) | |

| - 내러티브 순서 파악 (P-O) | |

| - 캐릭터 수 인식 (Cha-C) |

특히 시네마토그래피(CA), 내러티브(N.U) 영역에서 사람-모델 간 성능 격차가 가장 큼

📌 성능 영향 요인 분석 (Ablation Results)

| 변수 | 결과 |

| 🎞️ 입력 프레임 수 | 일정 이상(8~32)부터 성능 변화 거의 없음 (많아진다고 성능이 오르지 않음) |

| 🖼️ 인코더 해상도 | 해상도가 높을수록 성능 향상됨 (224 → 448) |

| 🧠 LLM 크기 | 더 큰 모델일수록 정확도 향상 (특히 내러티브 추론에 긍정적) |

| 📚 SFT 데이터량 | SFT 데이터량이 많을수록 성능 증가 (MA, CU 태스크에서 특히 효과적) |

➡ MLLM 설계 시 단순히 "더 많은 프레임을 넣는 것"보다는 해상도, LLM 크기, 데이터 다양성이 더 중요한 역할

📌 정성적 오류 분석 (Qualitative Error Analysis)

- 시각적 디테일의 미묘한 차이 구별에 취약

(예: ‘Zoom In’ vs ‘Pan In’, ‘Eye-level’ vs ‘Low-angle’) - 컷 전환이나 편집 흐름 추론 실패

(편집 의도 파악 능력 부족) - 감정 추론이나 캐릭터 인식에는 비교적 양호한 성능

🎥 예시: 어떤 모델은 똑같은 배우의 옷 스타일 변화를 캐치하지 못하거나, 카메라가 이동하는 것을 단순 ‘Static’으로 판단

🧠 2. 결론 (Conclusion)

논문은 다음과 같은 결론을 제시합니다:

✅ 주요 결론 요약

- VIDCOMPOSITION은 기존 벤치마크가 다루지 못한 “영상 구성(Composition)” 분석 능력을 평가할 수 있는 최초의 벤치마크

- 현재의 최첨단 MLLMs조차도 인간 수준에는 크게 미치지 못하며, 특히 시네마토그래피적 요소에 대한 이해력이 부족

- 영상 이해에서 "단순 시각적 요소" 이상으로 "영상 문법, 연출 의도, 구성 연결성"이 중요하다는 것을 시사

🔍 전문가 관점에서 본 인사이트

| 기존 영상 QA의 관점 | VIDcomposition의 확장 |

| “이 인물은 무엇을 하고 있나?” | “이 장면에서 왜 이 카메라 무빙이 쓰였을까?” |

| “이 장면의 주인공은 누구인가?” | “컷이 어떻게 분할되어 시나리오를 강조했나?” |

| “무슨 일이 일어났나?” | “편집을 통해 감정이 어떻게 강조되었나?” |

➡ 이는 결국 MLLM이 ‘감성적-구성적 추론’을 배우게 해야 한다는 방향성을 제시

🧩 3. 마무리 및 향후 연구 방향 (Closing & Future Work)

📌 향후 과제 제안

- 시네마 구성 요소를 더 잘 반영하는 MLLM 아키텍처 개발

- 예: Camera-Aware Attention, Scene Transition Module 등

- 영상 생성 및 편집 AI와의 연결

- 생성 모델이 어떤 구성 방식으로 영상을 만들어야 더 자연스러운지를 판단하는 기준 제공

- 텍스트-비디오 간 암묵적 추론 능력 강화

- 자막/스크립트와 비디오 간 연결이 명시적으로 표현되지 않는 경우 추론 필요

- 멀티 클립 기반의 추론 강화

- 하나의 긴 장면이 아닌, 여러 개의 짧은 클립 간 의미 연결 능력 요구

✅ 최종 요약

| 🎯 목적 | 영상의 시네마 구성 요소에 대한 MLLM의 이해력을 평가 |

| 🧪 방법 | 편집 영상 기반 다지선다 QA 15개 태스크 구축 및 MLLM 33종 평가 |

| 📊 결과 | 인간 86% vs 최고 MLLM 63%, 평균 43% → 큰 성능 격차 |

| 🔬 분석 | 해상도, LLM 크기, SFT 데이터량은 긍정적 영향 / 프레임 수는 영향 미미 |

| 🧠 결론 | 현재 MLLM은 시네마토그래피적 추론에서 취약, 영상 구성 추론 능력 향상이 필요 |

이 논문은 단순한 QA 벤치마크를 넘어, 비디오 표현의 구조적/의도적/미학적 측면을 이해하는 AI의 가능성을 실험하는 새로운 지평을 열었습니다.

앞으로 MLLM이나 비디오 AI 연구에서 “영상 언어(Visual Language)”를 어떻게 가르칠 것인가에 대한 실질적인 기준점이 됩니다.