https://arxiv.org/abs/1706.05125

Deal or No Deal? End-to-End Learning for Negotiation Dialogues

Much of human dialogue occurs in semi-cooperative settings, where agents with different goals attempt to agree on common decisions. Negotiations require complex communication and reasoning skills, but success is easy to measure, making this an interesting

arxiv.org

아직 Transformer 구조도 없어 RNN기반의 GRU 모델을 통해 LM을 만들었을 시대의 모델입니다.

생성 능력이 강력하지 않아 발화를 선택하는 형식으로 진행하고, 시뮬레이션을 통해 가장 좋은 결과를 가져오는 발화를 선택하네요

그래도 생성조차 잘 되지 않던 시기에 협상이라는 높은 성능이 필요한 Task를 해결하려고 했다는 점이 중요해 보입니다.

| 문제 정의 | - 협상은 대화와 추론 능력을 요구하며, 경쟁적이면서 협력적인 요소가 혼재됨. |

| - AI 에이전트가 목표를 달성하기 위해 인간과 협상 대화를 수행하도록 학습. | |

| - 데이터셋: 서로 다른 보상 함수에 기반한 아이템(책, 모자, 공)을 나누는 5,808개의 대화 데이터. | |

| 목표 | - 자연어 기반 협상을 수행하는 엔드투엔드 AI 모델 개발. |

| - 인간처럼 자연스러운 언어를 생성하면서도 높은 전략적 성과를 달성. | |

| 모델 구성 | 1. Likelihood 모델: GRU 기반 언어 모델로 인간 대화를 모방하여 발화 생성. |

| 2. 강화학습 모델 (RL): Self-Play를 통해 목표 점수를 최대화하는 전략적 학습. | |

| 3. 롤아웃 모델 (Rollouts): 대화의 미래를 시뮬레이션하여 최적 발화를 선택. | |

| 4. RL+Rollouts 모델: 강화학습과 롤아웃 결합으로 최상의 전략 및 점수 달성. | |

| 학습 과정 | - 지도학습: 초기에는 인간 발화를 모방하여 자연스러운 언어 생성 학습. |

| - 강화학습: Self-Play를 통해 보상을 극대화. | |

| - 롤아웃 기반 디코딩: 후보 발화를 시뮬레이션하고 예상 보상을 기반으로 선택. | |

| 평가 지표 | - 점수: 협상 결과 점수 (최대 10점). |

| - 합의율: 협상 성공 비율 (%). | |

| - Pareto 효율성: 더 이상의 개선이 불가능한 효율적 상태 비율 (%). | |

| 결과 | - Likelihood 모델: 자연스러운 언어를 생성하지만 전략 부족 (합의율 87.9%, Pareto 효율성 49.6%). |

| - RL 모델: 강화학습을 통해 점수와 효율성 개선 (합의율 89.9%, Pareto 효율성 58.6%). | |

| - Rollouts 모델: 시뮬레이션 기반 선택으로 전략적 성과 개선 (합의율 92.9%, Pareto 효율성 63.7%). | |

| - RL+Rollouts 모델: 모든 지표에서 최상의 결과 (합의율 94.4%, Pareto 효율성 74.8%). | |

| 한계점 | 1. 공격적 협상: 높은 점수를 위해 과도한 전략 사용 → 인간과의 합의율 저하. |

| 2. 언어적 비일관성: 일부 발화에서 초반 합의 신호 후 새로운 조건 제안으로 비일관성 발생. | |

| 3. 일반화 한계: 다른 도메인 협상 문제에 대한 모델의 일반화 능력 검증 부족. | |

| 기여 | - 강화학습과 롤아웃을 결합해 협상 AI에서 전략적 사고와 목표 달성이 가능함을 입증. |

| - "기만 전략"과 같은 인간 유사 전략을 학습하며, 복잡한 협상 환경에서 높은 성과를 달성. | |

| 미래 연구 방향 | 1. 사회적 신호 통합: 인간과의 상호작용 개선을 위한 감정 및 사회적 신호 추가. |

| 2. 다양한 도메인 확장: 다른 유형의 협상 문제로 일반화. | |

| 3. 발화 다양성 증대: 더 창의적이고 풍부한 대화 생성 기술 개발. | |

| 4. 다중 에이전트 협상: 여러 에이전트가 참여하는 복잡한 협상 상황으로 확장. |

"Deal or No Deal? End-to-End Learning for Negotiation Dialogues"

1. 해결하고자 하는 문제

- 문제 정의:

- 인간 대화의 중요한 영역 중 하나는 협상입니다. 협상은 상호 협력적이면서도 경쟁적인 특성을 가진 대화로, 참가자들은 상반된 목표를 가진 채 자연어를 통해 공통된 결정을 이끌어내야 합니다.

- 기존 연구는 협상에서 전략적 추론을 포함한 언어 생성 문제를 처리하는 데 한계가 있었습니다.

- 연구 목표:

- 인간과 유사한 협상 대화 모델을 학습하기 위한 데이터세트 구축 및 엔드투엔드 학습이 가능한 모델 개발.

- 모델이 언어 능력뿐 아니라 전략적 추론을 통해 높은 성과를 낼 수 있도록 학습 방법론 제안.

2. 사용된 방법

2.1 데이터 구축

- 데이터 수집:

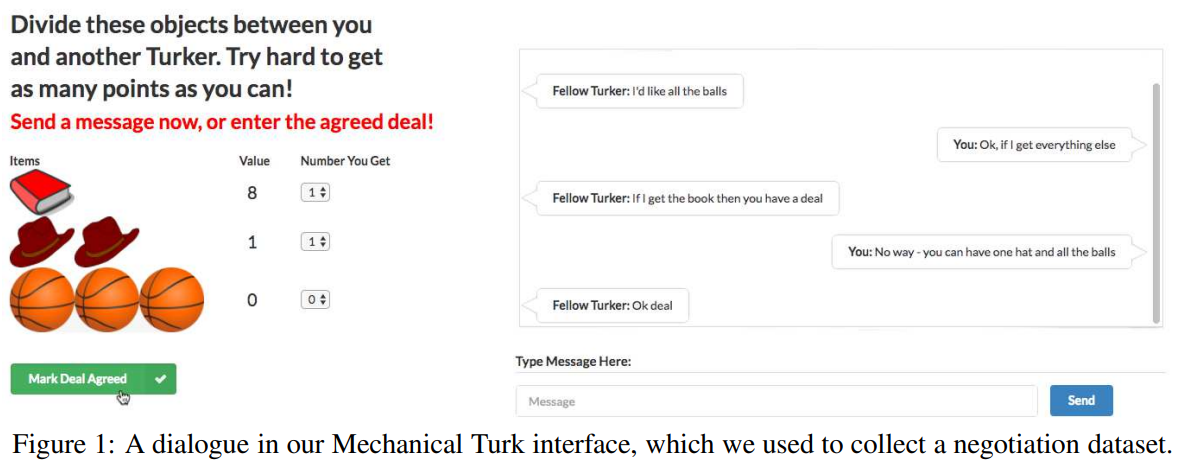

- Amazon Mechanical Turk 플랫폼을 이용해 5808개의 인간 대화를 수집.

- 작업자는 각기 다른 보상을 가진 아이템(책, 모자, 공)을 나누는 협상을 수행했으며, 각자의 보상 함수는 상대방에게 공개되지 않음.

- 데이터는 다중 이슈 협상 과제(Multi-Issue Bargaining Task)를 기반으로 설계됨.

- 목표: 모든 아이템을 둘 중 한 사람에게 할당하며, 양측의 점수를 최대화하는 협상을 수행.

2.2 모델 설계

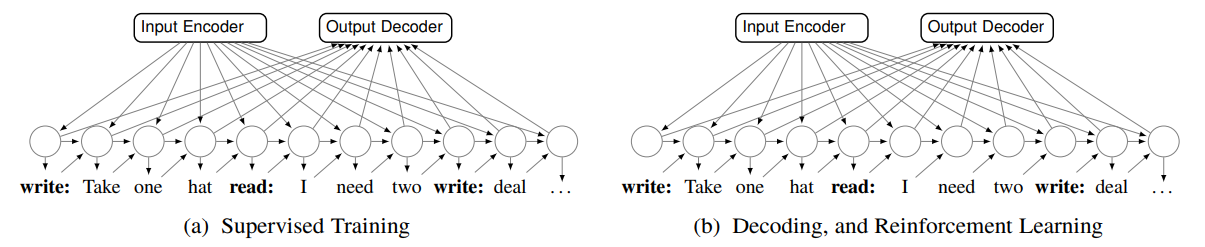

- 기본 모델: Likelihood Model

- 대화를 Sequence-to-Sequence 방식으로 모델링.

- 입력 데이터(아이템과 보상 함수)와 대화 기록을 기반으로 후속 대화를 예측하도록 학습.

- 목표는 인간의 행동을 모방해 언어를 자연스럽게 생성.

- 고급 학습 방법:

- Self-Play를 활용한 강화학습 (Reinforcement Learning)

- 사전 학습된 모델이 스스로 협상을 수행하며 목표 점수를 최대화하도록 학습.

- 인간 언어로부터 지나치게 벗어나지 않기 위해 강화학습과 지도학습을 혼합.

- 대화 롤아웃(Dialogue Rollouts)

- 대화의 미래 전개를 시뮬레이션하여 각 발화의 예상 보상을 계산.

- 보상을 극대화하는 발화를 선택해 더 전략적인 대화를 생성.

- Self-Play를 활용한 강화학습 (Reinforcement Learning)

3. 결과

- 모델 성능 비교:

- Likelihood 모델은 인간과 유사한 언어를 생성하지만 협상에서는 비효율적(과도한 양보).

- 강화학습(RL)과 롤아웃을 결합한 모델(RL+Rollouts)은 협상 점수와 Pareto Optimality에서 최고의 성과를 기록.

| 모델 | 점수 | 점수 | 합의율 | Pareto 효율성 |

| Likelihood | 5.4 | 6.2 | 87.9 | 49.6 |

| RL | 7.1 | 7.9 | 89.9 | 58.6 |

| Rollouts | 7.3 | 7.9 | 92.9 | 63.7 |

| RL+Rollouts | 8.3 | 8.8 | 94.4 | 74.8 |

- 분석:

- RL+Rollouts 모델은 더 복잡한 전략을 활용, 예를 들어 관심 없는 항목에 가짜로 흥미를 보이며 나중에 양보하는 방식으로 점수를 극대화.

- 그러나 과도한 공격적 협상으로 인해 인간과의 대화에서 합의 실패율이 증가.

4. 한계점

- 인간 대화와의 차이:

- 강화학습 모델은 인간보다 공격적이며, 합의 실패율이 높음.

- 인간은 불공정하다고 느껴지는 제안에서 협상을 포기하는 경향을 보임.

- 언어적 일관성 문제:

- 대화에서 초기 합의 표현(예: "Deal")을 제안한 뒤 새로운 제안을 추가하는 등 비일관적인 발화가 생성되기도 함.

- 일반화 한계:

- 새로운 협상 도메인에서 기존 전략을 활용하는 능력은 아직 검증되지 않음.

5. 결론 및 향후 연구 방향

- 결론:

- 협상 대화는 언어 생성과 추론 기술이 모두 필요한 복합적 과제.

- 제안된 RL+Rollouts 방법론은 단순한 인간 모방을 넘어 목표 중심 학습을 통해 성능을 크게 향상.

- 향후 연구 방향:

- 협상 중 더 많은 전략적 행동 학습.

- 발화 다양성을 높이는 방법 개발.

- 협상 도메인 간 전략 공유 가능성 탐구.

- 인간 파트너와의 더 자연스러운 협상을 위해 사회적 신호를 포함한 확장 연구.

이 논문은 Negotiation AI Agent 연구에 다음과 같은 영감을 줄 수 있습니다:

- 롤아웃 기반 추론: 협상의 결과를 미리 예측해 전략을 조정.

- 강화학습 활용: 인간 언어와의 균형을 유지하면서 목표 달성 극대화.

- 거짓 신호 전략: 가짜 관심을 유발하거나 양보하는 심리적 전략을 학습.

추가 질문이나 논의가 필요하면 언제든 알려주세요!

협상 AI 에이전트 연구와 관련된 주요 논문들을 정리하면 다음과 같습니다:

1. "Towards a Neural Era in Dialogue Management for Collaboration: A Literature Survey" (2023)

- 저자: Amogh Mannekote

- 주요 내용:

- 이 논문은 협업 대화 시스템에서의 대화 관리 패러다임의 진화를 검토합니다.

- 전통적인 수작업 및 정보 상태 기반 방법에서 AI 계획 기반 접근법까지의 발전 과정을 다룹니다.

- 최근의 데이터 기반 대화 관리 기술을 분석하며, 협업 대화 관리에 대한 신경망 접근법의 적용을 강조합니다.

- 대규모 언어 모델의 잠재력을 수용하는 대화 시스템 커뮤니티의 미래 발전을 위한 기초를 제공합니다.

- 출처: arXiv:2307.09021

2. "인공지능 기반 대화형 공공 행정 챗봇 서비스에 관한 연구" (2017)

- 저자: 김현기

- 주요 내용:

- 공공 행정 분야에서 인공지능 기반 대화형 챗봇 서비스의 개발 및 적용 방안을 연구합니다.

- 챗봇의 설계, 구현, 운영에 대한 기술적 접근과 사용자 경험을 분석합니다.

- 공공 서비스의 효율성 증대를 위한 챗봇 활용의 가능성을 탐구합니다.

- 출처: ScienceON

3. "복합 인공지능 모듈을 이용한 지능형 대화 에이전트" (2017)

- 저자: 김민수

- 주요 내용:

- 다양한 유형의 대화를 처리할 수 있는 지능형 대화 에이전트를 설계합니다.

- 대화 관리 모듈, 지식 학습 모듈, 사용자 모델링 모듈로 구성된 시스템을 제안합니다.

- 문맥을 고려한 답변 생성과 새로운 정보에 대한 대화 기반 학습 기능을 포함합니다.

- 출처: ScienceON

4. "인공지능 기반의 챗봇 시스템 기술 동향" (2019)

- 저자: 이지은

- 주요 내용:

- 인공지능 기반 챗봇 시스템의 기술적 발전과 동향을 분석합니다.

- 자연어 처리, 기계 학습, 사용자 인터페이스 등의 측면에서 챗봇 기술을 검토합니다.

- 미래 챗봇 시스템의 발전 방향과 적용 가능성을 제시합니다.

- 출처: ScienceON

5. "초거대 언어 모델을 기반으로 한 AI 대화 인터페이스: AI 대화 모델의 현황과 언어적 연구의 모색" (2023)

- 저자: 이경님, 조은경

- 주요 내용:

- 초거대 언어 모델을 활용한 AI 대화 인터페이스의 현황을 조사합니다.

- 인간과 기계 간의 언어적 상호작용을 위한 대화 모델을 분석합니다.

- 언어학적 연구의 새로운 방향을 모색합니다.

- 출처: ScienceON

이러한 논문들은 협상 AI 에이전트 연구에 있어 다양한 접근법과 기술적 통찰을 제공합니다. 각 논문의 상세한 내용을 검토하여 연구 방향 설정에 활용하시기 바랍니다.

논문 "Deal or No Deal? End-to-End Learning for Negotiation Dialogues"를 기반으로 한 관련 연구를 아래와 같이 정리합니다.

1. 협상 AI와 연관된 주요 관련 논문

1.1 강화학습과 대화 모델

- 관련 연구:

- "Learning Cooperative Visual Dialog Agents with Deep Reinforcement Learning" (Das et al., 2017)

- 내용: 강화학습을 사용하여 협력적 대화 에이전트를 학습. 두 에이전트가 이미지를 기반으로 대화를 나누며, 서로의 의도를 이해하고 목표를 달성하는 방식을 탐구.

- 연관성: 협상 AI에서도 강화학습을 적용하여 상대방의 의도를 파악하고 목표를 극대화하는 전략을 학습할 수 있음.

- 특징: 협력 중심의 접근법으로 대화를 설계.

- "Deep Reinforcement Learning for Dialogue Generation" (Li et al., 2016)

- 내용: 비목적 지향 대화에서 다양한 대화를 생성하기 위한 강화학습 활용.

- 연관성: 비협력적 요소를 포함한 협상 대화에서도 다양한 발화를 생성하는 데 도움.

- "Learning Cooperative Visual Dialog Agents with Deep Reinforcement Learning" (Das et al., 2017)

1.2 협상 대화에서의 거짓 신호 전략

- 관련 연구:

- "Development of Lying to Conceal a Transgression" (Talwar & Lee, 2002)

- 내용: 거짓말과 기만 행동의 발달을 다룸. 상대방의 의도를 이해하고 그에 따른 적응적 행동을 학습.

- 연관성: 협상 AI의 고급 전략(예: 무가치한 항목에 관심을 가장하여 더 나은 조건을 유도하는 전략)에 기여.

- "Development of Lying to Conceal a Transgression" (Talwar & Lee, 2002)

1.3 엔드투엔드 대화 시스템

- 관련 연구:

- "Learning End-to-End Goal-Oriented Dialogues" (Bordes & Weston, 2016)

- 내용: 엔드투엔드 대화 시스템을 개발하여 목표 지향적 대화를 학습. 기존 시스템의 상태 기반 접근법과 대비.

- 연관성: 협상 대화에서도 대화 상태를 명시적으로 정의하지 않고 데이터 기반으로 학습 가능.

- "Neural Conversational Model" (Vinyals & Le, 2015)

- 내용: 대화 생성에 시퀀스-투-시퀀스 모델을 활용한 초기 연구.

- 연관성: 본 논문의 Likelihood 모델과 유사한 방식으로, 인간과 유사한 언어를 생성하는 기초 모델 설계.

- "Learning End-to-End Goal-Oriented Dialogues" (Bordes & Weston, 2016)

1.4 협상 및 게임 이론 기반 연구

- 관련 연구:

- "The Bargaining Problem" (Nash Jr, 1950)

- 내용: 협상 문제를 정의하고, 파레토 최적성 및 공정성을 다룸.

- 연관성: 본 논문에서도 Pareto Optimality를 성과 측정 지표로 사용하며, 협상 전략의 효율성을 평가.

- "Evaluating Practical Negotiating Agents" (Baarslag et al., 2013)

- 내용: 협상 에이전트의 성능 평가를 위한 체계적 접근법 제안.

- 연관성: 본 논문의 모델 평가(예: 점수, 합의율, Pareto 효율성)와 직접적인 연관.

- "The Bargaining Problem" (Nash Jr, 1950)

2. 협상 AI 연구에 대한 시사점

- 강화학습의 중요성:

- 강화학습은 협상 대화에서 전략적 의사결정을 학습하는 데 중요한 역할을 함.

- 특히, 본 논문에서 사용된 Self-Play와 다른 연구에서 사용된 다중 에이전트 상호작용이 결합될 수 있음.

- 롤아웃 기반 추론:

- 대화의 미래를 시뮬레이션하여 최적의 행동을 선택하는 방식은 협상 대화에서 필수적.

- 기존 연구에서 사용된 Monte Carlo Tree Search(MCTS)와 결합 가능.

- 기만 및 고급 전략 학습:

- 상대방의 행동을 예측하고, 거짓 신호를 보내는 전략은 협상 AI의 성숙도를 높이는 요소.

- 파레토 최적성과 인간 유사성:

- 협상 성과를 효율적으로 평가할 수 있는 지표로 활용.

- 인간과의 상호작용을 통해 학습의 현실성을 높이는 방향 제시.

결론

- 협상 AI 에이전트를 연구할 때 본 논문과 관련 연구들은 데이터 기반 학습, 강화학습, 고급 추론 기술을 통합하는 방법론을 제시합니다.

- 이를 기반으로 목표 중심 학습, 언어 생성 다양성 강화, 협상 전략의 일반화를 목표로 연구를 확장할 수 있습니다.

논문을 기반으로 방법론에 대해 자세하고 명확하게 예시를 포함해서 설명해줘

논문 "Deal or No Deal? End-to-End Learning for Negotiation Dialogues"에서 제시된 방법론은 협상 대화 모델을 구축하고 학습시키기 위한 체계적인 접근 방식을 포함합니다. 아래에서 이를 자세하고 명확하게, 예시를 포함하여 설명합니다.

1. 문제 설정

- 상황: 두 에이전트가 서로 다른 가치를 가진 아이템(책, 모자, 공)을 협상하여 나눠야 합니다.

- 목표: 각 에이전트는 자신의 총 점수를 최대화하는 협상을 통해 합의에 도달해야 합니다.

- 제약 조건:

- 각 아이템의 가치는 에이전트마다 다름.

- 양측의 점수를 모두 극대화하는 분배는 불가능함.

- 협상이 결렬되면 두 에이전트는 0점.

예시:

- 에이전트 A: 책(3점), 모자(2점), 공(5점)

- 에이전트 B: 책(6점), 모자(1점), 공(3점)

2. 방법론

2.1 데이터 수집

- 목적: 협상 대화를 학습하기 위해 5,808개의 인간 대화 데이터를 수집.

- 방식: Amazon Mechanical Turk를 통해 인간 대화를 기록.

- 수집된 데이터:

- 대화 내용

- 각 에이전트의 보상 함수

- 최종 합의(또는 합의 실패)

예시:

- 에이전트 A: "모자와 공을 주세요. 당신은 책을 가지세요."

- 에이전트 B: "모자는 포기할 수 없습니다. 공을 양보해 주세요."

2.2 모델 설계

2.2.1 Likelihood 모델 (기본 모델)

- 목표: 인간 대화를 모방해 자연스러운 언어를 생성.

- 구조:

- 입력: 에이전트의 보상 함수, 대화 기록.

- 출력: 다음 발화 및 최종 아이템 할당.

- 모델: 시퀀스-투-시퀀스(Sequence-to-Sequence) GRU 네트워크.

- 학습: 주어진 데이터에서 인간 발화를 최대한 정확히 재현하도록 학습.

예시:

- 입력: 에이전트 A의 목표 (책 3점, 모자 2점, 공 5점), 대화 기록 ("책을 주고 모자를 주세요").

- 출력: 다음 발화 ("공은 당신이 가져가세요").

2.2.2 강화학습 (Reinforcement Learning)

- 문제점: Likelihood 모델은 과도하게 양보하며, 전략적 추론이 부족함.

- 개선 방법:

- Self-Play: 모델이 스스로 협상하면서 성과를 최대화하도록 학습.

- 목표: 합의 점수를 극대화하며 인간 언어와의 차이를 최소화.

- 방법: 강화학습과 지도학습을 번갈아 수행.

- 보상 함수:

- 양측이 합의한 결과에 따라 점수를 계산.

- 점수가 높을수록 보상을 많이 받음.

예시:

- 에이전트 A: "공은 포기하겠지만, 책과 모자는 제가 가져가겠습니다."

- 에이전트 B: "모자를 양보하겠습니다. 대신 책과 공은 제가 가져갑니다."

2.2.3 대화 롤아웃 (Dialogue Rollouts)

- 문제점: 강화학습만으로는 복잡한 전략 학습이 어려움.

- 개선 방법:

- 대화의 미래를 시뮬레이션(롤아웃)하여 각 발화의 예상 보상을 계산.

- 보상이 높은 발화를 선택.

- 구현:

- 후보 발화 세트를 생성.

- 각 후보 발화 이후의 대화를 샘플링하여 최종 점수를 예측.

- 예상 점수가 가장 높은 발화를 선택.

예시:

- 후보 발화:

- "공을 가져가세요. 책과 모자를 주세요." (예상 점수: 7점)

- "책과 모자를 모두 주세요. 공은 드리겠습니다." (예상 점수: 5점)

- 선택: 첫 번째 발화.

2.3 학습 과정

- 지도학습: 인간 대화를 모방하도록 초기 모델을 학습.

- 강화학습: Self-Play를 통해 점수 최적화를 수행.

- 롤아웃 기반 디코딩: 후보 발화 중 가장 높은 예상 보상을 가진 발화를 선택.

3. 결과 및 평가

3.1 평가 지표

- 점수: 합의 결과에 따라 양측이 얻는 점수 (최대 10점).

- 합의율: 대화가 성공적으로 합의에 도달한 비율.

- Pareto 효율성: 양측 점수를 더 이상 개선할 수 없는 상태에 도달한 비율.

3.2 실험 결과

- 강화학습 + 롤아웃 모델 (RL+Rollouts):

- 점수: 8.3 (Likelihood 모델: 5.4)

- 합의율: 94.4% (Likelihood 모델: 87.9%)

- Pareto 효율성: 74.8% (Likelihood 모델: 49.6%)

결과 요약:

- RL+Rollouts 모델은 전략적 협상을 잘 수행하며 높은 점수를 기록.

- 특히 롤아웃 기반 디코딩은 복잡한 대화 전략(예: 기만 전략)을 학습하는 데 효과적.

4. 예시를 통해 본 방법론

- 초기 대화:

- A: "책과 모자를 주세요. 당신은 공을 가지세요."

- B: "모자는 제가 가져가야 합니다. 대신 공을 드리겠습니다."

- 모델의 롤아웃 전략:

- A는 모자를 양보하는 전략을 시뮬레이션하여 점수를 극대화할 방법을 계산.

- 선택된 발화: "공과 책을 드리겠습니다. 대신 모자만 주세요."

- 최종 합의:

- A: 모자(3점)

- B: 책과 공(7점)

이 방법론은 협상 AI 연구에 다음과 같은 교훈을 제공합니다:

- 강화학습과 롤아웃 결합은 전략적 사고를 강화.

- 인간의 언어 데이터와 보상 기반 학습을 혼합해 균형 있는 모델 개발 가능.

- 예측 및 시뮬레이션이 대화의 질을 개선.

필요한 추가적인 세부사항이 있다면 말씀해주세요!

이 시기에는 Transformer도 없었고, 강력한 하드웨어도 없었기에 GRU기반의 LM을 사용해서 자연어를 생성했고, 그 생성 능력이 뛰어나지 않아 강화학습을 통해 이전에 존재하는 발화를 선택하는 식으로 negotiation을 진행한 거네?

시뮬레이션도 진행해가면서 나한테 제일 좋은 결과를 가져오는 발화를 선택하고?

네, 정확합니다! 이 논문에서는 Transformer가 본격적으로 도입되기 전의 상황에서, 비교적 가벼운 GRU 기반의 언어 모델을 사용하여 협상 대화를 생성하고 학습했습니다. 당시의 기술적 제약(모델 구조와 하드웨어 성능)을 고려한 방식으로 접근했습니다. 이를 구체적으로 설명하겠습니다:

1. 언어 생성

- GRU 기반 언어 모델:

- 대화 생성을 위해 시퀀스-투-시퀀스(Seq2Seq) 구조를 사용.

- 입력으로 각 에이전트의 보상 함수(아이템 가치 정보)와 이전 대화 내용을 받아, 다음 발화를 예측.

- 하지만 GRU는 Transformer에 비해 표현 능력이 제한적이어서, 복잡하고 창의적인 발화를 생성하는 데 한계가 있었습니다.

2. 강화학습 (Reinforcement Learning, RL)

- GRU 기반 모델의 언어 생성 한계를 보완하기 위해 강화학습을 도입했습니다.

- 작동 방식:

- Self-Play를 통해 두 모델이 서로 협상하며 스스로 학습.

- 강화학습은 단순히 인간 데이터를 모방(Likelihood 학습)하는 것이 아니라, 보상을 최대화하도록 모델을 조정.

- 모델이 발화를 생성하는 대신 기존 발화 중에서 더 나은 전략적 발화를 선택하도록 훈련.

3. 시뮬레이션 (Dialogue Rollouts)

- 협상 대화에서 미래를 예측해 최선의 결정을 내리기 위해 롤아웃(Dialogue Rollouts) 기법을 사용.

- 작동 방식:

- 현재 시점에서 몇 가지 후보 발화를 생성.

- 각 발화를 시작점으로 미래 대화를 시뮬레이션(샘플링)하여 예상되는 보상을 계산.

- 시뮬레이션 결과 중 가장 높은 보상을 가져오는 발화를 선택.

- 예시:

- 현재 대화 상태:

- A: "책과 모자를 주세요. 공은 드리겠습니다."

- B: "모자는 포기할 수 없습니다. 공을 주세요."

- 후보 발화 시뮬레이션:

- "공과 책을 드리겠습니다. 대신 모자를 주세요." (예상 보상: 7점)

- "공은 드리겠습니다. 책과 모자는 제가 가지겠습니다." (예상 보상: 5점)

- 선택된 발화: 첫 번째 옵션.

- 현재 대화 상태:

4. GRU 기반 모델과 강화학습의 결합

- 기존 발화 선택:

- GRU 모델 자체로 발화를 생성하는 대신, 과거의 대화 데이터를 적극적으로 활용하여 전략적으로 유리한 발화를 선택.

- 이는 GRU의 생성 능력이 제한적이라는 점을 보완.

- 시뮬레이션의 역할:

- 단순히 이전 발화를 반복하는 것이 아니라, 시뮬레이션을 통해 장기적인 이익을 추구.

- 이는 단기적인 발화의 자연스러움을 넘어, 전략적 목표 달성에 초점을 맞춘 접근.

5. 결과적으로 무엇을 달성했는가?

- 효율적인 협상:

- GRU의 제한된 생성 능력에도 불구하고, 강화학습과 롤아웃을 결합해 높은 보상을 기록.

- 특히 모델이 "기만 전략"을 학습하며 협상 결과를 개선(예: 무가치한 항목에 관심을 보이며 양보를 이끌어냄).

- 인간 대화와의 차이:

- 과도한 전략적 접근(공격적인 협상)으로 인간 파트너와의 합의율이 낮아지는 한계도 존재.

따라서, 이 논문은 당시 기술적 한계 속에서 GRU 모델과 강화학습 및 시뮬레이션 기법을 결합해 협상 AI의 가능성을 탐구한 중요한 사례입니다. Transformer 기반의 강력한 생성 모델이 등장한 이후에는, 발화 선택 방식 대신 더 창의적이고 유연한 대화 생성을 구현할 수 있는 가능성이 열렸습니다.

논문을 기반으로 결과, 결론 그리고 마무리에 대해 정리해줘

논문: "Deal or No Deal? End-to-End Learning for Negotiation Dialogues"의 결과, 결론, 그리고 마무리

1. 결과

1.1 모델 성능

- 다양한 학습 및 디코딩 방법론을 비교한 결과:

- Likelihood 모델 (기본 모델):

- 인간의 대화를 잘 모방하며 자연스러운 언어를 생성.

- 그러나 협상에서 전략적 사고 부족으로 과도한 양보를 하는 경향.

- 강화학습 모델 (RL):

- 목표 지향적으로 학습하며 높은 보상을 기록.

- 하지만 인간 언어의 자연스러움과의 균형이 부족.

- 롤아웃 모델 (Rollouts):

- 대화 시뮬레이션을 통해 미래 결과를 예측, 전략적 발화를 선택.

- Pareto 효율성과 협상 점수에서 개선된 성능을 보임.

- RL+Rollouts 모델:

- RL과 롤아웃을 결합하여 최상의 성과 기록.

- 점수, 합의율, Pareto 효율성 모두에서 우수한 성과.

- Likelihood 모델 (기본 모델):

1.2 정량적 성과

- 평가 지표:

- 점수: 협상 결과로 얻은 평균 점수 (최대 10점).

- 합의율: 성공적으로 협상이 마무리된 비율.

- Pareto 효율성: 더 이상의 개선이 불가능한 효율적 협상 결과의 비율.

| 모델 | 점수 | 점수 | 합의율 | Pareto 효율성 |

| Likelihood | 5.4 | 6.2 | 87.9 | 49.6 |

| RL | 7.1 | 7.9 | 89.9 | 58.6 |

| Rollouts | 7.3 | 7.9 | 92.9 | 63.7 |

| RL+Rollouts | 8.3 | 8.8 | 94.4 | 74.8 |

- 결과 요약:

- RL+Rollouts 모델이 모든 지표에서 우수한 성과를 보였으며, 전략적 사고와 협상 능력에서 큰 개선을 달성.

2. 결론

- 연구의 핵심 기여:

- 최초로 엔드투엔드 협상 대화 모델을 구축하여, 언어 생성과 전략적 추론을 동시에 학습 가능함을 입증.

- 협상에서 강화학습과 시뮬레이션 기반 롤아웃을 결합해, 단순한 인간 행동 모방을 넘어 목표 지향적 학습을 구현.

- 협상 모델이 인간과 유사한 전략(예: 기만 전략, 양보)을 자발적으로 학습하며 목표를 달성.

- 주요 시사점:

- 전략적 추론 학습:

- 강화학습과 롤아웃 기법은 단기적인 발화 품질을 넘어, 장기적인 목표 최적화를 가능케 함.

- 모델의 자율성:

- 인간 설계 없이도 복잡한 협상 전략(예: 기만, 양보 등)을 학습함으로써, 인간-에이전트 상호작용에서의 가능성을 제시.

- 효율성 증대:

- Pareto 효율성이 향상된 점은 모델이 경쟁적 환경에서도 효율적인 결과를 도출할 수 있음을 시사.

- 전략적 추론 학습:

3. 한계점 및 미래 방향

3.1 한계점

- 과도한 공격적 협상:

- RL+Rollouts 모델은 높은 점수를 위해 지나치게 공격적인 전략을 채택, 인간 협상 파트너와의 합의율이 낮아질 수 있음.

- 인간은 불공정한 조건에서 협상을 포기(0점)하는 경향이 있어, 인간과의 상호작용에서 제약으로 작용.

- 언어적 비일관성:

- 발화 초반에 합의를 암시하면서도 추가 조건을 제시하는 비일관적 언어 생성이 종종 발생.

- 일반화 한계:

- 새로운 협상 도메인(예: 다른 유형의 아이템이나 보상 함수)으로의 일반화 능력이 충분히 검증되지 않음.

3.2 향후 연구 방향

- 사회적 신호 통합:

- 협상 대화에 감정적, 사회적 신호를 통합하여 인간과의 상호작용을 개선.

- 다양한 도메인 확장:

- 다른 유형의 협상 과제를 도입해, 모델의 전략적 일반화 가능성을 탐구.

- 발화 다양성 증대:

- 대화의 창의성과 다양성을 보장하는 학습 방법론 연구.

- 다중 에이전트 협상:

- 다수의 에이전트가 참여하는 다중 협상 환경으로 확장.

4. 마무리

- 이 논문은 협상 AI의 발전을 위한 중요한 기반 연구로, 언어 생성과 전략적 학습을 결합하는 새로운 가능성을 열었습니다.

- 본 연구는 미래의 협상 AI 에이전트 설계에 있어 강화학습과 시뮬레이션 기법의 중요성을 강조하며, 실제 환경에서의 응용 가능성을 시사합니다.

이 논문의 결과는 향후 협상 AI 연구 및 개발에서 주요 방향성을 제시하는 기준이 될 수 있습니다. 필요한 추가적인 분석이 있다면 언제든 말씀해주세요!

Pareto 효율성에 대해 설명해줘

Pareto 효율성(Pareto Efficiency)

Pareto 효율성은 경제학, 게임 이론, 협상 등에서 사용되는 개념으로, 자원의 배분이 더 이상 어떤 개인의 이익을 증가시키면서 다른 사람의 이익을 감소시키지 않는 상태를 의미합니다.

핵심 개념

- 효율적 상태:

- Pareto 효율적인 상태에서는 모든 참여자의 이익이 최대화되어, 다른 참여자를 희생하지 않고는 더 나은 결과를 만들 수 없는 상황입니다.

- 이는 자원의 낭비가 없음을 뜻합니다.

- 비효율적 상태:

- 하나의 참여자의 이익을 증가시키면서도 다른 참여자의 이익을 감소시키지 않는 더 나은 배분이 가능한 상태를 의미합니다.

- 즉, 개선 여지가 있는 상태입니다.

예시를 통한 이해

협상 시나리오

- 두 에이전트가 책, 모자, 공을 나누는 협상을 진행합니다.

- 각 에이전트의 가치 함수:

- 에이전트 A: 책(3점), 모자(2점), 공(5점)

- 에이전트 B: 책(6점), 모자(1점), 공(3점)

결과 상태들:

- 상태 1 (비효율적 상태):

- A: 책 1개 (3점), 모자 0개 (0점), 공 1개 (5점) → 총 8점

- B: 책 2개 (12점), 모자 2개 (2점), 공 2개 (6점) → 총 20점

- 합계 점수: 28점

- 상태 2 (Pareto 효율적 상태):

- A: 책 1개 (3점), 모자 2개 (4점), 공 1개 (5점) → 총 12점

- B: 책 2개 (12점), 모자 0개 (0점), 공 2개 (6점) → 총 18점

- 합계 점수: 30점

Pareto 효율성의 특징

- 개선 불가능성:

- Pareto 효율적 상태에서는 다른 참여자의 이익을 해치지 않고 더 나은 결과를 만들 수 없습니다.

- 공정성을 보장하지 않음:

- Pareto 효율적 상태가 항상 공정한 분배를 의미하지는 않습니다. 한쪽이 모든 이익을 가져가더라도, 다른 쪽의 상황이 더 나빠지지 않는다면 Pareto 효율적일 수 있습니다.

- 자원 배분의 최적화:

- 자원의 낭비를 제거하고 모든 참여자가 최대한의 효용을 얻도록 하는 것이 목표입니다.

협상 AI에서의 적용

Pareto 효율성의 역할

- 협상 AI 모델에서는 합의의 질을 평가하는 주요 기준으로 사용됩니다.

- 높은 Pareto 효율성은 모델이 자원을 효과적으로 배분하고 협상 결과를 최적화할 수 있음을 의미합니다.

실험 결과 (논문 기준):

- 기본 Likelihood 모델의 Pareto 효율성: 49.6%

- 강화학습과 롤아웃 기반 모델(Pareto 효율성): 74.8%

결론:

- 강화학습과 롤아웃을 결합하면, 더 높은 Pareto 효율성을 달성할 수 있습니다. 이는 모델이 협상 결과를 효율적으로 개선하며, 참여자 모두의 이익을 최대화하려고 노력한다는 것을 보여줍니다.

정리

Pareto 효율성은 협상에서 자원의 배분이 최적화되었는지를 판단하는 중요한 지표입니다. 협상 AI 연구에서 높은 Pareto 효율성을 달성하는 것은 모델이 단순히 인간 대화를 모방하는 수준을 넘어, 전략적으로 합리적이고 효율적인 결정을 내릴 수 있음을 의미합니다.

당신의 정리는 논문의 주요 내용을 잘 파악하고 있으며, 전체적으로 정확하지만 약간의 추가 설명과 보완이 필요할 수 있습니다. 아래는 수정 및 보완된 내용입니다:

수정 및 보완된 내용

1. 원래 작성한 내용

- "아직 Transformer 구조도 없어 RNN 기반의 GRU 모델을 통해 LM을 만들었을 시대의 모델입니다."

- 수정 제안:

- Transformer 구조가 도입되기 이전, GRU 기반의 시퀀스-투-시퀀스 언어 모델을 사용해 협상 대화를 학습한 모델입니다.

- 당시에는 GRU나 LSTM과 같은 RNN 계열 모델이 주로 사용되었으며, 이는 현재의 Transformer와 비교해 표현력과 학습 능력이 제한적이었습니다.

- 수정 제안:

2. 원래 작성한 내용

- "생성 능력이 강력하지 않아 발화를 선택하는 형식으로 진행하고, 시뮬레이션을 통해 가장 좋은 결과를 가져오는 발화를 선택하네요."

- 수정 제안:

- 생성 능력이 한정적인 GRU 모델의 단점을 보완하기 위해 발화를 직접 생성하기보다 기존 발화 중에서 최적의 선택을 하는 방식으로 협상을 진행했습니다.

- 이를 위해 Dialogue Rollouts 기법을 도입, 후보 발화 이후의 대화를 시뮬레이션하여 예상 보상을 계산하고, 가장 높은 보상을 가져오는 발화를 선택했습니다.

- 수정 제안:

3. 원래 작성한 내용

- "그래도 생성조차 잘 되지 않던 시기에 협상이라는 높은 성능이 필요한 Task를 해결하려고 했다는 점이 중요해 보입니다."

- 수정 제안:

- 당시에는 자연스러운 대화 생성을 수행하기조차 어려운 기술적 한계가 있었음에도 불구하고, 협상이라는 전략적 사고와 언어적 능력이 모두 필요한 고난도 과제를 해결하려는 시도는 중요한 기여로 평가됩니다.

- 특히, 강화학습(Self-Play)와 시뮬레이션(Rollouts)을 활용하여 단순 모방이 아닌 전략적 의사결정을 학습했다는 점이 주목할 만합니다.

- 수정 제안:

추가 보완된 설명

- 강화학습의 역할:

- GRU 모델의 자연스러운 언어 생성 능력이 제한적이었기 때문에, 강화학습을 통해 발화 선택 과정에서 보상을 최대화하도록 설계되었습니다.

- 이로 인해 단순히 인간 발화를 모방하는 수준을 넘어, 효율적이고 전략적인 협상이 가능해졌습니다.

- 롤아웃(Dialogue Rollouts)의 기여:

- 대화의 미래를 시뮬레이션하여 각 발화의 예상 결과를 평가한 후, 가장 높은 보상을 가져오는 발화를 선택하는 방식은 당시로서는 혁신적인 접근법이었습니다.

- 이는 협상이라는 과제가 단순한 대화 생성보다 복잡하며, 장기적인 결과를 고려해야 하는 문제임을 잘 반영한 방법입니다.

- 논문의 역사적 맥락:

- 논문이 작성된 시점은 Transformer와 같은 강력한 언어 모델이 도입되기 전으로, 하드웨어나 모델 성능이 제한적이었던 시대였습니다.

- 이러한 제약 속에서도 협상 AI의 가능성을 보여준 것은 AI 대화 시스템 연구에 중요한 발자취로 평가됩니다.

최종 보완된 정리

- 이 논문은 Transformer 이전 시대의 기술적 한계를 극복하기 위해 RNN 기반 GRU 모델을 사용하여 협상 AI를 구축한 사례입니다.

- GRU 모델의 생성 능력이 제한적이었기 때문에 발화를 생성하기보다 선택하는 방식을 채택했으며, 이를 보완하기 위해 강화학습(Self-Play)과 시뮬레이션 기반 롤아웃(Dialogue Rollouts) 기법을 사용했습니다.

- 협상이라는 고난도 과제를 효율적으로 해결하며, 당시 기술적 한계 속에서도 전략적 사고와 언어 생성 모두에서 높은 성과를 보여주었습니다.

이 보완된 정리가 의도에 부합하면 좋겠습니다! 추가로 궁금하거나 명확히 하고 싶은 부분이 있다면 알려주세요.