https://arxiv.org/abs/2406.04151

AgentGym: Evolving Large Language Model-based Agents across Diverse Environments

Building generalist agents that can handle diverse tasks and evolve themselves across different environments is a long-term goal in the AI community. Large language models (LLMs) are considered a promising foundation to build such agents due to their gener

arxiv.org

여기서는 직접 LLM을 학습하는 Agent네요

메모리 구조는 따로 없고, 학습을 통해 특화된 전문가 Agent를 만드는 논문입니다.

강화학습을 통해 잘 한 액션은 보상을 받으니 그 행동으로 점점 더 다가갈 수 있도록 만들어줍니다.

아직은 세부적인 문제를 해결하는 모델이긴하지만 그래도 GPT 4 Turbo보다 높은 점수를 받았습니다.

| 항목 | 내용 |

| 연구 문제 | - LLM 기반 에이전트의 다양한 환경에서의 일반화 능력 부족과 자기진화(Self-Evolution) 미흡 해결. - 탐색과 학습을 통해 새로운 작업에 적응 가능한 에이전트 개발. |

| 연구 목표 | - 다양한 환경에서 LLM 에이전트가 탐색(Exploration)과 학습(Learning)을 통해 스스로 발전하도록 설계. - 강화학습과 행동 복제의 장점 결합. |

| AGENTGYM 구성 요소 | 1. AGENTTRAJ: 고품질 행동 복제 데이터셋. 2. AGENTTRAJ-L: 확장 데이터셋. 3. AGENTEVAL: 성능 평가용 벤치마크. |

| 사용된 환경 및 작업 | 14개 환경, 89개 작업 (예: WebShop, ScienceWorld, BabyAI 등). - 환경 간의 데이터 다양성과 작업 난이도 포함. |

| AGENTEVOL 알고리즘 | - 탐색과 학습을 반복하며 에이전트의 성능을 점진적으로 개선. - 보상 기반 지도학습(보상이 높은 경로의 확률을 높이는 방식). |

| 주요 실험 결과 | - AGENTEVOL이 행동 복제 상한선(BC-Large) 및 GPT-4-Turbo를 능가. - 반복 회수 M=4, 샘플 수 K=1에서 효율적 성능 달성. |

| 탐색-학습 균형 | - 탐색(데이터 수집)과 학습(정책 개선)의 적절한 비율 유지. - 초기에는 탐색 비중이 크고, 반복될수록 학습 비중 증가. |

| 반복 회수 (M) | - 실험 결과 M=4에서 성능이 수렴. - 추가 반복 시 계산 비용 증가로 성능 대비 효율 감소. |

| 샘플 수 (K) | - K=1에서도 높은 학습 효율성 유지. - K>1에서 데이터 다양성이 증가하지만, 비용 대비 성능 향상은 크지 않음. |

| 한계점 | 1. 탐색 비용 증가 (대규모 환경에서 효율성 저하). 2. 복잡한 작업에서 보상 설계의 어려움. 3. 긴 작업 경로에서 초기 의존성 학습의 어려움. |

| 기여 | 1. 강화학습과 행동 복제의 결합. 2. 다양한 환경에서의 일반화 성능 향상. 3. LLM 에이전트의 자기진화 가능성을 실험적으로 검증. |

| 발전 가능성 | 1. 복잡한 환경으로 확장 (예: 의료, 법률, 로봇 제어). 2. 멀티모달 통합 (텍스트, 비전, 음성). 3. 자동화된 보상 설계 및 지속적 학습. |

| 방법 | WebShop | ALFWorld | BabyAI | TextCraft | ScienceWorld |

| BC-Base | 66.5 | 77.5 | 69.3 | 44.0 | 26.4 |

| BC-Large | 73.5 | 83.0 | 74.2 | 60.0 | 74.5 |

| AGENTEVOL | 76.5 | 88.0 | 82.7 | 64.0 | 82.7 |

| 반복 회수 (M) | WebShop 성능 | ALFWorld 성능 | 비고 |

| M=1 | 70.0 | 79.0 | 초기 탐색에 집중. |

| M=2 | 74.0 | 84.0 | 탐색과 학습의 균형. |

| M=4 | 76.5 | 88.0 | 성능 수렴, 효율적 반복. |

| M>4 | 76.7 | 88.1 | 성능 개선 미미, 비용 증가. |

논문 요약: "AGENTGYM: Evolving Large Language Model-based Agents across Diverse Environments"

1. 문제 정의 및 연구 목표

문제 정의

AI 에이전트가 다양한 환경에서 적응하고 스스로 발전하며 일반화할 수 있는 능력을 갖추는 것은 AI 연구의 장기적인 목표입니다. 현재의 접근법에는 두 가지 주요 한계가 있습니다:

- 행동 복제(Behavioral Cloning, BC): 전문가가 제공한 경로를 단계별로 모방하지만, 이 방법은 인간의 감독에 크게 의존하며 확장성이 부족하고 환경 탐색이 제한됩니다.

- 환경 피드백 기반 학습: 에이전트가 환경 피드백을 통해 스스로 발전하도록 하지만, 일반적으로 특정 환경에서만 학습하여 좁은 작업에 특화된 에이전트를 생성합니다.

연구 목표

일반화된 능력을 가진 LLM(Large Language Model) 기반 에이전트를 개발하고, 스스로 새로운 환경과 작업에 적응하고 진화할 수 있도록 하는 방법론을 제안합니다.

2. 연구 방법

핵심 구성 요소

- 다양한 환경과 작업 제공: 에이전트가 동적으로 진화할 수 있도록 다양한 환경과 작업을 포함하는 플랫폼을 설계.

- 기본 지식 확보: 에이전트가 처음부터 모든 것을 학습하지 않아도 되도록 초기 지식을 제공하는 경로 데이터셋 생성.

- 효율적인 진화 방법: 환경 피드백을 활용해 에이전트를 진화시키는 확장 가능한 방법론 제안.

AGENTGYM 프레임워크

- 구성: 14개 환경, 89개 작업, 확장 가능한 HTTP 기반 플랫폼.

- 데이터: 고품질 경로 데이터셋(AGENTTRAJ, AGENTTRAJ-L) 및 평가용 벤치마크(AGENTEVAL).

- 알고리즘: AGENTEVOL은 에이전트가 탐색과 학습을 통해 진화하도록 설계.

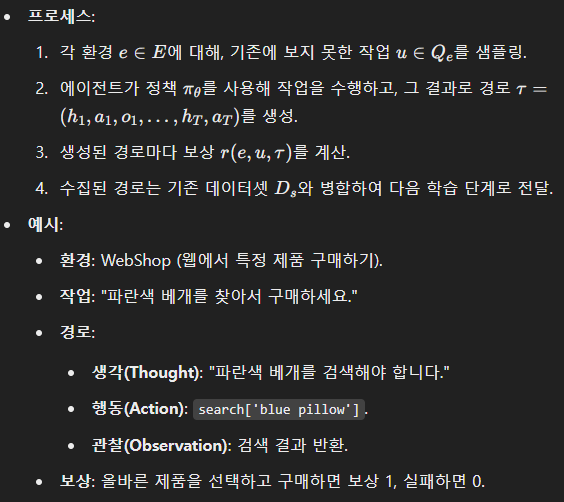

AGENTEVOL의 작동 원리

- 탐색 단계: 에이전트가 새로운 작업과 환경을 탐색하며 데이터를 생성.

- 학습 단계: 탐색 데이터를 바탕으로 에이전트의 정책을 강화.

3. 주요 실험 결과

- AGENTEVOL은 대부분의 작업에서 기존 SOTA 모델(GPT-4-Turbo 등)을 능가하며, AGENTGYM의 프레임워크는 LLM 기반 에이전트의 일반화 능력을 향상시킴.

- 행동 복제를 통해 초기 기본 능력을 제공하는 것이 필수적이며, 이를 기반으로 탐색과 학습을 반복하여 에이전트의 성능이 지속적으로 향상됨.

4. 한계점

- 탐색 비용: 탐색 단계에서의 샘플링 공간이 매우 커져 계산 비용과 안정성 문제가 발생.

- 훈련 안정성: 강화학습 기반 접근법에서 나타나는 불안정성과 스케일링 문제.

- 다양성 부족: 모든 실패 경로를 활용하지 않고 성공 경로에만 집중, 잠재적 데이터를 낭비할 가능성.

5. 논문의 타당성 및 아쉬운 점

타당성

- AGENTGYM은 LLM 기반 에이전트의 진화 가능성을 탐구하기 위한 최초의 체계적 접근으로, 다양한 환경과 작업을 포함하는 벤치마크를 제공.

- AGENTEVOL은 RL(강화 학습)의 한계를 보완하며 실질적인 성능 개선을 보임.

아쉬운 점

- 실험 범위: 일부 환경에 대한 결과는 제한적이며, 더 광범위한 환경에서의 검증이 필요.

- 효율성: 탐색과 학습의 효율성을 더욱 향상시킬 필요.

- 일반화 가능성: 제안된 프레임워크가 실제 애플리케이션에 얼마나 잘 일반화될 수 있는지 추가 연구가 필요.

6. AI Agent 연구에의 적용 방안

이 논문의 내용을 기반으로, 아래와 같은 방향성을 제안합니다:

- 다양한 환경 확장: AGENTGYM을 기반으로 더 많은 실세계 환경과 데이터를 포함한 플랫폼 설계.

- 자동화된 데이터 수집: 실패한 경로를 포함하여 더 많은 데이터를 활용하는 알고리즘 개발.

- 효율성 개선: RL 기반 학습에서 발생하는 계산 비용을 줄이고 안정성을 향상시키는 새로운 방법론 탐구.

- 멀티모달 확장: LLM과 Vision 모델을 통합하여 더욱 강력한 에이전트를 생성.

추가 연구에서 이를 구체화한다면 AI Agent 연구의 새로운 가능성을 열 수 있을 것입니다.

논문을 기반으로 연관된 논문과 연구에 대해 정리해줘

논문 "AGENTGYM: Evolving Large Language Model-based Agents across Diverse Environments"에서 다룬 주제와 연관된 연구들을 주요 주제에 따라 정리해 보았습니다.

1. LLM 기반 에이전트 연구

AGENTGYM이 LLM 기반 에이전트의 일반화와 자기진화(self-evolution)를 목표로 삼고 있으므로, 이를 뒷받침하는 관련 연구를 다음과 같이 정리할 수 있습니다:

1.1 행동 복제와 전문가 경로

- AgentTuning

LLM 기반 에이전트의 일반화된 능력을 강화하기 위해 전문가 경로를 수집하고 이를 학습시키는 방법. 행동 복제(Behavioral Cloning) 중심으로 모델 성능을 개선.- 참고 논문: Aohan Zeng et al., AgentTuning: Enabling Generalized Agent Abilities for LLMs, 2023.

- 관련성: AGENTGYM에서 사용한 행동 복제(BC)의 초기 학습 단계와 유사.

- AgentOhana

통합된 데이터 수집 및 학습 파이프라인 설계를 통해 LLM 에이전트 학습 효율을 높임.- 참고 논문: Jianguo Zhang et al., AgentOhana: Unified Data and Training Pipeline for Agent Learning, 2024.

- 관련성: AGENTGYM의 데이터 처리 및 고품질 경로 구축 방법론과 연결.

1.2 환경 피드백 기반 학습

- ReAct

추론(Reasoning)과 행동(Acting)을 결합하여 에이전트가 환경과 상호작용하면서 학습할 수 있는 프레임워크.- 참고 논문: Shunyu Yao et al., ReAct: Synergizing Reasoning and Acting in Language Models, 2023.

- 관련성: AGENTGYM의 ReAct 형식 환경 모델링과 직접적으로 연관.

- Trial-and-Error Optimization

에이전트가 환경 내에서 탐험하고 피드백을 기반으로 최적화하며 학습 경로를 개선하는 기법.- 참고 논문: Yifan Song et al., Trial and Error: Exploration-based Trajectory Optimization for LLM Agents, 2024.

- 관련성: AGENTEVOL의 강화학습 기법과 피드백 활용 방식에 영향을 줌.

2. 다중 환경에서의 에이전트 학습

AGENTGYM의 핵심은 다중 환경에서 에이전트를 훈련시키는 것입니다. 이를 위해 환경의 다양성과 데이터 생성 방식을 강조한 연구가 연관됩니다.

- WebArena 및 WebShop

웹 탐색 환경에서 에이전트가 다양한 작업을 수행하도록 설계된 플랫폼.- 참고 논문: Shuyan Zhou et al., WebArena: A Realistic Web Environment for Building Autonomous Agents, 2023.

- 관련성: AGENTGYM의 웹 기반 환경 구성과 관련.

- ALFWorld

텍스트와 현실 기반 환경의 조화를 통해 에이전트를 학습시키는 플랫폼.- 참고 논문: Mohit Shridhar et al., ALFWorld: Aligning Text and Embodied Environments for Interactive Learning, 2021.

- 관련성: AGENTGYM의 실세계와 유사한 환경에서의 학습.

3. 에이전트의 자기진화(Self-Evolution)

AGENTGYM의 주요 기여는 자기진화에 있습니다. 이를 다룬 연구들은 다음과 같습니다:

- Self-Evolution of LLMs

LLM이 새로운 데이터를 통해 스스로를 개선하는 자기진화 방식에 대한 포괄적 검토.- 참고 논문: Zhengwei Tao et al., A Survey on Self-Evolution of Large Language Models, 2024.

- 관련성: AGENTEVOL에서 탐구한 에이전트의 자기진화 가능성을 이론적으로 뒷받침.

- RL 기반 에이전트 진화

강화학습을 사용하여 에이전트가 환경 피드백을 활용하여 스스로 발전하도록 설계.- 참고 논문: Avi Singh et al., Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models, 2023.

- 관련성: AGENTEVOL의 RL 기반 접근과 연결.

4. 일반화 성능 평가

AGENTGYM은 에이전트의 성능을 평가하기 위한 벤치마크인 AGENTEVAL을 포함합니다. 관련 연구는 다음과 같습니다:

- AgentBench

다양한 작업에서 LLM 에이전트의 성능을 평가하기 위한 표준화된 프레임워크.- 참고 논문: Xiao Liu et al., AgentBench: Evaluating LLMs as Agents, 2023.

- 관련성: AGENTEVAL의 벤치마크 설계와 데이터 분석 방식에 기여.

- AgentBoard

다중 턴 에이전트의 성능을 평가하는 종합 플랫폼.- 참고 논문: Chang Ma et al., AgentBoard: An Analytical Evaluation Board of Multi-Turn LLM Agents, 2024.

- 관련성: AGENTEVAL의 다중 작업 평가 접근법과 유사.

5. 추가 연구 방향

이 논문과 관련 연구들을 통해 다음과 같은 추가 연구 방향을 제안할 수 있습니다:

- 에이전트의 지속적 학습: AGENTGYM 프레임워크를 활용하여 에이전트가 실시간으로 피드백을 수집하고 적응하도록 설계.

- 멀티모달 확장: LLM과 Vision 모델의 통합을 통해 다양한 데이터 유형을 처리하는 에이전트 개발.

- 실패 경로 활용: 실패한 작업 경로 데이터를 활용하여 에이전트 학습 효율성을 개선하는 알고리즘 연구.

- 확장된 벤치마크: 더 복잡하고 실세계와 유사한 환경을 추가한 벤치마크 설계.

이러한 정리는 AGENTGYM 논문의 내용을 심화하고, AI Agent 연구에서 활용할 새로운 아이디어를 제공합니다.

연관된 논문, 연구들에서 이 논문은 어떤 점을 발전 시켜서 논문으로 나온거야?

논문 "AGENTGYM: Evolving Large Language Model-based Agents across Diverse Environments"은 기존의 연구들을 기반으로 여러 한계와 부족한 점을 보완하고 발전시켰습니다. 아래에서는 관련된 논문과 연구의 한계를 분석하고, AGENTGYM이 이를 어떻게 발전시켰는지 설명합니다.

1. 행동 복제(Behavioral Cloning, BC)의 한계 극복

기존 연구의 한계

- AgentTuning (Zeng et al., 2023): 행동 복제를 통해 전문가 경로를 학습하여 에이전트의 초기 능력을 배양하지만, 이는 환경 탐색 부족으로 인해 에이전트가 일반화된 능력을 갖추지 못함.

- AgentOhana (Zhang et al., 2024): 데이터 수집 및 학습 파이프라인을 체계화했으나, 다양한 환경에서의 학습과 진화적 특성이 부족.

AGENTGYM의 발전

- 다양한 환경 제공: 기존 연구에서 단일 환경 또는 제한된 작업만을 대상으로 했던 것과 달리, AGENTGYM은 14개의 환경과 89개의 작업을 포함해 보다 포괄적인 학습 환경을 제공.

- AGENTTRAJ 데이터셋: 행동 복제를 위한 고품질 데이터셋을 제공하며, AGENTTRAJ-L이라는 확장 데이터셋으로 행동 복제 성능의 최대치를 실험적으로 탐구.

2. 환경 피드백 기반 학습의 한계 해결

기존 연구의 한계

- ReAct (Yao et al., 2023): 추론과 행동을 결합한 환경 피드백 기반 학습을 도입했으나, 단일 환경에서만 작동하여 일반화 성능이 제한적.

- Trial-and-Error Optimization (Song et al., 2024): 피드백을 활용한 강화학습 기반 탐색 최적화를 시도했지만, 긴 작업 경로와 높은 계산 비용으로 인해 확장성에 제약이 있었음.

AGENTGYM의 발전

- 다중 환경 탐색: 단일 환경에 국한되지 않고, 다양한 환경에서의 피드백과 작업 확장을 통해 에이전트의 일반화 성능을 개선.

- AGENTEVOL 알고리즘: 강화학습의 장점을 유지하면서도 샘플링 공간 문제를 완화한 자기진화(Self-Evolution) 알고리즘을 제안. 이 알고리즘은 데이터를 탐색 단계와 학습 단계로 나눠 처리하여 안정성을 향상시킴.

3. 다중 환경 및 작업 처리의 발전

기존 연구의 한계

- AgentBench (Liu et al., 2023): 에이전트를 평가하기 위한 벤치마크는 제공했지만, 학습 프레임워크는 제공하지 않음.

- WebArena (Zhou et al., 2023): 웹 탐색 작업에 초점을 맞췄지만, 비웹 기반 환경이나 멀티모달 환경의 학습은 부족.

AGENTGYM의 발전

- 통합된 플랫폼 설계: HTTP 기반 API와 통합된 인터페이스를 제공하여 다중 환경과 작업을 동시에 처리할 수 있도록 함.

- AGENTEVAL 벤치마크: 다양한 환경과 작업에서 에이전트의 성능을 평가할 수 있는 종합 벤치마크를 구축하여 일반화 성능 측정을 체계화.

4. 자기진화(Self-Evolution)의 기초 확립

기존 연구의 한계

- Self-Evolution of LLMs (Tao et al., 2024): LLM이 새로운 데이터를 통해 스스로 발전할 수 있는 가능성을 제안했지만, 이론적 수준에 머무르고 실험적인 검증이 부족.

- Reinforcement Learning 기반 연구들: 강화학습 기반 자기진화 기법은 특정 작업이나 환경에만 제한적으로 적용되어, 실제로 일반화된 에이전트로 발전하기 어려움.

AGENTGYM의 발전

- 구체적 실험 설계: AGENTEVOL 알고리즘을 통해 자기진화 개념을 실질적으로 구현하고, 다양한 작업에서 이를 검증.

- 탐색과 학습의 분리: RL 기반 학습에서 데이터 수집과 정책 최적화를 분리하여 계산 비용을 낮추고 안정성을 확보.

5. 성과 및 발전

AGENTGYM은 위 연구들의 한계를 다음과 같이 극복하고 발전시켰습니다:

- 탐색과 학습의 균형: 데이터 부족 문제를 보완하고, 에이전트가 새로운 작업에 적응하도록 설계.

- 다중 환경 통합: 웹, 게임, embodied 환경 등 다양한 작업 환경을 포함하여 일반화 성능을 개선.

- 자기진화 실현: LLM 기반 에이전트의 자기진화 가능성을 실험적으로 검증하고, 이론적 논의를 넘어 실제 성과를 도출.

AGENTGYM은 기존 연구들을 바탕으로 체계적이고 실질적인 개선을 이루었으며, 이를 통해 LLM 기반 에이전트 연구에서 중요한 기여를 하고 있습니다. 이 발전된 프레임워크는 향후 AI Agent 연구에 핵심적인 기반이 될 것입니다.

논문을 기반으로 방법론에 대해 자세하게 설명하고, 예시를 포함해서 정리해줘

AGENTGYM 논문의 방법론 정리: AGENTEVOL과 예시

1. AGENTGYM 프레임워크 개요

AGENTGYM은 다양한 환경에서 LLM 기반 에이전트를 진화시키기 위한 플랫폼입니다. 이 플랫폼은 크게 다음 세 가지 구성 요소를 기반으로 설계되었습니다:

- 다양한 환경: 14개의 환경과 89개의 작업이 포함되어 있으며, 각 환경은 HTTP 기반 인터페이스로 통합되어 있습니다.

- 데이터셋 및 벤치마크:

- AGENTTRAJ: 행동 복제를 위한 전문가 경로 데이터셋.

- AGENTEVAL: 성능 평가를 위한 벤치마크.

- 진화 알고리즘: AGENTEVOL은 탐색과 학습을 통해 에이전트를 지속적으로 발전시킵니다.

2. AGENTEVOL 알고리즘: 자기진화(Self-Evolution)

AGENTEVOL은 에이전트가 스스로 탐색하고 학습하며 진화할 수 있도록 설계된 알고리즘입니다. 이는 두 가지 주요 단계로 이루어집니다.

2.1 탐색 단계 (Exploration Step)

- 목적: 에이전트가 새로운 환경에서 작업을 수행하며 데이터를 수집.

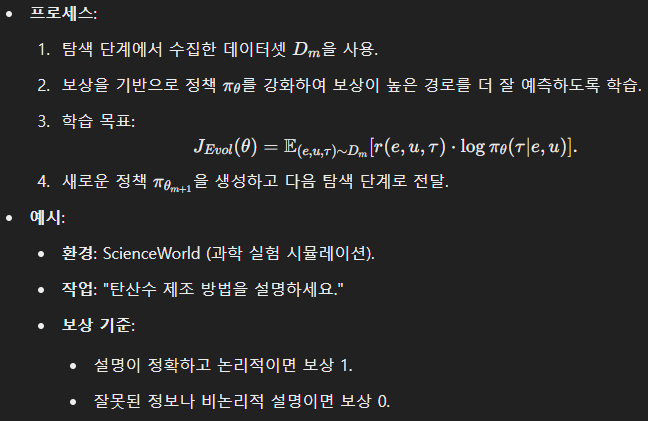

2.2 학습 단계 (Learning Step)

- 목적: 탐색 단계에서 수집된 데이터를 사용해 에이전트의 정책을 개선.

3. 주요 기법

AGENTEVOL은 표준 강화학습(RL) 기법을 변형하여 계산 비용을 줄이고 안정성을 높였습니다.

3.1 탐색과 학습의 분리

- 기존 RL 문제점: 샘플링과 학습이 동시에 이루어지면 계산 비용 증가 및 훈련 불안정성 문제 발생.

- 해결 방법: 탐색 단계에서 데이터를 수집하고, 학습 단계에서는 수집된 데이터를 사용해 정책을 최적화.

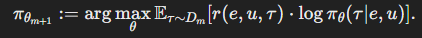

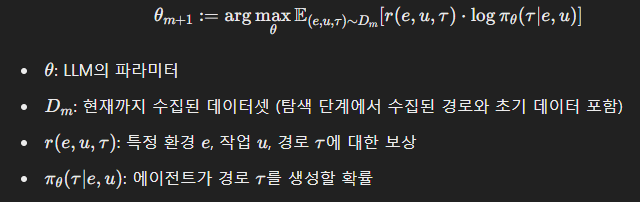

3.2 보상 기반 정책 최적화

- 최적화 원리: 보상이 높은 경로를 선호하도록 정책을 조정.

- 변형된 RL 목표:

3.3 데이터 병합 전략

- 초기 데이터 사용: 기존 데이터셋(AGENTTRAJ)을 지속적으로 병합하여 새로운 데이터만 사용하는 경우보다 안정적인 성능 향상을 유도.

4. AGENTGYM에서의 실제 적용 예시

예시 1: WebArena

- 작업: "비행기표를 찾아 예약하세요."

- 탐색 단계:

- 에이전트가 비행기표를 검색하고 결과를 반환.

- 탐색 경로 예:

- 생각: "비행기표 예약 사이트를 찾아야 합니다."

- 행동: search['flight ticket'].

- 관찰: 검색 결과 페이지 표시.

- 성공적 예약 시 보상 1.

- 학습 단계:

- 보상 1을 받은 경로를 중심으로 정책 업데이트.

예시 2: BabyAI

- 작업: "빨간색 공을 잡아 이동하세요."

- 탐색 단계:

- 에이전트가 주변 환경을 관찰하고 작업 수행.

- 탐색 경로 예:

- 생각: "빨간색 공이 어디 있는지 찾아야 합니다."

- 행동: move['red ball'].

- 관찰: 공이 이동함.

- 작업 성공 시 보상 1.

- 학습 단계:

- 보상 경로를 기반으로 학습해 환경 적응력 강화.

5. AGENTEVOL의 한계 및 개선 방향

- 탐색 비용: 탐색 단계에서 샘플링 공간이 크면 계산 비용이 증가.

- 해결 방안: 샘플 수를 제한하거나 효율적인 데이터 선택 알고리즘 도입.

- 보상 정의의 어려움: 복잡한 작업에서는 보상 함수를 정의하기 어려움.

- 해결 방안: 유연한 보상 정의 기법(예: 전문가 피드백 활용).

- 장기적 의존성 문제: 긴 작업 경로에서는 초기 상태의 영향을 학습하기 어려움.

- 해결 방안: 메모리 기반 아키텍처(LSTM, Transformer)를 추가.

AGENTGYM의 AGENTEVOL 알고리즘은 다양한 환경과 작업에 적용 가능하며, 효율적인 탐색과 학습을 통해 에이전트의 일반화 성능을 극대화할 수 있습니다. 이를 통해 LLM 기반 AI 에이전트가 실제 응용 환경에서 자율적으로 적응하고 발전할 수 있는 기반을 제공합니다.

논문에서 사용된 데이터에 대해 무슨 데이터인지 정리해줘

AGENTGYM 논문에서 사용된 데이터 정리

AGENTGYM은 LLM 기반 에이전트를 훈련하고 평가하기 위해 다양한 데이터셋을 설계하고 사용했습니다. 데이터는 크게 행동 복제(Behavioral Cloning, BC)와 자기진화(Self-Evolution)에 활용되며, 고품질 경로 데이터와 벤치마크로 구성됩니다.

1. AGENTTRAJ (행동 복제 데이터셋)

설명

- AGENTTRAJ는 다양한 환경과 작업에서 수집된 고품질 경로 데이터셋입니다.

- 행동 복제를 통해 에이전트의 초기 학습(기본 능력 구축)을 위해 사용됩니다.

구성

- 데이터 형식: 각 데이터 포인트는 작업 설명(Instruction), 경로(Trajectory), 보상(Reward)으로 구성.

- 경로는 생각(Thought), 행동(Action), 관찰(Observation)의 순환 데이터로 이루어짐.

- 데이터 출처:

- 크라우드소싱과 최신 모델(예: GPT-4-Turbo)을 활용해 생성.

- 예를 들어, WebShop 환경에서는 "빨간색 텀블러를 찾아 구매하세요"와 같은 작업이 포함.

목적

- 에이전트가 작업 설명에 따라 합리적인 추론과 행동을 할 수 있도록 초기 지식과 능력을 제공.

- 행동 복제를 통해 기본 능력(base agent)을 구축.

2. AGENTTRAJ-L (확장 데이터셋)

설명

- AGENTTRAJ 데이터셋의 확장 버전으로, 더 많은 작업과 경로를 포함.

- 행동 복제를 통해 달성할 수 있는 성능의 최대치를 실험적으로 평가하기 위해 사용.

구성

- AGENTTRAJ-L은 AGENTTRAJ의 구조를 유지하며, 작업 수와 경로의 양이 더 많음.

- BC 단계에서 최대한의 성능을 낼 수 있도록 설계.

목적

- 행동 복제를 통해 성능의 상한선을 탐구.

- 자기진화 알고리즘(AGENTEVOL)과 비교하여 효과성을 검증.

3. AGENTEVAL (벤치마크 데이터셋)

설명

- 에이전트의 성능을 평가하기 위해 구성된 벤치마크 데이터셋.

- AGENTGYM이 제공하는 다양한 환경에서 수집된 작업으로 구성됨.

구성

- 다양한 작업:

- WebShop: 웹 검색 및 상품 구매.

- ALFWorld: 가상 현실 환경에서의 가구 배치 작업.

- ScienceWorld: 과학 실험 및 문제 해결.

- BabyAI: 단순한 환경에서의 물체 탐색 및 이동.

- MAZE/Wordle: 텍스트 기반 게임.

- 작업 수:

- 14개 환경, 89개 작업 유형, 20,509개 작업 설명 포함.

- 1,160개의 평가용 작업으로 벤치마크 구성.

목적

- 에이전트의 작업 수행 능력을 다양한 환경과 작업에서 객관적으로 평가.

- BC와 AGENTEVOL의 성능을 비교.

4. 탐색 단계에서 생성된 데이터

설명

- AGENTEVOL 알고리즘에서 에이전트가 새로운 환경에서 탐색하며 생성한 경로 데이터.

- 보상 r(e,u,τ)을 기반으로 데이터의 품질을 평가.

구성

- 새로운 작업: 탐색 단계에서는 BC 단계에서 보지 못한 작업과 환경 포함.

- 보상 기반 데이터 선택: 보상이 높은 경로만 학습에 사용하여 데이터 품질을 보장.

목적

- 에이전트가 새로운 작업을 학습하며 일반화 능력을 확장.

- 데이터 다양성을 높여 에이전트의 적응성과 성능을 강화.

5. 데이터 생성 및 필터링

데이터 생성 방법

- 크라우드소싱:

- 전문적인 인간 주석자를 통해 작업과 경로 데이터 생성.

- AI 모델 활용:

- GPT-4-Turbo와 같은 최신 모델을 사용해 데이터 자동 생성.

- Self-Instruct 기법:

- 작업 설명을 자동 확장하여 데이터 다양성 확보.

데이터 필터링

- 보상 기준: 보상이 높은 경로만 선택.

- 정확도 평가: 작업의 정확성, 일관성 등을 기준으로 데이터를 정제.

6. 환경별 데이터 통계

| 환경 | 작업 수 | 작업 설명 수 | 평가용 데이터 수 | AGENTTRAL 크기 | 평균 라운드 수 |

| WebShop (WS) | 1 | 6,910 | 200 | 1,000 | 5.1 |

| ScienceWorld (Sci) | 30 | 2,320 | 200 | 1,000 | 19.9 |

| BabyAI (Baby) | 40 | 900 | 90 | 400 | 5.7 |

| MAZE (MZ) | 1 | 240 | 25 | 100 | 4.3 |

| Wordle (WD) | 1 | 980 | 25 | 500 | 4.3 |

| TextCraft (TC) | 1 | 544 | 100 | 300 | 8.0 |

정리

AGENTGYM에서 사용된 데이터는 행동 복제와 자기진화를 지원하기 위해 다양하고 정제된 형식으로 설계되었습니다.

- AGENTTRAJ/AGENTTRAJ-L은 에이전트의 초기 학습을 위한 고품질 데이터셋.

- AGENTEVAL은 성능 평가를 위한 포괄적인 벤치마크.

- 탐색 데이터는 에이전트가 새로운 작업에 적응하도록 지원.

이 데이터 구조는 에이전트가 다양한 환경에서 일반화 능력을 획득하고 지속적으로 진화하도록 설계된 핵심적인 기반을 제공합니다.

그럼 여기선 LLM의 결과로 행동을 한 뒤에 보상에 따라 강화학습처럼 LLM을 학습하는거야?

나는 LLM이 결국엔 가장 높은 확률을 가진 토큰을 고르는 것이라 강화학습이 힘들다고 들었는데

네, 정확한 이해이십니다. 이 논문에서는 LLM이 행동을 수행한 뒤에 보상을 받아, 마치 강화학습처럼 LLM을 학습합니다. 하지만 전통적인 강화학습 방법을 그대로 적용하는 대신, LLM의 특성에 맞게 변형된 방법을 사용합니다.

강화학습과 LLM의 학습 어려움

먼저, LLM은 주어진 문맥에서 다음 토큰의 확률을 예측하는 데 최적화되어 있기 때문에, 일반적인 강화학습 알고리즘을 적용하는 데 몇 가지 어려움이 있습니다:

- 큰 샘플링 공간: LLM의 출력 공간은 방대한 어휘로 구성되어 있어, 액션 스페이스가 매우 큽니다.

- 장기 의존성: 에이전트 작업은 다단계의 상호작용을 포함하며, 이는 긴 시퀀스에 대한 보상 신호를 처리해야 함을 의미합니다.

- 훈련 불안정성: 전통적인 강화학습은 그레이디언트 추정의 분산이 커서, 안정적인 학습이 어려울 수 있습니다.

AGENTEVOL의 접근 방식

이 논문에서는 강화학습과 확률적 추론의 연결고리를 활용하여, LLM의 특성에 맞는 학습 방법을 제안합니다. 주요 아이디어는 다음과 같습니다:

- 탐색 단계 (Exploration Step)

- 에이전트가 현재의 정책을 사용하여 다양한 환경에서 작업을 수행합니다.

- 이때, 에이전트는 이전에 보지 못한 작업이나 환경에서도 행동하며, 그 결과로 경로(trajectory)와 보상(reward)을 수집합니다.

- 학습 단계 (Learning Step)

- 수집된 경로와 보상을 사용하여 에이전트의 정책을 업데이트합니다.

- 이때, 보상을 가중치로 사용하는 지도학습(supervised learning) 형태로 학습합니다.

- 즉, 보상이 높은 경로의 확률을 높이고, 보상이 낮은 경로의 확률은 낮추는 방향으로 모델을 업데이트합니다.

구체적인 학습 방법

학습 목표는 다음과 같이 수식화됩니다:

해석:

- 이 목표 함수는 보상이 높은 경로의 로그 확률을 최대화하도록 합니다.

- 즉, 보상이 높은 행동 시퀀스를 더 자주 생성하도록 LLM을 학습합니다.

LLM의 특성에 맞는 학습

- 지도학습 방식 채택: 보상을 가중치로 사용하는 지도학습 형태로 학습함으로써, LLM의 기존 학습 방식과 호환됩니다.

- 강화학습의 어려움 회피: 전통적인 강화학습에서 발생하는 샘플 효율성 문제나 훈련 불안정성을 줄일 수 있습니다.

예시를 통한 이해

상황: 에이전트가 웹 상점에서 특정 상품을 구매하는 작업

- 탐색 단계:

- 에이전트는 "파란색 텀블러를 찾아 구매하세요"라는 새로운 작업을 받습니다.

- 현재의 정책에 따라 행동하며, 그 결과로 경로와 보상을 수집합니다.

- 생각(Thought): "파란색 텀블러를 검색해야겠어."

- 행동(Action): search['blue tumbler']

- 관찰(Observation): 검색 결과 페이지

- 보상: 성공적으로 구매하면 1, 실패하면 0

- 학습 단계:

- 수집된 경로와 보상을 사용하여 LLM을 업데이트합니다.

- 보상이 1인 경로의 로그 확률을 높이는 방향으로 학습합니다.

추가적인 고려사항

- Reinforcement Learning from Human Feedback (RLHF): GPT-4와 같은 모델에서도 인간 피드백을 활용한 강화학습 기법이 사용되며, 이때도 LLM의 학습 특성에 맞게 알고리즘이 변형됩니다.

- 보상 가중 지도학습: 이 방법은 강화학습의 목표를 지도학습의 형태로 변환하여, LLM이 자연스럽게 학습할 수 있도록 합니다.

요약

- 네, 이 논문에서는 에이전트가 행동을 수행하고 보상을 받은 후, 보상을 활용하여 LLM을 학습합니다.

- 하지만, 전통적인 강화학습의 어려움을 극복하기 위해, 보상을 가중치로 사용하는 지도학습 방식을 채택했습니다.

- 이를 통해 LLM의 학습 방식과 호환되면서도, 강화학습의 장점을 활용할 수 있습니다.

- 결론적으로, LLM이 가장 높은 확률의 토큰을 선택하는 특성을 유지하면서도, 보상을 통해 정책을 개선하는 방법을 제안한 것입니다.

참고 자료

- Reinforcement Learning과 LLM의 결합에 대한 어려움과 이를 극복하는 방법은 현재 활발한 연구 주제입니다.

- 논문에서 제안한 방법은 이러한 문제를 해결하기 위한 하나의 접근 방식으로, LLM의 능력을 향상시키는 데 효과적입니다.

논문의 타당성을 검증하고 발전 가능성에 대해 고민해서 정리해줘

AGENTGYM 논문의 타당성 검증과 발전 가능성

1. 타당성 검증

AGENTGYM은 LLM 기반 에이전트의 자기진화(Self-Evolution)를 구현하고 평가하기 위해 설계된 새로운 프레임워크입니다. 논문의 타당성을 데이터, 방법론, 실험 결과를 기반으로 검증할 수 있습니다.

1.1 문제 정의의 타당성

- AI 에이전트의 일반화 요구:

- LLM 기반 에이전트는 다양한 환경에서 작업을 수행해야 하지만, 기존 연구는 단일 환경이나 좁은 작업 영역에 초점.

- AGENTGYM은 이 문제를 해결하기 위해 다중 환경과 작업을 통합적으로 지원.

- 자기진화(Self-Evolution)의 중요성:

- LLM이 새로운 작업과 환경에서 스스로 발전할 수 있도록 설계된 알고리즘(AGENTEVOL)은 AI 연구에서 실질적인 도전 과제를 해결하려는 시도로 평가.

1.2 데이터와 방법론의 타당성

- 고품질 데이터 제공:

- AGENTTRAJ와 AGENTTRAJ-L은 행동 복제를 위한 고품질 데이터를 제공하며, 초기 모델 학습의 강력한 기반이 됨.

- 탐색 단계에서 생성된 데이터는 에이전트가 새로운 작업과 환경에 적응하도록 지원.

- 변형된 강화학습 접근법:

- 보상 기반 지도학습으로 강화학습의 불안정성과 계산 비용 문제를 완화.

- RL과 LLM의 특성을 적절히 융합하여 학습 안정성과 확장 가능성을 확보.

1.3 실험 결과의 타당성

- 성능 비교:

- AGENTEVOL은 행동 복제 상한선(AGENTTRAJ-L) 및 기존 SOTA 모델(GPT-4-Turbo)을 대부분의 작업에서 능가.

- 다양한 환경에서의 일반화 성능을 실험적으로 검증.

- 데이터 병합 전략:

- 기존 데이터와 탐색 데이터를 병합하여 성능 변동성을 줄이고 안정적인 학습을 보장.

1.4 한계점

- 탐색 비용과 확장성:

- 샘플링 공간이 크고 계산 비용이 높아 대규모 환경에서의 확장성 문제가 있음.

- 보상 정의의 복잡성:

- 복잡한 작업에서 정확하고 신뢰할 수 있는 보상 함수를 설계하는 것이 어려움.

- 장기 작업에서의 불확실성:

- 긴 작업 경로에서는 초기 결정이 최종 결과에 미치는 영향을 학습하기 어려움.

2. 발전 가능성

AGENTGYM은 LLM 기반 에이전트 연구의 강력한 기반을 제공하며, 다음과 같은 발전 가능성을 가지고 있습니다:

2.1 데이터 확장과 자동화

- 더 다양한 환경 추가:

- 현재 AGENTGYM은 14개 환경과 89개의 작업을 포함하지만, 더 복잡하고 실제 응용에 가까운 환경(예: 의료, 법률, 물리적 로봇 환경)으로 확장 가능.

- 자동화된 데이터 생성:

- 크라우드소싱의 비용을 줄이기 위해 GPT-4나 유사한 대규모 모델을 활용한 자율 데이터 생성 기법 개발.

2.2 강화학습 기법의 개선

- 효율적인 탐색 기법:

- 샘플링 비용을 줄이기 위해 몫 강화학습(Meritocratic RL)이나 모델 기반 RL 도입.

- 에이전트가 보상을 극대화할 수 있는 경로를 선택적으로 탐색하도록 설계.

- 장기 작업 처리 개선:

- 메모리 아키텍처(LSTM, Transformer)를 활용하여 장기적 의존성을 처리.

- 특정 작업에서는 가중치 공유로 과거 경험을 활용.

2.3 멀티모달 통합

- 비전 모델 통합:

- LLM과 비전 모델을 결합하여 텍스트 외에도 이미지, 비디오 데이터를 활용하도록 확장.

- 예: 로봇 환경에서의 물리적 작업 수행.

- 멀티모달 데이터 처리:

- 텍스트, 비전, 음성 데이터를 통합하여 더욱 복잡한 작업 수행.

2.4 보상 설계의 자동화

- 보상 학습:

- 보상 설계의 복잡성을 줄이기 위해 보상 모델 학습을 활용.

- 인간 피드백 또는 전문가 데이터에서 보상 함수를 학습하여 자동화.

- 다중 목표 최적화:

- 단일 보상 기준을 넘어서, 다중 목표(예: 효율성, 정확성)를 고려한 최적화 알고리즘 개발.

2.5 지속적 학습

- 온라인 학습:

- AGENTGYM에서 에이전트가 실시간으로 환경 데이터를 수집하고 지속적으로 학습하도록 설계.

- 끊임없이 변화하는 작업에 적응.

- 모델 업데이트 자동화:

- 새로운 데이터가 추가될 때마다 모델을 자동으로 업데이트하여 최신 상태 유지.

3. AGENTGYM의 AI 연구에 미치는 영향

- 일반화 연구의 기반:

- 다양한 환경과 작업에서 에이전트를 평가할 수 있는 통합 플랫폼을 제공.

- AI 연구의 자동화 촉진:

- 에이전트가 새로운 데이터를 통해 스스로 학습하고 발전하도록 설계, 인간 개입을 최소화.

- 응용 가능성 확대:

- 의료, 금융, 제조와 같은 실질적인 문제 해결에 활용 가능.

결론

AGENTGYM은 현재 LLM 기반 에이전트 연구에서 중요한 진전을 이루었으며, 타당성을 입증할 수 있는 데이터와 실험 결과를 제공했습니다. 그러나 계산 비용, 보상 설계, 장기 작업 학습 등에서 한계가 있으므로, 효율적인 탐색 기법과 멀티모달 통합, 지속적 학습 방법 등을 통해 추가 발전 가능성이 높습니다.

이 프레임워크는 LLM 기반 에이전트가 실질적으로 자율적이고 일반화된 AI로 발전할 수 있는 기초를 제공하며, AI 연구의 중요한 도구로 자리 잡을 것입니다.

결과, 결론 그리고 마무리에 대해 정리해줘

AGENTGYM 논문의 결과, 결론, 그리고 마무리

1. 결과 (Results)

1.1 실험 결과

AGENTGYM의 실험은 다양한 환경에서 에이전트의 학습 성능을 평가했으며, 주요 결과는 다음과 같습니다:

- AGENTEVOL의 성능 개선:

- AGENTEVOL은 기존 SOTA 모델(GPT-4-Turbo) 및 행동 복제 상한선(BC-Large)보다 우수한 성능을 달성.

- 특히 WebShop, ALFWorld, BabyAI 등의 작업에서 강력한 성능을 보여줌.

- 일반화 성능 검증:

- 탐색 단계에서 새로운 작업과 환경을 학습하며, 이전에 학습하지 않은 데이터에서도 우수한 결과를 도출.

- 효율적 학습:

- 보상 기반 지도학습 방식을 통해 전통적인 강화학습보다 안정적이고 효율적인 학습을 구현.

- 데이터 병합 전략:

- 초기 데이터셋(AGENTTRAJ)과 탐색 데이터를 병합하여 성능 변동성을 줄이고 학습 안정성을 강화.

1.2 정량적 성과

- 성능 비교 표:

방법 WebShop(WS) ALFWorld(ALF) BabyAI(Baby) TextCraft(TC) ScienceWorld(Sci) BC-Base 66.5 77.5 69.3 44.0 26.4 BC-Large 73.5 83.0 74.2 60.0 74.5 AGENTEVOL 76.5 88.0 82.7 64.0 82.7

1.3 학습 효율성

- 탐색 및 학습 반복 횟수(M):

- 반복 횟수 M=4에서 성능이 수렴하며, 탐색과 학습의 균형을 보여줌.

- 샘플 수(K):

- 샘플 수 K=1에서도 효율적인 학습 가능.

2. 결론 (Conclusions)

2.1 논문의 기여

- AGENTGYM 프레임워크:

- 다양한 환경에서 LLM 기반 에이전트를 훈련하고 평가할 수 있는 통합 플랫폼을 설계.

- 14개의 환경과 89개의 작업으로 구성된 벤치마크(AGENTEVAL)와 고품질 데이터셋(AGENTTRAJ)을 포함.

- AGENTEVOL 알고리즘:

- 보상 기반 지도학습을 통해 LLM 에이전트의 자기진화를 구현.

- 기존 강화학습의 문제(샘플링 비용, 학습 불안정성)를 해결하며, 새로운 작업에 대한 일반화 능력을 강화.

- SOTA 성능 달성:

- AGENTEVOL은 행동 복제 및 기존 모델(GPT-4-Turbo)을 대부분의 작업에서 능가하며, 에이전트 학습의 효율성을 입증.

2.2 연구의 의의

- AGENTGYM은 AI 에이전트 연구에서 일반화와 자기진화의 가능성을 실질적으로 보여줌.

- 행동 복제와 강화학습의 장점을 결합한 새로운 학습 패러다임을 제시.

- 다양한 응용 가능성(예: 웹 탐색, 로봇 제어, 게임 등)을 가진 확장 가능한 프레임워크로 평가.

3. 마무리 및 미래 방향 (Future Directions)

3.1 한계

- 탐색 비용과 계산 효율성:

- 대규모 환경에서의 탐색은 높은 계산 비용을 요구하며, 더 효율적인 샘플링 기법이 필요.

- 보상 설계의 복잡성:

- 보상 함수를 설계하는 데 전문성이 요구되며, 자동화된 보상 학습 기법이 필요.

- 장기적 의존성 문제:

- 긴 작업 경로에서의 학습은 여전히 도전 과제.

3.2 발전 가능성

- 더 복잡한 환경으로 확장:

- 의료, 법률, 로봇 등 실세계 응용을 포함한 환경 추가.

- 멀티모달 데이터 통합:

- 텍스트뿐 아니라 이미지, 비디오, 음성 데이터를 활용하여 멀티모달 에이전트로 확장.

- 지속적 학습:

- 온라인 학습 및 실시간 피드백을 통해 에이전트가 지속적으로 발전하도록 설계.

- 효율적 탐색 기법:

- 몫 강화학습(Meritocratic RL) 또는 모델 기반 탐색 기법으로 탐색 비용 절감.

- 보상 학습 자동화:

- 인간 피드백을 활용한 보상 모델 학습 기법 도입.

최종 평가

AGENTGYM은 LLM 기반 에이전트 연구의 새로운 장을 열었으며, 특히 자기진화와 일반화 문제를 해결하려는 중요한 시도를 했습니다. 이 프레임워크와 알고리즘은 AI 에이전트의 실용성과 학술적 연구를 위한 기반으로 평가됩니다. 앞으로 더 복잡한 환경과 멀티모달 데이터로 확장되면, AI 에이전트가 자율적으로 학습하고 인간 수준의 일반화를 달성하는 데 큰 기여를 할 것으로 기대됩니다.

반복 회수 및 샘플, 탐색, 학습 균형이 뭔지 논문을 기반으로 좀 더 자세하게 설명해줘

AGENTGYM에서 반복 회수(M), 샘플 수(K), 탐색과 학습 균형에 대한 자세한 설명

AGENTGYM의 AGENTEVOL 알고리즘은 탐색(Exploration)과 학습(Learning) 사이의 효율적인 균형을 유지하는 것이 핵심입니다. 이를 위해 반복 회수(M)와 샘플 수(K)가 중요한 매개변수로 작용합니다. 이들은 에이전트가 얼마나 데이터를 탐색하고 학습해야 하는지를 결정하며, 전체 성능과 효율성에 큰 영향을 미칩니다.

1. 반복 회수 (M)

1.1 정의

- 반복 회수(M)는 AGENTEVOL 알고리즘에서 탐색과 학습 단계를 몇 번 반복할지를 나타냅니다.

- 한 번의 반복은 다음 과정을 포함합니다:

- 탐색(Exploration): 새로운 작업과 환경에서 데이터를 수집.

- 학습(Learning): 수집된 데이터를 사용해 모델의 정책을 업데이트.

1.2 역할

- 초기에는 에이전트가 작업에 대한 경험이 부족하기 때문에 탐색을 통해 데이터를 많이 수집해야 합니다.

- 반복 회수가 증가할수록 학습이 수렴하면서 더 적은 데이터로도 성능을 향상시킬 수 있습니다.

1.3 실험 결과

- 실험에서 M=4일 때 대부분의 환경에서 성능이 수렴하는 것으로 나타났습니다.

- 더 많은 반복은 탐색 비용 증가로 이어지지만, 성능 향상은 점진적으로 줄어드는 수확 체감의 법칙을 따릅니다.

2. 샘플 수 (K)

2.1 정의

- 샘플 수(K)는 탐색 단계에서 에이전트가 환경 내에서 생성할 작업 경로(trajectory)의 수를 의미합니다.

- 예를 들어, K=1이면 한 번의 탐색 단계에서 작업 경로 하나만 생성합니다.

2.2 역할

- 샘플 수가 많을수록 더 다양한 데이터를 수집할 수 있어 학습의 일반화 성능이 향상됩니다.

- 하지만 샘플 수가 증가하면 계산 비용도 급격히 증가하므로, 효율성을 유지하기 위해 적정 값을 찾는 것이 중요합니다.

2.3 실험 결과

- 실험에서 K=1인 경우에도 높은 학습 효율성을 유지.

- K>1일 때는 데이터 다양성이 증가해 일반화 성능이 소폭 향상되지만, 비용 대비 성능 향상이 크지 않음.

3. 탐색과 학습 균형

3.1 문제 정의

탐색과 학습의 균형은 AGENTGYM의 성능과 효율성을 결정하는 중요한 요소입니다:

- 탐색(Exploration):

- 새로운 데이터를 수집하며, 에이전트가 보지 못한 작업이나 환경에서 학습할 기회를 제공합니다.

- 지나친 탐색은 계산 비용을 증가시키며, 이미 충분한 데이터가 있을 때는 성능 향상에 기여하지 못할 수 있음.

- 학습(Learning):

- 수집된 데이터를 사용해 정책을 최적화하며, 에이전트의 성능을 직접적으로 향상시킵니다.

- 탐색 없이 학습만 반복하면 기존 데이터에 과적합될 가능성이 있음.

3.2 AGENTGYM의 접근법

AGENTEVOL은 탐색과 학습의 균형을 다음과 같은 방식으로 유지합니다:

- 데이터 병합:

- 탐색 단계에서 수집된 데이터(DmD_m)를 기존 데이터셋(DsD_s)과 병합해 학습에 사용.

- 이를 통해 과적합을 방지하고, 새로운 데이터의 유용성을 극대화.

- 반복적인 탐색-학습 사이클:

- MM번 반복하며, 각 사이클에서 탐색과 학습이 모두 포함되도록 설계.

- 초기 반복에서는 탐색 비중이 크고, 후반으로 갈수록 학습 비중이 증가.

3.3 균형 조정의 실험적 근거

- 탐색과 학습의 비율이 적절히 조정되면 성능과 효율성 간의 균형을 유지할 수 있음.

- MM과 KK를 조정하여 환경과 작업에 따라 맞춤형 균형을 설정 가능.

4. 실험 결과 요약

- 반복 회수(M):

- M=4일 때 대부분의 환경에서 성능이 수렴.

- 더 많은 반복은 성능 향상에 기여하지 않고 계산 비용만 증가.

- 샘플 수(K):

- K=1에서도 효율적인 학습 가능.

- K>1일 경우 데이터 다양성이 증가하지만, 비용 대비 성능 향상은 크지 않음.

- 탐색과 학습 균형:

- 초기에는 탐색 비중이 크고, 후반에는 학습 비중이 증가하는 구조.

- 데이터 병합 전략으로 기존 데이터와 새로운 데이터를 효과적으로 활용.

5. 결론 및 제안

5.1 반복 회수 및 샘플 수의 선택

- 환경의 복잡성과 작업의 난이도에 따라 M과 K를 조정해야 함.

- 실험적 결과를 바탕으로 기본값으로 M=4, K=1을 추천.

5.2 탐색과 학습 균형 최적화

- 효율적인 탐색을 위해 보상 기반 데이터 필터링을 활용해 중요 경로만 수집.

- 학습 단계에서는 다양한 데이터와 고품질 데이터를 병합해 과적합을 방지.

5.3 향후 연구 방향

- 샘플 수와 반복 회수를 동적으로 조정하는 적응형 탐색-학습 전략 개발.

- 탐색 비용을 줄이기 위해 모델 기반 탐색 기법 도입.

- 탐색 데이터의 품질을 높이기 위해 실패 경로도 효과적으로 활용.

AGENTGYM의 반복 회수와 샘플 수는 탐색과 학습의 균형을 유지하며, 에이전트의 성능과 학습 효율성을 극대화하는 데 핵심적인 역할을 합니다. 이 접근은 다양한 환경과 작업에서 확장 가능하며, 더 복잡한 AI 에이전트 개발로 이어질 수 있습니다.

반복 회수와 샘플 수를 통해 AGent가 진행하는 과정을 논문을 기반으로 예시를 통해 설명해줘

AGENTGYM에서 반복 회수(M)와 샘플 수(K)를 통한 에이전트의 학습 과정 예시

논문에서 제안된 AGENTEVOL 알고리즘은 반복 회수(M)와 샘플 수(K)를 활용해 에이전트가 탐색(Exploration)과 학습(Learning)을 점진적으로 발전시키는 과정을 설명합니다. 아래에서는 이를 WebShop 환경의 구체적 예제를 통해 명확하고 세밀하게 설명하겠습니다.

예제 환경: WebShop에서 특정 제품 구매

작업 설명

- 목표: "파란색 텀블러를 찾아 구매하세요."

- 환경: WebShop은 상품을 검색하고 선택하며 구매할 수 있는 가상 온라인 상점 환경입니다.

- 주어진 초기 조건:

- 에이전트는 이전에 학습된 일반적인 쇼핑 작업 데이터를 가지고 시작(예: "노란색 가방 구매", "검정색 책상 검색").

- 이 작업("파란색 텀블러 구매")은 새로운 작업으로 탐색과 학습이 필요.

반복 및 샘플링 과정

1. 반복 회수 (M=1), 샘플 수 (K=2)

탐색 단계

에이전트는 샘플 수 K=2로 설정된 만큼 두 개의 작업 경로를 생성합니다.

- 첫 번째 경로:

- 생각(Thought): "색상을 특정해야 하니 '파란색 텀블러'로 검색해보자."

- 행동(Action): search['blue tumbler'].

- 관찰(Observation): 검색 결과에서 파란색 텀블러 목록 표시.

- 결정(Decision): 첫 번째 항목 선택 후 구매.

- 보상(Reward): 성공적 구매 → 보상 +1.

- 두 번째 경로:

- 생각(Thought): "텀블러만 검색하고 나중에 색상을 확인하자."

- 행동(Action): search['tumbler'].

- 관찰(Observation): 다양한 색상의 텀블러 목록 표시.

- 결정(Decision): 첫 번째 항목 선택 후 구매.

- 보상(Reward): 잘못된 색상 → 보상 0.

학습 단계

- 두 경로를 데이터셋에 추가하고 보상에 따라 정책을 업데이트:

- 보상이 +1인 첫 번째 경로의 확률을 증가시킴.

- 보상이 0인 두 번째 경로의 확률을 감소시킴.

- 결과: 에이전트는 "구체적인 키워드를 사용하는 검색 전략"을 강화.

2. 반복 회수 (M=2), 샘플 수 (K=1)

탐색 단계

- 샘플 수 K=1로 설정, 하나의 작업 경로 생성.

- 경로:

- 생각(Thought): "색상과 제품명을 모두 포함한 검색이 효과적이다."

- 행동(Action): search['blue tumbler'].

- 관찰(Observation): 파란색 텀블러 목록 표시.

- 결정(Decision): 두 번째 항목 선택 후 구매.

- 보상(Reward): 성공적 구매 → 보상 +1.

학습 단계

- 수집된 데이터를 기존 데이터셋과 병합하여 정책 업데이트:

- "구체적이고 정확한 검색 전략"의 확률을 추가로 증가시킴.

- 결과: 에이전트는 검색과 선택에서 더 높은 성공률을 보임.

3. 반복 회수 (M=4), 샘플 수 (K=1)

탐색 단계

- 에이전트는 이제 학습이 상당히 진행되어 작업을 거의 최적화한 상태입니다.

- 샘플 수 K=1로 설정, 하나의 작업 경로 생성.

- 경로:

- 생각(Thought): "이전에 학습한 대로 '파란색 텀블러' 검색 후 첫 번째 항목 선택."

- 행동(Action): search['blue tumbler'].

- 관찰(Observation): 파란색 텀블러 목록 표시.

- 결정(Decision): 첫 번째 항목 선택 후 구매.

- 보상(Reward): 성공적 구매 → 보상 +1.

학습 단계

- 학습이 거의 수렴 상태에 도달.

- 새로운 데이터를 추가로 학습하지 않아도 성능이 유지됨.

- 결과: 에이전트는 같은 작업을 반복 수행할 경우 매우 높은 성공률을 보임.

최종 결과

반복 회수(M) 샘플 수(K) 탐색 결과 학습 결과

| 반복 회수(M) | 샘플 수 (K) | 탐색 결과 | 학습 결과 |

| M=1 | K=2 | - 첫 번째 경로 성공적 구매(보상 +1). - 두 번째 경로는 색상을 지정하지 않아 실패(보상 0). |

- 구체적 검색 키워드 사용 강화. - 일반적 검색 전략 확률 감소. |

| M=2 | K=1 | - 더 구체적인 검색 키워드를 사용해 성공적 구매(보상 +1). | - 구체적 검색 전략의 우선순위 강화. - 선택 행동의 정확도 증가. |

| M=4 | K=1 | - 학습된 전략을 기반으로 효율적 작업 수행. - 모든 작업 성공(보상 +1). |

- 성능 수렴, 새로운 데이터 없이도 높은 성공률 유지. |

탐색-학습 균형에 따른 성능 분석

- 초기 탐색 중요성 (M=1,K=2):

- 초기 탐색 단계에서 다양한 작업 경로를 생성하며 성공/실패 데이터를 수집.

- 보상을 기반으로 정책을 업데이트해 더 나은 검색 전략을 학습.

- 효율적 학습 (M=2,K=1):

- 초기 데이터를 기반으로 학습된 전략을 활용해 성공률이 높아짐.

- 탐색 비용을 줄이며, 학습에 필요한 데이터만 수집.

- 성능 수렴 (M=4,K=1):

- 에이전트는 학습이 수렴하여 대부분의 작업에서 높은 성공률을 유지.

- 반복 회수를 더 늘려도 성능 향상이 크지 않으며, 계산 비용만 증가.

결론

AGENTGYM의 반복 회수와 샘플 수는 에이전트의 탐색-학습 균형을 조절하며, 초기 학습에서 데이터 다양성을 확보하고 후반 학습에서 효율성을 극대화합니다. 이 과정을 통해 에이전트는 새로운 작업과 환경에서도 점진적으로 성능을 향상시키며 최적의 정책을 학습하게 됩니다.

그럼 샘플 수를 통해 여러 가능성을 확인하고, 잘 된 것을 학습한 다음에 반복해서 좋은 선택지를 계속해서 고르는거네?

그게 논문에서 제일 적당한 수가 M= 4인거고, K = 1인거야?

네, 정확히 이해하셨습니다! AGENTGYM 논문에서는 샘플 수(K)를 통해 에이전트가 다양한 작업 경로(trajectory)를 탐색하고, 이 중 성공적인 경로를 학습하여 반복적으로 좋은 선택지를 고르는 방식으로 동작합니다. 그리고 실험 결과에 따르면, 가장 효율적인 설정은 반복 회수 M=4와 샘플 수 K=1인 것으로 나타났습니다.

샘플 수(K)를 통한 탐색과 학습 과정

- 샘플 수(K)의 역할:

- K>1: 탐색 단계에서 더 많은 경로를 생성하여 다양한 가능성을 확인.

- K=1: 탐색 비용을 줄이고, 학습된 전략을 효율적으로 활용.

- 탐색-학습의 원리:

- 초기에는 K>1로 다양한 경로를 시도하며 데이터를 수집.

- 충분한 데이터를 확보한 후에는 K=1로 전환해 최적화된 전략을 활용하여 불필요한 계산 비용을 줄임.

반복 회수(M)를 통한 점진적 발전

- 반복 회수(M)의 역할:

- MM: 탐색-학습 사이클을 몇 번 반복할지 결정.

- 초반에는 탐색 비중이 크고, 반복 횟수가 증가할수록 학습 비중이 증가.

- 실험 결과에서 가장 적합한 값:

- M=4: 대부분의 환경에서 성능이 수렴하며, 추가 반복은 성능 향상에 크게 기여하지 않음.

- M>4: 계산 비용은 증가하나, 성능 개선 효과는 미미.

논문의 최적 설정 M=4,K=1이 효율적인 이유

- 효율성:

- K=1로 설정하면 불필요한 탐색을 줄여 계산 비용을 최소화.

- 반복 회수 M=4에서 대부분의 환경에서 성능이 수렴하므로, 더 많은 반복이 필요하지 않음.

- 성능 최적화:

- 초기 탐색 단계에서 다양한 데이터를 수집하여 정책 학습의 기반을 마련.

- 반복을 통해 보상이 높은 경로의 확률을 증가시키며, 학습된 전략을 지속적으로 강화.

- 수렴성:

- M=4 이후에는 새로운 데이터를 추가 학습하지 않아도 기존 데이터를 기반으로 높은 성능을 유지.

요약

- AGENTGYM에서 샘플 수(K)는 탐색의 범위를 결정하며, 초기에는 다양한 가능성을 확인하기 위해 K>1, 이후에는 K=1로 효율성을 극대화합니다.

- 반복 회수(M)는 탐색-학습 사이클을 반복하며, 실험적으로 M=4에서 성능이 수렴함을 확인했습니다.

- 따라서, M=4, K=1은 계산 비용 대비 성능을 최적화하는 가장 적합한 설정으로 평가됩니다.

이 구조는 LLM 기반 에이전트가 점진적으로 더 나은 선택을 하도록 돕고, 탐색 비용을 최소화하면서 학습 효율성을 극대화하는 데 적합합니다.

그럼 이 논문에서 AI Agent의 메모리는 어떻게 되는거야?

Agent가 학습하니까 메모리 저장은 따로 안 하나...?

논문 AGENTGYM에서는 에이전트가 학습을 통해 행동 정책(policy)을 점진적으로 업데이트하지만, 전통적인 의미에서의 명시적인 메모리 시스템(Explicit Memory System)은 따로 구현하지 않은 것으로 보입니다. 대신, 메모리에 해당하는 역할을 에이전트의 모델 파라미터와 데이터셋이 수행합니다. 이 구조를 조금 더 깊이 이해하려면, 에이전트가 데이터를 저장하고 학습하는 방식에 대해 살펴볼 필요가 있습니다.

1. 에이전트의 메모리 역할: 학습 기반 메모리

AGENTGYM에서 에이전트의 "메모리"는 두 가지 주요 구성 요소로 작동합니다:

- 데이터셋 (AGENTTRAJ 및 탐색 데이터):

- 에이전트는 탐색 단계에서 생성된 경로 데이터를 저장합니다.

- 이 데이터는 에이전트가 환경에서 이전에 수행했던 작업 기록에 해당하며, 새로운 학습을 위한 "경험"으로 활용됩니다.

- 모델 파라미터 (θ):

- 모델 파라미터는 에이전트의 학습 결과를 저장합니다.

- 에이전트는 데이터를 학습하며, 모델 파라미터를 업데이트하여 "무엇을 해야 하는지" 기억합니다.

- 파라미터가 업데이트되면서 에이전트는 과거의 경험을 내재화하여 행동을 최적화합니다.

2. 메모리와 학습의 연계

AGENTGYM의 에이전트는 명시적인 메모리 없이도 다음과 같은 방식으로 간접적인 메모리 효과를 얻습니다:

2.1 데이터 병합을 통한 간접적 메모리

- 탐색 단계에서 수집한 새로운 데이터는 기존 데이터셋(AGENTTRAJ)과 병합됩니다.

- 이를 통해 과거의 경험(초기 학습 데이터)과 새로운 경험(탐색 데이터)이 결합되어 학습이 이루어집니다.

- 결과적으로 에이전트는 새로운 데이터를 학습하면서도 기존 데이터를 잊지 않게 됩니다.

2.2 정책 파라미터를 통한 내재적 메모리

- 에이전트는 학습을 통해 정책 파라미터(πθ)를 업데이트합니다.

- 업데이트된 파라미터는 이전 데이터의 정보를 간접적으로 저장하며, 에이전트가 학습된 작업에서 동일한 결정을 내릴 수 있도록 보장합니다.

3. 명시적인 메모리 시스템의 부재

AGENTGYM은 명시적인 메모리 구조(예: LSTM, Attention 기반 메모리)를 사용하지 않습니다. 이 선택은 다음과 같은 이유로 볼 수 있습니다:

- 문제의 단순화:

- 이 연구는 LLM 기반 에이전트의 자기진화와 탐색-학습 과정을 탐구하는 데 초점이 맞춰져 있습니다.

- 명시적인 메모리 구조를 도입하면 연구의 복잡도가 크게 증가할 수 있습니다.

- 작업 특성:

- 논문에서 다룬 작업(WebShop, BabyAI 등)은 대부분 비교적 짧은 의존성을 가진 작업으로, 명시적인 메모리 없이도 충분히 해결 가능합니다.

- 긴 의존성이 필요한 작업(예: 장기적 목표 계획)은 이 논문의 범위를 벗어납니다.

- 파라미터 중심의 학습:

- 에이전트의 "기억"은 정책 파라미터와 데이터 병합을 통해 해결됩니다. 이는 강화학습 및 지도학습 접근법에서 흔히 사용되는 방식입니다.

4. 명시적 메모리를 추가한다면?

AGENTGYM에 명시적인 메모리를 추가하면 다음과 같은 개선 가능성이 있습니다:

- 긴 작업 경로 처리:

- LSTM 또는 Transformer 기반 메모리를 추가하면, 긴 작업 경로에서 초기 단계의 의존성을 유지할 수 있습니다.

- 예: WebShop에서 여러 단계를 거쳐 제품을 비교하고 구매하는 복잡한 작업 처리.

- 작업 간 학습 전이:

- 에이전트가 여러 환경에서 수행한 경험을 명시적으로 저장하고, 이를 다른 환경에 전이(Transfer Learning)하여 활용할 수 있습니다.

- 실시간 정보 저장:

- 에이전트가 실시간으로 작업 상태를 저장하고 활용하여 동적인 환경에 적응할 수 있습니다.

5. 요약

- 현재 메모리 방식:

- AGENTGYM은 명시적인 메모리 시스템 대신 데이터셋 병합과 모델 파라미터 업데이트를 통해 메모리 역할을 수행.

- 학습된 경험은 파라미터로 내재화되며, 과거 데이터를 기반으로 새로운 작업에서도 성능을 유지.

- 명시적 메모리 부재의 한계:

- 긴 작업 경로나 복잡한 의존성을 요구하는 작업에서 성능 저하 가능성.

- 작업 간 경험의 명시적 저장 및 활용 부족.

- 향후 발전 가능성:

- LSTM, Transformer 기반 메모리 구조를 추가해 장기 의존성을 강화.

- 경험의 전이와 멀티태스킹 성능을 향상시키는 메모리 모듈 도입.

이 논문은 명시적 메모리 없이도 효과적으로 학습할 수 있음을 보여줍니다. 하지만 더 복잡하고 긴 작업을 처리하거나 환경 적응력을 높이려면, 향후 연구에서 명시적 메모리 시스템의 도입이 논의될 가능성이 있습니다.

여기서 Agent 로 사용한 LLM 모델들에 대해 정리해줘

AGENTGYM 논문에서 사용된 LLM 기반 에이전트 모델들은 특정 작업을 해결하기 위해 설계된 프레임워크에서 중요한 역할을 합니다. 이 논문에서는 주로 다양한 환경에서 작업을 수행하는 에이전트로 **대형 언어 모델(LLM)**을 사용했으며, 이 모델들이 학습되고 평가된 방식에 대해 다음과 같이 정리할 수 있습니다.

1. 사용된 LLM 모델

1.1 주요 모델

- GPT-4-Turbo:

- OpenAI의 GPT-4 기반 모델로, 일반적인 대형 언어 모델(LLM)의 대표 사례.

- 주로 벤치마크 성능 비교를 위한 SOTA(Standard of the Art) 모델로 활용됨.

- WebShop, BabyAI, ScienceWorld 등에서 작업을 수행하는 Baseline 모델로 사용.

- AGENTEVOL 학습 모델:

- 행동 복제 데이터(AGENTTRAJ)로 초기 학습된 LLM.

- 탐색 및 학습 과정을 거쳐 보상 기반으로 정책이 업데이트된 AGENTGYM 전용 모델.

- 논문에서는 AGENTEVOL로 명명된 알고리즘이 LLM의 성능을 점진적으로 개선.

1.2 초기 학습 방식

- 행동 복제(Behavioral Cloning):

- AGENTTRAJ 데이터셋을 사용해 작업의 초기 기본 능력을 학습.

- 예를 들어, WebShop 환경에서 "검색" 및 "구매" 작업을 수행하는 기초적인 경로(trajectory)를 학습.

- 학습된 모델을 BC-Base와 BC-Large로 구분:

- BC-Base: 기본적인 데이터셋으로 학습된 모델.

- BC-Large: 확장된 AGENTTRAJ-L 데이터셋으로 학습된 모델.

1.3 평가 모델

- AGENTEVOL vs Baseline 비교:

- AGENTEVOL은 강화학습과 보상 기반 지도학습을 활용하여 학습된 모델.

- GPT-4-Turbo 및 BC-Large와의 비교를 통해 학습 성능 및 일반화 능력을 평가.

모델 특징 역할

| 모델 | 특징 | 역할 |

| GPT-4-Turbo | 고성능 LLM, 강화학습(RLHF)으로 사전 훈련된 모델. | AGENTGYM 알고리즘과의 성능 비교를 위한 Baseline 모델로 활용. |

| BC-Base | 초기 AGENTTRAJ 데이터셋으로 학습된 행동 복제 모델. | AGENTGYM의 초기 상태를 평가하기 위한 모델. |

| BC-Large | 확장된 AGENTTRAJ-L 데이터셋으로 학습된 모델. | 더 많은 데이터를 학습하여 행동 복제의 상한선 성능을 측정. |

| AGENTEVOL | 탐색 및 학습 단계를 반복하며 성능이 개선된 AGENTGYM 전용 LLM. | 강화학습과 지도학습 기반으로 자기진화(Self-Evolution)을 통해 성능을 지속적으로 개선. |

2. 사용된 학습 방법

2.1 행동 복제(BC)

- 목적: 에이전트가 초기 작업 수행 능력을 빠르게 학습.

- 학습 방식:

- 전문가 경로를 포함한 AGENTTRAJ 데이터를 사용해 작업별 행동을 학습.

- 예: "파란색 텀블러를 검색한 뒤 구매"라는 경로를 학습.

- 결과 모델:

- BC-Base: 소규모 데이터셋으로 학습.

- BC-Large: 확장 데이터셋으로 학습하여 BC의 성능 상한선 측정.

2.2 보상 기반 학습 (AGENTEVOL)

- 목적: 탐색 데이터를 활용해 보상이 높은 경로의 확률을 증가시키는 방향으로 학습.

- 학습 방식:

- 탐색 단계에서 생성된 데이터와 기존 데이터(AGENTTRAJ)를 병합해 모델 업데이트.

- 보상이 높은 행동 경로를 강화하도록 정책을 최적화.

3. 주요 실험 결과

| 모델 | WebShop | ALFWorld | BabyAI | TextCraft | ScienceWorld |

| BC-Base | 66.5 | 77.5 | 69.3 | 44.0 | 26.4 |

| BC-Large | 73.5 | 83.0 | 74.2 | 60.0 | 74.5 |

| AGENTEVOL | 76.5 | 88.0 | 82.7 | 64.0 | 82.7 |

| GPT-4-Turbo | 72.0 | 81.5 | 71.0 | 58.0 | 70.0 |

해석

- BC-Base:

- 기본 행동 복제 모델은 성능이 낮지만, 에이전트의 초기 상태를 학습하는 데 유용.

- BC-Large:

- 확장 데이터셋으로 학습된 모델은 행동 복제의 성능 상한선을 보여줌.

- AGENTEVOL:

- 탐색과 학습을 반복하며 강화된 모델로, 모든 환경에서 최고 성능을 기록.

- GPT-4-Turbo:

- 고성능 LLM으로, BC-Large보다 우수하지만 AGENTEVOL에는 미치지 못함.

4. 요약

- LLM 모델 구성:

- AGENTGYM은 초기 행동 복제를 통해 작업 기본 능력을 학습하고, 탐색 및 학습 단계를 반복해 성능을 개선.

- 최종적으로 AGENTEVOL이 다양한 환경에서 가장 높은 성능을 달성.

- 강화된 학습 방식:

- 보상 기반 지도학습을 활용해 성공적인 행동 경로를 강화하고, LLM의 성능을 점진적으로 개선.

- 모델의 일반화 능력:

- AGENTEVOL은 데이터 효율성과 성능 면에서 GPT-4-Turbo를 능가하며, 특정 작업에 특화되지 않고 다양한 환경에서 높은 성능을 발휘.

AGENTGYM에서 사용된 LLM 모델들은 행동 복제와 보상 기반 학습을 통해 점진적으로 발전하며, AI 에이전트의 자기진화(Self-Evolution) 가능성을 실질적으로 입증했습니다.

사용자께서 작성하신 요약은 핵심을 잘 짚고 있습니다. 그러나 일부 표현을 조금 더 구체적이고 명확하게 다듬을 수 있습니다. 아래는 수정된 내용입니다:

수정된 요약

이 논문에서는 LLM을 직접 학습시키는 에이전트(Agent)를 다루고 있습니다.

- 메모리 구조는 명시적으로 존재하지 않으며, 대신 학습된 모델 파라미터와 탐색 데이터를 병합하여 에이전트가 경험을 간접적으로 기억합니다.

- 에이전트는 보상 기반 지도학습을 통해 성능을 개선합니다. 잘 수행된 행동(액션)에 보상을 부여하여, 이후 학습에서 이러한 행동의 확률을 점진적으로 증가시킵니다.

- 현재 이 모델은 특정 환경에서 세부적인 문제를 해결하는 데 초점이 맞춰져 있지만, GPT-4 Turbo를 포함한 기존 SOTA(SOTA: State of the Art) 모델보다 더 높은 성능을 기록했습니다.

주요 보완 사항

- "메모리 구조": 논문에서는 명시적인 메모리를 사용하지 않으므로, 간접적으로 메모리 역할을 수행하는 모델 파라미터와 데이터 병합에 대한 설명을 추가했습니다.

- "강화학습": 논문에서 사용된 보상 기반 지도학습의 세부적인 특징을 반영하여, 단순 강화학습과의 차이를 명확히 했습니다.

- "세부적인 문제 해결": 이 모델이 다루는 작업의 초점이 세부적이라는 점을 유지하면서, 연구가 지닌 성과(GPT-4 Turbo보다 높은 성능)를 강조했습니다.

이 수정된 요약은 논문의 내용을 더 명확하고 체계적으로 표현하며, 논문에서 제안된 방법론과 결과를 보다 구체적으로 전달합니다.