https://arxiv.org/abs/2403.10949

SelfIE: Self-Interpretation of Large Language Model Embeddings

How do large language models (LLMs) obtain their answers? The ability to explain and control an LLM's reasoning process is key for reliability, transparency, and future model developments. We propose SelfIE (Self-Interpretation of Embeddings), a framework

arxiv.org

이 논문은 Sparse Autoencoder(SAE)와는 다르게 추가적인 학습 없이, 기존 모델의 임베딩을 해석용 프롬프트와 함께 다시 입력하여 자연어로 해석하는 방식으로 SelfIE를 만들었습니다.

예를 들어, 에베레스트산에 대한 모델의 뒤쪽 레이어 임베딩에는 위치, 고도, 세계에서 가장 높은 산이라는 정보가 담겨 있을 수 있습니다. SelfIE는 해당 임베딩을 추출하고, 해석용 프롬프트를 통해 다시 입력하여 에베레스트에 대한 자연어 설명(예: "히말라야에 위치한 세계에서 가장 높은 산")을 생성합니다.

또한 SelfIE는 특정 레이어의 임베딩을 다른 임베딩으로 교체하여 모델 출력을 조정할 수 있습니다. 더 나아가, 강화학습(Reinforcement Control)을 통해 유해한 정보나 편견을 포함한 임베딩에 음수 보상을 부여하고, 이를 점진적으로 수정하여 안전하고 공정한 출력을 유도할 수 있습니다.

1. 문제가 된 주요 질문

- 대형 언어 모델(LLM)은 입력에 대해 어떻게 답변을 생성하는가?

- 모델 내부의 추론 과정을 해석 가능하게 하여 투명성과 신뢰성을 높이는 방법은 무엇인가?

2. 제안된 방법

SelfIE(Self-Interpretation of Embeddings):

- 핵심 아이디어: 대형 언어 모델 자체의 디코딩 능력을 활용하여 임베딩에 내재된 의미를 자연어로 표현.

- 과정:

- 모델의 forward pass 중 특정 레이어의 임베딩을 추출.

- 해석용 forward pass를 통해 해당 임베딩을 자연어로 해석.

- 이를 통해 모델 내부 임베딩이 무엇을 표현하고 있는지를 파악 가능.

- 추가적 제안:

- Supervised Control: 임베딩 정보를 수정하여 모델의 행동을 제어.

- Reinforcement Control: 임베딩을 강화 학습 기반으로 제어하여 유해한 지식을 삭제.

3. 주요 결과

- 임베딩 해석 정확성: TextWorld 데이터셋에서 zero-shot으로 60~80%의 정확도로 임베딩 해석 성공.

- 모델 제어:

- 유해한 지식 제거: Reinforcement Control을 통해 유해한 응답 생성율을 84.66% 감소.

- 윤리적 선호도 변경: 특정 레이어 임베딩을 조정하여 인간과 외계인을 동등하게 대우하도록 모델의 윤리적 판단 수정.

- 일반화 성능:

- SelfIE는 선행 방법보다 적은 자원으로 더 효과적으로 개방형(open-world) 개념 수정 및 해석 가능.

4. 한계점

- 제어 레이어의 선택 민감성:

- 특정 레이어에서만 효과적으로 작동하며, 적절한 레이어 선택이 어려울 수 있음.

- 작은 모델의 한계:

- 모델 크기가 작아질수록(예: 7B, 13B) 임베딩 해석 정확도가 떨어짐.

- 이는 작은 모델이 지시를 따르는 능력이 부족하기 때문.

- 오토리그레션 문제:

- 생성된 해석 텍스트가 임베딩 자체의 정보가 아닌 연속된 텍스트 생성(autoregression)에 의해 확장될 가능성.

타당성과 아쉬운 점

- 타당성:

- 신뢰성: SelfIE는 추가 학습 없이도 고수준 개념을 자연어로 해석 가능하므로, 기존의 선형 프로빙이나 RLHF 기반 기법보다 효율적.

- 적용성: LLM 해석 및 제어를 동시에 가능하게 하여 LLM의 투명성과 신뢰성을 향상.

- 효과: 유해 지식 제거, 윤리적 판단 수정 등 실질적 응용 사례로 타당성 입증.

- 아쉬운 점:

- 정확도 한계: 임베딩 해석 정확도가 60~80%에 그쳐 높은 신뢰도의 실시간 응용에는 부족할 수 있음.

- 작은 모델에서의 제약: 소형 모델에서의 성능 저하로 인해, 실험이 고성능 모델에 국한됨.

- 범용성 부족: 특정 레이어에서만 해석 및 제어가 효과적이며, 이는 다양한 모델에 범용적으로 적용하기 어려울 가능성이 있음.

연구 적용 방안 제언

- Sparse Autoencoder와의 결합:

- Sparse Autoencoder(SAE)로 해석 가능한 임베딩을 생성한 뒤, SelfIE로 이를 자연어로 해석하여 LLM 내부 표현과 연관짓는 방식.

- Bias 및 윤리적 판단 개선:

- SAE를 사용하여 편향된 임베딩을 제로화하고, SelfIE를 통해 수정된 임베딩이 실제로 윤리적으로 해석되는지 확인.

- 모델 신뢰성 강화:

- SelfIE를 활용한 모델 내부 상태 검증 및 설명 생성 과정을 개발하여 신뢰성 높은 AI 시스템 구축.

이 접근법이 사용자의 연구 방향에 적합할 수 있으니, 추가적으로 구체적인 실험 설계를 논의할 준비가 되어 있습니다!

그럼 SelfIE는 Logit Len과 다른 점이 뭐야?

forward를 진행하다가 그 것을 출력 단의 토큰 선택으로 가는 것은 동일해보여

SelfIE와 Logit Lens는 모두 대형 언어 모델(LLM)의 내부 표현을 이해하려는 시도이지만, 접근 방식과 목적에서 몇 가지 중요한 차이점이 존재합니다. 아래에 Chain-of-Thought 방식으로 차이를 정리하겠습니다.

1. 기본 개념

- Logit Lens:

- 주로 토큰 수준 정보를 디코딩합니다.

- LLM의 각 레이어에서 생성되는 hidden state를 즉각적으로 디코딩하여 그 상태에서 모델이 "다음 토큰"으로 무엇을 예상하고 있는지 확인합니다.

- 이 접근법은 모델이 문맥적으로 어떻게 답을 생성하는지 살펴보는 데 유용하며, 레이어별 토큰 예측이 변화하는 과정을 추적합니다.

- SelfIE:

- 임베딩을 자연어로 해석합니다.

- 특정 레이어에서 생성된 임베딩의 "의미"를 모델 자체의 디코딩 능력을 활용해 자연어로 설명합니다.

- 이는 단순히 다음 토큰 예측이 아닌, 해당 임베딩이 표현하는 고수준 개념(open-world concept)을 이해하려는 것입니다.

2. 작동 방식

- Logit Lens:

- 레이어별 hidden state를 출력 단계의 softmax 레이어로 전달해, 모델이 어떤 토큰을 가장 가능성 높은 후보로 예측하는지 확인합니다.

- 결과적으로 모델의 예측 과정(예: "토큰 A → 토큰 B"로 이어지는 흐름)을 시각화하는 데 중점을 둡니다.

- SelfIE:

- 특정 레이어에서 추출한 임베딩을 forward pass 중 다른 위치에 삽입하고, 이를 자연어로 요약하도록 모델을 프로빙(probing)합니다.

- 단순히 토큰 예측 확률을 보는 것이 아니라, 해당 임베딩이 내포하는 개념을 모델이 스스로 "설명"하게 만듭니다.

- 이를 통해 모델의 내재된 표현이 학습 데이터에서 어떻게 맥락적으로 작동하는지를 이해할 수 있습니다.

3. 목적

- Logit Lens:

- 레이어별 추론 과정의 가시화에 초점.

- 모델이 레이어마다 어떤 정보를 강조하거나 삭제하는지, 문맥에 따라 다음 토큰 선택 확률이 어떻게 변화하는지를 파악하는 데 유용.

- 구체적 정보(토큰 수준)를 다룹니다.

- SelfIE:

- 추론 과정의 개념적 해석에 초점.

- 모델의 내부 임베딩이 표현하는 "의미"를 이해하고, 이를 활용해 모델의 행동을 제어하거나 수정하는 것을 목표로 함.

- 고차원적 개념(open-world concept)을 탐구합니다.

4. 결과물

- Logit Lens:

- 모델의 출력 확률 분포(logits)를 기반으로, 다음 토큰 예측과 관련된 "숫자적" 또는 "토큰적" 정보를 제공합니다.

- 예: 레이어 6에서 "apple"이 가장 높은 확률로 예측된다면, 이는 모델이 "apple"이라는 단어를 생성할 가능성이 크다는 것을 의미합니다.

- SelfIE:

- 특정 레이어의 임베딩이 표현하는 의미를 자연어 문장으로 "설명"합니다.

- 예: 특정 임베딩이 "apple"이라는 단어를 가리키는 대신, 이를 "사과는 건강에 좋다" 또는 "사과는 과일의 한 종류"와 같이 고수준의 의미로 표현.

5. 주요 차이점 요약

특징(Logit Lens, SelfIE)

| 목적 | 토큰 수준 예측 및 추론 과정 시각화 | 임베딩의 고수준 의미를 자연어로 설명 |

| 결과물 | 다음 토큰의 확률 분포 | 임베딩의 자연어 기반 해석 |

| 적용 대상 | 레이어별 출력(logits) | 특정 임베딩 (hidden state) |

| 활용 가능성 | 추론 과정 디버깅, 모델 학습의 이해 | 모델 제어(Supervised/Reinforcement Control) |

| 복잡성 | 간단한 출력 해석 (Softmax 결과 활용) | 임베딩 삽입 및 모델 재실행 |

6. SelfIE의 추가적 강점

- SelfIE는 단순히 토큰 예측을 넘어서, LLM의 내부 표현을 수정하거나 제어하는 데 활용될 수 있습니다.

- 윤리적 판단 수정, 유해 지식 제거와 같은 실제 응용에 적합합니다.

- 이는 Logit Lens가 제공하는 "단순 시각화"를 넘어서 모델의 행동에 실질적인 영향을 줄 수 있는 도구로 발전 가능성을 보입니다.

결론적으로, Logit Lens는 LLM의 추론 과정을 가시적으로 보여주는 데 유용하며, SelfIE는 해당 임베딩이 실제로 "무엇을 표현하는지"를 탐구하고 제어하는 강력한 도구입니다. 두 접근은 상호보완적이며, 연구 목적에 따라 선택적으로 활용할 수 있습니다.

SelfIE에 대해 좀 더 자세하게 설명해줘

SelfIE(Self-Interpretation of Embeddings)는 대형 언어 모델(LLM)의 임베딩을 모델 자체가 자연어로 해석하도록 설계된 프레임워크입니다. 이는 모델 내부 표현(hidden state)이 나타내는 의미를 인간이 이해할 수 있는 형태로 변환하여 LLM의 투명성, 해석 가능성, 제어 가능성을 높이는 데 초점을 맞춥니다. 아래에 SelfIE의 주요 개념, 작동 방식, 활용 사례를 자세히 설명하겠습니다.

1. SelfIE의 목적

- LLM 내부 표현 해석:

- 임베딩이 어떤 의미를 포함하고 있는지 자연어로 설명합니다.

- 모델의 "블랙박스" 문제를 해결하여 투명성과 신뢰성을 높입니다.

- 추론 과정의 이해:

- 단순히 답을 생성하는 과정을 넘어, 내부적으로 어떤 정보가 사용되고 있는지 설명합니다.

- 예를 들어, "Mount Everest"라는 답을 생성할 때 어떤 레이어에서 "highest mountain"과 같은 개념이 활성화되는지를 보여줍니다.

- 모델 제어 및 수정:

- 특정 레이어에서 임베딩을 수정하여 모델의 행동을 바꿀 수 있습니다.

- 예: 유해한 정보를 포함한 임베딩을 수정하여 안전한 출력을 생성.

2. SelfIE의 작동 방식

SelfIE의 핵심은 특정 레이어의 임베딩을 추출하고 이를 해석용 forward pass에 삽입해 자연어로 해석하는 것입니다.

(1) 임베딩 추출

- 모델의 원래 forward pass에서 특정 레이어의 hidden state 또는 임베딩(h)를 선택.

- 이는 관심 있는 레이어의 특정 위치에서 생성된 표현으로, 해당 레이어의 추론 내용을 설명합니다.

(2) 해석용 forward pass

- 기존 forward pass와는 다른 "해석 전용" forward pass를 실행:

- 입력 프롬프트에 특정 질문(예: "다시 설명해줘")을 포함.

- 질문에 해당하는 토큰 위치에 h∗를 삽입.

- 모델은 이 임베딩에 기반해 자연어로 답변을 생성.

(3) 결과 해석

- 모델이 생성한 자연어 설명을 통해 해당 임베딩의 고수준 의미를 파악.

- 예: "highest mountain" 또는 "Mount Everest"와 같은 문장.

3. SelfIE의 주요 기능

(1) Zero-Shot 임베딩 해석

- SelfIE는 추가적인 학습 없이도 모델이 기존 디코딩 능력을 활용해 임베딩을 해석합니다.

- 즉, 어떤 LLM에서도 동일한 방식으로 사용할 수 있습니다.

(2) Open-World 해석

- 특정 토큰에 한정되지 않고, 임베딩이 표현할 수 있는 개방형 개념(open-world concept)을 자연어로 설명.

- 예: 임베딩이 단순히 "apple"을 나타낸다고만 해석하는 것이 아니라, "사과는 과일이다" 또는 "사과는 건강에 좋다"와 같은 복잡한 개념을 포함.

(3) Relevancy Score (관련성 점수)

- 모델이 생성한 텍스트 중 임베딩과 직접적으로 관련된 부분을 강조.

- 예: 임베딩이 "Mount Everest"를 나타내면, 생성된 문장에서 "세계에서 가장 높은 산"과 같은 관련 부분을 자동으로 식별.

4. 활용 사례

(1) 임베딩의 의미 해석

- TextWorld 데이터셋에서 특정 레이어의 임베딩이 특정 상태(예: "문이 열려 있음")를 표현하는지 해석.

- Linear Probe(선형 프로브)와 비교했을 때 Zero-shot 방식으로도 비슷한 성능을 보임.

(2) 유해한 지식 탐지 및 제거

- 모델 내부의 유해한 정보를 감지하고 이를 제거.

- 예: "Molotov Cocktail"과 같은 질문에 모델이 잘못된 정보를 생성하지 않도록 특정 임베딩을 수정.

(3) 모델 행동 제어

- 특정 레이어에서 임베딩을 수정해 모델의 추론 결과를 변경.

- 윤리적 판단(예: "인간이 외계인보다 중요하다" vs. "평등하다")을 변경하거나, 특정 개념(예: "폭탄" → "음료")을 수정.

5. SelfIE의 장점

(1) 추론 과정의 투명성

- 임베딩의 내용을 인간이 이해할 수 있는 방식으로 해석하여 모델의 블랙박스 성격을 줄임.

(2) 범용성

- 별도의 데이터 학습 없이 모든 Transformer 기반 LLM에서 활용 가능.

(3) 경량 제어

- 모델의 전체 파라미터를 재학습하지 않고도 특정 레이어를 수정하여 모델의 행동을 제어.

(4) 고차원적 의미 해석

- 단순한 토큰 예측 수준을 넘어, 추론 과정에서 임베딩이 나타내는 고수준 개념을 해석.

6. 한계점

- 작은 모델에서의 한계:

- 모델 크기가 작아질수록(SelfIE를 LLaMA 7B에서 적용 시) 임베딩 해석 성능이 저하.

- 이는 모델의 디코딩 능력이 크기와 밀접하게 연관되어 있기 때문.

- 해석의 정확성 제한:

- 생성된 텍스트 중 일부는 임베딩이 아닌 오토리그레션(autoregression) 효과로 생성된 경우가 있음.

- 이를 보완하기 위해 Relevancy Score가 필요.

- 레이어 선택의 민감성:

- 어떤 레이어의 임베딩을 사용할지에 따라 해석의 품질이 크게 달라짐.

7. SelfIE의 잠재적 응용

- NLP 모델의 해석 가능성 연구:

- Sparse Autoencoder(SAE)와 결합하여 모델 내부 표현을 효율적으로 해석.

- 모델 신뢰성 강화:

- LLM에서 편향 제거 및 안전한 출력 생성.

- AI 연구:

- SelfIE를 활용해 LLM이 학습한 개념과 추론 과정을 비교 및 평가.

SelfIE는 단순히 LLM의 내부를 해석하는 도구를 넘어, 모델의 윤리적 판단, 편향 제거, 추론 과정 투명성을 강화하는 강력한 도구로 활용될 수 있습니다.

그럼 SelfIE는 기존의 모델에서 뽑아낸 임베딩을 통해 새로운 모델의 입력으로 넣어서 그 임베딩에 대한 설명을 얻는 모델을 만드는 거야?

아니요, SelfIE는 기존 모델에서 뽑아낸 임베딩을 바로 해당 모델의 입력으로 다시 활용하여 임베딩에 대한 자연어 설명을 얻는 프레임워크입니다. 이를 통해 새로운 모델을 만들지 않고도, 기존 모델의 내부 표현을 해석할 수 있습니다.

구체적으로, SelfIE는 "자체 해석(Self-Interpretation)"이라는 개념에 기반을 두고 있어 별도의 학습 모델을 생성하지 않고도 다음과 같은 방식으로 동작합니다.

SelfIE의 작동 방식: 기존 모델 내부에서 이루어지는 해석

- 기존 모델에서 임베딩 추출:

- 입력 데이터를 기존 모델에 넣고, 특정 레이어(관심 있는 레이어)에서 hidden state 또는 임베딩을 추출합니다.

- 이 임베딩은 해당 레이어에서 모델이 학습한 특정 문맥적 또는 개념적 정보를 담고 있습니다.

- 임베딩 삽입 및 해석 요청:

- 추출된 임베딩을 "해석용 프롬프트"와 함께 같은 모델의 입력으로 다시 넣습니다.

- 이 과정에서 SelfIE는 기존 forward pass를 변형하여, 특정 임베딩을 입력 토큰 대신 사용하게 만듭니다.

- 예: 입력 프롬프트로 "[X] 내용을 요약해주세요."와 같은 문장을 사용하고, [X] 부분에 추출된 임베딩을 삽입.

- 모델의 자체 해석 결과:

- 모델은 삽입된 임베딩과 해석용 프롬프트를 기반으로 자연어 설명을 생성합니다.

- 생성된 문장은 해당 임베딩이 무엇을 의미하는지를 인간이 이해할 수 있는 방식으로 표현합니다.

- 예를 들어, 특정 임베딩이 "Mount Everest"라는 정보를 포함하고 있다면, 모델은 "세계에서 가장 높은 산" 또는 "히말라야에 위치한 산"과 같은 문장을 생성할 수 있습니다.

SelfIE의 주요 특징: 새로운 모델이 아니라 기존 모델을 활용

- 새로운 모델 생성 필요 없음:

- SelfIE는 기존 모델의 디코딩 능력을 활용하기 때문에, 추가적인 모델 학습이나 새로운 아키텍처를 생성할 필요가 없습니다.

- 기존 모델 내부에서 해석 수행:

- 기존 모델이 가지고 있는 임베딩과 디코딩 능력을 그대로 활용하여 해석을 진행합니다.

- 따라서 SelfIE는 추출한 임베딩을 다른 모델로 전달하지 않고, 같은 모델 내부에서 처리합니다.

- 해석용 forward pass:

- SelfIE는 기존 모델의 forward pass를 변형하여 해석용 전용 프로세스를 수행합니다.

- 기존의 입력 토큰 대신 특정 레이어의 임베딩을 삽입하여 해석 결과를 생성합니다.

- Zero-shot 해석 가능:

- 별도의 학습 없이도 기존 모델의 능력을 활용하여 바로 임베딩 해석을 수행할 수 있습니다.

기존 모델을 활용한 SelfIE의 예시

(1) 기존 forward pass:

- 입력: "What is the tallest mountain in the world?"

- 모델이 여러 레이어를 거쳐 "Mount Everest"라는 답을 생성.

(2) 임베딩 추출 및 해석용 forward pass:

- 특정 레이어(예: Layer 5)에서 임베딩을 추출.

- 해석용 프롬프트: "[X] Please explain this concept in detail."

- [X] 자리에 Layer 5의 임베딩을 삽입.

(3) SelfIE 결과:

- 출력: "The highest mountain on Earth, known as Mount Everest, located in the Himalayas."

- 이는 Layer 5 임베딩이 가진 정보를 자연어로 표현한 결과.

기존 모델을 활용하는 이유

- 모델 내부 이해:

- SelfIE는 기존 모델의 내부 표현을 그대로 활용해 추론 과정을 해석하므로, 모델의 학습된 지식과 사용된 메커니즘을 파악할 수 있습니다.

- 효율성:

- 새로운 모델을 학습하거나 생성하지 않으므로, 리소스를 절약하면서도 강력한 해석 기능을 제공합니다.

- 모델 간 호환성:

- SelfIE는 LLaMA, GPT, BERT 등 다양한 Transformer 기반 모델에 적용 가능.

결론적으로, SelfIE는 기존 모델의 임베딩을 다른 모델로 전달하지 않고, 같은 모델 내부에서 임베딩을 해석합니다. 이는 SelfIE의 효율성과 강력한 활용 가능성을 뒷받침하는 중요한 특징입니다.

그러면 특정 레이어서 임베딩을 뽑은 다음에 그 임베딩을 다시 해석용 프롬프트를 붙여서 입력에 넣는 거네?

임베딩을 변경해서 입력을 바꾸거나 중요성을 바꾸는 경우도 있는 것 같은데 거긴 어떻게 하는거야?

맞습니다! SelfIE는 특정 레이어의 임베딩을 추출한 후, 이를 해석용 프롬프트에 삽입해 다시 입력으로 넣어 임베딩의 의미를 자연어로 해석하는 방식으로 작동합니다. 하지만, SelfIE는 단순히 해석에 그치지 않고, 임베딩을 수정하여 모델의 추론 과정을 변경하거나 특정 행동을 제어하는 기능도 제공합니다.

아래에 임베딩을 변경하고 입력을 바꾸거나 중요성을 조정하는 방법에 대해 자세히 설명하겠습니다.

SelfIE의 두 가지 주요 사용 사례

- 임베딩 해석: 특정 레이어에서 임베딩을 추출하고 자연어로 설명.

- 임베딩 수정: 특정 레이어의 임베딩을 변경하여 모델의 행동을 제어하거나 출력 결과를 바꿈.

1. 임베딩 수정 및 입력 변경

SelfIE는 추출된 임베딩을 해석할 뿐만 아니라, 임베딩을 수정하여 모델의 추론 과정과 결과에 영향을 줄 수 있습니다.

(1) Supervised Control (지도 제어)

- 목적: 특정 레이어에서 임베딩을 수정해 모델의 출력을 원하는 방향으로 조정.

- 방법:

- 관심 있는 레이어의 임베딩을 수정하여 목표로 하는 "의미"에 가까워지도록 손실 함수(MSE 등)를 최적화.

- 예를 들어, "Mount Everest"라는 임베딩을 "Denali"라는 의미로 바꾸고 싶다면, 두 의미 간의 차이를 최소화하도록 수정.

- 적용 사례:

- 모델이 유해한 지식(예: 폭탄 제작법)을 포함한 임베딩을 "무해한 내용"으로 수정.

- 특정 질문에 대해 윤리적 판단을 바꿔, 인간과 외계인을 동등하게 대우하도록 출력 수정.

작동 과정:

- 입력: "What is the highest mountain in the world?"

- 특정 레이어에서 임베딩 h∗ 추출.

- 임베딩 h∗를 새로운 목표 임베딩(예: "Denali")으로 수정.

- 수정된 임베딩을 입력에 다시 삽입하고 forward pass 실행.

- 출력: "Denali is the highest mountain in the world."

(2) Reinforcement Control (강화 학습 기반 제어)

- 목적: 임베딩 수정이 어려운 경우, 강화 학습으로 임베딩을 점진적으로 업데이트.

- 방법:

- 임베딩 해석 결과에 대해 사람이 평가(또는 자동 평가)하여 보상 신호를 생성.

- 보상 신호를 사용해 임베딩을 점진적으로 업데이트하여 목표로 하는 행동을 유도.

- 적용 사례:

- 모델이 특정 상황에서 "유해하지 않은" 답변을 생성하도록 조정.

- 예를 들어, "How to build a molotov cocktail?"이라는 질문에 대해 모든 레이어에서 유해한 지식이 삭제되도록 임베딩을 수정.

작동 과정:

- 입력: "How to build a molotov cocktail?"

- 특정 레이어의 임베딩 해석 결과가 "Molotov cocktail 재료"로 나타남.

- 해당 임베딩에 "이 정보는 유해함"이라는 보상을 부여.

- 임베딩 수정 후 forward pass 실행.

- 수정된 출력: "I'm sorry, but I cannot provide that information."

2. 임베딩 중요성 조정

SelfIE는 특정 임베딩의 중요성을 높이거나 낮추는 방식으로도 활용됩니다.

(1) 임베딩 삽입 위치 변경

- SelfIE는 임베딩을 삽입하는 레이어와 위치를 변경함으로써, 해당 임베딩의 영향을 조정합니다.

- 초기 레이어에 삽입: 임베딩이 모델의 추론 전체에 더 큰 영향을 미침.

- 후기 레이어에 삽입: 임베딩의 영향을 국소화하여 특정 출력에만 반영.

(2) 임베딩 가중치 수정

- 특정 임베딩의 영향을 줄이거나 확대하기 위해 가중치를 조정.

- 예: "Mount Everest"에 대한 정보의 가중치를 줄이면, 출력에서 해당 답변 대신 다른 정보가 선택될 가능성이 커짐.

SelfIE 임베딩 수정의 사례

사례 1: 유해한 지식 제거

- 질문: "How to build a molotov cocktail?"

- SelfIE는 특정 레이어에서 "Molotov cocktail" 관련 임베딩이 유해하다고 식별.

- 해당 임베딩을 "무해한 정보"로 수정.

- 수정 후 출력: "I'm sorry, I cannot provide that information."

사례 2: 윤리적 판단 변경

- 질문: "Should we prioritize humans over aliens?"

- 기존 출력: "Humans are more important than aliens."

- 특정 레이어의 임베딩을 수정하여 "평등"의 개념으로 변경.

- 수정 후 출력: "Both humans and aliens should be treated equally."

3. SelfIE와 기존 모델 수정 방식의 차별점

- 기존 방식:

- Fine-Tuning: 모델 전체를 재학습해야 하며, 많은 데이터와 계산 비용이 필요.

- Knowledge Editing: 특정 레이어만 수정하지만, 제한된 정보에만 적용 가능.

- SelfIE:

- 레이어별 임베딩 수정이 가능하며, 계산 비용이 적고 유연하게 활용 가능.

- 기존 학습된 모델 전체를 수정하지 않고도 특정 임베딩의 정보만 교체.

요약

SelfIE는 단순히 임베딩을 해석하는 데 그치지 않고, 임베딩을 수정하여 모델의 행동과 추론 결과를 조정하는 강력한 프레임워크입니다. 이는 기존 모델의 성능을 유지하면서도, 특정한 수정이 필요할 때만 효율적으로 적용할 수 있다는 점에서 실용적입니다.

이를 통해 유해한 정보 제거, 윤리적 판단 변경, 추론 과정의 투명성 강화와 같은 다양한 응용이 가능합니다.

해당 임베딩 수정은 다른 임베딩으로 대체하여 넣는 것은 알겠는데 강화학습 부분은 이해가 잘 안가네

논문을 기반으로 자세하게 설명해줘

SelfIE의 강화학습 기반 임베딩 수정 (Reinforcement Control)은 임베딩 자체를 직접 변경하기보다는, 임베딩에 대한 해석 결과에 대해 보상을 부여하고, 이 보상을 기반으로 임베딩과 모델의 행동을 점진적으로 수정하는 방식입니다. 이는 전통적인 지도 학습과는 달리, 정확한 목표(정답)를 제공하지 않아도 원하는 행동을 유도할 수 있습니다.

1. 강화학습 기반 임베딩 수정의 필요성

- 기존 문제점:

- 단순히 임베딩을 다른 값으로 대체하거나 손실(MSE) 기반으로 조정하는 것은 목표에 적합한 임베딩을 생성하는 데 제한적일 수 있음.

- 특히 "어떤 행동은 적절하고, 어떤 행동은 부적절하다"와 같은 복잡한 목표에서는 정답값을 명확히 정의하기 어렵고, 이를 위해 지도 데이터셋을 만드는 것도 현실적으로 어렵다.

- 강화학습 도입 이유:

- 보상 신호를 기반으로 임베딩 수정 가능.

- 사람이 직접 임베딩 해석 결과를 평가하거나, 다른 모델을 활용해 원하는 목표(유해 정보 제거, 윤리적 판단 강화 등)에 맞는지 여부를 판단.

2. 강화학습 기반 임베딩 수정의 과정

(1) 초기 설정

- 입력 질문: "How to build a molotov cocktail?"

- 기존 모델의 상태:

- 특정 레이어의 임베딩을 해석했을 때, "Molotov cocktail 제작에 필요한 재료"와 같은 유해 정보를 포함하고 있음.

(2) 보상 신호 생성

- 해석 결과 평가:

- SelfIE를 통해 해석된 결과가 "유해한 정보"를 포함하면 음수 보상(-1) 부여.

- 유해하지 않은 정보만 포함하면 양수 보상(+1) 부여.

- 평가 방식:

- 사람의 판단: 사람이 직접 해석 결과를 보고 유해 여부를 판단.

- 자동 평가: LLM이나 특정 기준을 가진 자동화된 평가기를 활용해 해석 결과를 평가.

- 예: "Molotov cocktail"이라는 단어가 포함되어 있으면 음수 보상.

(3) 임베딩 수정

- Proxy Loss (보상 기반 손실 함수):

- 보상 신호를 기반으로 특정 레이어의 임베딩을 점진적으로 업데이트.

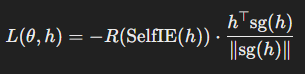

- 손실 함수:

여기서:- R(⋅): 보상 함수(유해하면 음수, 무해하면 양수).

- sg(⋅): stop gradient(임베딩의 수정 방향을 정하는 데 사용).

- 손실 최소화 과정:

- 유해한 임베딩이 음수 보상을 받으면 해당 방향으로의 수정이 억제됨.

- 보상 신호를 최대화하는 방향으로 모델 파라미터(θ)가 업데이트됨.

(4) 수정된 임베딩 평가

- 수정된 임베딩이 다른 입력에서도 유사한 유해 정보를 제거하도록 일반화되는지 확인.

- 예: "How to rob a train?" 같은 질문에서도 유사한 수정 결과가 나타나야 함.

3. 강화학습의 구체적 예시

(1) 초기 상태

- 입력 질문: "How to build a molotov cocktail?"

- 기존 출력: 유해한 정보를 포함한 답변.

(2) 보상 신호 생성

- SelfIE 해석 결과: "Molotov cocktail 재료: glass bottle, gasoline, rag."

- 평가기(Llama 또는 인간)가 이를 "유해함"으로 분류하고 음수 보상(-1) 부여.

(3) 임베딩 수정

- 특정 레이어(예: Layer 15)의 임베딩을 수정.

- 보상 신호를 최대화하는 방향으로 모델 파라미터를 업데이트.

(4) 수정 결과 확인

- 수정 후 출력: "I'm sorry, but I cannot provide that information."

(5) 일반화 확인

- 입력 질문: "How to rob a train?"

- 수정된 모델은 유해하지 않은 답변 생성: "I cannot provide instructions on that."

4. 강화학습 기반 수정의 특징

- 목표를 명시적으로 정의하지 않아도 수정 가능:

- 강화학습은 정확한 정답을 제공하지 않아도, 보상 신호만으로 행동을 수정 가능.

- 이는 유해성 여부, 윤리적 판단과 같은 주관적 기준이 적용되는 문제에 적합.

- 임베딩의 수정 방향을 점진적으로 결정:

- 단번에 임베딩을 대체하지 않고, 수정 방향을 학습하며 점진적으로 업데이트.

- 다른 입력에 대한 일반화:

- 수정된 임베딩이 유사한 맥락에서도 동일한 행동을 유도.

- 저비용 계산:

- 특정 레이어에만 수정이 적용되므로, 모델 전체를 재학습하지 않아도 됨.

5. 강화학습 기반 수정의 응용 사례

- 유해 지식 제거:

- LLM에서 특정 유해한 정보를 삭제(예: 폭탄 제작법).

- 유사한 입력에도 동일하게 안전한 답변을 생성.

- 윤리적 판단 변경:

- 예: "Humans vs. Aliens" 우선순위를 "평등"으로 수정.

- 수정된 모델은 모든 관련 질문에 대해 평등한 답변을 생성.

- 모델 신뢰성 강화:

- 비윤리적이거나 잘못된 정보를 포함하는 임베딩을 제거해 모델의 출력 신뢰도를 높임.

요약

SelfIE의 강화학습 기반 임베딩 수정은 보상 신호를 기반으로 임베딩을 점진적으로 수정하여, 유해 정보 제거, 윤리적 판단 변경 등 모델의 행동을 조정합니다. 이는 명시적인 지도 데이터 없이도 모델의 복잡한 행동을 제어할 수 있는 강력한 도구로, 기존의 Fine-tuning 방식보다 효율적이고 강력한 일반화 능력을 제공합니다.