목표 - 딥러닝 기반 기계 번역의 목적과 작동 원리 이해하기

2,3년 안에 급속도로 발전되어 Chat GPT도 등장하였다.

발전 과정을 보면서 핵심, 한계점 등을 봐보자!

Seq2seq -> attention -> self-attention(transformer)

이게 Seq2Seq아닌가...?

통계 기반을 개선하기 위해서 인코더 디코더 구조가 나왔다.

앞선 논문은 그저 인코딩이었다면 여기선 word embedding이 진행된다.

문장을 입력과 출력으로 받게 되어 기계 번역에 유용하게 사용되었다.

통계 기반을 압도적으로 이긴 것은 attention 메커니즘 도입 이후이다.

입력문장의 정보를 출력할 때 마다 사용되는 구조이다.

양방향 - ELMo나 BERT처럼 문맥을 양방향으로 확인했따.

생성할 때 활용할 수 있는 정보의 양이 많아져서 좋아졌다.

Fast Forward connection을 도입!

손실될 수 있었던 정보를 더해줘서 정보 손실을 막는다. + 기울기 소실 막기

더 많은 레이어를 쌓을 수 있게 되었고, 특징을 잘 학습할 수 있게 되었다.

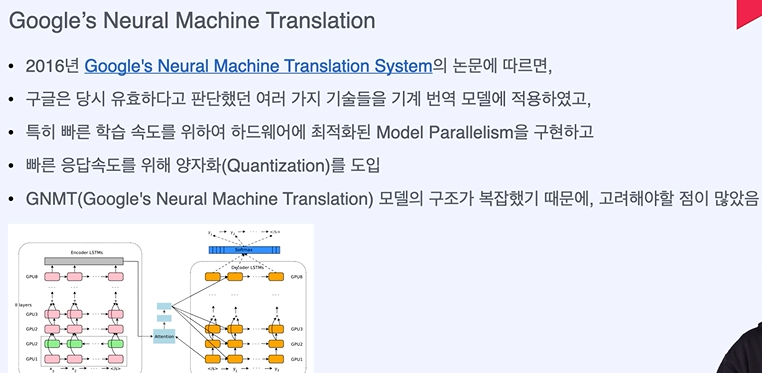

논문 - 작업의 성능에 집중 -> 효율성이 떨어질 수 있다.

서비스 - 성능과 서비스 모두 좋아야 한다. -> 번역도 빨리 빨리 되어야 한다.

병렬적으로 처리하여 빠른 속도로 끝낸다.

CNN - attention보다 빠른 시간으로 해결가능하다.

성능보다 효율성을 택하였고, 문자를 한번에 뽑아냈기 때문에 빠른 속도를 가져왔다.

여기서도 CNN에 위치정보를 포함하기 위해 Positional Encoding을 사용하였다.

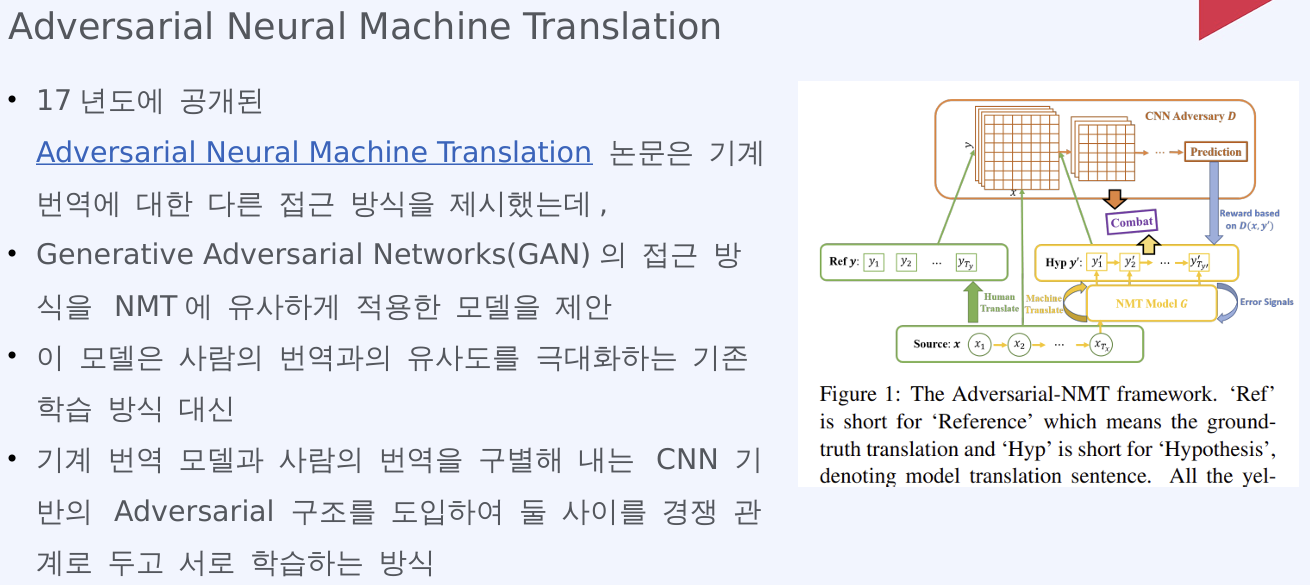

비전에서 가장 핫한 GAN모델을 NLP에 적용하였다.

판별자와 생성자의 싸움 구조인데 학습 방식을 가지고 와서 기계번역과 사람 번역을 구분해 계속 평가하도록 한다.

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 python 실습 - 한국어 기계 번역 데이터 수집 및 전처리 (0) | 2024.04.26 |

|---|---|

| 자연어 처리 기계 번역 - 딥러닝 기반 기계 번역 연구 동향, 발전 방향 (0) | 2024.04.26 |

| 자연어 처리 기계 번역 - 규칙, 통계 기반 기계 번역 (0) | 2024.04.26 |

| 자연어 처리 기계 번역 - 병렬 학습 데이터셋 수집 (1) | 2024.04.26 |

| 자연어 처리 기계 번역 - 기계 번역이란? (0) | 2024.04.26 |