728x90

728x90

위치가 11일 때, 상태 가치를 정책에 따라 구하고, 두 가치의 차를 구하라.

감쇠인자는 0이다.

감쇠인자가 0이면 당장 받는 보상의 기대값만 신경쓰면 되니까 둘다 -1이고, 차는 0 아닌가...?

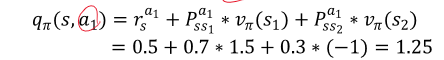

아래 그림을 보고 q(s,a1)를 구하라

감쇠인자를 안알려주길래 감쇠인자 그대로 적었다가 1로 하라고 해서 이대로 계산했습니다.

v*구하기

2입니당

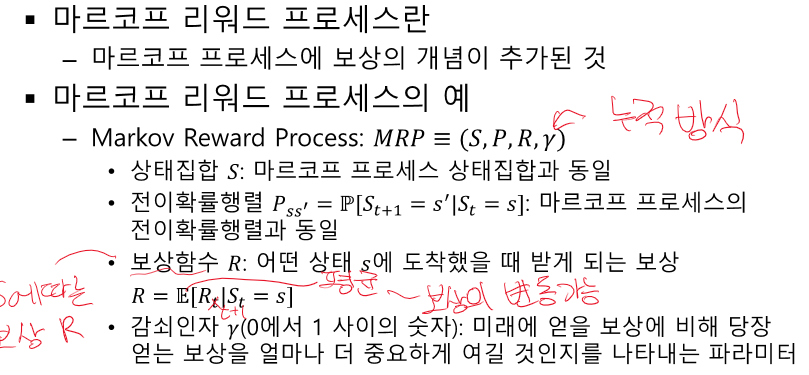

마르코프 상태에 대한 빈칸 문제

마르코프가 빈칸이었습니다.

그리고 모든 상황이 마르코프 상황인 것은 아니지만 모델링은 가능하다가 O,X문제로 나왔었습니다. O

마르코프 프로세스는 상태 집합, 보상함수, 감쇠인자로 이루어져 있다. X

P가 빠졌습니다.

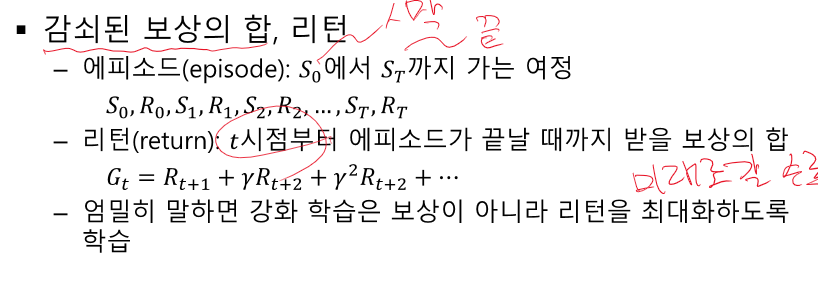

빈칸 문제 : 일정 시점부터 에피소드가 끝날 때 까지의 받은 보상의 합은 ( 리턴 )이다.

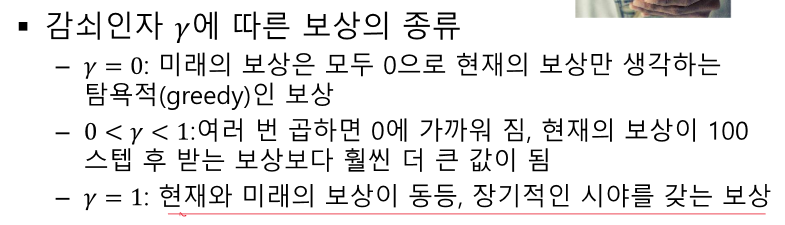

감쇠 인자가 0이라면 현재의 보상을 크게 바라본다. O

MDP를 모른다는 것은 보상함수와 (전이 확률)을 모른다는 것이다.

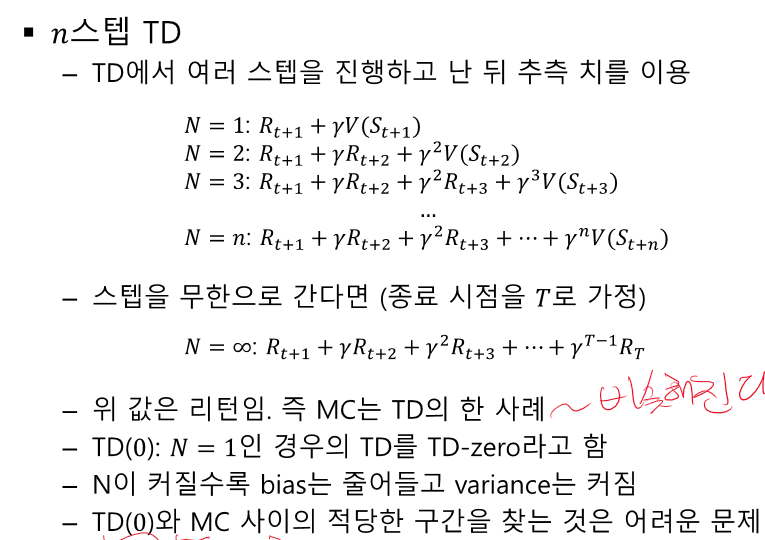

MC는 에피소드가 종료되어야 학습하고, TD는 종료되지 않아도 학습할 수 있따 O

n step td에서 n이 작아질수록 분산이 커진다 X - 작아진다.

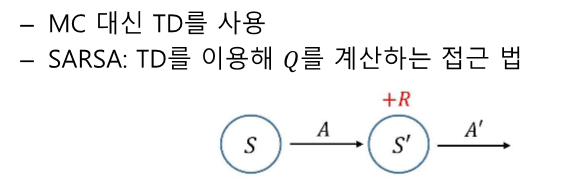

SARSA 는 MC와 유사하고 Q-learning은 TD와 유사하다 X - SARSA도 TD다.

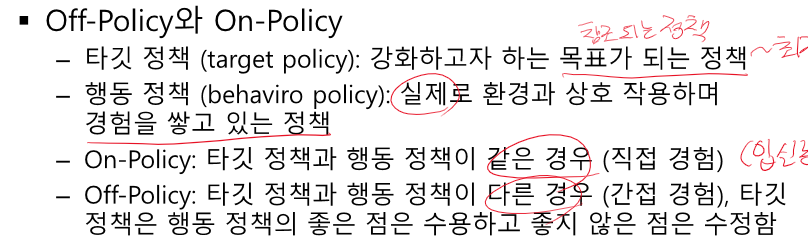

off policy 빈칸문제

끝!

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 생성형 인공지능 입문 중간고사 (0) | 2024.04.24 |

|---|---|

| 딥러닝 개론 중간고사 대비 문제 - backpropagation, convolution, optimization (0) | 2024.04.24 |

| 강화학습 - TD에서 s'을 언제 업데이트 해야 할까? (0) | 2024.04.23 |

| 강화학습 암기할 내용들 (0) | 2024.04.23 |

| 강화학습 마르코프 프로세스부터 Q-learning, SARSA까지 개념 정리 (0) | 2024.04.23 |